statistiques et probabilites au lycee - Académie de Dijon

Transcript of statistiques et probabilites au lycee - Académie de Dijon

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 1 Robert FERACHOGLOU

Statistiques et probabilités au lycée

« Le loto, c'est un impôt sur les gens qui ne comprennent pas les statistiques. » (Anonyme)

I – INTRODUCTION 1. Un apprentissage dans la continuité

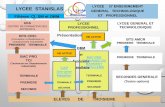

Quelques éléments de statistique descriptive ont été introduits au collège, une initiation au calcul des probabilités a été menée en classe de 3ème depuis la rentrée 2008. Le programme de classe de 2nde s’inscrit dans la continuité de ce travail pour ce qui est du contenu. Le tableau sy-noptique suivant résume l’évolution des connaissances.

Classe de 6ème Classe de 5ème Classe de 4ème Classe de 3ème

Organisation et gestion de

données

Organiser des données en choisissant un mode de représentation adapté. Lire et interpréter des in-formations à partir d’une représentation graphique. Représentations usuelles : tableaux, diagrammes en bâtons, circulaire, …, cartésien.

Classes, effectifs, fréquen-ces. Tableaux de données : lecture, interprétations, élaboration, représenta-tions graphiques. Diagrammes, histogram-mes.

Moyenne pondérée. Caractéristiques de posi-tion : médiane, quartiles. Approche des caractéristi-ques de dispersion : éten-due. Notion de probabilité.

Le programme de Seconde ne va guère plus loin sur les notions nouvelles dans ce qui est dé-

sormais désigné par « analyse des données », en institutionnalisant la connaissance des caracté-ristiques de position et de dispersion (moyenne, médiane, quartiles). Il introduit cependant un nouveau champ de réflexion conceptuelle sur les données, avec une ap-proche de l’échantillonnage statistique. Cette approche avait déjà été initiée de façon qualitative avec le programme de 2000, nous allons plus loin dans ce domaine avec la mise en évidence d’éléments chiffrés de la fluctuation (notion d’intervalle de fluctuation au seuil de 95%).

Enfin, le programme de 2009, introduit les premiers éléments du calcul de probabilité, ce qui est une première en classe de seconde ! Le recours à la simulation d’expériences aléatoires ren-force et crédibilise le lien avec les statistiques, beaucoup plus que dans le programme précédent où ces simulations étaient souvent négligées dans les pratiques, faute peut-être de trouver un an-crage suffisant avec les autres domaines étudiés.

2. Regard sur les objectifs du programme de Seconde

Ces objectifs, relativement ambitieux, sont clairement résumés dans le libellé du programme : « Objectifs visés par l’enseignement des statistiques et probabilités à l’occasion de résolutions de problèmes • dans le cadre de l’analyse de données, rendre les élèves capables :

− de déterminer et interpréter des résumés d’une série statistique ; − de réaliser la comparaison de deux séries statistiques à l’aide d’indicateurs de position et

de dispersion, ou de la courbe des fréquences cumulées ; • dans le cadre de l’échantillonnage :

− faire réfléchir les élèves à la conception et la mise en œuvre d’une simulation ; − sensibiliser les élèves à la fluctuation d’échantillonnage, aux notions d’intervalle de fluc-

tuation et d’intervalle de confiance et à l’utilisation qui peut en être faite. »

3. Commentaires Les objectifs affichés s’articulent autour de la statistique purement descriptive (ou : analyse

des données), qui utilise des outils mathématiques issus de la géométrie et de l’analyse, et des

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 2 Robert FERACHOGLOU

liens entre la statistique et les phénomènes aléatoires : l’étude de ces phénomènes se fonde sur la notion de probabilité, comprise comme une valeur idéale de fréquence, et dont la théorie expli-que certains phénomènes constatés (la fluctuation d’échantillonnage) mais aussi donne un cadre théorique rigoureux pour, à partir de ces données statistiques, formuler une prévision ou prendre un décision. Ce deuxième aspect est plus complexe, car il met l’accent sur l’imbrication entre statistiques et probabilités ; les statistiques permettent d’accepter ou de réfuter un modèle théori-que, les probabilités expliquent les écarts statistiques constatés et donnent des garde-fous pour la statistique inférentielle, c’est-à-dire la statistique de la prévision ou de la décision. Cette articulation entre statistiques et probabilités n’est pas un artifice, elle correspond à un cheminement historique et épistémologique conjoint dans le développement de ces deux disci-plines. Dans le bagage culturel du futur « citoyen », l’enjeu avéré du programme est de donner à chacun un jugement le plus sain possible sur l’information chiffrée, avec l’appui d’un « bon sens de l’aléatoire ». C’est un objectif ambitieux, d’autant plus que la France affiche un triste retard en la matière, notamment par rapport aux pays anglo-saxons ; le retard est culturel, les perles journalistiques relatives aux sondages et à leur interprétation, le flou affiché dans la « confian-ce » des bulletins météo, en sont quelques traces visibles ; le retard est également visible dans l’enseignement où, non seulement on a dressé au fil des années un rideau de fer entre statistiques et probabilités (les incitations fortes des différents programmes, et notamment celui de 2000, ont peu infléchi les pratiques), mais encore on a établi une hiérarchie de fait entre ces deux discipli-nes, au détriment des statistiques trop souvent considérées comme des mathématiques au rabais. Les statistiques restent trop souvent dans la société un amas de chiffres obscurs que l’on peut manipuler de façon machiavélique – ce qui n’est pas toujours faux – pour rendre opaque une vé-rité ou la déformer. Les citations abondent dans ce sens ; en voici trois : « Il y a trois sortes de mensonges : les mensonges, les sacrés mensonges et les statistiques. »

(Mark Twain) « La statistique est la première des sciences inexactes. » (Jules de Goncourt) « Faites attention, la statistique est toujours la troisième forme du mensonge. » (Jacques Chirac)

Chacun pourra tester son propre sens de l’aléatoire dans l’exemple qui suit. On a consigné ci après quatre séries de 100 chiffres 0 ou 1, dont une seule a été obtenue de façon aléatoire. Il s’agit de dé-terminer laquelle.

Série 1 Série 2 Série 3 Série 4 1 1 1 1 1 1 1 0 1 1 0 1 0 1 1 1 0 1 0 0 1 1 0 0 1 0 0 1 0 1 1 1 0 0 1 0 0 1 0 1 1 1 1 1 1 1 1 1 1 1 1 1 0 1 0 1 1 0 0 0 0 1 0 1 0 0 0 1 0 1 0 1 0 1 0 0 0 1 0 1 1 1 1 1 0 1 1 1 1 1 1 1 0 1 1 0 1 1 0 1 1 0 1 1 0 0 0 1 0 0 1 0 1 1 0 0 0 1 0 0 1 1 0 0 0 1 1 1 1 1 0 1 1 1 0 1 0 0 0 1 1 1 1 0 1 0 1 1 0 1 1 1 1 0 1 0 1 1 0 1 1 1 0 1 1 1 0 0 1 1 1 0 0 1 1 0 0 1 1 0 1 1 0 0 1 0 1 0 1 0 1 1 0 0 1 0 1 0 1 0 1 1 1 0 1 1 0 1 0 1 1 0 1 0 0 0 1 0 1 1 0 1 0 0 1 1 0 1 1 0 0 1 0 0 1 1 0 1 1 0 1 1 0 1 1 1 1 1 1 1 0 0 1 0 1 0 0 1 1 1 0 1 0 1 1 0 1 1 0 1 0 1 0 1 1 0 1 1 0 1 0 1 1 1 1 0 1 1 1 1 0 0 1 0 0 1 0 0 1 0 1 0 1 0 1 0 0 1 1 1 1 0 1 0 1 0 0 1 1 1 1 1 1 1 1 1 1 1 0 0 1 0 0 0 1 0 1 1 1 0 0 1 1 0 1 0 0 1 1 1 0 1 1 0 1 0 0 1 1 1 0 0 1 1 1 1 1 1 1 1 0 1 1 0 0 1 0 0 0 1 0 1 0 1 0 0 0 1 1 0 0 1 0 1 0 0 0 1 1 0

Nombre de 0 : 18 Nombre de 0 : 51 Nombre de 0 : 48 Nombre de 0 : 42

Nombre de 1 : 82 Nombre de 1 : 49 Nombre de 1 : 52 Nombre de 1 : 58 Nombre de blocs 25 Nombre de blocs 62 Nombre de blocs 66 Nombre de blocs 53

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 3 Robert FERACHOGLOU

Commentaires La première idée est de regarder la fréquence d’apparition des chiffres, ce qui permet d’éliminer la première série, qui comporte trop de 1. Le nombre de 1 est en effet une variable aléatoire qui suit une loi binomiale de paramètres 100 et 0,5 ; sa moyenne est 50m= et son écart-type 5σ = . Sa loi est proche d’une loi normale ayant les mêmes paramètres, pour laquelle environ 95 % des échantil-lons aléatoires sont contenus dans l’intervalle [ ]2 , 2m mσ σ− + , c’est-à-dire [40, 60]. Au seuil de

95%, on peut donc réfuter le caractère aléatoire de la série 1, et accepter celui des séries 2, 3, 4. On peut également considérer le nombre de blocs, c'est-à-dire de suite de termes analogues dans chacune des séries. Formellement, si 1X , …, 100X sont les 100 variables de Bernoulli donnant la va-

leur des 100 chiffres, cela consiste à introduire comme compteurs de blocs les variables

1 100( )i iY ≤ ≤ ainsi définies :

1 1Y = et pour 2 100i≤ ≤ , 1iY = si 1i iX X −≠ et 0iY = si 1i iX X −= .

Alors 100

1i

i

S Y=

=∑ représente le nombre total de blocs.

On a 1( ) 1E Y = et pour 2 100i≤ ≤ , 1

( )2iE Y = , donc ( ) 1 99 0,5 50,5E S = + × = ; c’est le nombre

moyen de blocs.

De plus, 1( ) 0V Y = et pour 2 100i≤ ≤ , 1

( )4iV Y = et les iY sont indépendantes, donc

( ) 99 0,25 24,75V S = × = . Cela fournit : ( ) 5Sσ ≈ . Pour environ 95% des échantillons aléatoires, le nombre de blocs est donc compris entre 40,5 et 60,5, ce qui permet de réfuter le caractère aléatoire des séries 2 et 3 : elles ont trop de blocs pour être obtenues par hasard. (En fait, ces séries ne comportent pas de séries de chiffres consécutifs de lon-gueur supérieure à 3 : c’est également extrêmement rare.) II – LA STATISTIQUE DESCRIPTIVE 1. Appréhender une série statistique

Une série statistique livre un ensemble de données brutes. Lorsqu’elles sont nombreuses, ces données demandent d’être résumées pour en tirer un enseignement. Les graphiques et les para-mètres constituent les principaux résumés, visuels et numériques. Deux points sont essentiels dans la formation des élèves :

− s’habituer à poser des questions a priori, comme par exemple : « quel résumé semble le plus pertinent pour une étude donnée ? », « quels paramètres sont intéressants à calcu-ler ? » ;

− s’entraîner à comprendre et interpréter les résumés, qu’ils soient visuels ou numériques, et les exploiter pour en tirer un élément de réponse.

Le programme insiste sur la nécessité de travailler le plus souvent possible sur des données réel-les ; la mise à disposition de fichiers numériques permettra un travail sur ordinateur, d’autant plus justifié que ces données seront nombreuses et complexes. Le document ressource préconise le recours à quelques fichiers qui serviront de fil rouge. Par exemple le fichier de l’INSEE sur les 36723 communes françaises, disponible sur le site http://www.insee.fr/fr/ppp/bases-de-donnees/recensement/populations-legales/france-departements.asp, permet de mener des travaux intéressants sur des exemples de représentations graphiques, des tris, des calculs de fréquences, des calculs de paramètres et leur interprétation, des comparaisons de populations, d’étudier les effets de différents regroupements, d’utiliser le cumul des fréquences, de prélever des échantil-

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 4 Robert FERACHOGLOU

lons, d’observer la fluctuation d’échantillonnage, de découvrir la loi de Benford, d’introduire les rudiments du calcul des probabilités, ….

2. Résumer une série statistique a) Position du problème

Une série statistique numérique offre un premier résumé visuel naturel tel que l’histogramme (ou le diagramme en bâton, en barres, …). Ce graphique pose la question de trouver un résu-mé numérique adéquat, à l’aide de paramètres chiffrés traduisant trois notions visuelles : - la tendance centrale (centre de gravité, valeur « sommitale », valeurs de partage) ; - la dispersion des données ; - la forme du graphique (aplatissement, asymétrie). Seules les deux premières notions sont envisagées au lycée ; il n’est pas inintéressant pour un professeur d’en étudier un aspect théorique, qui ne sera pas présenté aux élèves.

b) Lien théorique entre tendance centrale et dispersion On identifie la série statistique 1x , …, nx au vecteur 1( , ..., )nx x x

d’un espace euclidien de

dimension n, identifié à nℝ . Une valeur centrale est par définition une constante c telle que le vecteur constant

( , ,...; )c c c c= est proche de x

, au sens suivant : la distance entre x

et c

doit être minimale. La valeur de cette distance minimale est, toujours par définition, la dispersion associée à la valeur c. On peut envisager cela avec quelques distances classiques dans nℝ

:

• 1

( , ) i ii n

d x y Max x y∞ ≤ ≤= −

; 1

1( , ) i i

i nD x y Max x y

n∞ ≤ ≤= −

;

• 11

( , ) i ii n

d x y x y≤ ≤

= −∑

; 11

1( , ) i i

i n

D x y x yn ≤ ≤

= −∑

;

•

1

22

21

( , ) ( )i ii n

d x y x y≤ ≤

= − ∑

1

22

21

1( , ) ( )i i

i n

D x y x yn ≤ ≤

= −

∑

(d2 est la distance eucli-

dienne) ;

•

1

1

( , ) ( )p

pp i i

i n

d x y x y≤ ≤

= − ∑

1

1

1( , ) ( )

pp

p i ii n

D x y x yn ≤ ≤

= −

∑

pour p entier, 1p ≥ .

Les trois résultats suivants donnent le paramètre de tendance centrale et la dispersion asso-ciée, relativement à trois de ces distances, parmi les plus classiques.

Théorème 1

( , )d x c∞

est minimal lorsque c est égal à la moyenne des valeurs extrêmes de la série. La valeur de ce minimum est la demi-étendue de la série.

La démonstration est immédiate.

Théorème 2

1( , )D x c

est minimal lorsque c est égal à la médiane Me de la série. La valeur de ce mini-mum est l’écart moyen à la médiane (EMM ).

La démonstration du premier résultat peur être conduite en cycle terminal de la série S pour une série ayant 3 ou 4 valeurs, admise pour les séries d’ordre supérieur.

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 5 Robert FERACHOGLOU

Théorème 3

2( , )D x c

est minimal lorsque c est égal à la moyenne x de la série. La valeur de cette distance euclidienne minimale est l’écart-type de la série.

Ce résultat, hors de portée des élèves de lycée, se justifie de deux façons : - analytiquement, en étudiant le minimum de 2

1

( )ii n

x x x≤ ≤

−∑֏ ;

- géométriquement, en remarquant que la distance euclidienne dérive d’un produit scalai-re, et que la distance minimale de x

à la droite vectorielle engendrée par c

, qui est aussi

engendrée par le vecteur (1,...,1)u

, est minimale pour le projeté orthogonal sur cette droite vectorielle. Ainsi c

doit être le projeté orthogonal de x

sur u

ℝ ; il est calculé par

les conditions : ( ,..., )c c c

et . .c x c c= .

On en tire : 21 ... . .ncx cx c x c c nc+ + = = =

.

D’où : 1 ... nx xc x

n

+ += = (moyenne de la série).

La dispersion associée est la distance minimale correspondante, soit : 1

22

21

1( , ) ( )i

i n

D x x x x sn ≤ ≤

= − = ∑

(c’est l’écart-type de la série).

Ainsi, le couple (moyenne, écart-type) joue-t-il un rôle privilégié parmi les paramètres.

c) Que choisir en classe ? L’aspect théorique précédent ne doit pas être soulevé en classe ; il a cependant le mérite

de montrer que les résumés numériques fonctionnent par deux : un paramètre de tendance centrale et l’indicateur de dispersion qui lui mathématiquement associé. Il faut également re-tenir que les valeurs extrêmes de la série ainsi que le seul paramètre de dispersion qui est of-ficiellement au programme de seconde, à savoir l’étendue, ne doivent pas être méprisés mê-me s’ils sont relativement grossiers : ils interviennent en liaison avec la distance d∞ . Ces pa-

ramètres ont d’ailleurs une importance réelle dans les séries statistiques où intervient un si-nistre, voire une catastrophe ; ainsi les plans d’occupation des sols doivent tenir compte des hauteurs maximales des cours d’eau plutôt que de leur hauteur moyenne, les normes sismi-ques des bâtiments que l’on construit prennent la mesure des plus grandes magnitudes cons-tatées des séismes, etc.

D’autre part, il est important de montrer aux élèves que, pour une série numérique, moyenne et médiane peuvent être très différentes, et de les entraîner à réfléchir à la pertinen-ce du choix des paramètres. La moyenne est très usuelle, mais elle est peu robuste relative-ment à des valeurs extrêmes très élevées ; ainsi le salaire moyen en France est relativement trompeur pour rendre compte du revenu des habitants. Les paramètres d’ordre et leur repré-sentation (médiane, quartiles, déciles, boîtes de dispersion) sont souvent plus appropriés. De plus ces paramètres donnent du sens à la fonction cumulative des fréquences, dont l’équivalent probabiliste est la fonction de répartition d’une variable aléatoire.

III – DÉFINIR UNE LOI DE PROBABILITÉ 1. Expérience aléatoire et modélisation

a) Qu’est-ce que modéliser ? Modéliser une expérience aléatoire, c’est définir les résultats possibles (appelés « résultats »

ou « issues » ou encore « événements élémentaires ») 1x , …, nx , que l’on supposera être en

nombre fini en classe de seconde, et leur affecter une suite de nombres 1p , …, np tous positifs

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 6 Robert FERACHOGLOU

A

d

ou nuls et dont la somme est égale à 1. L’ensemble des issues 1,..., nx xΩ = est l’univers, le

nombre ip est appelé probabilité de l’issue ix , le n-uplet 1( ,..., )np p est la loi de probabilité asso-

ciée aux n issues. Le mot probabilité a deux sens qu’il ne faut pas confondre, il désigne ici les nombres affectés aux différentes issues, il va désigner aussi une application p qui à chaque évé-nement A (au lycée, un événement désigne toute partie de Ω ; en théorie des probabilités, un événement est une famille de parties appelée tribu qui vérifie certaines conditions de stabilité) associe un nombre compris entre 0 et 1 : la somme des probabilités (au premier sens du terme) des issues qui appartiennent à A.

La modélisation soulève quatre questions. Est-elle mathématiquement juste ? Est-elle uni-

que ? Dépend-elle objectivement d’une expérience aléatoire ? Est-elle satisfaisante par rapport à l’expérience ?

La justesse mathématique est garantie par les conditions imposées, même si la modélisation n’est pas satisfaisante ; on peut en effet modéliser les six issues résultant du lancement d’un dé

équilibré en affectant les probabilités 1

2,

1

10,

1

10,

1

10,

1

10,

1

10 aux différentes issues. Cela per-

mettra d’effectuer des calculs justes, mais sûrement pas satisfaisants relativement à l’expérience. La modélisation n’est pas unique, comme on peut le voir en avec l’expérience consistant à

prélever trois boules dans une urne ; on peut considérer que les boules sont prises ensemble et se ramener à des calculs de combinaison, ou les ordonner et raisonner en termes d’arrangements. On sait bien que ces deux modélisations (à la fois justes et satisfaisantes) conduisent aux mêmes résultats.

La question de l’objectivité a été le credo des mathématiciens jusqu’à la fin du XIXème siè-cle ; il a été ébranlé lorsque Emile BOREL a démonté le paradoxe de Bertrand décrit ci-dessous. On sait depuis lors que le fait de choisir au hasard n’induit aucune modélisation mathématique objective, et il faut préciser le protocole expérimental utilisé. Donnons-en trois exemples ; le premier (il s’agit du paradoxe de Bertrand) est difficile, mais présente un grand intérêt histori-que ; les deux autres sont abordables en classe de seconde. Exemple 1 : le paradoxe de Bertrand Jusqu’à la fin du XIXe siècle, les mathématiciens avaient l’espoir que chaque « événement » ré-sultant d’une expérience aléatoire ait une probabilité objective calculable. Cette croyance a volé en éclat après la publication en 1889 par Joseph Bertrand d’un célèbre paradoxe qui a jeté un grand trouble dans les esprits, et a ainsi rendu nécessaire une axiomatisation rigoureuse des pro-babilités. On choisit une corde au hasard sur un cercle. Quelle est la probabilité p qu’elle soit plus longue que le côté du triangle équilatéral inscrit dans le cercle (de centre O, de rayon r) ? • Première modélisation : une extrémité A de la corde est fixée, l’autre extrémi-

té M est choisie au hasard sur la circonférence. La corde répond à la question lorsque M est sur l’arc du cercle situé à droite de la droite d. La longueur de cet arc est le tiers de la circonférence, donc :

1

3p = .

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 7 Robert FERACHOGLOU

A

B

• Deuxième modélisation : le milieu I de la corde est choisi au hasard sur un dia-mètre [AB]. La corde répond à la question lorsque I est choisi sur un segment dont les ex-trémités sont situées au quart et aux trois quarts de [AB] ; la longueur de ce

segment est la moitié du diamètre, donc : 1

2p = .

• Troisième modélisation : le milieu I de la corde est choisi au hasard dans le disque. La longueur de la corde dépasse celle du côté d’un triangle équilatéral inscrit lorsque I est situé à l’intérieur du disque concentrique de rayon moitié (grisé sur la figure). L’aire de ce disque est égale au quart de celle du disque de

départ, donc : 1

4p = .

Exemple 2 : le problème des cases (Manuel de 1ère S, Collection Terracher, 2001) On choisit au hasard une case blanche dans le damier ci-contre. Quelle est la probabilité d’obtenir une case ayant le numéro 1 ? 2 ? 3 ? 4 ? 5 ? On vérifie sans peine que les trois protocoles suivants ne donnent pas les mêmes résultats : • Protocole 1 : on choisit au hasard une case blanche parmi les cinq. • Protocole 2 : on choisit au hasard une colonne parmi les trois, puis une case blanche dans la

colonne choisie. • Protocole 3 : on choisit au hasard une ligne parmi les trois, puis une case blanche dans la li-

gne choisie Exemple 3 : le problème des bancs (Manuel de Terminale C et E, Analyse et probabilité, Collec-tion Terracher, 1992) Ce problème est repris sous un habillage à peine modifié dans le document d’accompagnement du programme de seconde, page 8. Dans une pièce se trouvent trois bancs de deux places chacun. Deux personnes entrent et s’assoient au hasard. Quelle est la probabilité qu’elles s’assoient côte à côte ? • Protocole 1 : on place dans une urne trois boules marquées A, B, C correspondant aux trois

bancs. La première personne choisit une boule au hasard, la remet dans l’urne, et va s’asseoir au hasard sur l’une des deux places du banc indiqué. La deuxième personne procède de mê-me.

• Protocole 2 : on place dans une urne six boules marquées 1, 2, 3, 4, 5, 6 correspondant aux six places. La première personne tire une boule au hasard et va s’asseoir à la place indiquée ; la deuxième personne procède de même avec les cinq boules restantes

Il est aisé de calculer, par exemple en recourant à un arbre, que la probabilité cherchée est égale à 1

3 dans le premier cas, à

1

5 dans le deuxième.

1

2 3

4 5

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 8 Robert FERACHOGLOU

b) Les modélisations satisfaisantes

Il existe plusieurs modélisations satisfaisantes d’une même expérience aléatoire. Par exem-ple, lorsqu’on lance un dé équilibré, on peut définir l’univers 1, 2, 3, 4, 5, 6 avec

l’équiprobabilité des issues, ou l’univers « six », « autres nombres » avec la loi 1 5

,6 6

. Le

choix dépend des objets d’étude. Qu’est-ce qu’une modélisation satisfaisante ? Du point de vue mathématique, la définition

d’une loi de probabilité 1( ,..., )np p associée aux issues 1( ,..., )nx x est irréprochable dès lors que

les ip sont tous positifs et de somme égale à 1 ; elle permet de calculer les probabilités de cha-

que événement. Ce n’est pas suffisant pour que le modèle soit en accord avec l’expérience aléa-toire. Une détermination satisfaisante des ip est difficile a priori sauf dans quelques cas particu-

lier : − lorsque l’on reconnaît une expérience déjà connue ; − lorsque l’on a de bonnes raisons de postuler l’équiprobabilité des issues (tirage aléatoire

d’objets identiques, symétries d’un dé ; − etc. Dans tous les autres cas, et c’est une spécificité du calcul probabiliste, la vérification d’un modè-le ne peut intervenir qu’a posteriori par la loi des grands nombres, que l’on peut énoncer de fa-çon qualitative en termes vulgarisés : « Si le modèle est bon, lorsqu’on réalise un grand nombre de fois l’expérience aléatoire, la dis-tribution des fréquences des différentes issues doivent se rapprocher des probabilités. » Ainsi la réalisation effective d’une expérience aléatoire (ou une simulation satisfaisante) peut donner une idée de la valeur des probabilités, et ce d’autant mieux que le nombre d’expériences est grand, mais ne permet en aucun cas d’en déterminer les valeurs exactes ; par contre, les expé-riences répétées peuvent permettre de réfuter un modèle erroné.

2. Les lois des grands nombres Il existe plusieurs versions de cette loi. Nous en donnons une version édulcorée, liant la fréquen-ce de réalisation d’un événement et sa probabilité. Dans une expérience aléatoire, on considère un événement A de probabilité p. Lorsqu’on ré-alise n fois de façon indépendante cette même expérience aléatoire, on considère la variable

aléatoire nombre de réalisations de

n

AF

n= . Des valeurs statistiques fn de la variable Fn sont ob-

tenues chaque fois qu’on réalise effectivement n fois l’expérience : fn est la fréquence des occur-rences de A sur n expériences. Les lois des grands nombres démontrent mathématiquement que la suite ( )nF converge vers p en un certain sens :

- la loi faible (établie par Jacques Bernoulli, publiée en 1713 dans son ouvrage posthume Ars conjectandi) énonce que pour tout 0ε > , la probabilité que Fn s’écarte de p de plus de ε tend vers 0 lorsque n tend vers +∞ ; autrement dit :

0ε∀ > , ( )lim | | 0nn

P F p ε→+∞

− > = .

Une démonstration élémentaire s’appuie sur l’inégalité classique de Bienaymé-Tchebychev (si X est une variable aléatoire de moyenne finie m et d’écart-type fini σ ,

alors pour tout 0h > , on a ( ) 2

1| |P X m h

hσ− > ≤ ).

- la loi forte (plus puissante et plus difficile, conséquence des travaux réalisés au XXe siè-cle par Emile Borel, Francesco Cantelli et Andreï Kolmogorov) précise que lim n

nF p

→+∞=

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 9 Robert FERACHOGLOU

pour presque toutes les expériences. Au sens de la théorie de la mesure, cela signifie que l’événement « lim n

nF p

→+∞= » a pour probabilité 1.

Pratiquement cela assure dans presque tous les cas que la fréquence observée expérimenta-lement se rapproche d’une valeur théorique p. La modélisation devrait donc attribuer cette valeur p à la probabilité. Cette conception, dite fréquentiste, offre l’avantage d’être cohérente avec l’approche statistique.

3. L’approche fréquentiste en classe

Cette approche a dû être réalisée en classe de troisième. Il n’est peut-être pas inutile de la compléter en seconde, à partir d’une expérience aléatoire simple à réaliser ou simuler.

Prenons le cas du lancer de dé, où l’on s’intéresse à la fréquence d’apparition du six. Il s’agit d’observer la stabilisation des fréquences lorsque l’on augmente le nombre de lancer en traçant la courbe d’évolution de la fréquence fn de l’issue choisie en fonction du nombre n de lancers. Un tableur semble indispensable étant donné le grand nombre de lancers requis, et un fichier prêt à servir est disponible sur le serveur académique. En observant l’évolution de la fréquence de sor-tie du six sur 3000 lancers, on a obtenu la courbe suivante, qui montre clairement une stabilisa-tion.

Un autre type d’expérience peut être réalisé à la main pour conjecturer une probabilité incon-

nue. Un exemple classique consiste à lancer une punaise en métal qui peut tomber soit la pointe sur la table (position A) soit la pointe en l’air (position B). En répartissant les expériences et les calculs dans une classe, on peut observer à nouveau sur environ 600 lancers une relative stabili-sation des fréquences.

IV – SIMULATION 1. Peut-on simuler une expérience aléatoire ?

On veut simuler une expérience aléatoire pour plusieurs raisons : parce que celle-ci est trop difficile à réaliser, trop coûteuse ou trop fastidieuse (à cause du grand nombre de données), parce qu’elle peut comporter une issue catastrophe, etc. La simulation est utile essentiellement pour permettre certaines découvertes, conforter ou infirmer une hypothèse, etc. Le désir de confier l’expérimentation à une simulation se heurte cependant à un obstacle de taille : on ne peut pas simuler une expérience aléatoire, mais seulement une loi de probabilité connue. Cela signi-fie qu’une expérience aléatoire demande un minimum de modélisation avant d’être simulée ; ain-si, pour étudier l’attente de clients dans un dispositif comportant plusieurs sorties (guichets à la poste, caisses de supermarché, péages d’autoroute), on ne pourrait rien simuler sans postuler que

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 10 Robert FERACHOGLOU

l’arrivée de chaque client suit une loi connue, décrite par un processus de Poisson (le nombre d’arrivées dans un intervalle de temps donné suit une loi de Poisson, le temps entre deux arrivées suit une loi exponentielle).

Ainsi la simulation ne permet pas de découverte ab nihilo, mais peut simplement faire con-jecturer des paramètres liés à des lois complexes, en s’appuyant sur la simulation de lois élémen-taires mieux connues. Par exemple, lorsqu’on lance n fois un dé ( 2n ≥ ), on peut conjecturer à l’aide d’une simulation une valeur approchée de certaines probabilités (relatives à la somme des chiffres, au maximum, à l’obtention d’une série donnée …), à partir de la simulation de la loi uniforme sur 1, 2, 3, 4, 5, 6 correspondant à chaque lancer, cette dernière étant parfaitement connue.

2. Nombres aléatoires a) Qu’est-ce qu’un nombre aléatoire ?

La simulation consiste à fabriquer à l’aide d’un programme de calcul une suite de nom-bres 1x , …, nx , indépendants les uns des autres, où chaque nombre suit une loi de probabilité

voulue. On peut obtenir de tels échantillons à partir d’un générateur de nombres aléatoires (procédé « Random » qui devrait fonctionner comme le tirage aléatoire d’un nombre réel ap-partenant à l’intervalle [0 ; 1[), ou à partir d’une table de nombres aléatoires (tirage aléatoire avec remise des chiffres 0, 1, …, 9). Le générateur permet en pratique d’obtenir une table de nombres aléatoires, qui sont les décimales du nombre aléatoire.

La définition correcte d’un nombre aléatoire n’est pas simple ; écrit en base deux, les chiffres 0 et 1 de ce nombre doivent se comporter comme les piles et faces obtenues lors-qu’on lance une infinité de fois au hasard une pièce de monnaie équilibrée ; écrit en base dix, un tel nombre pourrait être défini par ses décimales comme si l’on tirait sans relâche et avec remise dans une urne des boules marquées 0, 1, …, 9. Dans ce dernier cas : − un nombre aléatoire est nécessairement irrationnel, car un rationnel, ayant ses décimales

périodiques, ne peut pas contenir certaines séquences dans la suite de ses décimales ; − les chiffres 0, 1, …, 9 doivent être équiprobables, mais ce n’est pas suffisant car le nom-

bre 0,1234567890 1234567890 ...n’est pas équiprobable car la séquence 11 par exemple n’apparaît jamais ; de tels nombres sont dits « équirépartis en base dix » ;

− les 100 séquences 00, …, 99 doivent se retrouver avec la même fréquence, ainsi que les 1000 séquences 000, …, 999, et plus généralement les 10n séquences 0…0, …, 9…9 (n chiffres) doivent se retrouver avec la même fréquence 10 n− . Les conditions très fortes imposées à ces nombres (appelés « normaux en base dix ») font douter de leur existence ; cette propriété de normalité a pourtant été prouvée pour certains d’entre eux, comme le nombre de Champernowne 0, 1234567891011121314… (formé en juxtaposant la suite des entiers naturels) ; on conjecture que les nombres e et π sont eux aussi normaux en base dix, sans avoir pu le prouver. Cependant, les nombres normaux ne sont pas nécessai-rement aléatoires comme on peut le voir avec le nombre de Champernowne dont les dé-cimales sont parfaitement déterminées et donc prévisibles ;

− d’autres nombres comme π ont des décimales sans régularité, mais ne sauraient être con-sidérés comme des nombres aléatoires : on connaît très bien de courts programmes per-mettent d’obtenir les k premières décimales de π , ou même la k-ième sans passer par les précédentes (algorithmes compte-gouttes). Au cours du XXème siècle, de nombreuses tentatives pour définir un nombre aléatoire (ou

une suite de chiffres aléatoires) ont échoué, l’idée intuitive de désordre total dans les décima-les étant difficile à décrire en termes de fréquences. La solution est apparue d’abord en 1965 avec le suédois Per MARTIN-LÖF, puis une dizaine d’années plus tard avec le russe Andreï KOLMOGOROV et l’américain Gregory CHAITIN ; c’est la théorie de la complexité – liée au développement de l’informatique – qui en donne une définition satisfaisante : une suite de nombres est aléatoire si et seulement si elle est incompressible au sens informatique du ter-

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 11 Robert FERACHOGLOU

me, c’est-à-dire grosso modo s’il n’existe pas de programme d’obtention des n premières dé-cimales qui soit plus court … que d’en donner la liste ! On démontre qu’il existe de tels nombres, qui sont toutefois difficiles à appréhender, de part même leur définition (voir [9]).

Il faut donc renoncer à disposer de vrais nombres aléatoires, et l’on se contentera de gé-nérateurs qui fournissent des nombres pseudo-aléatoires, c’est-à-dire de nombres qui donnent l’apparence du désordre (certains auteurs, comme Jean-Louis PIEDNOIR, qui a été inspec-teur général de mathématiques, les nomment « nombres canada-dry », du nom de la célèbre boisson qui présente toutes les apparences de l’alcool, mais qui n’est pas de l’alcool), ou tout au moins de l’imprévisibilité, si l’on ne considère qu’une liste finie assez courte de décima-les.

b) Obtention de nombres pseudo-aléatoires

Les méthodes les plus employées sont basées sur des suites récurrentes ; elles fournissent donc des suites périodiques qui, en théorie, n’ont donc rien d’aléatoire. On s’arrange pour que la période soit assez grande pour garder l’illusion du désordre.

Par exemple, dans la méthode multiplicative de Lehmer, on définit une suite d’entiers ( )ir par : 1 (mod )i ir ar b m+ ≡ + , où les entiers a, b, 0r bien choisis sont implémentés à la

création du processeur et m est le plus grand possible (sur ordinateur, on prend souvent 12pm −= , où p est le nombre de bits d’un mot machine, c’est-à-dire 32 ou 64). On considère

alors que les nombres 1

ir

m−forment une suite de nombres pseudo-aléatoires. (Voir [8].)

3. Simulation de quelques lois classiques

a) De quoi s’agit-il ? Il s’agit de simuler toute loi de probabilité connue à partir d’un échantillon de nombres

pseudo-aléatoires. Théoriquement cela revient, si une variable aléatoire U suit la loi uniforme sur [0 ; 1], à exprimer la loi d’une variable aléatoire donnée X en fonction de celle de U.

b) Loi équirépartie sur [[1 ; n]], l’ensemble des entiers compris entre 1 et n

Cette loi correspond au lancer aléatoire d’un « dé » à n faces ou au tirage au hasard dans une urne contenant des boules marquées 1, …, n. La variable ( ) 1X E nU= + suit la loi correspondante (E désignant la partie entière).

Cela signifie en pratique que si les iu sont des nombres pseudo-aléatoires, les nombres

( ) 1i ix E n u= × + sont des entiers au hasard compris entre 1 et n.

c) Loi uniforme sur l’intervalle [a, b]

La variable ( )X b a U a= − × + suit la loi uniforme sur l’intervalle [a, b].

d) Loi de Bernoulli de paramètre p, et loi binomiale La variable X définie par : 1X = si U p≤ et 0X = si U p> suit la loi de Bernoulli de

paramètre p. Si 1X , …, nX suivent la même loi de Bernoulli de paramètre p et sont indépendantes, alors

1 ... nX X X= + + suit la loi binomiale de paramètres n et p. Cela permet aisément de simuler

une loi binomiale à partir d’un générateur aléatoire, que l’on itère n fois. Lorsque n est grand, il est préférable de considérer que la loi binomiale est proche d’une loi normale (voir plus loin).

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 12 Robert FERACHOGLOU

e) Cas d’une variable aléatoire continue • Lorsque F, la fonction de répartition de X est continue et bijective, il est fréquent que

1F − ait une forme analytique simple (fonction exponentielle, fonctions gammas, …). Dans ce cas, l’égalité 1( )X F U−= permet de simuler la variable X (c’est la méthode dite « de l’anamorphose »).

• Lorsque X admet sur un intervalle [a, b] borné une densité f qui est elle-même bornée dans [0, m], on se donne une varia-ble 1U qui suit la loi uniforme sur [a, b], une variable 2U qui

suit la loi uniforme sur [0, m]. Si 2 1U U≤ , on conserve 1U qui

est une réalisation de X, sinon, on rejette 1U et on recom-

mence. (Méthode du rejet, voir [8]).

f) Loi de Poisson de paramètre m La méthode consiste à simuler un processus de Poisson (sans mémoire). Si X est une variable aléatoire suivant la loi de Poisson de paramètre m, on prend 1X …, nX des lois exponentiel-

les indépendantes de paramètre 1, alors l’événement ( )X n= est réalisé lorsque n est le plus

grand entier tel que 1 ... nX X m+ + < .

En pratique, cela signifie qu’à partir de nombres pseudo-aléatoires 1u , 2u , …, l’événement

( )X n= est réalisé lorsque n est le plus grand entier tel que 1

lnn

ii

u m=

− <∑ ; cette condition

permet une simulation simple sur tableur.

g) Loi normale (ou de Laplace-Gauss) Une méthode particulièrement simple repose sur le théorème de la limite centrée : si 1X , …,

nX sont des variables indépendantes ayant même loi d’espérance µ et d’écart-type σ , alors

en posant 1 ... nX XX

n

+ += , la variable /

X

n

µσ

−converge en loi vers n(0, 1), la loi normale de

moyenne 0 et d’écart-type 1. Ce résultat est en particulier valable pour des variables 1X , …, nX suivant la loi uniforme

sur [0, 1] (dont la moyenne est 1/2 et la variance 1/12), et on considère que l’approximation est correcte à partir de 12n = (Voir [8]). Cela signifie que 1 12...X X+ + a une loi proche de

n(6, 1). Donc la variable 1 12( ... 6)X m X Xσ= + + + − a une loi proche de n(m, σ ).

On peut donc simuler une variable normale X à partir de 12 nombres pseudo-aléatoires 1u ,

…, 12u en considérant que ( )X x= lorsque 12

1

6ii

x m uσ=

= + − ∑ .

V – LA FLUCTUATION D’ÉCHANTILLONNAGE 1. Echantillon statistique, échantillon probabiliste

Un échantillon statistique aléatoire de taille n est un n-uplet (x1, …, xn ) formé des résultats d’un tirage aléatoire réalisé n fois dans un ensemble fini Ω appelé population. Nous nous limitons au cas où les tirages sont effectués avec remise (tirages non exhaustifs), ce qui revient à supposer que les tirages sont mutuellement indépendants.

u1

u2

m

0 a b

X1 X2 Xn+1

E2 E1 0 En m En+1

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 13 Robert FERACHOGLOU

Exemples : - lorsqu’on lance 100 fois une pièce, on obtient un échantillon de taille 100 de la population

Pile, Face ; - lorsqu’on réalise un sondage portant sur 700 personnes vivant en France, on obtient un

échantillon de taille 700 de la population des gens vivant en France (63 000 000 d’individus environ).

D’un point de vue théorique, chacune des valeurs xi peut être considérée comme la réalisation

d’une même variable aléatoire X définie sur Ω. Les valeurs observées (x1, …, xn ) constituent alors une réalisation du n-uple ( X1, …, Xn ), où les Xi sont n variables aléatoires indépendantes et de même loi : celle de X. Le n-uple ( X1, …, Xn ) est un échantillon probabiliste de taille n ayant pour variable mère la variable X. La théorie de l’échantillonnage (voir § 3) étudie les propriétés du n-uple ( X1, …, Xn ) et des ca-ractéristiques le résumant (les statistiques), comme par exemple : la moyenne X , la fréquence F d’une valeur ou d’une modalité, le maximum, le minimum, l’étendue, les quantiles, … On englobe sous la locution « fluctuation d’échantillonnage » le fait : - d’observer qu’il existe des différences entre les diagrammes et les paramètres (fréquences,

moyennes, …) obtenus sur des échantillons statistiques distincts ; - d’interpréter à l’aide de la théorie probabiliste de l’échantillonnage si ces différences sont

compatibles avec la nature aléatoire du tirage, ou si elles sont « significatives », c’est-à-dire si elles remettent en cause ce caractère aléatoire. Le tout, bien sûr, étant entaché d’une certai-ne certitude (ou : avec une certaine probabilité).

« L'égalité des chances, c'est pour ceux qui ont de la chance. »

Cette citation du mathématicien et romancier Denis Guedj (Le théorème du perroquet), en

forme de boutade, doit illustrer le fait que l’égalité probabiliste des chances se retrouve rarement dans une expérience réelle ; il faut espérer qu’elle n’a rien à voir avec une vérité sociale !

2. Observation qualitative

Le premier objectif en seconde est de sensibiliser les élèves à la notion de fluctuation. Il est facile d’observer à l’aide d’une simulation sur tableur que, lorsqu’on lance 600 fois un dé, on n’obtient le même nombre d’occurrences des six issues. Il n’est pas rare non plus d’observer cer-tains écarts par rapport aux nombres théoriques de 100. Les graphiques suivants montrent quel-ques exemples que l’on peut obtenus sur Excel.

On notera en particulier que sur les trois échantillons aléatoires qui sont représentés, on a obtenu 123 fois le « 2 » dans l’échantillon n°3, 118 fois le « 2 » et le « 3 » ainsi que 81 fois le « 1 » et le « 5 » dans l’échantillon n°2. Ces fluctuations naturelles étant constatées, il est normal de s’interroger sur le caractère réelle-ment aléatoire des données en quantifiant l’étendue « naturelle » de la fluctuation statistique. C’est la théorie de l’échantillonnage qui en donne la garantie et les limites.

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 14 Robert FERACHOGLOU

3. Quelques éléments de théorie de l’échantillonnage

a) Définitions usuelles Un échantillon aléatoire de taille n est un n-uple 1( ,..., )nX X de variables aléatoires indépen-

dantes définies sur le même espace probabilisé, qui ont toutes la même loi qu’une variable X ap-pelée variable parente. Lorsqu’on réalise n tirages sans remise dans une population, les valeurs statistiques observées

1,..., nx x peuvent être considérées de deux manières :

- ce sont n réalisations indépendantes de la variable parente X ; - c’est une réalisation du n-uple 1( ,..., )nX X .

Une statistique T est une fonction mesurable de ces n variables aléatoires : 1( ,..., )nT f X X= .

C’est donc une nouvelle variable aléatoire qui s’exprime à l’aide de l’échantillon.

Quelques exemples de statistiques : 1 ... nn

X XM

n

+ += (appelée moyenne « empirique » de

l’échantillon), 1max( ,..., )nX X (maximum empirique), l’étendue, la médiane des Xi sont des sta-

tistiques classiques, mais aussi 2 2

1

1( )

n

i ni

S X Mn =

= −∑ (variance empirique de l’échantillon).

La théorie de l’échantillonnage étudie ces « statistiques » d’un point de vue probabiliste : leur loi exacte (par une formule, si on parvient à la déterminer, ou alors par des tables), ou bien leur loi asymptotique, à l’aide d’un théorème de convergence.

b) Rappel sur trois types de convergence d’une suite de variables aléatoires

• Convergence en probabilité La suite (Xn) converge en probabilité vers la constante a si pour tous ε et η ,

( )nP X a ε η− > < .

• Convergence presque sûre (ou convergence forte)

La suite (Xn) converge presque sûrement vers X si ( / lim ( ) ( ) ) 0nn

P X Xω ω ω≠ = .

• Convergence en loi (ou convergence faible)

La suite (Xn) converge en loi vers la variable X de fonction de répartition F si la suite (Fn) des fonctions de répartition des Xn converge simplement vers F, en tout point de continuité de F.

• Liens entre les différents types de convergence

Pour la démonstration, on pourra se reporter à [7] ou [8].

c) Distribution des moyennes empiriques et des fréquences empiriques

Presque sûre Probabilité Loi

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 15 Robert FERACHOGLOU

Soit 1( ,..., )nX X un échantillon aléatoire associé à la variable mère X, de moyenne µ et

d’écart-type σ . On note 1 ... nn

X XM

n

+ += la moyenne empirique de cet échantillon.

Théorème 1 : l’espérance et la variance de nM sont données par les relations :

( )nE M µ= et 2

( )nV Mn

σ= .

La première égalité est une conséquence immédiate de la linéarité de l’espérance. Pour la deuxième :

( )1 12 2

1 1( ) ( ... ) ( ) ... ( )n n nV M V X X V X V X

n n= + + = + + d’après l’indépendance.

On en tire : 2

22

1( )nV M n

n n

σσ= × = .

Théorème 2 (lois des grands nombres) La suite ( )nM converge en probabilité vers µ (loi faible), et converge presque sûrement vers

la variable constante égale à µ (loi forte). Théorème 3 (théorème de la limite centrée)

La suite de terme général /nM

n

µσ

− converge en loi vers la variable normale centrée réduite

(qui a pour de moyenne 0 et pour écart-type 1. On la note n(0 ; 1). Pour la démonstration de ces deux théorèmes, voir par exemple [8]. Cela entraîne que pour n grand, les lois de ces variables sont proches, ou encore que la loi

nM est proche de celle de la loi normale n ,n

σµ

, de moyenne µ et d’écart-type n

σ. En

pratique, on considère que cette approximation est bonne pour 25n ≥ et 0,2 0,8p≤ ≤ . Dans le cas particulier où les Xi sont des variables de Bernoulli associées à un événement de probabilité p, la variable Mn = Fn est la proportion empirique de réalisations de cet événe-ment. Le théorème 3 se traduit alors dans le résultat suivant. Théorème 4 :

La suite de terme général (1 ) /

nF p

p p n

−−

converge en loi vers la variable normale centrée

réduite n(0 ; 1).

En d’autres termes, nF ≈ n(1 )

,p p

pn

−

, loi normale de moyenne p et d’écart-type

(1 )p p

n

−.

Ce résultat est à la base de la quantification de la fluctuation d’échantillonnage (voir §4).

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 16 Robert FERACHOGLOU

Il est bon de retenir quelques caractéristiques essentielles de la loi normale centrée réduite (voir graphique suivant).

d) Variance empirique

On considère la variable 2 2

1

1( )

n

i ni

S X Mn =

= −∑ (variance empirique de l’échantillon).

Il est facile d’établir que 2 2 2

1

1 n

i ni

S X Mn =

= − ∑ , ce qui montre que 2 2S σ→ presque sûre-

ment. Mentionnons encore le résultat suivant, qui est fort utile dans l’estimation d’un écart-type. Théorème 5

L’espérance de 2S est donnée par l’égalité : 2 21( )

nE S

nσ−= .

Démonstration : d’après l’égalité précédente, 2 2 2

1

1( ) ( ) ( )

n

i ni

E S E X E Mn =

= − ∑ , soit :

2 2 2 2 21( ) ( ) ( ) ( ) ( )n nE S n E X E M E X E M

n= × − = − . (1)

Or 2 2 212 2

1

1 1( ) ( ... ) ( ) ( )

n

n n i i ji i j

E M E X X E X E X Xn n = ≠

= + + = +

∑ ∑ .

Les iX étant indépendantes, on a 2( ) ( ) ( )i j i jE X X E X E X µ= = ; on en tire :

2 2 2 22

1 1 1( ) ( ) ( 1) ( )n

nE M nE X n n E X

n n nµ µ−

= + − = + . (2)

-5 -4 -3 -2 -1 0 1 2 3 4 5

2

21

( )2

x

f x eππππ

−−−−====

0,68

0,95

0,997

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 17 Robert FERACHOGLOU

D’après (1) et (2), il vient : 2 2 21( ) 1 ( )E S E X

nµ = − −

, soit 2 21( )

nE S

nσ−= .

4. Quelques éléments quantitatifs de fluctuation

Lorsqu’on réalise une expérience aléatoire, il est naturel que les valeurs observées s’écartent des valeurs théoriques, mais pas trop cependant. Il est important de chiffrer cet écart qui, s’il sort des bornes « raisonnables » prévues par la théorie (on parle alors d’écart « significatif »), permet de mettre en doute le caractère aléatoire de l’expérience. La théorie s’appuie sur deux types de résultats ; l’un est modeste mais non méprisable, puisqu’il s’agit de l’inégalité de Bienaymé-Tchebychev ; les autres proviennent de la théorie de l’échantillonnage, et il s’agit essentiellement des théorèmes de convergence (lois des grands nombre, théorème de la limite centrée, conver-gence vers la loi normale). Dans les deux cas, la fluctuation est soumise à deux paramètres qui sont l’intervalle de fluctuation et la probabilité pour que les valeurs observés soient dans cet in-tervalle ; la difficulté essentielle est de comprendre (et de faire comprendre) cette dialectique dans laquelle les deux paramètres sont antagonistes : ce que l’on gagne en rayon d’intervalle est perdu en probabilité, c’est-à dire en certitude de tomber dans l’intervalle donné.

Par exemple, dans le jeu de pile ou face, on s’intéresse à la proportion de faces sur n lancers.

Pour chaque lancer, la probabilité est 0,5p = et l’écart-type 0,5 (1 0,5) 0,5σ = × − = , donc la

variable aléatoire nX qui décompte le nombre de faces sur n lancers a pour moyenne 0,5 n× ,

pour variance 4

n, pour écart-type

2

n. Ainsi la fréquence nF des faces a pour moyenne 0,5 et

pour écart-type 1

2 n.

L’inégalité de Bienaymé-Tchebychev prévoit que pour tout 0h > , la probabilité que nF ne soit

pas contenu dans l’intervalle 0,5 ,0,52 2

h h

n n

− +

n’excède pas 2

1

h. Ainsi, pour 2h = , on

trouve qu’il y a au plus une chance sur 4 pour que nF ne soit pas contenu dans l’intervalle

1 10,5 ,0,5

n n

− +

. Ce renseignement quantitatif est amélioré en certitude par le théorème de

la limite centrée qui dit que ( )nF converge en loi vers n1

0,5;2 n

. Une table de la loi normale

centrée réduite permet alors d’évaluer qu’il y a environ une chance sur 20 pour que nF ne soit

pas contenu dans l’intervalle 1 1

0,5 ,0,5n n

− +

. L’amélioration en certitude est considéra-

ble : on dit que l’intervalle 1 1

0,5 ,0,5n n

− +

est l’intervalle de fluctuation de nF avec la

certitude à 0,95 (on dit aussi : au seuil de 95 %). Cela peut être vérifié expérimentalement, sur un grand nombre d’échantillons ; avec 100n = et 1600 échantillons, nous avons obtenu le graphique suivant sur Excel.

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 18 Robert FERACHOGLOU

On observe sur cette simulation que le pourcentage d’échantillons de taille 100 pour lesquels la fréquence de faces est extérieure à l’intervalle de fluctuation [0,4 ; 0,6] est effectivement proche de 5%. Ce type de simulation peut être simplement montré aux élèves si l’on veut aller vite ; il n’est pas inintéressant de le proposer en travail à la maison, car c’est un bon exercice très complet utilisant le tableur, avec la fonction « random », le graphique, une instruction conditionnelle, une fonction de décompte, …).

Plus généralement, pour un événement de probabilité p , la fréquence de réalisation nF sur un

échantillon de taille n a pour moyenne p et pour écart-type (1 )p p

n

−. Le théorème de la limite

centrée affirme que (1 )nF p

p p

n

−−

converge en loi vers n(0 ; 1), donc la loi de nF est proche de celle

de la variable aléatoire gaussienne n(1 )

;p p

pn

−

; cela impose en particulier que l’intervalle

de fluctuation au seuil de 95 % est proche d’un intervalle de centre p et de rayon

(1 )1,96

p p

n

−. On supposera pour simplifier que 1,96 2≈ et l’on majore (1 )p p− par

1

4, ce

qui est classique lorsque 0 1p≤ ≤ . En comptant large, on est ainsi assuré d’un intervalle de fluc-

tuation égal à 1 1

;p pn n

− +

au seuil de 95%. Pratiquement, cette approximation est bonne

lorsque p n’est pas trop proche de 0 ou de 1 et n assez grand (le programme préconise les condi-tions 0,2 0,8p≤ ≤ et 25n ≥ ).

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 19 Robert FERACHOGLOU

Voici trois intervalles de fluctuation classiques, donnés par la table de la loi normale.

Intervalle de fluctuation Seuil

1 1;

2 2p p

n n

− +

68 %

1 1;p p

n n

− +

95%

3 3;

2 2p p

n n

− +

99%

VI – LA STATISTIQUE INFÉRENTIELLE 1. Estimation de paramètres et prévision

a) Position du problème Il s’agit d’estimer certains paramètres d’une population à partir des valeurs relevées sur un échantillon statistique. Le cadre des sondages motive cette problématique : on veut par exemple estimer le pourcentage de Français qui pensent ceci ou cela en interrogeant seule-ment 1000 personnes, ou encore donner le résultat de la présidentielle à 20 heures à partir de seulement 30000 bulletins électoraux dépouillés. C’est la théorie de l’échantillonnage (voir plus haut) qui donne un fondement solide à ces estimations. On se place toujours dans le ca-dre d’échantillons aléatoires de taille n indépendants avec remise, analogues à des tirages dans une urne avec remise. C’est le seul cadre qui donne des résultats permettant un contrôle mathématique de la précision (notion de fourchette ou d’intervalle de confiance) et de la cer-titude (en terme de probabilité) ; ce n’est malheureusement pas le cas des sondages d’opinion où le choix des sondés n’a aucun caractère aléatoire mais relève de choix empiriques propres à l’institut de sondage, qui peuvent s’avérer justes ou erronés, mais sur lesquels on n’a aucun contrôle mathématique de la précision ou de la certitude.

b) Estimation ponctuelle de certains paramètres Un estimateur d’un paramètre est une variable aléatoire qui est censée approcher ce paramè-tre en un certain sens. La première qualité d’un estimateur est de converger (en loi, presque sûrement) vers ce paramètre. Ainsi, avec les notations de V 3, les variables nM , nF , 2S sont

des estimateurs des paramètres µ , p, 2σ , moyenne, proportion, et variance respective dans une population. On a bien, d’après les résultats précédents : nM µ→ , nF p→ et 2 2S σ→ en loi (théorèmes

3 et 4). Lorsque T est un estimateur du paramètre θ , l’erreur d’estimation T θ− est une variable aléatoire qui peut se décomposer ainsi :

( ) ( )fluctuation aléatoire de T erreur systématiqueautour de sa moyenne

T T E T E Tθ θ− = − + −

.

L’erreur systématique ( )E T θ− est appelée le biais de l’estimateur ; en pratique, on essaie d’utiliser des estimateurs pour lesquels ce biais est nul, on les appelle estimateurs sans biais.

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 20 Robert FERACHOGLOU

D’après le théorème 1, on a ( )nE M µ= et par voie de conséquence ( )nE F p= , donc nM et

nF sont des estimateurs sans biais de µ et p.

Par contre (théorème 5), 2 21( )

nE S

nσ−= , donc 2S possède un biais ; c’est pourquoi l’on ré-

fère choisir 2

1

nS

n− pour estimer 2σ ; ce nouvel estimateur converge aussi en loi vers 2σ et

il est sans biais. En pratique, cela signifie que dans le cadre de l’échantillonnage (tirage aléatoire d’un échan-tillon de taille n indépendant avec remise), on peut estimer une moyenne µ , une proportion

p, un écart-type σ en mesurant la moyenne nm , la fréquence nf , l’écart-type ns de cet

échantillon, et en appliquant la règle de conduite suivante.

Valeur exacte du paramètre dans la population

µ p σ

Valeur estimée à partir d’un échantillon de taille n nm nf

1 n

ns

n−

c) Estimation par intervalle de confiance

On peut se limiter ici à l’estimation d’une proportion, qui se rattache à la problématique des sondages ; là-dessus, le futur citoyen mérite une sensibilisation quantitative, et ce d’autant plus que l’inculture ambiante (celle des media, mais aussi celle de bien des politiques) ne fa-cilite pas la réflexion sur ce type d’information chiffrée. On a vu que, d’après le théorème de la limite centrée, si p est la proportion d’une modalité dans une population (par exemple, la proportion des Français qui ont voté pour le candidat X à une élection) la fréquence nf du

vote X se trouve dans l’intervalle 1 1

;p pn n

− +

dans 95% des échantillons aléatoires

avec remise de taille n. Or 1 1 1 1

; ;n n nf p p p f fn n n n

∈ − + ⇔ ∈ − +

.

Cela permet de dire que, parmi tous les échantillons de taille n, le nombre inconnu p appar-tient à 95% d’entre eux.

L’intervalle 1 1

;n nf fn n

− +

est la fourchette de confiance de p au seuil de 95%.

Remarques • Pour être plus précis, on peut travailler avec une valeur estimée sans biais de l’écart-type,

ce qui revient à multiplier le nombre 1

n par

1

n

n− (voir c) ; on obtient alors

l’intervalle 1 1

;1 1

n nf fn n

− + − − , qui est celui considéré dans les classes de BTS. Il

ne s’agit pas d’entrer dans ce raffinement en classe de seconde. • Il est intéressant d’observer comment varie le rayon de la fourchette en fonction de n. On

obtient les résultats suivants.

n 100 400 900 1600 2500 10000 40000 Rayon de la fourchette 10% 5% 3,3% 2,5% 2% 1% 0,5%

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 21 Robert FERACHOGLOU

• On peut en tirer plusieurs enseignements. Par rapport aux sondages d’opinion (qui rappe-

lons-le portent en général sur 900 personnes environ, et ne sont pas effectués selon la mé-thode de l’échantillonnage aléatoire), la fourchette a une amplitude supérieure à 6%, ce qui est rarement annoncé par les journalistes, et parfois passé sous silence par les instituts de sondage eux-mêmes ; les élèves méritent d’être prévenus là-dessus. Par rapport aux sondages « sortis des urnes » qui annoncent très tôt le résultat d’une élection, dans la me-sure où l’échantillon prélevé est aléatoire (ce qui est rarement le cas), il est remarquable que seulement 10000 bulletins dépouillés donnent une fourchette de 1%± , et seulement 40000 donnent une fourchette de 0,5%± ; c’est ainsi que l’on peut connaître avec une excellente précision et une bonne certitude le résultat de l’élection présidentielle dès 20 heures le soir du deuxième tour. Ce résultat est d’autant plus remarquable qu’il est indé-pendant de la taille de la population, puisqu’il dépend seulement de la taille de l’échantillon.

d) Où s’arrêter en seconde ?

En classe de seconde, l’objectif demeure très modeste ; il s’agit de sensibiliser les élèves à la notion de sondage pour estimer une proportion, et aux deux « insatisfactions » qui sont inhé-rentes à ce travail : la première est liée à l’imprécision, avec la notion de fourchette, la deu-xième à l’incertitude avec la notion de seuil de confiance. On pourra mener un travail de son-dage à partir de données réelles, comme il est prescrit dans le document ressource [4].

2. Les tests et la décision

Les tests sont abordés dans les classes de techniciens supérieurs ; ce sont des processus tech-niques extrêmement codés qui ne seront pas abordés dans ce document. Ils s’inscrivent dans la problématique de la prise de décision, à quoi les élèves de terminale S sont sensibilisés lorsqu’on aborde l’adéquation à une loi de probabilité. L’objectif en seconde est uniquement d’amener les élèves à un questionnement sur la prise de décision, à partir de résultats statistiques sur un échantillon, et plus précisément à partir de la connaissance d’un intervalle de fluctuation. C’est un premier contact avec la notion de preuve statistique. Le raisonnement est le suivant : pour apprécier si la fréquence observée f sur un échantillon de taille n d’un événement de probabilité p est compatible avec le caractère aléatoire d’une expé-rience, on regarde si f appartient à l’intervalle de fluctuation au seuil de 95%, à savoir l’intervalle

1 1;p p

n n

− +

. Dans le cas contraire, on décide de réfuter le caractère aléatoire de cette ex-

périence. Un exemple intéressant est donné dans le document d’accompagnement du programme, à partir des personnels de deux entreprises :

Hommes Femmes Total Entreprise A 57 43 100 Entreprise B 1350 (54%) 1150 (46 %) 2500

Il s’agit d’observer et de décider si ces deux entreprises respectent la parité hommes-femmes. Au premier examen, cette parité est mieux respectée dans l’entreprise B qui ne comporte que 54% d’hommes au lieu de 57% dans l’entreprise A. La détermination des intervalles de fluctuation statistique naturelle au seuil de 95% vont mieux guider la décision :

L’articulation probabilités-statistiques Journées de l’inspection - Octobre 2009 Page 22 Robert FERACHOGLOU

Effectif Intervalle de fluctuation au seuil de 95% dans le cas d’une répartition aléatoire

Entreprise A 100 [0,4 ; 0,6]

Entreprise B 2500 [0,48 ; 0,52]

Dans l’entreprise A, les proportions 0,57 et 0,43 appartiennent à l’intervalle donc on ne peut pas rejeter le fait que la parité est respectée ; dans l’entreprise B, les proportions 0,46 et 0,54 n’appartiennent pas à l’intervalle, donc on décide que la parité n’est pas respectée (seulement 5% des échantillons aléatoires sont situés à l’extérieur de l’intervalle). D’autres exemples intéressants pourront être consultés dans [4], [5].

Bibliographie et sites du web • [1] Site de l’INSEE : http://www.insee.fr/fr/ppp/bases-de-donnees/recensement/populations-

legales/france-departements.asp

• [2] Site de l’INED : http://www.ined.fr/fichier/t_telechargement/18154/telechargement_fichier_fr_sd2006_t2_fm.xls

• [3] Site de Meteo-France : http://www.meteociel.com/climatologie/climato.php • [4] Document ressource pour la classe de seconde en probabilités et statistiques

• [5] Document ressource pour les LP en probabilités et statistiques :

http://www.ac-grenoble.fr/maths/docresseconde/Proba_stat_LP.doc

• [6] Arthur ENGEL, Les certitudes du hasard, ALEAS Editeur

• [7] J. BASS, Eléments de calcul des probabilités, MASSON ET Cie Editeurs

• [8] Gilbert SAPORTA, Probabilités, Analyse des données et Statistique, Editions TECHNIP

• [9] Jean-Paul DELAYE, Logique, informatique et paradoxes, Dossier spécial Pour la science, Edition BELIN