Chapitre 6 : la classification

Transcript of Chapitre 6 : la classification

Traitement des données, chapitre 6 : Classification

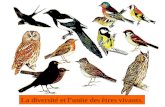

Chapitre 6 : la classification et la segmentation Pour décrire des types, il ne suffit pas de définir des critères, encore faut-il les hiérarchiser. De même que le nombre de vertèbres suffit á distinguer les oiseaux des mammifères. La condition est que les critères typologiques soient pleinement fondés. Dans le cas des entreprises, de nombreux critères d'organisation internes tendraient á les confondre. Il convient de se demander pourquoi un critère et un seul peut faire la distinction. En logique avec sa dénomination, la classification sert à définir des classes entre les variables qualitatives ou quantitatives qui caractérisent des individus, d’une part, et d’autre part à transposer cette question en classant des individus en fonction des variables qualitatives ou qualitatives qui les caractérisent. Les données peuvent se présenter sous différentes formes ; elles concernent n individus supposes affectes, pour simplifier, du même poids : i. un tableau de distances (ou mesure de dissemblance) (n × n) des individus 2 à 2 ; ii. les observations de p variables quantitatives sur ces n individus ; iii. l’observation de variables qualitatives ou d’un mélange de variables quantitatives et qualitatives. Il s’agit, d’une manière ou d’une autre, de se ramener au premier cas de la connaissance de distances 2 à 2 entre les individus. Le choix d’une matrice de produit scalaire permet de prendre en compte un ensemble de variables quantitatives. D’autres méthodes sont ensuite traditionnellement incluses dans la chaîne de traitement : ACP avec représentation des classes et de leur enveloppe convexe, pour apprécier la qualité de la classification, AFD et/ou arbre de classification afin d’aider à l’interprétation de chacune des classes de la typologie par les variables initiales, AFCM dans le cas de variables qualitatives. On suivra le plan suivant :

• 1. Buts suivis par les méthodes • 2. Présentation des bases des méthodes • 3. Classification Ascendante Hiérarchique • 4. Analyse factorielle discriminante • 5. Classification sur facteurs : les marchés du travail de l’OCDE • 6. Segmentation par régression non paramétrique d’un arbre : classement des

universités 1. Buts suivis par les méthodes La classification des individus répond à une logique économique pure. Comment regrouper des individus et considérer en fonction des variables qui les caractérisent, non plus les individus mais des classes d’individus auxquels on exprimera des actions identiques suivant les classes ou dont on attend un comportement identique suivant leurs classes d’appartenance. Par ailleurs ces méthodes doivent renseigner sur le risque du choix, c’est-à-dire l’imprécision accrue ou au contraire le gain de précision que l’on obtient en choisissant de réduire ou d’augmenter d’une classe marginale le nombre de classe.

1

Traitement des données, chapitre 6 : Classification

Dans bien des études, l'objet essentiel de l'analyse est le degré de ressemblance ou, au contraire, de dissemblance, qui existe entre les objets individus ou variables. Les indices de proximités, déjà évoqués au chapitre 4, sont des valeurs qui mesurent et résument le degré de ressemblance entre deux objets définis par un ensemble commun de variables. Ces indices, que l'on peut classer en deux grands groupes : indices de similarité (sij) et ceux de dissimilitudes (dij), se caractérisent par un certain nombre de propriétés mathématiques.

Propriété 1 : normalisation, cette condition permet de distinguer les indices de similarité de ceux

de dissimilitude. On impose au premier d'atteindre son maximum en 1 (lorsque l'objet est comparé á lui-même) et au second d'atteindre son minimum en zéro.

Propriété 2 : non-négativité : la première condition pour qu'un indice de similarité, dissimilitude soit une proximité est que cet indice soit positif ou nul. sij >= 0 ou dij >_ 0 ∀ i,j ∈ X et ∀ i ∈ X d(i, i) = 0.

Propriété 3 : Symétrie: la proximité ne dépend pas de l'ordre de présentation: ∀ i,j ∈ X dij = dji

Propriété 4 : d(i, j) <= d(i, k) + d(j, k); ∀(i, j, k) ∈ R3.

2. Présentation des bases des méthodes Jusqu’à présent l’information était synthétisée autour de variables construites en petit nombre les axes factoriels, ces derniers devant condenser le maximum d’information. Ici les classes vont être le vecteur pour synthétiser l’information ces classes devant donc être une réduction de l’information en rassemblant les individus dont la distance entre les variables de caractérisation est minimale au sein de chaque classe. 2.1 Affectation et dispersion Une classification répond dans un premier temps à l’action d’affecter un individu dans une classe de manière à ce qu’un individu appartienne à une classe et à une seule. D’un point de vue mathématique cette opération s’appelle la partition. Ainsi on appellera partition de l’ensemble I, l’objet Q(I) s’il génère des sous ensembles q1, q2,….qk non vides tels que :

1,2...i

i k

i j

q I avec qi

q q pour i j=

⎧ = ≠⎪⎨⎪ ∩ =∅ ≠⎩

∪ ∅

Si la méthode recherche à synthétiser l’information, il est nécessaire que la méthode détermine la meilleure partition entre les diverses partitions possibles de l’ensemble I. Nous sommes donc confronté à un problème de combinaison et ces questions ne sont jamais simples. Dans les chapitres antérieurs, l'inertie d'un tableau de données a été définie comme la mesure de dispersion multidimensionnelle. Ainsi si nous disposons d’un tableau de présentation classique de p variables identifiant n individus, la disposition du tableau est la suivante :

2

Traitement des données, chapitre 6 : Classification

1,1 1,2 1,

2,1

,1 ,

_ _ _

1 2

...... ... ...

... ... ... ...... ...

, , .....,

p

ij

n n

n

y y yy

y

y y

g y y y

⎡ ⎤⎢ ⎥⎢ ⎥=⎢ ⎥⎢ ⎥⎢ ⎥⎣ ⎦⎧ ⎫⎪ ⎪= ⎨ ⎬⎪ ⎪⎩ ⎭

p

Le vecteur g aura comme coordonnées les moyennes de chaque séries, aussi l’inertie peut se définir par

_2 21

1( ) 1/ ( )n

j j j j ij jij

I y n y g où y g y y=

=

= − − = −∑ ∑

2.2 Un critère de qualité d'une partition : le critère d'inertie inter-classes

On se donne une partition de l'ensemble des individus en k classes, avec évidemment k<p, par l'intermédiaire des ensembles d'indices des groupes. On note Is, ensemble d'indices du groupe s, nss son effectif , et g son barycentre ou point moyen du groupe. Ce point moyen a encore pour coordonnées les valeurs moyennes des variables dans le groupe. On définit alors :

• D’une part, l'inertie inter-groupe (ou inertie entre les groupes ou inertie « between »), mesurant l'écartement des groupes, par : 2

1

( ) /nb k ks àk

I y n n g=

= g−∑ c'est l'inertie du

nuage des barycentres des groupes. • D’autre part, l'inertie intra-groupe (ou inertie à l'intérieur , within, des groupes) par :

2

1

( ) 1/nw i ss àk i Is

I y n y g= ∈

= −∑ ∑

On a alors le résultat suivant : Inertie totale = inertie inter groupe + inertie intra groupe

Ainsi pour ce critère, chercher une partition qui maximise l'inertie inter (donc qui tend à disperser au mieux les groupes), revient à chercher une partition minimisant l'inertie intra (donc qui tend à obtenir des groupes les plus compacts).

Mais le maximum du critère est obtenu pour la partition discrète, ayant comme classes les singletons. On est donc amené à maximiser l'inertie inter pour un nombre de classes fixé a priori.

2.2 Dénombrement de l'ensemble des partitions d'un ensemble à n éléments

On note Nk,n le nombre de partitions contenant exactement k parties d'un ensemble En à n éléments, et Nn le nombre total de ces partitions. On construit l'ensemble des partitions d'un ensemble à n éléments à partir de celui obtenue pour n-1 éléments de la façon suivante.

Soit E n-1={1,2,…..n}l'ensemble à n-1 éléments et n le nom du nieme élément.

3

Traitement des données, chapitre 6 : Classification

Une partition de En:

• soit admet {n}comme singleton, • soit possède l'élément n dans une partie de plus d'un élément.

Le nombre de partitions contenant k parties du premier ensemble est exactement égal au nombre de partitions contenant k-1 parties de En-1, soit Nn-1,k-1 . Pour les partitions n'admettant pas {n}comme singleton, on passe d'une partition contenant k parties de En-1 à k différentes partitions (contenant toujours k parties) de En en ajoutant l'élément n à chacune des k parties de cette partition. Au total, on arrive à: Nn,k = Nn-1,k-1 + k Nn-1,k A l'aide d'un tableur, on obtient les résultats suivants : K / N 2 3 4 5 6 7 8 9 10 11 12

1 1 1 1 1 1 1 1 1 1 1 1

2 1 3 7 15 31 63 127 255 511 1023 2047

3 1 6 25 90 301 966 3025 9330 28501 86526

4 1 10 65 350 1701 7770 34105 145750 611501

5 1 15 140 1050 6951 42525 246730 1379400

6 1 21 266 2646 22827 179487 1323652

7 1 28 462 5880 63987 627396

8 1 36 750 11880 159027

9 1 45 1155 22275

10 1 55 1705

11 1 66

12 1

12

1j

Nj=∑

2 5 15 52 203 877 4140 21147 115975 678570 4213597

On peut remarquer que le facteur multiplicatif permettant de passer de Nn-1 à Nn est proche d'une fonction linéaire en n. Le nombre Nn augmente donc plus qu'exponentiellement en fonction de n et vaudrait environ 51013 pour n=20. Cette brève étude permet de voir qu'il ne sera pas possible, si on a défini un critère de qualité d'une partition, de passer toutes les partitions en revue pour trouver la meilleure (un ensemble d'individus contient en général de 50 à 10 000 individus). Les méthodes essaient de réduire le nombre de partitions, à comparer à chaque étape, afin de se diriger vers une partition acceptable. Les méthodes se limitent `a l’exécution d’un algorithme itératif convergeant vers une“bonne” partition qui peut correspondre `a un optimum local. même si le besoin de classer des objets est très ancien, seule la généralisation des outils informatiques en a permis l’automatisation dans les années 70 ; Celeux et alii (1989) décrivent en détail ces algorithmes. Différents choix sont laissés à l’initiative de l’utilisateur : • une mesure d’éloignement, de dissemblance ou de distance entre individus ; • le critère d’homogénéité des classes à optimiser : il est, dans le cas de variables quantitatives, généralement défini `a partir des traces des matrices de variances inter (ou inertie) ou intra de la partition ; • la méthode : la classification ascendante hiérarchique ou celle par réallocation dynamique sont les plus utilisées, seules ou combinées, • le nombre de classes ; ceci reste un point délicat et entaché de subjectif.

4

Traitement des données, chapitre 6 : Classification

2.3 Une relation d'ordre partiel , Distance entre partitions

Si Π1 et Π2 sont deux partitions sur un ensemble E, on dit que Π1 est ``plus fine que''Π2 si toute partie Ai de Π1 est contenue dans une partie Bj de Π2, ce qui s'écrit encore :

Définition 1 Π1``plus fine que'' Π2 équivalent à : pour tout Ai∈Π1, il existe Bj ∈ Π2 tel que Ai∈Bj .

Etant donné une partition Πdéfinie sur un ensemble I, on sait associer à cette partition un ``graphe'' G sur I, défini comme la partie G de I x I, (ensemble des paires de I ), telle que (i,j) ∈G si et seulement i et j appartiennent à la même classe Π1 plus fine que Π2 ⇔ G1⊂G2. On définit alors comme distance entre deux partitions Π1 et Π2 sur I, à partir de leurs graphes respectifs G1 et G2 la ``distance de la différence symétrique'' d(Π1, Π2) par: d(Π1, Π2) = gard((G1\G2)∪(G2\G1))= card (G1∆G2) où card désigne le nombre d'éléments d'un ensemble et où ∆ est l'opérateur de la différence symétrique.

3. La classification hiérarchique

L'algorithme est valable pour les objets sont des unités statistiques.

Première étape : l'algorithme calcule la matrice des distances entre les unités statistiques.

Deuxième étape : l'algorithme agrège les unités statistiques xi et xj, avec i≠j, telles que dij<=dkk’ où k=1….n et k’=1…n mais k≠k’. Troisième étape : l'algorithme remplace les unités statistiques xi et xj par leur centre de

gravité, puis il recalcule la matrice des distances entre les unités statistiques.

On reprend ensuite à l'étape deux et on réitère le processus jusqu'à ce que l'on obtienne une seule classe.

Les méthodes de classification hiérarchique fournissent plus d'informations que les méthodes de partitionnement, puisqu'une hiérarchie induit plusieurs partitions, mais ils sont toutefois plus longs et plus difficiles à interpréter.

Dans notre cas, l'intérêt de ce type de méthodes consisterait à nous donner quelques indications nous permettant de répondre à la question: ``quel nombre de classes choisir ?''. Ainsi que nous l'avons précisé dans les deux méthodes présentées précédemment, le nombre de classes doit être fixé au préalable. Mais sur quels critères se baser pour le fixer ?

Il existe deux sortes d'algorithmes de classification hiérarchique :

• les premiers fournissent une série de partitions de plus en plus fines et sont appelés algorithmes de classification hiérarchique descendante ;

• les seconds fournissent une série de partitions de moins en moins fines et sont appelés algorithmes de classification hiérarchique ascendante.

5

Traitement des données, chapitre 6 : Classification

Compte tenu des préoccupations dominantes en économie cette seconde voie est beaucoup plus courante d’approche ; d’ailleurs d’après Saporta les méthodes descendantes ne sont pratiquement jamais utilisées..

Le résultat des cette méthode est fortement dépendant du choix initial de noyaux et de la distance. L’algorithme s’arrête avec l’obtention d’une seule classe. Les regroupements successifs sont représentés sous la forme d’un arbre binaire ou dendogramme. D’autres méthodes dérivent de cette logique :

• Classification non-hiérarchique ou partitionnement • Méthodes mixtes • Méthodes basées sur le modèle de mélange de Gaussiens • Classification « floues » • cartes (SOM) de Kohonen • Méthodes basées sur la théorie des graphes • Algorithme kmeans : Il s’agit d’une modification de l’algorithme précédent par Mac Queen

(1967). Les barycentres des 2 classes concernées, sont recalculés à chaque allocation d’un individu à une classe. L’algorithme est ainsi plus efficace mais dépend de l’ordre des individus dans le fichier.

• Nuées dynamiques : La variante proposée par Diday (1971) consiste à remplacer chaque centre de classe par un noyau constitué d’éléments représentatifs de cette classe ; ce qui permet de corriger l’influence d’éventuelles valeurs extrêmes sur le calcul du barycentre.

3.1 La classification hiérarchique ascendante

La classification hiérarchique ascendante (CAH) consiste à agréger progressivement les individus selon leur ressemblance, mesurée à l'aide d'un indice de similarité ou de dissimilitude. Elle nécessite la définition d’une mesure de similarité ou de distance entre les objets à classifier, échantillons; et d’un critère d’agrégation des classes qui peut être défini comme une mesure de similarité ou de distance entre les classes d’objets Elle produit une suite de partitions emboîtées de l’ensemble d’objets à classifier. Au départ, on a une partition en n classes, chaque classe étant composée d’un seul objet (partition la plus fine).L'algorithme commence par rassembler les couples d'individus les plus ressemblants, puis à agréger progressivement les autres individus ou groupes d'individus en fonction de leur ressemblance, jusqu'à ce que la totalité des individus ne forme plus qu'un seul groupe. L’initialisation de cet algorithme consiste, s’il n’est déjà donné en préalable, à calculer un tableau de distances entre les individus à classer. L’algorithme débute alors de la partition triviale des n singletons (un individu est une classe) et cherche, à chaque étape, à constituer des classes par agrégation des 2 éléments les plus proches de la partition de l’étape précédente. La CAH produit un arbre binaire de classification (dendrogramme), dont la racine correspond à la classe regroupant l'ensemble des individus. L’ensemble des noeuds définit une «hiérarchie» sur l’ensemble d’objets. Le nombre de classes obtenues dépend du niveau de l’arbre choisi pour la coupe, ceci est un choix final de l’analyste. Il existe des indices de niveau, voir 3.2.2 pour évaluer la qualité d’une partition. Ce dendrogramme représente une hiérarchie de partitions, une partition étant obtenue pas troncature du dendrogramme à un certain niveau de ressemblance. La partition comporte alors d'autant moins de classes que la troncature s'effectue en haut du dendrogrammme (c'est-à-dire vers la racine). À la limite, une troncature effectuée en dessous du premier nœud de l'arbre conduit à ce que chaque classe ne contienne qu'un individu (cette

6

Traitement des données, chapitre 6 : Classification

partition est l'assise du dendrogramme), et une troncature effectuée au-delà du niveau de la racine du dendrogramme conduit à une seule classe contenant tous les individus. 3.2 Techniques de mesures Il existe de nombreuses mesures de ressemblances (similarités ou dissimilitudes), et plusieurs méthodes pour recalculer la ressemblance lorsque l'algorithme forme des groupes (critères d'agrégations). Les divers logiciels proposent des indices et des critères sélectionnés en fonction de leurs propriétés mathématiques et de leur intérêt pratique ou pédagogique. 3.2.1 Corrélations et similitudes Corrélation de Pearson : covariance des deux lignes ou des deux colonnes comparées, standardisées par les écarts types, ou ce qui revient au même, covariance calculée sur les données centrées-réduites. Résultat dans l'intervalle [-1,+1]. Corrélation de Spearman : coefficient de corrélation non paramétrique strictement équivalent au coefficient de corrélation de Pearson calculé sur les rangs des valeurs. Résultat dans l'intervalle ρ= [-1,+1]. Corrélation de Kendall : coefficient de corrélation non paramétrique, c'est-à-dire calculé sur les rangs des valeurs. Résultat dans l'intervalle [-1,+1]. Remarque : Les coefficients de corrélation ont été créés avec l'intention de mesurer la ressemblance entre variables. Pour évaluer la ressemblance entre individus, ils devraient être employés avec circonspection. Distance euclidienne : métrique de l'espace euclidien (espace de la géométrie classique). La distance euclidienne vaut 0 pour deux lignes ou deux colonnes identiques, mais elle ne possède pas de borne supérieure. La distance euclidienne augmente à mesure que s'accroisse le nombre de variables, et sa valeur dépend également de l'échelle de chacune des variables de sorte qu'en changeant simplement leur échelle, on peut obtenir des résultats très différents. Ce problème peut être évité en standardisant les variables. Distance du χ² : Pour pallier les inconvénients liés à l'utilisation de la distance euclidienne, il est possible d'utiliser la distance du χ² qui fait intervenir à la fois les sommes des colonnes et des lignes du tableau de données. Dans le cas du calcul de la distance du χ² entre deux lignes par exemple, les termes de chaque ligne sont rapportés à leur somme et une colonne contribue à la distance en raison inverse de son poids. Le calcul de la distance du χ² revient à calculer la distance euclidienne sur des données transformées comme ceci a été évoqué au chapitre 4. La distance du χ² satisfait au principe d'équivalence de distribution c'est-à-dire que la distance ne change pas entre les lignes ou entre les colonnes en remplaçant deux colonnes ou deux lignes de même profil par leur somme. La distance du χ², comme ceci a été évoqué au chapitre 4, est particulièrement adaptée aux tableaux homogènes d'effectifs ou de grandeurs additives (ex. populations, tonnes, …) . Distance de Manhattan : métrique calculée sur la base des écarts absolus au lieu des écarts quadratiques comme dans le cas de la distance euclidienne.

7

Traitement des données, chapitre 6 : Classification

Dissimilitude de Pearson : transformation de la corrélation de Pearson en une dissimilitude variant dans l'intervalle [0,1], soit r -> (1 - r) / 2. Dissimilitude de Spearman : transformation de la corrélation de Spearman en une dissimilitude variant dans l'intervalle [0,1], soit rS -> (1 – rS) / 2. Dissimilitude de Kendall : transformation de la corrélation de Spearman en une dissimilitude variant dans l'intervalle [0,1], soit ρ> (1 – ρ) / 2. 3.2.2 Cas des données binaires Si i et j sont deux entrées dans le tableau (deux lignes ou deux colonnes), notons a le nombre de 1 communs à i et j, b le nombre pour 1 de i qui correspondent à des 0 pour j, c le nombre de 1 pour j qui correspondent à des 0 pour i et d le nombre de 0 communs à i et j. Les indices pour données binaires sont définis à partir de a, b et c, et éventuellement de d. Notez que les données a, b, c et d sont simplement les effectifs du tableau de contingence 2 × 2 suivant : i / j 1 0 1 A B a + b 0 C D c + d a + c B + d n = a + b + c + d Les indices de niveau Les indices sont présentés sous la forme de similarités S, mais peuvent s'exprimer très facilement sous la forme de dissimilitudes D en calculant D = 1 – S lorsque S varie dans l'intervalle [0,1], et en calculant D = (1 – S)/2 lorsque S varie dans l'intervalle [-1,+1]. Indice de Jaccard : a / (a + b + c). Résultat dans l'intervalle [0,1]. Donne un poids égal aux différents termes, et ne prend pas en considération les doubles nuls -0 (terme d). Indice de Dice : 2a / (2a + b + c), où a est divisé par la moyenne arithmétique des nombres de 1 pour i et j. Résultat dans l'intervalle [0,1]. Construit selon le modèle de l'indice de Jaccard, cet indice donne un poids deux fois plus élevé aux doubles-1 (terme a). Indice de Sokal & Sneath : a / (a + 2b +2c). Résultat dans l'intervalle [0,1]. Construit selon le modèle de l'indice de Jaccard, cet indice donne un poids deux fois plus élevé aux différences figurant au dénominateur (termes b et c). Les indices de Jaccard, Dice et Sokal & Sneath donnent la même ordonnance, c'est-à-dire les mêmes relations d'ordre entre les individus. En conséquence, dans une classification ascendante hiérarchique on obtient des dendrogrammes qui ont la même structure (ou topologie identique). Indice de Sokal & Michener : (a + d) / (a + b + c + d). Résultat dans l'intervalle [0,1]. En employant cet indice, on part du principe que les doubles-1 (terme a) et les doubles-0 (terme d) jouent un rôle symétrique, ce qui implique que les deux modalités de la variable peuvent être indifféremment codées 1 ou 0.

8

Traitement des données, chapitre 6 : Classification

Indice de Rogers & Tanimoto : (a + d) / (a + 2b + 2c + d). Résultat dans l'intervalle [0,1]. Construit selon le modèle de l'indice de Sokal & Michener, cet indice donne aux différences (termes b et c) un poids deux fois plus important qu'aux concordances (termes a et d). Indice de Sokal & Sneath : (2a + 2d) / (2a + b + c + 2d). Résultat dans l'intervalle [0,1]. Construit selon le modèle de l'indice de Sokal & Michener, cet indice donne aux concordances (termes a et d) un poids deux fois plus important qu'aux différences (termes b et c). Les indices de Sokal & Michener, Rogers & Tanimoto et Sokal & Sneath donnent la même ordonnance. En conséquence, là aussi dans une classification ascendante hiérarchique on obtient des dendrogrammes qui ont la même topologie. 3.2.3 Liste des critères d'agrégation. La dissimilitude entre deux groupes d'objets A et B peut être calculée selon différentes méthodes nommées critères d'agrégation, chaque critère conditionnant la structure de la hiérarchie binaire produite par l'algorithme de CAH. Parmi les critères existants on peut évoquer : Lien simple : la dissimilitude entre A et B est la dissimilitude entre l'objet de A et l'objet de B les plus ressemblants. L'agrégation par le lien simple a tendance à contracter l'espace des données et à écraser les niveaux des paliers du dendrogramme. Comme la dissimilitude entre deux éléments de A et de B suffit à relier A et B, ce critère peut conduire à relier des classes très allongées (effet de chaînage). Lien complet : la dissimilitude entre A et B est la plus grande dissimilitude entre un objet de A et un objet de B. L'agrégation par le lien complet a tendance à dilater l'espace des données et produit des classes compactes. Lien moyen : la dissimilitude entre A et B est la moyenne des dis similarités entre les objets de A et les objets de B. L'agrégation selon le lien moyen constitue un bon compromis entre les deux extrêmes précédents et respecte assez bien les propriétés de l'espace des données. Lien proportionnel : la dissimilitude moyenne entre les objets de A et de B est calculée comme une somme de dissimilitudes pondérée de telle sorte qu'un poids égal soit attribué aux deux groupes. Comme le lien moyen, ce critère respecte assez bien les propriétés de l'espace des données. Lien flexible : ce critère fait intervenir un paramètre â variant dans l'intervalle [-1,+1[ qui permet de générer une famille de critères d'agrégation. Pour â = 0 on retrouve le lien proportionnel. Quand â est proche de 1, on obtient un fort effet de chaînage, mais à mesure que â décroît et devient négatif, on obtient une dilatation de plus en plus forte. Lien fort : ce critère fait intervenir à la fois la moyenne des distances à l'intérieur de chaque groupe et la moyenne des distances entre les groupes. Son utilisation conduit à la formation de classes très compactes. Augmentation de l'inertie (Ward) : on agrège deux groupes de sorte que l'augmentation de l'inertie intra classe soit la plus petite possible, afin que les classes restent homogènes. Ce critère, proposé notamment par Ward (1963), ne peut s'utiliser que dans le cas des distances quadratiques, c'est-à-dire ici, dans le cas de la distance euclidienne et de la distance du khi².

9

Traitement des données, chapitre 6 : Classification

4. Analyse factorielle discriminante Une première méthode de classification consiste dans l’analyse factorielle discriminante. On aborde successivement deux points : la présentation à partir de la combinaison des distances de classes. L'analyse factorielle discriminante (AFD) est une méthode permettant de modéliser l'appartenance à un groupe d'individus en fonction des valeurs prises par plusieurs variables, puis de déterminer le groupe le plus probable pour un individu, connaissant uniquement les valeurs des variables qui le caractérisent. De manière générale, les variables qui décrivent les individus sont forcément des variables quantitatives, les groupes étant spécifiés par une variable qualitative. L'AFD peut être considérée comme une extension de la régression multiple dans le cas où la variable à expliquer est une variable qualitative décrivant des groupes. L'analyse discriminante couvre deux aspects : le premier aspect, descriptif et explicatif, consiste à déterminer les caractères discriminants d'une population répartie en groupes, le second est décisionnel et aide à affecter un nouvel individu à un groupe. Des techniques alternatives, comme la construction d’arbres de décision (méthodes de segmentation), répondent également à des objectifs décisionnels. Une des techniques de "scoring" essaye de déterminer la contribution des variables qui expliquent l'appartenance des individus à des groupes. Deux ou plusieurs groupes sont comparés, sur plusieurs variables pour déterminer s'ils différent et pour comprendre la nature de ces différences.

Une population, est ici divisée en k classes au moyen d’un critère qualitatif Y. Un ensemble de p variables décrit les i individus, i s’agit donc de relier la liaison entre le critère Y et les p variables1. Le but est ici de signaler les différences entre l’appartenance à une classe au niveau des variables. L’analyse discriminante bayésienne permettra d’obtenir une règle de décision lorsque l’on dispose de règle d’appartenance a priori sur les k classes et que les p variables sont-elle mêmes définies par des lois normales.

On observe sur un ensemble individus ou population P les variables Y, X1 à Xp. La variable Y possède k modalités qui permettent de classer la population P en k sous populations P1 à Pk d’effectifs n1 à nk.

On note xjhi, la valeur de Xj pour l’individu i de la classe h, dans ce cas _

jkx sera la moyenne

de la variable Xj sur le groupe et _

jx la moyenne pour la m^me variable sur l’ensemble analysé. Dans ce cas la relation Inertie totale = inertie inter groupe + inertie intra groupe peut s’écrire comme une décomposition de variance :

2 2_ _ _2

1 1 11 1

( ) ( ) (k k kj jhi jjhi h jhih h h

i ành i ànhx x n x x x x

= = == =

− = − + −∑ ∑ ∑ ∑ ∑_

)jh

1 On reste à l’évidence ici dans une logique d’analyse exploratoire, sans modèle ex ante. Dans ce dernier cas les modélisations de type logistique ou à choix discrets seront plus appropriées.

10

Traitement des données, chapitre 6 : Classification

Le pouvoir discriminant de la variable Xj vient alors de la part de la variance intra classes que la variable permet d’identifier, ce qui s’exprime comme un rapport de corrélations :

2 Somme des carrés inter classes( , )Somme des carrés totauxjX Yη = ou en terme de F, carrés moyens :

Somme des carrés inter classes/(k-1)( , )Somme des carrés totaux/(n-k)jF X Y = ainsi suivant les critères usuels de mise en

œuvre du test du F on peut évaluer les variables effectivement discriminantes.

L’analyse discriminante va donc travailler à partir de la notion de corrélation totale et de sa décomposition entre la corrélation intra classes, conditionnée par rapport à la variable qualitative, et la corrélation inter classes où les données sont ramenées aux centres de gravité des classes pondérés par les fréquences. La corrélation intra classes revient à établir une corrélation partielle entre deux variables X1 et X2 conditionnellement à la variable, ce qui revient à étudier les modèles de régression suivants : X1=β10+ β11Y1+… +β1(k-1)Y1(k-1)+ε1

X2=β20+ β21Y1+… +β2(k-1)Y1(k-1)+ε2

Où Y1….Yk-1 sont les variables indicatrices des k-1 premières modalités de Y. La corrélation partielle COR(X1,X2/Y) représente la corrélation entre les résidus des modèles ci-dessus calculés sur l’échantillon concerné. Ces résidus s’expriment pour la ième observation du groupe h par

_

1 1 1_

2 2 2

hi hi h

hi hi h

x x et

x x

ε

ε

= −

= −

La corrélation intra classes équivaut donc à

_ _

1 1 2 21 11/ 2

_ _2 2

1 1 2 21 1 1 1

( )( )COR(X1,X2/Y)=

( ) ( )

k nhhi h hi hh i

k nh k nhhi h hi hh i h i

x x x x

x x x x

= =

= = = =

− −

⎛ ⎞− −⎜ ⎟⎜ ⎟

⎝ ⎠

∑ ∑

∑ ∑ ∑ ∑

Cette corrélation est calculée sur les données de classes centrées sur les moyennes des classes et non sur les moyennes générales. La corrélation inter classes est calculée, à partir de k points représentant les classes, sur les centres de gravité des classes pondérées par leur fréquences :

_ _

1 1 2 211/ 2_ _

2 21 1 2 21 1

( )( )CORinter(X1,X2)=

( ) ( )

kh hi hih

k nhh hi h h hi hh i

n x x x x

n x x n x x

=

= =

− −

⎛ ⎞− −⎜ ⎟

⎝ ⎠

∑

∑ ∑

La structure de segmentation en classes des données n’intervient pas sur la corrélation totale. La corrélation intra classes en tient compte et équivalent à une corrélation pondérée par la taille des classes des corrélations internes entre les individus de la classe. La corrélation inter classes ne prend plus en compte les classes qu’à travers leur centre de gravité

11

Traitement des données, chapitre 6 : Classification

Remarque : les calculs de l'AFD ne peuvent pas s'exécuter si les variables explicatives sont linéairement dépendantes (multi colinéarité). En conséquence, aucune variable ne doit pouvoir être déduite des autres par une relation linéaire. Par exemple, dans un jeu de variables explicatives correspondant aux pourcentages de votes exprimés pour un ensemble de candidats, il convient de ne pas inclure parmi les variables explicatives le pourcentage de votes non exprimés puisque cette variable se déduit linéairement de toutes les autres (100 % moins la somme des pourcentages de votes exprimés). Le problème de la multi colinéarité peut se détecter en calculant la matrice de corrélation entre les variables et en vérifiant qu'il n'y a pas de couples de variables fortement corrélées.

Cette méthode recherche des variables Z telles que :

~2

1 11

~2

2 21

1 tel que Max ( , ) et

2 tel que Max ( , )

p

jjj

p

jjj

Z a X Z Y

Z a X Z Y

η

η

=

=

=

=

∑

∑

Où X tilde traduit des données centrées réduites. Ces variables zm sont limitées en nombre par le nombre de groupes moins un.

En règle générale les logiciels fournissent des variables discriminantes des variances intra classes égales à l’unité du style :

_2

1 1

1 ( )k nh

mhmhih i

z zn k = =

− =− ∑∑ 1

Les corrélations intra classes entre les Zm sont également nulles. On considère un vecteur µh représentant les moyennes des variables X1 à Xp dans la classe h de la population, la densité de probabilité de X sur l’échantillon h est ainsi

1( 1/ 2( ) ( )1/ 2/ 2

1( ) exp2

x h x hh p

f x µ µ

π

−− − Ξ −=Ξ

')

avec Ξ représentant la matrice de variances covariances des X. Les variables discriminantes à prendre en compte peuvent être choisies à l’aide d’un test sur l’apport nul des corrélations à partir de la statistique :

12(1 )

k

mm k q

q η−

= =

Λ = −∏

L’hypothèse est rejetée si, à niveau q donné, les valeurs de Λ sont trop faibles. De manière générale ceci se réalise en appliquant les transformations de Rao ou Barlett, ramenant respectivement la règle de décision à un test du F ou du χ2. De manière pratique pour un niveau de classe k on mesure le pouvoir discriminant d’une variable à l’aide du Lambda de Wilks qui mesure, à mesure où il prend de petites valeurs, le pouvoir discriminant de p variables :

12

11

(1 )k

k mm

η−

−=

Λ = Λ = −∏

12

Traitement des données, chapitre 6 : Classification

4.2 Vision géométrique de l’AFD Une manière commode d'aborder l'analyse discriminante est d'examiner un modèle géométrique simple. On prend deux groupes de sujets (par exemple des médecins généralistes) mesurés sur deux variables X,Y. Le nombre de consultation pour une pathologie donnée sera notée par X et le nombre d’envoi vers un spécialiste sera noté Y. Les individus sont représentées dans la figure 1. Les deux critères sont les variables par lesquelles on veut distinguer les groupes.

En analysant le graphique on se rend compte que sur chacun des axes représentés par les deux variables il y a une région importante d'incertitude, dans laquelle pour les mêmes valeurs des variables on trouve des individus appartenant aux deux groupes. Le but de l'analyse discriminante est de trouver un nouvel axe, combinaison linéaire des variables, qui permet de réduire cette zone d'incertitude et de séparer au mieux les deux groupes. Imaginons, d'une manière plus générale, que ces variables X soient centrées pour l'ensemble des deux groupes. On illustre dans un espace à deux dimensions les coordonnées de chaque sujet sur les variables en question et on trace les lignes contours de 95 % (1,96 σ) Ou 68 % (1 écart type). Les hypothèses de normalité des variables conjointes et d'homogénéité des variances et covariances sont maintenues2. La figure suivante en est un exemple.

13

Traitement des données, chapitre 6 : Classification

On choisit s'il faut considérer les moyennes, ou centroides, de chaque population comme distinctes : L'analyse de variance multiple est un instrument bien indiqué pour cette tâche. Il apparaît ensuite intéressant, connaissant les scores d'un éventuel sujet sur les deux variables, de déterminer, à l'intérieur d'un pourcentage d'erreur, l'appartenance de ce sujet à l'une ou l'autre de ces populations. Si l'on se base, pour une telle attribution d'appartenance, sur la connaissance du seul score X, on voit que l'incertitude de la décision va de a à b et touche les sujets situés dans la région hachurée de la figure

Si cette décision est prise en tenant compte des deux variables, on constate que la région sûre correspond alors à la surface hachurée suivante (intersection).

14

Traitement des données, chapitre 6 : Classification

5. Classification sur facteurs : Comparaison des marchés du travail dans la zone OCDE Ici vous est proposée une comparaison entre les indicateurs concernant les pays de l’OCDE Ces données sont assez délicates à manier et l’on profite d’un récent rapport qui a publié des données normalisées pour les pays de l’OCDE : L. Osberg et A. Sharpe, « An Index of Labour Market Well-being for OECD Countries”, September 2003, CSLS (Centre for the Study of Living Standards), Research Report 2003-05 Ce rapport et les données peuvent être obtenus (format pdf), sur la page consacrée aux rapports du CSLS : http://www.csls.ca/res_reports.asp Dans l’analyse présente, nous ne retenons que 5 indicateurs synthétiques , sur la période 1980-2001 pour les pays avec une prise en compte des extrêmes de période. Six indicateurs sur le marché du travail sont sélectionnés, ces indicateurs indiqueraient une situation d’autant plus intéressante s’il sont élevés : HK l’accès à la formation (HK90 observé en 1981, HK20 observé en 2000) EQ la dimension inégalitaire ou égalitaire des salaires, plus cet indicateur est élevé plus l’éventail des salaires est resserré ; SE sécurité de l’emploi, un coefficient plus élevé indique une probabilité de turnover faible ; RC Sécurité face au chômage, en particulier le chômage de longue durée, RS Protection face aux périls de santé dans le travail (couverture maladie, prévention des accidents….) RP Qualité des systèmes de retraite et de pension ;

Capital humain Egalité

Sécurité emploi

Sécurité faceChômage

Protection santé

Retraite pension

pays HK90 HK20 EQ90 EQ20 SE90 SE20 RC90 RC20 RS90 RS20 RP90 RP20Australia 0,785 0,883 0,721 0,704 0,338 0,3 0,059 0,057 0,762 0,799 0,193 0,045Belgium 0,391 0,603 0,377 0,401 0,377 0,401 0,197 0,142 0,405 0,564 0,528 0,496Canada 0,749 0,902 0,284 0,463 0,284 0,463 0,046 0,051 0,648 0,697 0,159 0,641Denmark 0,672 0,737 0,454 0,375 0,454 0,375 0,217 0,195 0,796 0,819 0,348 0,111Finland 0,466 0,724 0,453 0,554 0,453 0,554 0,143 0,141 0,685 0,754 0,532 0,767France 0,455 0,618 0,381 0,502 0,381 0,502 0,168 0,185 0,51 0,604 0,465 0,719Germany 0,733 0,902 0,373 0,371 0,373 0,371 0,245 0,129 0,524 0,625 0,351 0,358Italy 0,083 0,392 0,262 0,373 0,262 0,373 0,048 0,088 0,37 0,61 0,37 0,42Japan 0,528 0,754 0,468 0,488 0,468 0,488 0,087 0,092 0,849 0,884 0,32 0,34Netherlands 0,458 0,724 0,418 0,47 0,418 0,47 0,306 0,27 0,875 0,889 0,073 0,251New Zealand 0,68 0,789 0,348 0,449 0,348 0,449 0,089 0,08 0,607 0,819 0,27 0,3Norway 0,547 0,748 0,443 0,57 0,443 0,57 0,222 0,279 0,801 0,836 0,305 0,596Sweden 0,422 0,706 0,607 0,566 0,607 0,566 0,258 0,141 0,845 0,876 0,718 0,681Switzerland 0,684 0,839 0,337 0,43 0,337 0,43 0,054 0,107 0,621 0,752 0,24 0,27UK 0,444 0,652 0,471 0,493 0,471 0,493 0,035 0,029 0,889 0,908 0,49 0,54US 0,751 0,917 0,177 0,26 0,177 0,26 0,014 0,016 0,433 0,596 0,084 0,169 La chaîne de traitement sous SPAD correspond à la suite suivante :

15

Traitement des données, chapitre 6 : Classification

On débute par une ACP (CORPRI), puis la procédure DEFAC d’aide à la description des axes factoriels. Dans un second temps vient la classification proprement dite.

On débute par une analyse factorielle, ici l’on retiendra les 3 premiers axes et l’on demandera le graphe pour les axes 1 & 2 ainsi que pour les axes 1 & 3.

Le programme de description des axes demande la référence des trois premiers axes. Ici l’on

conserve les options par défaut du programme (utilisation des seules variables actives). Le programme RECIP/Semis choisit la classification hiérarchique et retient aussi les options

par défaut en particulier pour le dessin de l’arbre hiérarchique. Le programme Parti-Décla de partition de l’arbre travaille avec les choix par défaut du

programme c’est-à-dire au moins 3 classes de partitionnement et au plus 10 classes.

Numéro Valeur propre

Pourcentage Pourcentage cumulé

1 4,897 40,808 40,8082 2,952 24,600 65,4083 1,485 12,378 77,7864 1,021 8,512 86,2985 0,841 7,008 93,3056 0,611 5,096 98,4017 0,101 0,846 99,247

16

Traitement des données, chapitre 6 : Classification

Caractérisation par les variables continues des classes de la partition Coupure 'a' de l'arbre en 3 classes CLASSE 1 / 3 (Poids = 6,00 Effectif = 6 ) Variable Moyenne

dans la classe

Moyenne générale

Ecart-type dans la classe

Ecart-type général

Valeur-Test

Probabilité

HK90 0,730 0,553 0,038 0,179 2,967 0,002 HK20 0,872 0,743 0,045 0,132 2,919 0,002 SE90 0,310 0,387 0,065 0,097 -2,383 0,009 CLASSE 2 / 3 (Poids = 3,00 Effectif = 3 ) HK90 0,310 0,553 0,162 0,179 -2,525 0,006 RS20 0,593 0,752 0,020 0,116 -2,557 0,005 RS90 0,428 0,664 0,059 0,170 -2,572 0,005 HK20 0,538 0,743 0,103 0,132 -2,886 0,002 CLASSE 3 / 3 (Poids = 7,00 Effectif = 7 ) RS90 0,820 0,664 0,064 0,170 3,134 0,001 SE90 0,473 0,387 0,057 0,097 3,031 0,001 RS20 0,852 0,752 0,049 0,116 2,955 0,002 SE20 0,502 0,442 0,064 0,088 2,363 0,009

Description de l'axe 1 Par les VARIABLES CONTINUES ACTIVES Libellé de la variable Coordonnée Poids Moyenne Ecart-type SE90 -0,944 16,000 0,387 0,097SE20 -0,824 16,000 0,442 0,088RS90 -0,716 16,000 0,664 0,170Z O N E C E N T R A L E HK20 0,281 16,000 0,743 0,132HK90 0,340 16,000 0,553 0,179Description de l'axe 2 Par les VARIABLES CONTINUES ACTIVES Libellé de la variable Coordonnée Poids Moyenne Ecart-type HK90 -0,797 16,000 0,553 0,179HK20 -0,789 16,000 0,743 0,132RS90 -0,596 16,000 0,664 0,170Z O N E C E N T R A L E SE20 0,220 16,000 0,442 0,088RP90 0,525 16,000 0,340 0,170RP20 0,590 16,000 0,419 0,217Description de l'axe 3 Par les VARIABLES CONTINUES ACTIVES Libellé de la variable Coordonnée Poids Moyenne Ecart-type EQ20 -0,343 16,000 0,467 0,101RP90 -0,304 16,000 0,340 0,170RP20 -0,227 16,000 0,419 0,217Z O N E C E N T R A L E HK20 0,097 16,000 0,743 0,132RC90 0,743 16,000 0,137 0,091RC20 0,769 16,000 0,125 0,075

17

Traitement des données, chapitre 6 : Classification

On note dans le premier plan la relative autonomie des Etats-Unis et de l’Australie.

18

Traitement des données, chapitre 6 : Classification

L’arbre des classifications est le suivant

Classification hierarchique directe

Australia

Germany

New Zealand

Switzerland

Canada

US

France

Belgium

Italy

Denmark

Netherlands

Japan

UK

Norway

Finland

Sweden

0%

0%

0%

0%

0%

0%

0%

0%

8

0%

0%

0%

0%

0%

0%

0%

0%

0%

0%

10

0%

0%

0%

0%

0%

5

0%

0%

0%

3

0%

0%

2

0%

0%

0%

3

19

Traitement des données, chapitre 6 : Classification

20

Traitement des données, chapitre 6 : Classification

Libellé de la variable

Moyenne Ecart-type Minimum Maximum

HK90 0,553 0,179 0,083 0,785HK20 0,743 0,132 0,392 0,917EQ90 0,411 0,126 0,177 0,721EQ20 0,467 0,101 0,260 0,704SE90 0,387 0,097 0,177 0,607SE20 0,442 0,088 0,260 0,570RC90 0,137 0,091 0,014 0,306RC20 0,125 0,075 0,016 0,279RS90 0,664 0,170 0,370 0,889RS20 0,752 0,116 0,564 0,908RP90 0,340 0,170 0,073 0,718RP20 0,419 0,217 0,045 0,767

21

Traitement des données, chapitre 6 : Classification

6. Segmentation par régression non paramétrique d’un arbre Cette procédure, mise en œuvre ici sous Spad, effectue la construction d'un arbre de décision binaire complet pour la régression non-paramétrique d'une variable à expliquer quantitative (variable réponse) sur un ensemble de variables explicatives qui peuvent être de nature quelconque : continues, ordinales ou nominales. La méthode fournit, à partir de l'arbre binaire complet, la séquence des sous-arbres obtenue en utilisant une procédure d'élagage basée sur la suppression successive des branches les moins informatives en termes d'explication de la variable réponse Y. Dans cette séquence d'élagage, elle sélectionne un sous-arbre "optimal" à l'aide de l’échantillon de base (en se basant sur l'estimation de la variance résiduelle des différents segments terminaux). L'idée fondamentale est de sélectionner chaque division d'un sous-ensemble (ou segment) de telle sorte que la variance de la variable à expliquer Y dans les segments descendants soit plus faible que la variance de Y dans le segment parent. Plus précisément, pour toute division d'un segment, on calcule la moyenne pondérée de la variance de Y dans ses segments descendants (variance intra). La meilleure division est, parmi toutes les divisions possibles à l'aide des variables explicatives, celle qui minimise cette variance intra. On retient ainsi la division qui conduit à deux segments descendants aussi homogènes que possible en Y. Un problème de régression multiple se pose quand on est en présence d'un tableau de données contenant une variable privilégiée (variable réponse), Y continue à expliquer par les autres variables du tableau X1, X2 ... Xp dites variables explicatives. Il s'agit alors d'une part, de sélectionner parmi ces variables celles qui expliquent significativement le phénomène Y, et d'autre part, de construire une règle de prédiction de la valeur de Y pour un nouvel individu. Dans le cas présenté nous prenons le classement des universités françaises établies par le « Nouvel observateur » en mars 2003. Cet indicateur continu Y le rang de classement, est mis en relation avec les variables explicatives X suivantes, observées pour les 68 universités hiérarchisées dans le classement : Mnémonique Intitulé D2A % obtenant le DEUG en 2 ans en 2000 D3A % obtenant le DEUG en 3 ans en 2000 D5A % obtenant le DEUG en 5 ans en 2000 EMPREG Emploi dans la région EVOL99 Evolution du nb d'étudiants en 98/99 FCTETUD Dotation de fonctionnement en frs par étudiant 2000INVETUD Dotation équipement en frs par étudiant 2000 PARTMED Part des études médicales (% des étudiants) PARTSCI Part des études scientifiques (% des étudiants) PIBDT Richesse départementale par habitant (F / habitant)POP99 Population du département implantation U. PREMCYCL Etudiants en 1er cycle en 2000 PREMINSC premières inscriptions en 2001 TAILLE nb etudiants TOTAL total inscriptions Sous SPAD, la filière d’études va demander la mise en oeuvre de 2 méthodes :

a) la régression par arbre binaire, b) l’élagage de l’arbre

22

Traitement des données, chapitre 6 : Classification

23

Traitement des données, chapitre 6 : Classification

Après avoir retenu la variable explicative (CLASS) on retient les continues exogènes du modèle. Puis dans la fenêtre paramètre on précise les sorties graphiques de l’arbre.

24

Traitement des données, chapitre 6 : Classification

Bilan des données manquantes pour les variables continues Nombre d'individus actifs abandonnés: 0 Nombre d'individus actifs conservés: 68

Libellé de la variable Nombre de données manquantes

CLASS 0 D5A 0 D2A 0 TAILLE 0 EVOL99 0 FCTETUD 0 INVETUD 0 PARTMED 0 PARTSCI 0 PIBDT 0

25

Traitement des données, chapitre 6 : Classification

REGRESSION NON-PARAMETRIQUE: ARBRE DE DECISION BINAIRE PARAMETRES DE LA SEGMENTATION, LA VARIABLE A EXPLIQUER EST : CLASS, ECHANTILLON TEST TIRE AU HASARD, PTEST = 33.00%, FREQUENCES DES ECHANTILLONS, MOY = MOYENNE DE LA VARIABLE A EXPLIQUER EC = ECART-TYPE DE LA VARIABLE A EXPLIQUER -------------+-----------+------------+------------+ ECHANTILLON | EFFECTIF | MOY | EC | -------------+-----------+------------+------------+ BASE | 35 | 34.7714 | 19.7022 | TEST | 33 | 32.9697 | 18.5562 | -------------+-----------+------------+------------+ L'échantillon-test (33 obs. de l'échantillon total) est tiré au hasard, le complément (35) sera la base. On a ici les moyennes et écarts-type de la variable "classement" (variable à expliquer) à la racine de l'arbre, dans l'échantillon de base et dans l'échantillon-test. Si l'arbre complet (arbre avant élagage) présente un nombre de niveaux inférieur ou égal à 13, il est dessiné. Par contre la description de l'arbre complet sous forme de tableau est fournie quel que soit le nombre de niveaux. ARBRE COMPLET (A1) ---------------------------------------------------------------------------------------------------------------------------------- 1. T : NUMERO DU SEGMENT 2. N(T) : NOMBRE D'INDIVIDUS CONTENUS DANS T 3. M(T) : MOYENNE PREDITE DANS LE SEGMENT T 4. S2(Y/T) : ERREUR DE PREDICTION DANS LE SEGMENT T ---------------------------------------------------------------------------------------------------------------------------------- T N(T) M(T) S2(Y/T) SEGM. COUPURE 32 4 61.50 5.25 . . . . . . . . . . . 32---+ | 16---+ 16 VAR 2 <= 76.500 | | 33 2 66.50 0.25 . . . . . . . . . . . 33---+ | | 8---+ 8 VAR 5 <= 23325.000 | | 17 1 35.00 0.00 . . . . . . . . . . . . 17---+ | | 4---+ 4 VAR 2 <= 83.500 | | 18 4 47.50 23.25 . . . . . . . . . . . . 18---+ | | | | | 9---+ | 9 VAR 14 <= 0.215 | | 19 3 36.00 50.67 . . . . . . . . . . . . 19---+ | | 2---+ 2 VAR 6 <= 2.500 | | 10 4 24.75 45.69 . . . . . . . . . . . . . 10---+ | | | | | 5---+ | 5 VAR 2 <= 80.500 | | 11 2 53.50 6.25 . . . . . . . . . . . . . 11---+ | | 1---+ 1 VAR 12 <= 1361.500 | 12 1 52.00 0.00 . . . . . . . . . . . . . 12---+ | | | 6---+ | 6 VAR 5 <= 8672.500 | | | 52 3 15.00 18.67 . . . . . . . . . . . 52---+ | | | | | | | 26---+ | | | 26 VAR 11 <= 3476.000 | | | | | 53 3 26.33 105.56 . . . . . . . . . . . 53---+ | | | | | | | | 13---+ | | 13 VAR 5 <= 25247.500 | | | 27 2 36.00 16.00 . . . . . . . . . . . . 27---+ | | | | 3---+ 3 VAR 12 <= 2588.500 | 28 3 3.67 1.56 . . . . . . . . . . . . 28---+ | | | 14---+ | 14 VAR 4 <= 29.500 | | | 29 2 9.00 4.00 . . . . . . . . . . . . 29---+ | | | | 7---+ 7 VAR 6 <= 2.500 | 15 1 22.00 0.00 . . . . . . . . . . . . . 15---+

26

Traitement des données, chapitre 6 : Classification

La procédure d'élagage entraîne la suppression des branches les moins informatives de l'arbre et produit cette séquence de sous arbres (A1, A2,...A35). Ce tableau fournit pour chaque sous arbre de la séquence : - son nombre de segments terminaux, - l'erreur relative de prédiction qui lui est associée dans l'Echantillon de Base et dans l'Echantillon-Test. • Pour l'échantillon de base cette erreur relative représente l'Erreur Apparente de Prédiction (EAP) rapportée à la variance de l'échantillon de base à la racine. • Pour l'échantillon-test, il s'agit de l'estimation de l'Erreur Théorique de Prédiction (E T P) rapportée à la variance de l'échantillon test à la racine de l'arbre. Les éléments du tableau permettent d'obtenir le sous-arbre optimal repéré par un * dans la dernière colonne. Il s'agit du plus petit (en terme de nombre de segments terminaux) sous arbre de la séquence correspondant à la plus petite estimation de l'erreur théorique de prédiction. Dans cet exemple le sous arbre en question est A94 contenant 2 segments terminaux dont l'estimation de l'erreur relative théorique de prédiction est 0,587. L'erreur relative correspondant à l'échantillon de base représente la variance résiduelle de l'arbre, rapportée à la variance s2 de Y à la racine de l'arbre (ou erreur apparente initiale), c'est-à-dire, la part de la variance non expliquée par l'arbre de régression construit à partir de l'échantillon de base. Tableau d'élagage - Recherche du sous arbre optimal

Coût d'erreur initial ( 388.17633)

Arbre Nombre de segments terminaux

Erreur relative de prédiction - échantillon

test

Ecart type associé

Erreur relative de prédiction - échantillon

base

Sous arbre optimal

1 14 1,064 0,347 0,065 2 13 1,014 0,340 0,067 3 12 0,969 0,321 0,070 4 11 0,954 0,321 0,084 5 10 0,909 0,298 0,100 6 9 0,911 0,298 0,117 7 8 0,831 0,284 0,143 8 7 0,708 0,251 0,192 9 6 0,714 0,252 0,242 10 5 0,648 0,237 0,313 11 4 0,713 0,232 0,394 12 3 0,639 0,226 0,478 13 2* 0,587 0,165 0,575 Optimum 14 1 1,000 0,034 1,000 Il apparaît que la variable INVETUD, Dotation équipement en francs par étudiant 2000, est celle qui permet de fournir la coupure qui minimisera la variété (erreur de prédiction) interne à chaque sous-groupe.

27

Traitement des données, chapitre 6 : Classification

Description de l'arbre élagué (échantillon de base) Nombre total de segments ( 3)

Nombre de segments terminaux ( 2)

Numéro du segment Effectif Pourcentage Moyenne

prédite

Erreur de prédiction (variance)

Libellé de la variable de coupure

Valeur de coupure

1 35 100,00 34,771 388,176 INVETUD 1361,500 2 20 57,14 45,900 230,590 Segment terminal 3 15 42,86 19,933 212,996 Segment terminal Ce tableau contient la description de l'arbre élagué (pour l'échantillon de base) : - les différentes divisions, - l'effectif (et la proportion) des différents segments intermédiaires ou terminaux., - la moyenne prédite et l'erreur de prédiction des différents segments. Ce tableau permet, surtout de connaître les effectifs des profils correspondant aux différents chemins de l'arbre. Le tableau suivant fournit les informations détaillées de tous les segments intermédiaires et terminaux et de toutes les divisions (ou coupures) de l'arbre retenu avec pour chaque segment la taille, la moyenne et son erreur de prédiction. La robustesse devant être testée en modifiant les choix de répartition entre tests et bases. Description des segments terminaux sur l'échantillon de base ( 35) Description et liste des individus du segment 2

Effectif du segment: 20

% de l'échantillon de base: 57.143 Moyenne de la variable à expliquer: 45.9000 Erreur apparente de prédiction: 230.5899

Numéro Identificateur de l'individu

1 Gre2

2 Vers

3 Tou1

4 Roue

5 Cerg

6 Caen

7 Stb3

8 Tou2

9 Perp

10 Havr

11 Gre3

12 Ly3

13 Nan2

14 Par1

15 Bret

16 Bdx3

17 Par3

18 Litt

19 Besa

20 Arto Description et liste des individus du segment 6

Effectif du segment: 9

% de l'échantillon de base: 25.714 Moyenne de la variable à expliquer: 27.5556 Erreur apparente de prédiction: 180.2469

Numéro Identificateur de l'individu

1 Poit

2 Vale

3 Bdx2

4 Bres

5 Orlé

6 Nant

7 Ange

8 Nice

9 La R

Description et liste des individus du segment 7

Effectif du segment: 6

% de l'échantillon de base: 17.143 Moyenne de la variable à expliquer: 8.5000 Erreur apparente de prédiction: 44.2500

Numéro Identificateur de l'individu

1 Lil1

2 Par1

3 Par9

4 Nan1

5 Bdx1

6 Cle1

28

Traitement des données, chapitre 6 : Classification

Références Celeux, G., E. Diday, G. Govaert, Y. Lechevallier, and H. Ralambondrainy (1989). Classification automatique des données. Dunod. Dillon W.R. & M. Goldstein (1984). Multivariate analysis. Methods and applications. John Wiley & Sons, New York, pp. 360-429. Jobson J.D. (1992). Applied multivariate data analysis. Volume II: categorical and multivariate methods. Springer-Verlag, New York, pp. 209-278. Johnson R.A. & D.W. Wichern (1992). Applied multivariate statistical analysis. Prentice-Hall, Englewood Cliffs, pp. 246-284. Lebart L., A. Morineau & M. Piron (1997). Statistique exploratoire multidimensionnelle. 2ème édition. Dunod, Paris, pp. 251-277. Saporta G. (1990). Probabilités, analyse des données et statistique. Technip, Paris, pp. 403-428. Sharma S. (1996). Applied multivariate techniques. John Wiley & Sons, New York, pp. 287-316. Tomassone R., M. Danzart, J.J. Daudin & J.P. Masson (1988). Discrimination et classement. Masson, Paris. Tomassone R., C. Dervin & J.P. Masson (1993). Biométrie. Modélisation de phénomènes biologiques. Masson, Paris, pp. 348-352, 358-367.

29

Traitement des données, chapitre 6 : Classification

Annexe Classification hiérarchique ascendante sous XLSTAT : reprise de l’exemple sur les marchés du travail dans l’OCDE Classification des lignes en fonction des colonnes Aucune donnée manquante détectée Pondération uniforme des colonnes (par défaut) Distance euclidienne Critère d'agrégation : augmentation de l'inertie (Ward) Les données sont standardisées Description du dendrogramme :

Noeud Niveau Effectif Fils gauche Fils droit 31 49,796 16 28 30 30 37,685 9 25 29 29 21,806 6 1 27 28 17,971 7 22 26 27 13,833 5 23 16 26 11,079 5 24 18 25 9,897 3 19 8 24 6,686 3 21 13 23 6,490 4 7 20 22 4,643 2 4 10 21 3,910 2 5 12 20 3,546 3 3 17 19 2,299 2 2 6 18 1,900 2 9 15 17 0,457 2 11 14

Histogramme des niveaux des noeuds

0,000 10,000 20,000 30,000 40,000 50,000 60,000

Dissimilarité

30

Traitement des données, chapitre 6 : Classification

31

28

2222

28

26

242121

24

26

1818

31

30

25

1919

25

30

2929

27

2323

2020

1717

27

0,00

9,00

18,00

27,00

36,00

45,00

54,00

Den

mar

k

Net

herla

nds

Finl

and

Nor

way

Sw

eden

Japa

n

UK

Bel

gium

Fran

ce

Italy

Aus

tralia

Ger

man

y

Can

ada

New

Zea

land

Sw

itzer

land U

S

Dis

sim

ilari

téDendrogramme

31