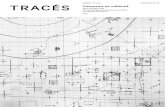

L‘EPFL pôle européen d‘un réseau de collaboration...

Transcript of L‘EPFL pôle européen d‘un réseau de collaboration...

FI édition spéciale 9.11.93

– 1 –

Après la signature du contrat de partenariat CRAY-EPFL — de gauche à droite : Messieurs J.-C. Badoux, Président de l'EPFL & J. F. Carlson, PDG de CRAY RESEARCH

(Photo Alain Herzog)

L‘EPFL pôle européen d‘un réseau de collaboration mondial

EDIT

ION

SPEC

IALE

FI édition spéciale 9.11.93

– � –

EDITORIALpar Marie-Christine sawley, siC-assistanCe

L'événement d’exception, Flash Informatique d’exception. Depuis la création de ce journal, c’est la première fois que nous produisons une édition spéciale. Cette dernière est motivée par les décisions ré-cemment prises par la Direction de l’EPFL, et qui vont remodeler dans les prochains 6 mois le paysage des moyens informatiques utilisés pour la simulation numérique.

A l’origine de ces choix, une décision de principe: souhaitant maintenir l’ex-pertise en simulation numérique pour laquelle certains groupes ont atteint une renommée mondiale, la Direction de l’EPFL, sur rapport de plusieurs groupes et sur recommandation de la Commission Infor-matique de l'Ecole, a jugé opportun (choix du moment et de la solution technique) de s’engager dans la voie du calcul massivement parallèle. Plusieurs systèmes ont vu le jour depuis quelques années, et ont montré les potentialités de cette technologie. Toutefois, il s’agit en-core d’une voie expérimentale en ce qui concerne les applications complètes de l’ingénieur. Afin de participer activement au défriche-ment de ces nouveaux territoires, et donc de continuer le travail de pionnier dans des domaines des sciences physiques et des sciences de l’ingénieur, l’EPFL choisit de s’associer avec un constructeur, CRAY RESEARCH: l’alliance du savoir faire et du savoir construire. Cette alliance a été scellée le 28 octobre dernier, à l’issue d’une conférence de presse, et marque le début d’une collaboration de 3 ans entre les deux partenaires. Face

de ce face à face avec la presse. M. le Président Badoux s’est attaché à souligner que l’École avait un grand potentiel pour rester dans le peloton de tête de la recherche et du développement dans les sciences de l’ingénieur. M. le Président Carlson a confirmé que l‘EPFL serait le seul centre européen de ce réseau de collaboration mondial. M. Paltenghi a relevé le caractère indispensable du partenariat pour faire face aux

défis passionnants posés par la technologie mas-sivement parallèle. Enfin M. Lévy a tenu à rappeler le rôle important que l’Europe peut et doit jouer sur la scène des logiciels d’applications.

L’accord est largement abordé dans les inter-views que m’ont accordé Jean-Jacques Paltenghi et Gilbert Lauber. Je profite de l’occasion pour les remercier d’avoir accepté de consacrer un peu de leur temps pour les lecteurs du Flash Informatique.

L’EPFL devient ainsi le pôle européen d’un réseau mondial de compétences

en technologie massivement paral-lèle. Grâce à la détermination de quelques initiateurs dont Michel Reymond et Gilbert Lauber, qui ont su convaincre leurs directions respec-tives de la nécessité d’engager des analyses et des études –auxquelles du côté de l’EPFL Gabriel Clerc et Gérald Parisod, ainsi que les professeurs concernés et certains collègues du SIC (J.-J. Dumont, M. Jaunin et la soussignée) ont consacré beaucoup de leur temps ces derniers mois– sur des formes de collabo-ration encore inexplorées. Il reste toujours des terrains à découvrir, encore faut-il être animé de passion et de persévérance.

à la presse se trouvaient Messieurs J.-C. Badoux, Président de l’École, J.F. Carlson, PDG de CRAY RE-SEARCH, J.-J. Paltenghi, directeur de la planification et de la recherche, ainsi que R. Lévy, vice-président de CRAY Europe.

Cette collaboration se fera pour du développement de technologie dans le domaine des logiciels d'application pour la simulation numérique sur un sous-système massi-

vement parallèle (256 processeurs, dont 128 mis à disposition par Cray dès l'installation et que l‘EPFL peut acquérir par la suite) qui sera connecté à Pascal au printemps 94. Auparavant, au mois de décembre, le Cray-2 aura été mis hors service et Pascal renforcé (achat de mémoire supplémentaire et de 3 processeurs). Il est à remarquer que la capacité en calcul vectoriel à l’EPFL passera ainsi de 6 à 4 processeurs.

Les raisons de cette alliance? Lorsque deux partenaires se mettent ensemble, c’est qu’ils se sentent com-plémentaires et lorsque la confiance est réciproque, et ce sont les points forts ressortis au fil des interventions

La signature du contrat de partenariat CRAY-EPFL (Photo Alain Herzog)

FI édition spéciale 9.11.93

– 3 –

Le massivement parallèle, quel enjeu pour l‘EPFL?

Interview de J.-J. Paltenghi, membre de la Direction de l‘EPFL

par Marie-Christine sawley, siC-assistanCe

financier fixé par l’accord. Mais encourager et aider de nouveaux groupes de recherche à démarrer dans le domaine du massivement parallèle qui pourraient eux aussi utiliser le T3D comme outil de production, dans le cadre des priorités fixées, sont des objectifs essentiels

s Comment ces objectifs s’inscrivent-ils dans les missions d’enseignement et de recherche de l’École?

t Nous sommes convaincus de l’importance de la simulation numérique pour la recherche scientifique et technique, y compris pour les applications indus-trielles. L’EPFL a été pionnier en Suisse et sur la scène internationale dans certains domaines de recherche utilisant la simulation numérique, que l’on s’accorde à décrire comme le troisième pilier de la recherche. L’analyse prospective entre les professeurs et les colla-borateurs du SIC nous a convaincus que l’avènement des systèmes massivement parallèles allaient permettre des avancées considérables. Permettre aux chercheurs et étudiants de se familiariser de travailler avec cette nouvelle technique, voilà ce qui s’inscrit parfaitement dans nos missions et nos objectifs en tant qu’École Polytechnique.

La coLLaboration

s Pourquoi l’association à un constructeur était-elle déterminante?

t Une école de notre taille, voire même une école plus grande n‘a pas les moyens de monter à elle seule un programme leader et compétitif au niveau internatio-nal.

s Finalement, quelles sont les raisons qui ont fait que l’EPFL ait choisi Cray comme partenaire?

t Les compagnies qui sont sur ce marché se comptent sur les doigts d’une main. Depuis près de 15 ans, Cray occupe une place de premier plan sur la scène de l’informatique de puissance pour la simulation numérique, donc ils ont une grande expérience. De

s Jean-Jacques Paltenghi, un accord de collaboration avec la société américaine Cray vient d’être conclu. En quoi consiste-t-il ?

t Il s’agit d’un accord de recherche et développement «Parallel Application Technology Program (PATP)», visant au développement commun d’applications parallèles sur T3D dans des domaines des sciences de l’ingénieur à l’EPFL. Le T3D est le sous-système massivement parallèle que CRAY vient d’annoncer, et dont l’EPFL a décidé de s’équiper dès le printemps 94. L'EPFL met à disposition le système ainsi que le personnel pour le management et l'encadrement des projets; Cray finance le personnel supplémentaire ainsi que les frais de location des locaux au Parc scientifique. La collaboration porte sur un montant de 12 millions dont sont exclus les frais du système formé par le M94 et T3D. Il s’agit d’un accord cadre fixant les conditions financières, organisationnelles, les conditions de gestion, le choix et le management des projets, les questions de propriété. Ce n’est pas le premier accord de ce type à l’EPFL: nous pouvons citer par exemple la collaboration avec Thomson. De plus, des accords spécifiques seront signés entre CRAY et les professeurs concernés pour les aspects recherche. 4 projets pilotes sont prévus sur 3 ans: mécanique des fluides, physique des plasmas, traitement des images et la physique des matériaux.

s Quels sont les objectifs de ce projet?

t Le premier est de démontrer qu’il est possible de développer sur un système massivement parallèle des outils performants pour affronter les grands défis de simulation scientifique. La nécessité pour l’EPFL de s’engager dans cette collaboration est d’abord justifiée par la recherche, les applications industrielles de pointe et la formation de haut niveau comme le doctorat. La diffusion de l’expertise en massivement parallèle est également un des objectifs prioritaires. Un groupe de support commun EPFL-CRAY travaillera au départ avec les projets pilotes, et offrira de l’aide aux autres qui voudront démarrer par la suite. Augmenter le nombre de projets pilotes sera difficile, vu le cadre

FI édition spéciale 9.11.93

– � –

plus, nous avons avec ce constructeur une relation de longue durée, depuis 1986, ce qui a permis d’envi-sager le partenariat, qui nécessite tout de même une certaine dose de confiance. Nous faisons aussi un pari sur leur capacité à se maintenir parmi les leaders de leur domaine: les indications de performances de T3D par rapport à des machines comparables nous confortent dans cette opinion. Il nous fallait choisir un partenaire offrant, de notre point de vue, les meilleures garanties techniques et capable de mener à bien cette collaboration; nous avons choisi celui avec lequel la collaboration nous semble le plus profitable sur le long terme pour l’EPFL, tout en minimisant les risques encourus.

technoLogie et choix stratégique

s L’EPFL s’était engagée dès 1986 dans le calcul vectoriel à haute performance. La conclusion de cet accord et l’installation prochaine d’un T3D s’inscrivent-elles dans la continuité de cet engagement, ou marquent-elles l’abandon d’une filière?

t Le calcul vectoriel traditionnel subsistera sur nos ma-chines de production, mais l’EPFL a décidé de ne pas augmenter ses capacités dans cette filière. Celle du T3D est expérimentale, et les comparaisons à ce stade ne sont pas possibles. Nous faisons le pari qu’après la durée de vie des machines actuelles traditionnelles (tel le Y-MP ou NEC SX-3), le calcul massivement parallèle ouvrira des perspectives plus ambitieuses.

s Quels sont à votre avis les apports à attendre de cette technologie?

t Pour la résolution de problèmes dans de nombreux domaines de la science et de l’ingénierie, les progrès que l’on peut espérer sont tributaires d’une importante augmentation de la puissance de calcul; la taille du problème n’est pas la seule en cause, la complexité est également un facteur important. Ces «grands chal-lenges» se rencontrent, par exemple, en physique du solide, physico-chimie de l'atmosphère, météorologie, mécanique des fluides, énergétique, sciences des matériaux, chimie et biotechnologie, et génie civil.

s Pourquoi l’École choisit-elle aujourd’hui de se lancer dans le massivement parallèle?

t Il existe déjà quelques systèmes parallèles en Suisse, quelques uns ont même été prêtés à l’EPFL ces deux dernières années et certains de nos chercheurs ont acquis une expérience sur ce type de machines. L’EPFL souhaite conserver un rôle de pionnier dans le domaine de la simulation numérique, plutôt que de se contenter d’un second rôle. Je pense que l’année charnière, celle où le massivement parallèle dépassera les superordinateurs vectoriels, est pour 1995. Il nous fallait donc anticiper le mouvement: trop tôt, les risques

étaient trop grands, trop tard, nous devrons suivre le mouvement. Un accord tel que celui-ci ne pourrait probablement plus se négocier dans 12 mois. Nous avons estimé que le moment opportun était arrivé.

s L’utilisation d’une machine comme le T3D sera-t-elle réservée à quelques «initiés»?

t Non, carrément non: il est clair que le programme PATP (les 4 projets pilote, ndrl) utilisera cette machine avec un certain degré de priorité. Mais elle sera ouverte aux autres unités de l’École, ainsi qu’aux universités et entreprises suisses et européennes. La stratégie choisie est que les projets pilotes acquièrent une certaine expérience qui doit ensuite diffuser vers les de nouveaux utilisateurs et ainsi de suite. En ce sens, cette situation n’est pas très différente que celle vécue avec le Cray-1 ou le Cray-2. La plus grande différence vient de ce qu’on s’attend à une complexité de programmation plus importante, pour des perspec-tives de performances et de réalisations en rapport.

s Est-ce important de former des ingénieurs en simula-tion numérique, et plus particulièrement sur machines massivement parallèles?

t Oui, je suis convaincu qu’une bonne utilisation et une bonne maîtrise de la simulation numérique peuvent augmenter la compétitivité et la créativité dans beau-coup de domaines. Et personnellement je regrette que beaucoup d’entreprises méconnaissent encore ces techniques qui sont en développement auprès d’universités, de constructeurs ou d’écoles d’ingénieurs et qui ne sont pas réservées aux entreprises de pointe. Au lieu de passer des mois à faire des prototypes et des maquettes, la simulation bien maîtrisée permet de raccourcir les délais, de multiplier les options et de tester de nouvelles hypothèses.

Les reLations extérieures

s Cette collaboration aura-t-elle une influence sur nos relations avec l’industrie suisse? Avec quels secteurs en particulier?

t Parmi les projets pilotes, 2 sont plutôt à tendance scientifique (physique du solide et physique des plasmas), alors que les 2 autres ont des applications industrielles plus immédiates (traitement d’images et mécanique des fluides): il existe donc un équilibre dans les programmes de recherches PATP à l’EPFL. Je pense qu’une influence positive ressortira de ce programme de recherche d’abord avec les secteurs industriels dans le prolongement de nos «grands challenges»: l’industrie des machines, l’aéronautique, l’automobile, la chimie, l’environnement, les systèmes de communication, etc.

s Cette collaboration irait au-delà que la formation d’ingénieurs?

Le massivement paraLLèLe, queL enjeu pour L‘epFL?

FI édition spéciale 9.11.93

– � –

t En formant nos ingénieurs à ces techniques, nous fai-sons le pari qu’un jour ou l’autre, face à un problème particulier au cours de leur carrière, ils puisent dans leurs connaissances. Mais nous devons aller au-delà en favorisant par exemple des programmes communs entre industriels et instituts qui ont une expérience et un intérêt pour cette nouvelle technologie. Un effort de promotion est à faire auprès des industries qui ne sont pas encore initiées et convaincues de l’apport de ce type de technique.

s Et avec les autres institutions du CEPF, en particulier l’ETHZ et le CSCS?

t Cette machine sera à disposition de l’ETHZ et du PSI, tout comme nous continuerons à utiliser le SX-3 à Manno. Il existe une complémentarité entre les 3 sites, que nous devrons développer autour du calcul massivement parallèle, afin d’échanger les expériences sur les différentes plates-formes.

s Cette complémentarité pourrait-elle être utile pour le choix d’un éventuel système de production natio-nal?

t Oui, car personne ne peut dire quel système et quelle architecture s’imposeront finalement. Donc tout recou-pement de connaissances ne peut être qu’une bonne chose.

s Avec l’Université de Lausanne?

t Nous donnerons l’occasion aux instituts de l’UNIL de travailler avec le T3D: des priorités seront fixées, mais cette possibilité sera certainement offerte.

s Sur quel plan placez-vous les relations avec les deux autres centres PATP, membres du réseau mondial de collaboration?

t C’est le troisième étage de la «fusée» de la collabora-tion: le premier est celui des projets, le second est celui du programme et son comité de gestion paritaire, et le troisième est international: il s’agit de la fédération des 3 programmes contractés par CRAY. Les deux autres sont situés l’un en Californie (Jet Propulsion Laboratory/Caltech) et l’autre en Pennsylvanie (NSF Pittsburgh Supercomputing Center: Carnegie Mellon University, University of Pittburgh). Un quatrième site aux États-Unis pourrait se joindre prochainement. L’EPFL est le seul site non-américain, et à ce titre a une grande responsabilité de catalyser les collaborations européennes, universitaires et industrielles. Nous espérons que les échanges seront très profitables sur le plan scientifique.

Le futur

s Quels sont les critères de réussite du projet ?

t Que la machine soit utilisée et que les utilisateurs aient le sentiment et la certitude qu’elle leur apporte un «plus». Ce «plus» peut être évalué par les progrès et les avancées qui se feront dans les sciences et les problèmes d’ingénierie où se recruteront les utilisateurs. La nature de ces progrès donnera une indication de la grandeur du succès. Sur un plan moins ambitieux, un succès serait de voir se consolider dans l’École un groupe d‘excellence constitué d‘ingénieurs et de chercheurs faisant largement usage de la technologie massivement parallèle.

s Au bout des 3 ans, qu’est-ce qui vous ferait dire que la collaboration a échoué ?

t La recherche, si elle ne conduit pas à une invention, n’est pas forcément un échec. Supposons que nous arrivions à la fin du programme avec la conclusion que cette technique n’est pas maîtrisable ou n’amène rien, des réponses auraient été données à des questions qui se posent dès à présent: ce serait aussi un succès. Dans le cadre de notre mission de formation, je crois que l’on peut beaucoup apprendre sur un projet qui ne se conclut pas sur une réalisation technique. Le véritable échec dans une école est l’incapacité de transmettre les connaissances, c’est l’échec pédagogique.

s Quoi qu’il arrive, il s’agirait donc d’un succès?

t Non bien sûr, la mésentente entre partenaires débou-chant sur un arrêt de la collaboration, la livraison d’une machines ne répondant pas aux conditions d’accepta-tion, ou encore la désertion du T3D par les utilisateurs sont des exemples de ce que je définirais comme des situations d’échecs véritables. Certains de ces cas de figures sont d’ailleurs réglés contractuellement, nous avons apporté un soin tout particulier à envisager ces situations et de préparer des issues de secours.

s Projetons nous d’ici à fin 96. Quelle suite possible, sinon souhaitable, voyez-vous à cet effort en direc-tion du massivement parallèle à l’EPFL à la fin des 3 ans?

t Si les objectifs poursuivis sont atteints, nous verrons l’avènement de systèmes de production qui feront partie du paysage informatique des chercheurs et des ingénieurs. J’espère qu’il y aura encore des actions à caractère pionnier à effectuer pour la simulation numérique: l’École a montré dans le passé sa qualité par sa capacité de travailler sur des problèmes à la frontière des possibilités. Le succès a plusieurs facettes: l’une est que cette phase de développement débou-che sur une phase de production, mais la constitution d’équipes interdépartementales compétentes pouvant relever les défis qui suivront en est une autre. n

Le massivement paraLLèLe, queL enjeu pour L‘epFL?

FI édition spéciale 9.11.93

– � –

La stratégie pour le calcul massivement parallèle chez

CRAYInterview de G. Lauber, Directeur de Cray Suisse

par Marie-Christine sawley, siC-assistanCe

technoLogie et choix stratégique

s CRAY vient d’annoncer son système massivement parallèle T3D. Pouvez-vous nous en dire plus sur ce système?

t Le système Cray T3D est un système massivement parallèle de nouvelle génération largement en avance sur les autres systèmes MPP car il s‘agit du premier supercalculateur hétérogène extensible. En effet, l‘en-vironnement T3D permet d‘associer harmonieusement les caractéristiques vectorielles/parallèles largement éprouvées des systèmes traditionnels de Cray Research avec les fonctionnalités prometteuses d‘une architecture massivement parallèle performante. Cette hétérogé-néité doit, d‘une part, permettre d‘élargir le spectre de problèmes pouvant être abordés par voie numérique, et d‘autre part accroître de manière significative les performances des applications en fonction de la taille du système. Ce dernier point représente d‘ailleurs le véritable enjeu du marché massivement parallèle.

La gamme des configurations possibles Cray T3D commence avec 32 processeurs (4,8 Gigaflops soit 4,8 milliards d'opérations en virgule flottante

par seconde) et s‘étend jusqu‘à 2048 processeurs (307 Gigaflops crête) par doublement successif du nombre de processeurs. Les clients disposant déjà d‘un système Cray vectoriel/parallèle peuvent compléter leur environnement par une implémentation MPP Cray T3D disposant de 32 à 2048 processeurs.

Jusqu'à 128 processeurs, les configurations proposées sont disponibles avec un refroidissement par air ou par eau, les configurations plus importantes étant refroidies par eau.

Les tailles mémoires proposées s‘étendent de 0.5 à 128 gigabytes (2048 Megamots de 64 bits!) selon la configuration adoptée.

s Combien de systèmes ont déjà été installés dans le monde (et en Europe en particulier)?

t A ce jour, Cray Research a enregistré de par le monde douze commandes de systèmes Cray T3D. Ces commandes ont été émises dans les secteur gouvernementaux, universitaires et industriels. La toute première machine de production a ainsi été installlée fin août dans les murs du Pittsburgh Supercomputer Center qui dispose par ailleurs d'un système Cray C90.

Un autre de ces systèmes sera par exemple installé dans les tous prochains jours pour le compte d‘une importante compagnie américaine active dans le domaine de la recherche et l‘exploration pétrolière.

Quatre à cinq installations européennes sont d'ores et déjà planifiées pour les six prochains mois.

s Quels sont à votre avis les apports à attendre de cette technologie? Et pourquoi CRAY choisit-il aujourd’hui de se lancer dans le massivement parallèle?

t Bien entendu, cette technologie étant nouvelle, j’estime que notre système a toutes les chances de devenir le premier système en production pour des applications complètes d’ingénieur. C’est un de nos points forts à mon avis par rapport aux systèmes massivement parallèles existants aujourd’hui.

Pour parler des motivations, la première est d’attein-dre la puissance nécessaire pour affronter les grands

FI édition spéciale 9.11.93

– � –

problèmes de simulation scientifique. Mais on ne pourra y parvenir que si il y a une refonte complète des méthodes de programmation: il faut apprendre à «penser» massivement parallèle. A mon avis, les possibilités seront exponentielles! Nous partons avec l’objectif d’atteindre le TeraFlop/s, c’est-à-dire 1 billion d’opérations en virgule flottante par seconde en production.

s Quand prévoyez-vous d’y parvenir?

t Laissez-moi dire au préalable que l’un des avantages de notre système est que l’architecture est indépendante du processeur utilisé. Nous avons prévu 3 phases dans l’évolution du système massivement parallèle: actuellement le T3D basé sur le chip Alpha, en 95 le T3E (1 TF en pointe) et en 97 une machine dont le nom n‘est pas encore connu mais qui arrivera à des performances en production (sustained) de l’ordre de 1 TF. Ces deux derniers modèles seront basés sur le chip le plus rapide du marché.

s CRAY s’est engagé depuis une vingtaine d’années dans le développement de systèmes vectoriels et scalaires à très haute performance. Son entrée en force sur le marché du massivement parallèle remet-elle cette filière en question?

t Bien au contraire, je pense qu’il reste un potentiel client important pour le vectoriel traditionnel. Beaucoup d’ap-plications de simulation numérique sont composées de parties scalaires, vectorielles, et parallèles. Ces appli-cations sont souvent trop complexes pour être typifiées. Donc un système hétérogène, capable de prendre en compte les spécificités de chaque morceau de code et de l’adresser au processeur vectoriel, scalaire ou au sous-système massivement parallèle sont, au sens de CRAY, la clef pour résoudre ces problèmes.

s Ces systèmes sont prévus pour quand?

t Le système dont l’EPFL sera équipé, un Y-MP/M94 et un T3D qui lui est couplé, en est déjà l’exemple! Bien entendu d’importants développements en logiciel sont à attendre pour atteindre cet objectif de distribution entre le séquentiel et le massivement parallèle. Il est possible que dans le futur le tout soit regroupé dans un seul et même châssis, mais il est prématuré d’en parler.

La coLLaboration

s Pourquoi recherchez-vous la collaboration avec un site universitaire pour ce nouveau système?

t Lors de la sortie des premiers processeurs vectoriels, le logiciel s’est développé au fur et à mesure et la palette d’applications est aujourd’hui bien fournie. Nos clients s’y sont habitués et nous avons senti le besoin de leur apporter rapidement sur la nouvelle architecture

massivement parallèle un environnement applicatif comparable. il faut aller vite car la concurrence est vive, et l’effort de développement est important. Il est impératif d’avoir des applications tournant à la perfection sur ce type d’architecture: la collaboration (soit portage soit développement avec parallélisation intelligente) avec des spécialistes en est la meilleure garantie.

s L’EPFL est le troisième site du programme PATP (Parallel application technology program). En quoi consiste ce programme?

t Je souhaiterais apporter une petite correction: l’EPFL est le troisième site à signer un accord de ce type, mais c’est surtout entre l’EPFL et CRAY SUISSE que l’idée de cette forme de collaboration a germé! Je suis allé vendre le projet chez CRAY aux USA, auprès de qui l’écho a été si favorable que l’idée d’un programme mondial a été lancé, auquel ont adhéré déjà deux sites nord-américains prestigieux eux aussi: Jet Propulsion Lab/Caltech et NSF Pittsburgh Supercomputing Center en Pennsyslvanie, Un quatrième et dernier partenaire sera annoncé prochainement.

s Quelles sont les raisons qui ont fait que CRAY ait proposé à l’EPFL d’être partenaire dans cette collaboration?

t Nous faisons chacun ce que l’on sait faire le mieux: chez vous les applications de sciences de l’ingénieur, chez nous les machines et les logiciels de base. Nous avons cherché le meilleur partenaire pour l’applicatif, c’était vous. Nous estimons avoir la meilleure architec-ture ainsi que la meilleure plate-forme logicielle pour le massivement parallèle, donc l’alliance est bonne pour obtenir le meilleur résultat. Actuellement sont prévues 4 collaborations avec des projets pilotes: l’IMHEF, l’IRRMA, le CRPP et le LTS. L’excellence de ces instituts dans leur domaine spécifique et leur expérience dans les relations industrielles étaient déterminants. Dans ce cadre, CRAY est heureux de s’installer dans les locaux du Parc Scientifique de l’EPFL à Ecublens.

s Que répondriez-vous à ceux qui estiment que des systèmes aussi performants tels que le T3D ne seront accessibles que par un très petit nombre d’industriels en raison de leur coût (équipement, exploitation)?

t Nous sommes au début du développement de MPP: il est fort probable que si la technique s’avère efficace, les méthodes pourront être utilisables, comme cela s’est passé pour le vectoriel, sur des systèmes plus modestes. Une forme de collaboration avec le secteur privé pourrait être la formation de doctorants par l‘EPFL ou l‘exécution de mandats confiés par les industriels à l‘EPFL.

La stratégie pour Le caLcuL massivement paraLLèLe chez craY

FI édition spéciale 9.11.93

– � –

Les reLations extérieures

s Quels sont les deux autres sites déjà associés au programme PATP et quels sont leurs points forts?

t Le NSF (National Science Foundation) Pittsburgh Su-percomputing Center avec la chimie, les matériaux, l’informatique pure et le génie médical; et le Jet propul-sion Laboratory de Caltech en CFD, électromagnétique, climatologie, environnement, plasmas. Je ne parle ici que de leurs points forts, d’autres projets sont en cours auprès de ces institutions.

s Ces institutions ont-elles à disposition un vivier de scientifiques de même importance que l’EPFL?

t Il y a environ un millier de chercheurs à JPL, alors que l’université de Carnegie Mellon, qui est un des par-tenaires pour le PSC, est environ 3 fois plus grande que l’EPFL.

s Cette collaboration aura-t-elle une influence sur vos relations avec l’industrie suisse et européenne? Avec quels secteurs en particulier?

t Parallèlement au projet PATP, nous avons une associa-tion avec ACRI de Tor Bloch et Jacques Stern, sous la forme de deux sociétés: une à Louvain-la-Neuve nommée ACSET, qui vise à développer un compilateur Fortran pour les fabricants européens en ayant en front-end le compilateur de CRAY. Une seconde société à Grenoble, nommée APTOS, s’occupe du portage d’applications à la fois sur CRAY et au moins sur une plate-forme européenne. L’initiateur des ces contacts avec l’industrie du software informatique européen est M. Robert Lévy, vice-président de Cray Europe, et M. Martin Walker dirige APTOS.

Le futur

s Quels sont, selon vous, les critères de réussite du projet? Ceux d’échec?

t Le seul échec réel serait que la collaboration ne mar-che pas. Toutes les autres situations sont des situations de réussite, à degrés variables bien entendu. Il est sûr que si au bout des 3 ans, des codes sont mis à disposition et une continuation au projet est trouvée, ce serait de mon point de vue, un grand succès.

s Et si l’on démontre que le massivement parallèle ne marche pas du tout pour certains problèmes?

t Bien sûr que ce serait positif, car le terrain serait dé-friché. Savoir que l’on a fait fausse route est toujours préférable que de ne rien savoir du tout!

La stratégie pour Le caLcuL massivement paraLLèLe chez craY

s Projetons nous d’ici à 3 ans. Quelle évolution pré-voyez-vous pour la filière massivement parallèle chez CRAY?

t Nous allons vers des systèmes hétérogènes, comme je l’ai évoqué au début. Les deux architectures (ndlr: séquentielle et massivement parallèle) coexisteront et une application, suivant la complexité des modules, pourra être adressée sur l’une ou l’autre des parties du système. Le logiciel détient la clef du succès!

s A quoi ressemblera selon vous le bon outil pour la simulation numérique de pointe en l’an 2000?

t Aux machines de CRAY de l’an 2000! D’une manière générale je pense que des améliorations certaines seront faites dans les entrées/sorties, et que les temps d’accès et les coûts de la mémoire seront diminués. n

Photo du T3D de Cray, sous-système qui sera connnecté à Pascal M94

FI édition spéciale 9.11.93

– 9 –

Arrêt du Cray-�Extension de Pascal

par MiChel Jaunin, siC-exploitation

Cette fin d’automne, et jusqu’au début de l’hiver, d’im-portantes modifications vont être apportées aux serveurs centraux de l’EPFL, dans le cadre d’un projet plus global qui verra l’installation d’un système massivement parallèle au printemps 1994 (décrit ailleurs dans ce Flash Informa-tique), tel que soutenu par la Commission Informatique lors de sa séance du 7 octobre 1993 et entériné par la direction de l’Ecole. Le Cray-2, en fonction depuis plus de 5 ans, sera mis hors service, et la plupart de ses tâches seront reprises par un système «Pascal plus» (Y-MP M94), résultat de la mise à jour de l’installation actuelle Y-MP 4E, alias Pascal. Différents éléments en relation avec cette opération sont décrits dans les 4 articles qui suivent:• Planification des opérations• Grandes manœuvres d’automne et d’hiver• Utilisateurs de Cray-2, ceci peut vous intéresser• Modifications du service du cluster Vax (stations

Cray)

Nous sommes conscients que cette période sera difficile pour certains utilisateurs, en particulier en raison de la période chargée de fin d’année, mais les collabo-rateurs du SIC, ainsi que ceux du fournisseur Cray, feront le maximum pour leur faciliter la tâche. Nous restons à

votre disposition pour tous renseignements.Les services offerts par le Cray-2 au niveau national

se terminent avec l’arrêt de la machine; ceux-ci sont repris par l’installation NEC du CSCS à Manno, entrée en exploitation en 1992. Afin de favoriser la migration souple sur ce nouveau système des applications des utilisateurs extérieurs, l’EPFL n’a pas fermé l’accès à ses ressources informatiques. Pour l’avenir, elle entend maintenir une politique d’ouverture en allouant des ressources à de bons projets universitaires en tenant notamment compte de l’existence d’une collaboration ou d’une synergie avec l’EPFL.

Ainsi, les utilisateurs du Cray-2 qui ne dépendent pas d’une institution rattachée au CEPF ne verront pas leurs comptes transférés sur le successeur du Cray-2. Ils envisageront, le cas échéant, de déposer une demande formelle à la direction de l’EPFL contenant la justification scientifique et technique de leur projet éventuellement établi avec un partenaire à l’EPFL pour pouvoir accéder au Y-MP M94.

Les utilisateurs de l’EPFL ou dépendant d’une insti-tution du CEPF et disposant d’un compte sur le Cray-2 qui désirent poursuivre leur travail sur son successeur doivent préparer dès maintenant la migration de leurs applications et de leurs fichiers. Se référer aux articles suivants pour les détails.n

Planification des opérationspar MiChel Jaunin, siC-exploitation

Les serveurs de calcul centraux de l’EPFL, gérés par le SIC, sont basés sur 2 systèmes complémentaires Cray, le Cray-2, à très grosse mémoire centrale, et le Y-MP4E, Pascal, dont les 2 processeurs sont environ 2 fois plus rapides que ceux du Cray-2.

Le Cray-2, installé en 1988, basé sur une technologie mémoire dynamique de 1986, a offert de très importants services jusqu’à ce jour; ses frais d’exploitation (frais de maintenance, coût de l’alimentation

de celle du Cray-2. Le M94 gardera les disques actuellement connectés à Pascal, et recevra en plus les disques du Cray-2, après son arrêt, disques qui seront simultanément remis à neuf avec augmentation de leur capacité, ainsi que ses accès aux cartouches et au robot. La configuration finale pour le serveur de calcul central sera donc:

Y-MP M94, 4 CPU’s, 512 M mots de mémoire (4 GB), plus de 60 GB de disques, accès au robot et aux cartouches à montage

électrique,…) deviennent actuelle-ment disproportionnés avec ceux du matériel disponible aujourd’hui sur le marché. Il a donc été décidé d’arrêter le service du Cray-2, et de procéder à une mise à jour de Pascal afin de permettre d’offrir ce qui faisait la particularité du Cray-2, à savoir une très grosse mémoire centrale. En l’occurrence, Pascal sera transformé en un système Cray Y-MP M94, disposant de 4 processeurs et d’une mémoire de 512 M mots (4 GB), soit le double

FI édition spéciale 9.11.93 – 10 –

manuel.En raison de la technologie

retenue pour pouvoir disposer de cette énorme mémoire, les accès à la mémoire sont plus lents que sur Pascal, ce qui fait que la perfor-mance par processeur du M94 est moindre que celle de Pascal: entre 75 % et 95 % selon que le code est très scalaire ou très vectorisé. En moyenne, la capacité du M94 représente donc environ 85 % de celle disponible actuellement avec le Cray-2 et Pascal, mais elle peut être améliorée de manière importante si l’application utilise sa grande taille mémoire. Pour le reste, le système M94 est identique à Pascal, et l’utilisateur ne devrait pas voir de différence. Indépendemment des gains en frais d’exploitation (maintenance, fluides, gestion d’un seul système) qui ne le touchent pas directement, l’utilisateur aura l’avantage de n’avoir à s’adresser qu’à un seul serveur qui regroupe à la fois les avantages du Cray-2 et du YMP4E, ceci avec un rapport prix/performance plus intéressant.

Cette configuration permettra aussi, plus tard, et avec quelques adjonctions en capacité disque, de recevoir un sous-système massive-ment parallèle (MPP), ce qui permet-tra d’augmenter de manière très importante la capacité de calcul, bien au-delà de ce qui est disponible aujourd’hui.

La planification des opérations, telle que décrite dans le tableau ci-contre, est encore sujette à des adaptations, mais ses grandes lignes sont relativement stables. Les détails seront donnés par les moyens habituels d’information en ligne. No-tons qu’en raison de l’arrêt imminent du Cray 2, il n’est plus possible d’ouvrir de nouveaux comptes sur

Le serveur de fichiers Nestor n’est pas directement touché dans cette opération, sauf par les services de stockage qu’il peut offrir lors de la migration des fichiers.

Michel Jaunin, SIC-SE, & 021.693 22 02E-mail: [email protected] n

arrêt du craY-2 — extension de pascaL

ce système dès maintenant.La période de fonctionnement

parallèle entre le Cray-2 et M94 (environ 2 à 3 semaines) sera dif-ficile, sachant que la configuration disque sur le M94 sera incomplète jusqu’au moment du transfert des disques provenant du Cray-2. Il faudra alors faire usage de DMF sur M94 et du serveur de fichiers Nestor en cas de besoin.

Ces modifications de configu-ration impliquent des changements dans les infrastructures de l’alimen-tation électrique et de refroidisse-ment; nous ferons notre possible pour limiter le plus possible les interruptions de service qui seront nécessaires.

jusqu'à mi- décembre

FI édition spéciale 9.11.93 – 11 –

Grandes manœuvres d’automne et d'hiver

Migration des comptes et environnements des ordinateurs cray-2 et Pascal/YMP vers Pascal/M94

par Jean-MiChel Chenais, siC-exploitation

ModaLités de Passage au nouveau MatérieL

La stratégie de migration des envi-ronnements Pascal/Y-MP et Cray-2 vers le M94 est dictée par tout un ensemble de considérations, dont les principales sont les suivantes:z compatibilité complète, de par

son architecture et telle qu’an-noncée par le constructeur, entre le Pascal/Y-MP et le M94: en particulier, pas de recompilation nécessaire des codes.

z incompatibilité du Cray-2 avec le M94, de par son matériel (archi-tecture), et celle éventuellement re-lative à son logiciel d’exploitation Unicos (niveau 6.1.5a) non remis à jour depuis largement plus d’un an; la conséquence principale est que tous les codes Cray-2 devront tous être recompilés sur M94.

z présence sur Cray-2 d’un vo-lume de données utilisateur

relativement important (environ 25 Gigabytes) à traiter pour la migration, ces données étant ac-tuellement soit en ligne sur disque soit archivées sur le système DMF propre au Cray-2 (donc distinctes de celles existant sur Nestor);

z nécessité de tenir compte du fait que des comptes de même nom peuvent exister sur Pascal et Cray-2;

z nécessité de redéfinir les valeurs de uid/gid du Cray-2 selon les nouvelles règles officielles;

z transfert contrôlé, donc non auto-matique, de l’ensemble des comp-tes du Cray-2, vers le M94;

z reprise et rattachement au M94, après remise à neuf d’une partie de la périphérie des sous-systèmes disques du Pascal/Y-MP et du Cray-2 (doublement des capaci-tés disque);L’ensemble de ces considéra-

tions nous amène à déterminer la

stratégie de migration suivante:z pour le Pascal/Y-MP, prise en

charge par le SIC des opérations de transfert des comptes, envi-ronnements, services et fichiers du Pascal/Y-MP vers le M94. Cette opération ne pose pas de problèmes particuliers.

z pour le Cray-2, le principe retenu est que les usagers ayant des comptes sur les 2 machines sont tenus d’effectuer eux-mêmes leurs propres opérations de migration, c’est-à-dire de regrouper dès maintenant leurs fichiers Cray-2 dans l’environnement du Pas- cal/Y-MP (qui sera alors transféré d’office sur le M94), ou direc-tement sur le M94 lorsque ce dernier sera accessible pendant la période de recouvrement des 2 machines. Pour tous les usa-gers n’ayant un compte que sur Cray-2 et désireux de le transférer sur M94, une circulaire sera adres-sée personnellement qui précisera les modalités administratives liées à cette démarche, après quoi ce transfert pourra être entrepris soit par l’usager, soit par le SIC.Les conditions de passage vers

le nouveau matériel sont évidem-ment dictées en premier lieu par le souci de minimiser autant que faire se peut les désagréments pour les usagers; toutefois, compte tenu des considérations exposées ci-dessus, le scénario retenu, et selon le calendrier présenté, justifie les déroulements suivants:Etape 1: arrêt du Pascal, génération

et installation sur le M94 du système d’exploitation Unicos 7.C.3 (semblable à celui tour-nant actuellement sur Pascal, mais permettant en plus le

our l’automne et une partie de l’hiver prochain, de grandes manoeu-vres sont annoncées, visant à l‘arrêt de Cray-2 et à l'extension de Pascal/YMP en un YMP M94. L’article précédent décrit le contexte et la planification envisagés pour la mise en place des nouvelles configurations. La mise en exploitation du M94 est ainsi prévue dès

la première quinzaine du mois de décembre.Le maximum sera fait pour que le passage sur les nouveaux matériels

se fasse de façon aussi transparente que possible. La complexité de la situation (remplacement de 2 environnements par un seul) est telle que toutefois l’usager devra lui-même prendre en charge une certaine partie des opérations. Une interruption du service du Pascal/Y-MP de une à deux semaines au maximum est néanmoins inévitable, afin de faciliter la mise en place de son extension le M94. Pendant toute cette période, le Cray-2 restera en service, et sera arrêté en dernier, juste après que sa propre migration vers le M94 soit effectuée. Pendant les dernières heures de fonctionnement du Cray-2 (2 à 3 semaines au plus après la mise en exploitation du M94), l’ensemble des opérations de déménagement des équipements et de transfert des comptes nécessaires à la mise en place complète du M94 devront être terminées.

FI édition spéciale 9.11.93 – 1� –

raccordement du futur système Cray MPP/T3D), transfert des comptes et fichiers utilisateurs de Pascal vers le M94. Cette opération est censée être rela-tivement rapide et en principe totalement transparente;

Etape 2: mise en place de DMF sur M94; transfert du reliquat des fichiers du Cray-2 vers le M94, prise en charge immédiate de ceux-ci par le système DMF du M94 (opération nécessaire compte tenu de la relative faible capacité disque disponible du moment), puis raccordement au M94 du système disque DS40 du Cray-2 après remise à neuf et doublement de sa capacité. Cette opération sera toutefois facilitée par l’adjonction d’office de disques supplémentaires prévus dès la mise en route du M94.

Les modalités techniques de l’étape 2) ne sont encore pas toutes arrêtées; plusieurs solutions possibles sont en cours d’examen; le cas échéant, une information complémentaire sera publiée dans le message du jour du Cray-2.

Les fichiers des usagers archivés sur le serveur de fichiers Nestor ne sont pas concernés par l’ensemble de l’opération de transfert: ces mê-mes fichiers resteront accessibles par ftp ou nfs depuis le M94. La mise à jour de certains pointeurs (soft link au sens Unix) lors du passage sur M94 ne peut toutefois être totale-ment garantie.

transfert dePuis Pas-caL/Y-MP vers Le M94

Le transfert des fichiers, envi-ronnements et applications depuis Pascal vers le M94 sera réalisé simplement par le rebranchement du sous-système disque DE60 de Pascal au nouveau matériel. Les usagers de Pascal retrouveront donc très rapide-ment leurs fichiers et environnements de travail sur le M94.

transfert dePuis Le craY-2 vers Le M94

Le cas du Cray-2 est plus compliqué. Les usagers disposant actuellement de comptes sur Cray-2 et Pascal/Y-MP sont invités à transférer eux-mêmes leurs fichiers du Cray-2 vers Pascal, y compris ceux migrés sur le système DMF du Cray-2. Ces transferts peuvent s’effectuer soit par nfs, soit par ftp (ce dernier étant recommandé pour les très gros fichiers), après une remise en ligne (commande dmget) si nécessaire. En cas de problème particulier et sur demande, une aide peut être apportée par le SIC. Pour les usagers qui n’auront pas eu la possibilité matérielle d’effectuer ces transferts avant le départ du Cray-2, une procédure de «rattrapage» est prévue.

En raison du fait que les fichiers binaires exécutables ne sont pas compatibles entre Cray-2 et M94, les usagers, avant toute opération de transfert, sont priés d’éliminer dès maintenant sur Cray-2 tous les fichiers de type *.o et autres codes exécutables, ainsi que tous les autres fichiers sans utilité prévisible sur la nouvelle machine (et en particulier tous ceux migrés sur le système DMF du Cray-2). Pour les fichiers de données en code binaire, les usagers sont dès maintenant invités à vérifier sur le Pascal leur compatibilité avec le M94.

Sans que cela soit absolument garanti pour l’instant, les fichiers de données binaires sur cartou-ches écrits sur Cray-2 en principe peuvent être relus sur le M94, pour autant que ces fichiers n’aient pas été créés selon des particularités propres au Cray-2 (type pure data Cray-2 par exemple). Pour pallier à toute éventualité, les usagers sont invités le cas échéant à vérifier dès maintenant que la relecture de ces données écrites depuis Cray-2 est possible sur le Pascal.

Les possibilités d’accès au Cray-2 depuis le monde DEC/VMS par le logiciel frontal (station VMS) ne sont pas reconduites pour le

M94. En conséquence, les accès remote en mode batch à destination du M94 ne deviennent possibles que par la mise en place de la plate-forme NQS. Les accès NQS éloignés nécessitent la mise en place du logiciel NQS sur toute station Unix cliente désireuse de soumettre des travaux batch sur le M94; le logiciel (version SIC compatible avec Cray/Unicos) est gratuit, et est installé par ses soins sur simple demande de toute personne intéressée. Les accès aux services informatiques de l’ETHZ, actuellement encore possibles par la station VMS du SIC, devront passer également par la plate-forme NQS dès l’arrêt du Cray-2.

Dans ses grandes lignes, la configuration d’exploitation du M94 sera similaire à celles du Cray-2 et du Pascal réunis: accès interactif possible par mot de passe, (sup-pression des cartes SecurID), plate-forme NQS, dont les classes seront reconfigurées pour tenir compte de la grande mémoire du M94 (4 Gby-tes, donc 2 fois celle du Cray-2), disponibilité de DMF, de Nestor, du robot STK et de ses cartouches, quotas, etc. La configuration disque sera toutefois considérablement augmentée, notamment en prévision de la mise en place prochaine du système massivement parallèle T3D de Cray Research.

vers La Mise en PLace du sYstèMe MPP/t3d et de unicos 8

Avec la mise en place d’une machine à architecture massivement parallèle, un passage rapide vers Unicos 8 se révélera probablement nécessaire: cela sera réalisé au cours du premier trimestre de l’année 1994. La version 7.C.3 d’Unicos, qui sera installée lors de la mise en route du M94, est à considérer comme un système d’exploitation de transition, dont le support par CRI est limité dans le temps, car supprimé dès que la version Unicos 8.x sera disponible chez le fournisseur. L’ac-cès au MPP sera réalisé et contrôlé

grandes manœuvres d’automne et d'hiver

FI édition spéciale 9.11.93 – 13 –

par la mise en place de classes NQS appropriées, à destination du T3D. Selon ce projet, le M94 devient frontal du système MPP/T3D, ce qui exige des ressources supplémentaires en espace disque. A cette occasion, et dès le début de 1994, la mise en place d’une nouvelle génération de disques à très grande capacité (DA-301) est prévue. La configuration globale devrait approcher les 100 Gbytes à long terme, avec des taux de transfert variant de 10 à plus de 30 Megabytes/sec selon le type d’ensemble de disques.concLusions

La fin de l’année 1993 sera donc une période chargée: remplacement

de 2 ordinateurs par un successeur unique, importants travaux d’infras-tructure, mise en place progressive par étapes d’une configuration complète du M94, transfert des comptes, des environnements utili-sateurs et des applications, beta-test éventuellement possible (mais peu probable) pour Unicos 8. Le scéna-rio retenu autorise une production continue sur l’une ou l’autre des 2 machines pendant la période des transferts. La période la plus difficile sera sans nul doute le début du M94 (décembre 1993), qui verra la jonction effective des usagers du Cray-2 et du Pascal/Y-MP sur une seule machine.

En dépit de toutes les précautions prises, l’ensemble des opération de

changement de matériel et des sys-tèmes est prévu pour réduire autant que possible les désagréments auprès de nos usagers, dont nous espérons qu’ils pourront travailler dans les meilleures conditions dès la nouvelle année.

Jean-Michel Chenais, SIC-SE& 021.693 22 03E-mail: [email protected] n

grandes manœuvres d’automne et d'hiver

Un message par E-mail, c’est si facile!

Utilisateurs de Cray-�, ceci peut vous intéres-ser

par Marie-Christine sawley, [email protected], & 021.693.2242, siC-assistanCe

Un petit schéma pour vous indiquer les actions à prendre:

Vous travaillez pour l'EPFL, l'ETHZ ou le PSI? non

Vous avez un compte sur

Pascal?

non

oui

Vous demandez l'ouvertured'un compte sur Pascal

dès à présent

Vous souhaitez un compte sur Pascal

M-94?

nonVous nous informezdès à présent

oui

Vous devez transférervotre environnement de

Cray-2 sur Pascald'ici au 15 décembre

Vous devez faire unedemande à la

Direction de l'EPFL

Dans tous les cas, nous sommes là pour vous informer et vous aider. Vous pouvez contacter

l'équipe d'assistance lors de cette opération d'arrêt de Cray-2 en

vous adressant à: [email protected].

oui

FI édition spéciale 9.11.93 – 1� –

Pourquoiune architecture MIMD

pour le Grand Challenge?par Jean-JaCques duMont, siC-logiCiels

l’origine, le terme «massivement parallèle» était réservé à des architectures comportant plus de 1K PE (c-à-d. plus de mille

mais impliquant de petites quantités de données) et la bande passante (important pour les communications peu fréquentes mais impliquent de grandes quantités de données). Elle permet également de traiter correctement les problèmes de syn-chronisation rapide entre les diverses tâches (broadcast, barrières…).

Selon la granularité de l’ap-plication, il sera possible avec l’architecture MIMD d’utiliser alter-nativement ou simultanément des modèles de programmation de types différents :• «message passing» explicite, pour

lequel la mémoire reste visiblement distribuée

• «data/work sharing», pour lequel la mémoire est physiquement distribuée mais logiquement par-tagée (c-à-d. que chaque PE peut adresser directement la mémoire physiquement attachée aux autres PE comme si elle était locale, sans instruction explicite)

• -data parallel» (alias SIMD) si les primitives de synchronisation hard-ware nécessaires sont également fournies (ce qui est le cas du T3D de CRAY).n

tâches. D’où gros problèmes de conflits d’accès au bus et à la mémoire,

• on voit que même dans ce cas extrême, l’architecture MIMD, à mémoire physiquement distribuée, est supérieure, car elle minimise les coûts d’infrastructure et permet une plus grande souplesse dans les configurations («scalability»)

Les applications numériques de type «grand challenge» (CFD, biolo-gie moléculaire, chimie quantique, physique des plasmas, modélisa-tion du climat) exigent beaucoup plus de variété dans les modèles de programmation, tout en restant aussi gourmandes par rapport aux performances. Notamment, elles comportent des parties scalaires et vectorielles autant que parallèles. Il faut donc que les tâches puissent être découpées et distribuées de façon hétérogène si l’on veut éviter les pièges de la loi d’Amdhal. Ce type de distribution n’est possible que sur des architectures de type MIMD. Au niveau des PEs, il est nécessaire de disposer d’opérations arithmétiques sur 64 bits, ce qui en limite forcément le nombre. De ce fait, et en fonction de la mode, on appelle aujourd’hui «massivement parallèle» ou MPP toute machine disposant de plus de 64 proces-seurs, même si cette terminologie est quelque peu abusive.

Pour tous les autres types d’appli-cation, entrent en jeu les problèmes d’efficacité de communication à lon-gue ou courte distance. A nouveau, seule l’architecture MIMD permet d’optimiser la latence (important pour les communications fréquentes

Processing Elements). On parlait donc soit de processeurs très simples, avec peu d’instructions

opérant sur un petit nombre de bits (exemples : CM-2, ASP), soit de «array processors» fonctionnant en mode SIMD (Simple Instruction Multiple Data, exemple : DAP). Ce type d’architecture ne peut toutefois être efficace que pour certains ty-pes d’applications à parallélisme homogène : réseau de neurones, automates cellulaires, traitement de signaux en temps réel…

Certaines applications, dites «embarassingly parallel», deman-dent seulement de la puissance de calcul et ne comportent que peu ou pas de communication entre les tâches (exemple : méthodes de Monte-Carlo en physique). Ces applications peuvent s’exécuter plus ou moins efficacement sur des réseaux de stations interconnectées par Ethernet ou FDDI, voire sur des serveurs multiprocesseurs si le maté-riel existe déjà et est inutilisé. Le choix d’acquérir de telles configurations en vue de les dédier à ces applications ne serait toutefois pas optimal pour les raisons suivantes :• un réseau de stations («computer

farms») revient forcément plus cher que l’équivalent sous forme de PEs assemblés dans la même boîte, sans multiplication inutile des couches matérielles et logi-cielles (disques, alimentations, interfaces, OS...),

• dans le cas du serveur multipro-cesseur, la mémoire doit être gigantesque (donc très coûteuse) et partagée entre les diverses

FI édition spéciale 9.11.93 – 1� –

Les � «Grand Challenges» de l’EPFL

par Marie-Christine sawley, siC-assistanCe

Les interviews de Jean-Jacques Paltenghi et de Gilbert Lauber ont présenté la collaboration CRAY-EPFL ainsi que le système massivement parallèle T3D. Mais, en fait, pour quel type de problèmes un tel système est-il adapté? Une courte description des 4 projets pilotes nous permet d’évoquer l’intérêt potentiel important pour nombre d’autres groupes de l’EPFL ou avec lesquels elle entretient d’étroites relations tant sur le plan académique qu’industriel.

Le MassiveMent ParaLLèLe, Pourquoi?

Dans un environnement où les sciences de l’ingénieur sont largement représentées comme à l’EPFL, les besoins en simulation numérique avancée sont variés. Parmi les disciplines consommant de grandes ressources en infor-matique, on peut distinguer 3 catégories:z celles qui sont peu consommatrices d’applications toutes

faites, pour lesquelles le développement spécialisé est l’objet même de la recherche,

z celles qui sont peu consommatrices d’applications toutes faites, pour lesquelles le développement de programmes spécifiques est indispensable mais ne constitue pas une fin en soi: ce qui est investi dans ce développement doit être rentabilisé par une production soutenue sur des outils puissants et robustes,

z celles qui sont grandes consommatrices d’applications commerciales ou de progiciels (logiciels program-mables), pour lesquelles l’investissement pour le déve-loppement reste modeste.Les disciplines faisant largement usage de la simulation

numérique se rangent plutôt parmi les deux premières catégories: le développement ad hoc joue un rôle très important. Si la simulation numérique s’impose de plus en plus comme le fameux troisième pilier de la recherche, il existe toutefois encore des problèmes que les machines actuelles ne permettent pas d’aborder, (en raison de leur complexité ou de leur taille) couramment connus sous le terme de «Grands Challenges». Citons par exemple la compréhension des écoulements turbulents ou hyper-soniques faisant intervenir des nombreuses réactions chimiques, les écosystèmes globaux, le déchiffrement du génome humain, etc.

Plusieurs rapports d’experts (Rapports Rubbia, etc.) ont ces dernières années confirmé que pour s’attaquer à ces problèmes particulièrement coriaces, il fallait se tourner vers les nouvelles possibilités offertes par les machines parallèles. Parmi les différentes architectures, une machine telle que le T3D, à mémoire distribuée et MIMD, semble bien adaptée à ce type d’applications

(cf: «Pourquoi une architecture MIMD pour le grand challenge?» de J.-J. Dumont ci-contre).

Notons enfin que certains groupes de l’EPFL ont co-mmencé au cours de ces dernières années à acquérir de l’expérience sur des architectures moyennement et massivement parallèles. La liste suivante donne un aperçu de ce qui s’est fait dans ce domaine à l’Ecole mais n’est bien sûr pas exhaustive: HyperCube au LSE/DI, Transputers au LSP/DI, projet MPPC au LTS/DE, Music (de l’ETHZ) au CRPP; différentes plates-formes testées par l’IMHEF/DME, dont une CM-2 et un Maspar, prêtées au SIC en 1991.

Les 4 aPPLications PiLotes de L’ePfL

La stratégie choisie pour aborder l’ère du massivement parallèle est d’identifier quelques applications locomoti-ves qui peuvent, de par les techniques utilisées, aider à la diffusion de l’expertise sur ce type de machines vers d’autres disciplines. A l’EPFL, parmi les instituts ayant une grande expertise en matière de simulation, 4 ont proposé des projets qui sont les pilotes pour la phase de démarrage. Il s’agit du Centre en Recherches de Physique des Plasmas (CRPP), de l’Institut de Mécanique des Fluides et de Machines Hydrauliques (IMHEF), de l’Institut Romand de Recherches en Matériaux (IRRMA) et du Laboratoire de Traitement des Signaux (LTS).

Mécanique des Fluides nuMérique (cFd)

Dans la compréhension de phénomènes aussi com-plexes que la combustion ou les écoulements turbulents, on ne peut pour le moment simuler avec précision que des modèles comportant une réalité physique en 2-D ou des modèles très simples en 3-D. La plupart des experts s’accordent à penser qu’il faudrait un saut en perfor-mances de l’ordre de 1000 (on passe du domaine des MFlops au GF voire TF) pour aborder la résolution des problèmes 3D instationnaires (écoulements dépendants du temps) en géométries complexes.

Au cours des 15 dernières années, les dévelop-pements algorithmiques en CFD ont exploité les deux caractéristiques suivantes: d’une part la possibilité de traiter des régions disjointes dans l’espace comme pratiquement découplées; ceci qualifie la CFD comme un domaine particulièrement bien adapté au calcul mas-sivement parallèle à mémoire distribuée. D’autre part, il existe souvent de très petites régions dans lesquelles les grandeurs physiques présentent de forts gradients nécessitant un maillage très fin. Le calcul massivement

FI édition spéciale 9.11.93 – 1� –

parallèle se prête également au traitement simultané de ces petites régions et de l‘écoulement global pour autant que la répartition des données entre processeurs se fasse correctement.

Les problèmes de CFD pour lesquels l’IMHEF a acquis une renommée internationale sont: écoulement dans les turbines et pompes hydrauliques, simulation directe d‘écoulements turbulents, mélange de fluides dans des réacteurs chimiques, calcul d’écoulements pour l’aéro-nautique et l’aérospatiale.

Représentation du champ de pression de l'eau s'écoulant entre 2 aubes d'une turbine Francis

(doc. IMHEF)

À Physique des PlasMasEn Physique des Plasmas les simulations dans le do-

maine de la fusion jusqu’à présent faisaient largement usage de la MHD (magnéto-hydro-dynamique, modèle fluide), qui ont permis de faire des avancées considéra-bles. Toutefois, les vitesses de transport de la chaleur et des particules sont aujourd’hui encore inexpliquées et beaucoup plus élevées que ne le prédit la théorie simple. Comme c’est ce transport qui détermine la taille minimale que doit avoir un plasma pour pouvoir s’allumer, il est important d’étudier ce problème, dont on pense qu’il est dû à des phénomènes turbulents intervenant à une échelle spatio-temporelle beaucoup plus fine que celles de la MHD, ce qui exige une puissance de calcul de l’ordre de 100 à 1000 fois supérieure à celle existante.

Le CRPP a été un des pionniers dans le domaine de la simulation numérique des plasmas, et le fait que ses

chercheurs aient pu travailler sur des installations à très haute puissance à l’EPFL leur a permis de se maintenir au premier plan. Ces dernières années les activités numéri-ques se sont étendues à de nouveaux projets comme la simulation des différents éléments d’un gyrotron (source d’ondes millimétriques à haute fréquence) utilisés pour le chauffage des plasmas.

Mouvement de 9 particules dans une machine à fusion (par exemple Tokamak TCV de l'EPFL à Ecublens).

Sur l'ordinateur Cray T3D on simulera 10 millions de particules (doc. CRPP)

À Physique de la Matière condensée et dynaMique Moléculaire

En Dynamique Moléculaire, la complexité des calculs est directement reliée à la complexité du modèle choisi pour représenter le potentiel interatomique. Les méthodes ab initio –qui permettent de calculer à la fois la structure électronique et les trajectoires atomiques– ont ouvert la voie à des simulations réalistes des matériaux. Avec l’émergence de moyens de calcul offrant des performances en production de l’ordre du TeraFlop/s, on peut espérer modéliser de façon réaliste des phénomènes tels que for-mation d‘interfaces, nucléation, ou solution de molécules. Les limitations existent pourtant, car le coût du calcul croît avec le cube du nombre d’atomes considérés. De plus, la description de certains éléments tels que les métaux de transition impliquent des calculs très intensifs.

Certains groupes, dont celui de l’IRRMA, développent de nouvelles méthodes visant à réduire le coût de la simu-lation de grands systèmes, et à étendre leurs domaines d'application à tous les éléments. En particulier, un nouvel algorithme a permis de reformuler le problème électronique de façon à ce que l‘effort de calcul dépende linéairement du nombre d'atomes considérés. Ces nouvelles approches

Les appLications cLientes du t3d

FI édition spéciale 9.11.93 – 1� –

se prêtent particulièrement bien au parallélisme massif, pour lequel le gain de performances est immédiatement réinvesti au profit d’études de systèmes plus complexes. Ces nouveaux développements ouvriront la voie à des modélisations microscopiques de processus tels que la propagation de fissures, l’adhésion ou le frottement entre surfaces de matériaux différents, ou encore des composants biologiques.

Le carbone amorphe hydrogéné est un exemple de nouveau matériau qui combine la dureté et la stabilité

chimique du diamant à un faible coût de production. Ce modèle de structure microscopique obtenu par simulation

numérique ab initio permet d'étudier les liaisons chimiques entre les atomes d'hydrogène (rouge) et de

carbone (gris, bleu, vert).(doc. IRRMA)

À traiteMent des signauxLe LTS s’intéresse depuis plusieurs années au do-

maine du multimédia, au développement très rapide. Les applications intéressant les industriels et professionnels des télécommunications sont nombreuses et en rapide multiplication. Ce volet d’activités au potentiel encore largement inexploré est en pleine expansion.

Le domaine de la télévision haute définition, dans lequel le LTS est un des acteurs sur la scène mondiale, nécessite des méthodes de compression/décompres-sion très efficaces. Les algorithmes développés sont fort gourmands en temps calcul et le traitement séquentiel n’est pas adapté. Le LTS travaille depuis 88 sur le mas-sivement parallèle, essentiellement sur une architecture SIMD nommée ASP, dont le développement matériel est assuré par une société aux USA.

Une machine MIMD à mémoire distribuée, puissante, dont le logiciel serait développé en collaboration avec le constructeur, donnerait une impulsion décisive aux travaux du LTS.

TITLE:

CREATOR:

CR DATE:

Traitement de l‘image pour haute compression d‘information en utilisant des ondelettes (doc. LTS)

qu’en est-iL du 5èMe défi?

Il y a une dizaine d’années, les concepts de la vec-torisation se sont diffusés et ont quelque peu modifié la manière de développer du code. Cette transition s’est effectuée sans trop de problèmes aussi par le fait que des compilateurs ont pris en charge, avec succès, une partie de l’optimisation. Quelques techniques assez simples permettaient de compléter le bagage minimal du programmeur averti.

Avec le massivement parallèle, la transition envisagée est bien plus importante: il s’agit d’une véritable révolu-tion, avec tout ce que cela comporte de nouveauté et de défi. Défi car on doit abandonnner toute une culture séquentielle, connue, éprouvée, certes, mais désormais limitée, au profit de nouveaux modèles de programmation (comme la parallélisation des données, des tâches ou l’échanges de messages) qui doivent être compris, testés et assimilés avant d’obtenir les performances espérées. Le savoir-faire du développeur devient la pierre angulaire de l’aventure massivement parallèle.

Un groupe multidisciplinaire, formé de collaborateurs de l’EPFL et de CRAY, sera constitué pour prendre en charge les fonctions communes aux applications pilote. On peut citer par exemple l’expertise en programmation parallèle et en algorithmique, la visualisation, le test de nouveaux produits, la formation. Ce groupe offrirait un support pour le démarrage de nouveaux projets et se verrait confier la mission de diffuser le savoir-faire -en s’appuyant sur les compétences des chercheurs et du constructeur- et de stimuler des synergies internes et externes à l’EPFL.

Parmi les disciplines qui pourront tirer profit de ressources offertes par une machine MIMD à mémoire

Les appLications cLientes du t3d

FI édition spéciale 9.11.93 – 1� –

distribuée, on peut aujourd’hui citer la physique du so-lide, les sciences des matériaux, le calcul des structures, les réseaux et les systèmes de communications, l’accès aux banques de données, la mécanique des fluides, la chimie, la géophysique et la sismique, la physique des plasmas, le traitement de signaux et la synthèse d’images, les applications en biologie moléculaire, les problèmes environnementaux (pollution atmosphérique, des eaux et du sol), etc. Remarquons que cette énumération couvre à peu de choses près l’ensemble des départements de l’Ecole, d’où un intérêt potentiel considérable. De part les étroites relations que ces disciplines entretiennent avec de nombreux domaines industriels, le monde de la production commence à s’intéresser également de très près à ces techniques.

L’environnement logiciel disponible sur le T3D dès à présent et d’ici au premier semestre 94 est donné plus bas.

sYnthèse des objectifs visés

En résumé, il s’agit de:Àdévelopper ou adapter en collaboration avec CRAY des

applications existantes à l’architecture massivement parallèle T3D. Parvenir à un niveau d’expertise pour pouvoir atteindre les objectifs suivants (2 à 5),

À développer les échanges avec les autres centres PATP dans les disciplines où l’EPFL peut jouer un rôle actif de partenaire,

À identifier, stimuler, intégrer d’autres groupes faisant de la simulation nécessitant d’importants moyens de calcul à l’EPFL; donner de l’impulsion à certaines disciplines

pouvant bénéficier de ces moyens de calcul,√rechercher des synergies avec les industriels potentiel-

lement intéressés à ces techniques,Àformer des ingénieurs en techniques de calcul massive-

ment parallèle (3ème cycle).Il s’agit d’un projet comprenant plusieurs composan-

tes: dans un premier temps, la composante recherche et développement d’expertise est prioritaire (objectifs 1 et 2) . Dans une seconde phase intervient une composante de production et rentabilité: les codes fonctionnent et produisent des résultats, l’intérêt de l’industrie est recher-ché, les experts forment d’autres personnes (objectifs 3 et 4). L’enseignement peut être impliqué à plus long terme (objectif 5).

A long terme et à maturité des applications et de la technologie MPP, il est envisageable de prévoir un grand système de production «massivement parallèle» national, en tenant compte des expériences des divers projets similaires dans les autres Hautes Ecoles (ETHZ, CSCS,…). Chaque projet progressant avec du matériel différent (axe européen, américain, japonais) et permet-tant ainsi aux groupes de recherche MPP un accès aux autres moyens MPP que les leurs, afin de leur permettre des comparaisons et de rechercher la meilleure solution parmi un choix de technologies différentes pour du mas-sivement parallèle. Cette expertise serait très utile pour les choix futurs au niveau national. n

Note: l’auteur voudrait remercier les Profs. Car, Deville, Kunt, Monkewitz et Troyon pour la relecture critique de la description de leur domaine respectif.

Environnement logiciel du T3D

Les appLications cLientes du t3d

FI édition spéciale 9.11.93 – 19 –

EDITI

ON SPEC

IALE

Modifications du cluster Vax

par MiChel Jaunin, siC-exploitation

Le cluster Vax, basé sur 2 DEC Vax 6310, est éga-lement un système coûteux à maintenir. De nombreux services remplis par ce système ces dernières années ont été transférés récemment sur d’autres plateformes plus simples à entretenir. Parmi les derniers services à la communauté des utilisateurs qui restent encore actifs sur le cluster, il faut mentionner en particulier la station VMS pour accéder au Cray 2 et une station remote pour accéder au Y-MP de l’ETHZ. Avec l’arrêt du Cray 2, la station VMS locale perd sa raison d’être. Parallèlement aux stations VMS, les outils NQS disponibles sur les pla-teformes Unix permettent aussi la soumission à distance de travaux batch aux serveurs de l’EPFL, de l’ETHZ et du CSCS-Manno; ils sont déjà les seuls moyens d’accéder au serveur Pascal.

Le cluster sous sa forme actuelle sera mis hors service après l’arrêt du Cray 2 et après la mise en service du système qui le remplace pour les quelques fonctions résiduelles. La date précise ne peut donc être donnée actuellement. Les quelques applications et services restants seront alors pris en charge par une station DEC 3000 AXP modèle 400S. Les détails de l’opération non spé-cifiques aux stations Cray seront décrits dans un article à paraître dans un prochain Flash Informatique.

La station VMS remote sur l’installation Y-MP de l’ETHZ sera donc supprimée simultanément à l’arrêt du cluster actuel, et les utilisateurs lausannois de ce mode d’accès devront dès lors soumettre leurs travaux à Zurich par le système NQS disponible sur les stations de travail Unix ou sur Pascal, de la même manière qu’ils l’utilisent pour soumettre des travaux sur Pascal actuel - et l’utiliseront sur Pascal M94. Tout renseignement relatif à NQS, à son installation sur une station et à la façon d’accéder au Y-MP de l’ETHZ est à adresser à M. J-M. Chenais (693 22 03, [email protected]). n

SOMMAIRE

EditorialMarie-Christine Sawley 2

Le massivement parallèle, quel enjeu pour l‘EPFL?Interview de J.-J. PaltenghiMarie-Christine Sawley 3

La stratégie pour le calcul massivement parallèle chez CrayInterview de G. LauberMarie-Christine Sawley 6

Arrêt du Cray-2 — Extension de PascalMichel Jaunin 9

Planification des opérationsMichel Jaunin 9

Grandes manœuvres d'automne et d'hiverMigration des comptes et environnements des ordinateurs Cray-2 et Pascal/YMP vers Pascal/M94Jean-Michel Chenais 11

Un message par E-mail, c'est si facile!Utilisateurs de Cray-2, ceci peut vous intéresserMarie-Christine Sawley 13

Pourquoi une architecture MIMD, pour le Grand Chal-lenge?Jean-Jacques Dumont 14

Les 5 «Grand Challenges» de l‘EPFLMarie-Christine Sawley 15

Environnement logiciel du T3DMarie-Christine Sawley 18

Modification du cluster du VaxMichel Jaunin 19

Flash informatiqueLes articles de ce journal ne reflètent que l’opinion de leurs auteurs. toute reproduction, même partielle, n’est autorisée qu’avec l’accord de la rédaction et des auteurs.

rédacteur en chef: M.-c. sawley comité de rédaction: j.-d. bonjour, j.-M. che-

nais, M. crvcanin, j. dousson, P.-a. haldy, j.-P. Moinat, P.-j. Paris, f. roulet, ch. simm & j. virchaux

composition: a. raposo de barbosa

impression: reProtirage: 4000 exemplairesadresse: sic-sa ePfL 1015 – Lausanne & 021/693 22 42 & 22 47

FI édition spéciale 9.11.93 – �0 –

E DI T I O

N

S P E C I AL E