clusteringBeamer(1)

Transcript of clusteringBeamer(1)

Introduction Problématiques Méthodes de clustering

Clustering

Gilles Gasso - Philippe LERAY

INSA Rouen - Département ASILaboratoire LITIS

15 février 2013

Gilles Gasso - Philippe LERAY Clustering 1 / 76

Introduction Problématiques Méthodes de clustering

Plan

IntroductionProblématiques

Similarité et proximitéQualité des clusters

Méthodes de clusteringCHA

PrincipeMétriqueUne variante du CHA : CHAMELEON

K-meansPrincipeAlgorithmeVariantes

Mélange de gaussiennesExemple : mélange de deux gaussiennesEstimation de paramètres par max de la log-vraisemblanceAlgorithme EM (Expectation-Maximization)

Gilles Gasso - Philippe LERAY Clustering 2 / 76

Introduction Problématiques Méthodes de clustering

Introduction

Objectifs

I D = {xi ∈ Rd}Ni=1 : ensemble de points décrit par d attributs.

I But : structuration des données en classes homogènesOn cherche à regrouper les points en clusters ou classes telsque les données d’un cluster soient les plus similaires possibles

I Clustering ≡ apprentissage non supervisé. C’est une techniqued’exploration des données servant à résumer les informationssur les données ou à déterminer des liens entre les points.

Exemples de classes

Gilles Gasso - Philippe LERAY Clustering 3 / 76

Introduction Problématiques Méthodes de clustering

Introduction

Domaines d’application

Domaine Forme des données ClustersText mining Textes Textes proches

Mails Dossiers automatiquesWeb mining Textes et images Pages web prochesBioInformatique Gènes Gènes ressemblantsMarketing Infos clients, Segmentation

produits achetés de la clientèleSegmentation Images Zones homogènesd’images dans l’imageWeb log analysis Clickstream Profils utilisateurs

Gilles Gasso - Philippe LERAY Clustering 4 / 76

Introduction Problématiques Méthodes de clustering Similarité et proximité Qualité des clusters

Problématiques

I Nature des observations : Données binaires, textuelles,numériques, arbres, ... ?

I Notion de similarité (ou de dissimilarité) entre observations

I Définition d’un cluster

I Evaluation de la validité d’un cluster

I Nombre de clusters pouvant être identifiés dans les données

I Quels algorithmes de clustering ?

I Comparaison de différents résultats de clustering

Gilles Gasso - Philippe LERAY Clustering 5 / 76

Introduction Problématiques Méthodes de clustering Similarité et proximité Qualité des clusters

Notions de similarité

VocabulaireI Mesure de dissimilarité DM : plus la mesure est faible plus les

points sont similaires (∼ distance)

I Mesure de similarité SM : plus la mesure est grande, plus lespoints sont similaires

I DM = borne− SM

NotationsI Observation : xi ∈ Rd

avec xi =(xi ,1 xi ,2 · · · xi ,d

)>Gilles Gasso - Philippe LERAY Clustering 6 / 76

Introduction Problématiques Méthodes de clustering Similarité et proximité Qualité des clusters

Notion de proximité

Mesure de la distance D(x1, x2) entre 2 points x1 et x2

I Distance de Minkoswski : D(x1, x2) =(∑d

j=1 |x1,j − x2,j |q) 1

q

I Distance Euclidienne correspond à q = 2 :

D(x1, x2) =√∑d

j=1 (x1,j − x2,j)2 =√

(x1 − x2)t(x1 − x2)

I Distance de Manhattan (q = 1) :D(x1, x2) =

∑dj=1 |x1,j − x2,j |

I Distance de Sebestyen :D2(x1, x2) = (x1 − x2)>W (x1 − x2)(W= matrice diagonale de pondération définie positive)

I Distance de Mahalanobis :D2(x1, x2) = (x1 − x2)>C−1(x1 − x2)(C=matrice de variance-covariance)

Gilles Gasso - Philippe LERAY Clustering 7 / 76

Introduction Problématiques Méthodes de clustering Similarité et proximité Qualité des clusters

Notion de proximité

Mesure de la distance D(x1, x2) entre 2 points x1 et x2 àvaleurs discrètes

I Utiliser une matrice de contingence A(x1, x2) = [aij ]

I x1 =(0 1 2 1 2 1

)> et x2 =(1 0 2 1 0 1

)>I A(x1, x2) =

0 1 01 2 01 0 1

I Distance de Hamming : nombre de places où les 2 vecteurs

diffèrent :

D(x1, x2) =d∑

i=1

d∑j=1,j 6=i

aij

I Distance de Tanimoto, ...Gilles Gasso - Philippe LERAY Clustering 8 / 76

Introduction Problématiques Méthodes de clustering Similarité et proximité Qualité des clusters

Notion de proximité

Mesure de la distance D(C1, C2) entre 2 classes C1 et C2I plus proche voisin :

Dmin(C1, C2) = min {D(xi , xj), xi ∈ C1, xj ∈ C2}

I diamètre maximum :

Dmax(C1, C2) = max {D(xi , xj), xi ∈ C1, xj ∈ C2}

I distance moyenne :

Dmoy(C1, C2) =

∑xi∈C1

∑xj∈C2 D(xi , xj)

n1n2

I distance des centres de gravité : Dcg(C1, C2) = D(µ1, µ2)

I distance de Ward : DWard(C1, C2) =√

n1n2n1+n2

D(µ1, µ2)

I ...Gilles Gasso - Philippe LERAY Clustering 9 / 76

Introduction Problématiques Méthodes de clustering Similarité et proximité Qualité des clusters

Evaluation de la Qualité d’un clustering

Inertie Intra-cluster

I Chaque cluster Ck est caractérisé par

I Son centre de gravité : µk = 1Nk

∑i∈Ck

xi avec Nk = card(Ck)

I Son inertie : Jk =∑

i∈CkD2(xi , µk)

L’inertie d’un cluster mesure la concentration des points ducluster autour du centre de gravité. Plus cette inertie est faible,plus petite est la dispersion des points autour de ce centre

I Sa matrice de variance-covariance :Σk =

∑i∈Ck

(xi − µk)(xi − µk)>

Remarque : on a la propriété suivante Jk = trace(Σk). L’inertied’un cluster représente la variance des points de ce cluster

I Inertie intra-cluster : Jw =∑

k∑

i∈Ck D2(xi , µk) =∑

i∈Ck Jk

Gilles Gasso - Philippe LERAY Clustering 10 / 76

Introduction Problématiques Méthodes de clustering Similarité et proximité Qualité des clusters

Evaluation de la Qualité d’un clustering

Inertie inter-clusterI Soit µ le centre de gravité du nuage de points : µ = 1

N∑

i xi

I Les centres de gravité des clusters forment eux aussi un nuagede points caractérisé par

I Inertie inter-cluster : Jb =∑

k NkD2(µk , µ)

L’inertie inter-cluster mesure "l’éloignement" des centres desclusters entre eux. Plus cette inertie est grande, plus lesclusters sont bien séparés

I Une matrice de covariance inter-cluster :Σb =

∑k(µk − µ)(µk − µ)>

Remarque : Jb = trace(Σb)

Gilles Gasso - Philippe LERAY Clustering 11 / 76

Introduction Problématiques Méthodes de clustering Similarité et proximité Qualité des clusters

Bonne partition

I Illustration (Bisson 2001) :

g

g1

g

g2

g3

g4

C1

C2

C3

C4

Inertie totale des points = Inertie Intra-cluster + Inertie Inter-cluster

Comment obtenir une bonne partition ?Il faut minimiser l’inertie intra-cluster et maximiser l’inertieinter-cluster

Gilles Gasso - Philippe LERAY Clustering 12 / 76

Introduction Problématiques Méthodes de clustering Similarité et proximité Qualité des clusters

Bonne partition

I Illustration (Bisson 2001) :

g1 g2

Forte inertie inter-classes

Faible inertie intra-classes

g3

g4

Faible inertie inter-classes

Forte inertie intra-classes

Gilles Gasso - Philippe LERAY Clustering 13 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Approches de clustering

I Différentes approches sont possibles

I Clustering hiérachiqueI Clustering hiérarchique ascendant (CHA) et variantesI Clustering hiérarchique descendant

I Clustering par partitionnementI Algorithme des K-moyennes et variantesI Clustering flouI Clustering spectralI ...

I Clustering par modélisationI Notion de modèles de mélangeI Algorithmes EM et variantes

Gilles Gasso - Philippe LERAY Clustering 14 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

CHA - principe

PrincipeChaque point ou cluster est progressivement "absorbé" par lecluster le plus proche.

Algorithme

I Initialisation :I Chaque individu est placé dans son propre cluster,I Calcul de la matrice de ressemblance M entre chaque couple

de clusters (ici les points)I Répéter

I Sélection dans M des deux clusters les plus proches CI et CJI Fusion de CI et CJ pour former un cluster CGI Mise à jour de M en calculant la ressemblance entre CG et les

clusters existants

I Jusqu’à la fusion des 2 derniers clustersGilles Gasso - Philippe LERAY Clustering 15 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

CHA : principe

I Exemple (Bisson 2001)

Hiérarchie(indicée)

C10

C1

C6

C5

C4

C3

C2

C9

C8

C7

C1C2

C3

C4

C5

C6

C8

C10

C7

C9

i

I Schéma du milieu : dendrogramme = représentation desfusions successives

I Hauteur d’un cluster dans le dendrogramme = similarité entreles 2 clusters avant fusion (sauf exception avec certainesmesures de similarité)...

Gilles Gasso - Philippe LERAY Clustering 16 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

CHA : métrique

Problème

Trouver l’ultramétrique (distance entre clusters) la plus proche dela métrique utilisée pour les individus.

I Saut minimal (single linkage) basé sur la distance Dmin(C1, C2)I tendance à produire des classes générales (par effet de

chaînage)

I sensibilité aux individus bruités.

I Saut maximal (complete linkage) basé sur la distanceDmax(C1, C2)

I tendance à produire des classes spécifiques (on ne regroupeque des classes très proches)

I sensibilité aux individus bruités.

Gilles Gasso - Philippe LERAY Clustering 17 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

CHA : métrique

I Saut moyen basé sur la distance Dmoy(C1, C2)I tendance à produire des classes de variance proche

I Barycentre basé sur la distance Dcg(C1, C2)I bonne résistance au bruit

Gilles Gasso - Philippe LERAY Clustering 18 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

CHA : métrique

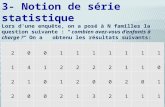

I Illustration : exemple (Bisson 2001)

Données (métrique : dist. Eucl.)

4

3

2

1

043210

A

C

B

E

F

D

Saut minimal

F E A B C D

i

0,5

1,1

0,9

0,7

Saut maximal

C D A B E F

i

0,5

4,0

2,8

1,7

I Pas les mêmes résultats selon la métrique utilisée ...

Gilles Gasso - Philippe LERAY Clustering 19 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

CHA : ASI4 Clustering

I 26 individus d’ASI4, 2003I Données = 5 valeurs 0/1 (inscription en IR, MGPI, DM1, DM2,

TIM)

Saut minimal

BA

RO

CA

ST

CO

RD

BO

NV

PE

SQ

BO

IT

TR

AO

WA

AG

CH

AM

LE

DI

BO

ND

SP

ER

GR

EM

CA

MP

PE

RS

WE

YC

CA

PR

FO

UR

GE

SL

JE

AN

LE

HO

HA

UT

OH

AN

RA

BA

RA

BI

ZE

HN

I Pas moyen de faire desous-groupes, tout lemonde est à une distancede 0 ou 1 des autresclusters.

Gilles Gasso - Philippe LERAY Clustering 20 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

CHA : ASI4 Clustering : saut maximal

BA

RO

CA

ST

CO

RD

GR

EM

RA

BI

ZE

HN

CA

MP

PE

RS

WE

YC

CA

PR

FO

UR

GE

SL

JE

AN

LE

HO

BO

IT

TR

AO

WA

AG

BO

NV

PE

SQ

HA

UT

OH

AN

RA

BA

BO

ND

SP

ER

CH

AM

LE

DI

I En changeant de métrique, on observe plus desous-regroupements

Gilles Gasso - Philippe LERAY Clustering 21 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

CHA : ASI4 Clustering

BA

RO

CA

ST

CO

RD

GR

EM

RA

BI

ZE

HN

CA

MP

PE

RS

WE

YC

CA

PR

FO

UR

GE

SL

JE

AN

LE

HO

BO

IT

TR

AO

WA

AG

BO

NV

PE

SQ

HA

UT

OH

AN

RA

BA

BO

ND

SP

ER

CH

AM

LE

DI

I Pour construire les clusters, on coupe l’arbre à la hauteurvoulue

Gilles Gasso - Philippe LERAY Clustering 22 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

CHA : Autre exemple de saut maximal

0

0.2

0.4

0.6

0.8

1

1.2

1.4

1.6

1.8

Indice des points regroupés

Dis

tan

ce

Dendrogramme

1 4

17

26 6

20

24 3

25

13

21 7 2 8

22 5

14

18

10

16

11

23 9

19

12

15

27

35

40

29

28

36

31

32

39

30

33

34

37

38

Gilles Gasso - Philippe LERAY Clustering 23 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

CHA : Autre exemple de saut maximal

0

0.2

0.4

0.6

0.8

1

1.2

1.4

1.6

1.8

Indice des points regroupés

Dis

tan

ce

Dendrogramme

1 4

17

26 6

20

24 3

25

13

21 7 2 8

22 5

14

18

10

16

11

23 9

19

12

15

27

35

40

29

28

36

31

32

39

30

33

34

37

38

fusion desclusters 7 et 8

1 2 3 4 5 6 7 8 9 10

Gilles Gasso - Philippe LERAY Clustering 24 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

CHA : Autre exemple de saut maximal

10 clusters

cluster 7

cluster 8

fusion desclusters 7 et 8

étape suivante :

Gilles Gasso - Philippe LERAY Clustering 25 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

CHAMELEON

I Une méthode de classification hiérarchique ascendante plusévoluée

I Principe = estimer la densité intra-cluster et inter-cluster àpartir du graphe des k plus proches voisins

données graphe 1-ppv 2-ppv3-ppv

Gilles Gasso - Philippe LERAY Clustering 26 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

CHAMELEON : similarité entre deux clusters

Inter-connectivité

I Inter-connectivité absolue entre 2 clusters :EC (Ci , Cj) = ensemble des points qui relient des nœuds de Ciet de Cj

I Inter-connectivité interne d’un cluster :EC (Ci ) = plus petit ensemble qui partionne Ci en 2sous-clusters de taille proche

I Inter-connectivité relative : RI (Ci , Cj) =2∗|EC(Ci ,Cj )|

|EC(Ci )|+|EC(Cj )|

Gilles Gasso - Philippe LERAY Clustering 27 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

CHAMELEON : similarité entre deux clusters

Proximité

I Proximité absolue entre 2 clusters :EC (Ci , Cj) = distance moyenne entre les points de EC (Ci , Cj)

I Proximité interne d’un cluster :EC (Ci ) = distance moyenne entre les points de EC (Ci )

I Proximité relative : RC (Ci , Cj) =(|Ci |+|Cj |)EC(Ci ,Cj )|Ci |EC(Ci )+|Cj |EC(Cj )

Gilles Gasso - Philippe LERAY Clustering 28 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

CHAMELEON : algorithme

I Deux phases

I Trouver des sous-clusters initiauxI en partitionnant le graphe k-ppv en m partitions "solides" (ou

la distance entre les points est minimisée)

I Fusionner dynamiquement les sous-clustersI en fonction de RI (Ci , Cj ) et RC(Ci , Cj )

Gilles Gasso - Philippe LERAY Clustering 29 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

CHAMELEON : résultats

DS4DS3

DS5

Gilles Gasso - Philippe LERAY Clustering 30 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Complexité

I Classification Hierarchique Ascendante : O(N3)

I Certaines variantes de CHAI CURE : O(n2) en petite dimimension, O(N2 + Nm logN)

sinon (en commençant avec m clusters)

I CHAMELEON :I graphe k-ppv : O(N log N) en petite dim. sinon O(N2)I clustering : O(Nm + N log N + m2 log m)

Gilles Gasso - Philippe LERAY Clustering 31 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Classification Hiérarchique Descendante

I Principe :I Sélection du cluster le moins cohérent

I Subdivision du cluster le moins cohérent

I Problème :I Pour réaliser la subdivision, il faut souvent faire une

classification hierarchique ascendante pour savoir quelle est lameilleure façon de séparer les points

I Algorithme beaucoup moins attractif que l’autre

Gilles Gasso - Philippe LERAY Clustering 32 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Approches de clustering

I Différentes approches sont possibles

I Clustering hiérachiqueI Clustering hiérarchique ascendant (CHA) et variantesI Clustering hiérarchique descendant

I Clustering par partitionnementI Algorithme des K-moyennes et variantesI Clustering flouI Clustering spectralI ...

I Clustering par modélisationI Notion de modèles de mélangeI Algorithmes EM et variantes

Gilles Gasso - Philippe LERAY Clustering 33 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Clustering par partitionnement

Objectifs

I N données D = {xi ∈ Rd}i=1,··· ,N disponibles

I Recherche d’une partition en K < N clusters Ck des données

I Approche directeI Construire toutes les partitions possiblesI Evaluer la qualité de chaque clustering clustering et retenir la

meilleure partition

I Souci : problème NP difficile car le nombre de partitionspossibles augmente exponentiellement

#Clusters =1K !

K∑k=1

(−1)K−kCKk kN

Pour N = 10 et K = 4, on a 34105 partitions possibles !Gilles Gasso - Philippe LERAY Clustering 34 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Clustering par partitionnement

Solution plus pratique

I Minimisation de l’inertie intra-classe

Jw =K∑

k=1

∑i∈Ck

D2(xi , µk)

I Eviter l’énumération exhaustive de toutes les partitionspossibles

I Utilisation d’une approche heuristique donnant au moins unebonne partition et pas nécessairement la partition optimale ausens de Jw

Gilles Gasso - Philippe LERAY Clustering 35 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Clustering par partitionnement

Un algorithme très connu : algorithmes des K-means (oucentres mobiles)

I Si on connait les centres de gravité µk , k = 1, · · · ,K , onaffecte un point xi à un cluster et un seul. Le point est affectéau cluster C` dont le centre µ` est le plus proche

I Connaissant les clusters Ck , k = 1, · · · ,K , on estime leurcentre de gravité

I On alterne ainsi l’affectation des points aux clusters etl’estimation des centres de gravité jusqu’à convergence ducritère

Gilles Gasso - Philippe LERAY Clustering 36 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

K-Means : algorithme

I Initialiser les centres µ1, · · ·µKI Répeter

I Affectation de chaque point à son cluster le plus proche

C` ← xi tel que ` = arg mink

D(xi , µk)

I Recalculer le centre µk de chaque cluster

µk =1

Nk

∑i∈Ck

xi avec Nk = card(Ck)

I Tant que ‖ ∆µ ‖> ε

Complexité : O(KN`) pour ` : itérations

Gilles Gasso - Philippe LERAY Clustering 37 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

K-Means : illustration [S. Roweis, 2003]Clustering en K = 2 classes

Données Initialisation Itération 1

Itération 2 Itération 3 Itération 4

Gilles Gasso - Philippe LERAY Clustering 38 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

K-Means : exemple

K = 2 K = 3

K = 4 K = 5

K = 6 K = 7

Gilles Gasso - Philippe LERAY Clustering 39 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

K-Means : exemple

K = 2 K = 3

K = 4 K = 5

K = 6 K = 7

Gilles Gasso - Philippe LERAY Clustering 40 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

K-Means : exemple

K = 6

Gilles Gasso - Philippe LERAY Clustering 41 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

K-Means : exemple

K = 10

Gilles Gasso - Philippe LERAY Clustering 42 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

K-Means : exemple

K = 10

Gilles Gasso - Philippe LERAY Clustering 43 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

K-Means : Remarques et problèmes

I On montre qu’à chaque itération de l’algorithme le critère Jwdiminue.

I L’algorithme converge au moins vers un minimum local de Jw

I Convergence rapide

I Initialisation des µk :I aléatoirement dans l’intervalle de définition des xi

I aléatoirement dans l’ensemble des xi

I Des initialisations différentes peuvent mener à des clustersdifférents (problèmes de minima locaux)

Gilles Gasso - Philippe LERAY Clustering 44 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

K-Means : Remarques et problèmes

I Méthode générale pour obtenir des clusters "stables" =formes fortes

I On répète l’algorithme r fois

I On regroupe ensemble les xi qui se retrouvent toujours dansles mêmes clusters.

I Choix du nombre de clusters : problème difficile

I Fixé a priori (exple : on veut découper une clientèle en Ksegments)

I Chercher la meilleure partition pour différents K > 1 etchercher "un coude" au niveau de la décroissance de Jw (K )

I Imposer des contraintes sur le volume ou la densité des clustersobtenus

Gilles Gasso - Philippe LERAY Clustering 45 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

K-Means : formes fortes

I Illustration (Bisson 2001) :

x

x

x

x

x

x

x

x

x

x

xx

x

xx

x

x

4 “formes fortes”

C1

C2C’1

C’2

x

x

x

x

x

x

x

x

x

x

x

x

x

xx

x

x

F1

F2

F4

F3

Classifications

Gilles Gasso - Philippe LERAY Clustering 46 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

K-Means : formes fortes

I K-Means répété 6 foisK = 3 K = 3

K = 3 K = 3

K = 3 K = 3

Gilles Gasso - Philippe LERAY Clustering 47 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

K-Means : formes fortes

I On trouve 5 regroupements de points différents :

F1 F2 F3 F4 F5

Ni 2040 1940 49 2042 1929

I F3 n’est pas représentatifI F1, F1, F4 et F5 sont les formes fortesI on peut recalculer les clusters à partir des centres des formes

fortes

Gilles Gasso - Philippe LERAY Clustering 48 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

K-Means : formes fortes

I K-Means répété 6 fois4 Formes fortes pour K = 3

Gilles Gasso - Philippe LERAY Clustering 49 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

K-Means séquentielsAdaptation des K-means lorsque les exemples arrivent au fur et à mesure

I Initialiser µ1, · · ·µKI Initialiser n1, · · · nK à 0I Répeter

I acquérir xI affectation du point au cluster le plus proche

C` ← x tel que ` = arg mink

D(x , µk)

I incrémenter n`I recalculer le centre µ` de ce cluster

µ` = µ` +1n`

(x − µ`)

RemarqueSi on dispose d’une partition initiale, on utilisera les centres desclusters et on initialisera nk = card(Ck), k = 1, · · · ,K

Gilles Gasso - Philippe LERAY Clustering 50 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Variantes de K-means

K-means flousI Ici un point xi peut appartenir à plusieurs clusters !

I Par contre, pour chaque cluster Ck , on lui associe un degréd’appartenance zi ,k tel que 0 ≤ zi ,k ≤ 1 et

∑Kk=1 zi ,k = 1

I On minimise le critère intra-classe suivant

Jw =∑k

N∑i=1

zγi ,kD2(xi , µk) avec γ > 1

γ règle le "degré de flou". Plus γ est grand, plus les clusterstrouvés se recouvrent.

Gilles Gasso - Philippe LERAY Clustering 51 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Variantes de K-means

Nuées Dynamiques (Diday 1972, 1974)

I Généralisation des K-Means

I Utilisation de noyaux = représentation d’un cluster

I barycentre ( = µ pour les K-means)

I n points représentatifs

I HyperplanI ...

Gilles Gasso - Philippe LERAY Clustering 52 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Approches de clustering

I Différentes approches sont possibles

I Clustering hiérachiqueI Clustering hiérarchique ascendant (CHA) et variantesI Clustering hiérarchique descendant

I Clustering par partitionnementI Algorithme des K-moyennes et variantesI Clustering flouI Clustering spectralI ...

I Clustering par modélisationI Notion de modèles de mélangeI Algorithmes EM et variantes

Gilles Gasso - Philippe LERAY Clustering 53 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Clustering par modélisation statistique

Introduction par l’exemple

I Considérons N données {xi ∈ Rd}i=1,··· ,N formant deuxclasses

−3 −2 −1 0 1 2 3 4 5 6−2

−1

0

1

2

3

4

5

6

Données des deux classes

−3 −2 −1 0 1 2 3 4 5 6−2

−1

0

1

2

3

4

5

6

Données des deux classes et contours des classes

I On veut trouver le modèle statistique des données.

I On constate que pour modéliser les données, il faut deuxdistributions gaussiennes

Gilles Gasso - Philippe LERAY Clustering 54 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Clustering par modélisation statistique

Introduction par l’exemple

I Dans la classe 1, les données suivent une loi normaleN (X ;µ1,Σ1) où X désigne une variable aléatoire. Dans laclasse 2, X suit N (X ;µ2,Σ2)

I Loi marginale de X

f (X ) = f (X ,Z = 1) + f (X ,Z = 2)

= f (X/Z = 1)Pr(Z = 1) + f (X/Z = 2)Pr(Z = 2) Th de Bayes

f (X ) = π1f (X/Z = 1) + π2f (X/Z = 2)

avecf (X/Z = 1) ≡ N (X ;µ1,Σ1), f (X/Z = 2) ≡ N (X ;µ2,Σ2)

Z : variable aléatoire (cachée) indiquant la classe du point XGilles Gasso - Philippe LERAY Clustering 55 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Clustering par modélisation statistique

Introduction par l’exemple

I Loi marginale de X

f (X ) = f (X ,Z = 1) + f (X ,Z = 2)

f (X ) = π1f (X/Z = 1) + π2f (X/Z = 2)

I π1 et π2 désignent la probabilité a priori que X relève resp. dela classe C1 et C2. Remarque : on a π1 + π2 = 1

I f (X/Z = 1) et f (X/Z = 2) désignent la densitéconditionnelle de X respectivement à Z = 1 et Z = 2

I f (X ) est entièrement déterminé par la connaissance de πj , µj ,Σj , j ∈ {1, 2}. On l’appelle modèle de mélange de densités

Gilles Gasso - Philippe LERAY Clustering 56 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Modèle de mélange : illustration

I Modèle de mélange gaussien

f (X ) = π1N (X ;µ1,Σ1) + π2N (X ;µ2,Σ2) avec π1 + π2 = 1

−3 −2 −1 0 1 2 3 4 5 6−2

−1

0

1

2

3

4

5

6Données des deux classes et loi sous−jacente

−6 −4 −2 0 2 4 6−5

0

5

0.005

0.01

0.015

0.02

0.025

0.03

0.035

0.04

Loi en 3−D

Gilles Gasso - Philippe LERAY Clustering 57 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Du modèle de mélange au clustering

Intérêt du modèle statistique pour faire du clustering ?

I Si on connait le modèle de mélange, on connait les probabilitésà priori πj et les lois conditionnelles f (X/Z = j), j ∈ {1, 2}

I D’après le théorème de Bayes, on en déduit les probabilités aposteriori d’appartenance du point X = x à C1 et C2

Pr(Z = 1/X = x) =π1f (X = x/Z = 1)

f (X = x)

Pr(Z = 2/X = x) =π2f (X = x/Z = 2)

f (X = x)

I Remarque : on a Pr(Z = 1/X = x) + Pr(Z = 2/X = x) = 1

Gilles Gasso - Philippe LERAY Clustering 58 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Du modèle de mélange au clustering

Affectation des points aux clusters

I Affectation probabiliste

I Le point x est affecté à la classe de plus grande probabilité aposteriori

C1 ← x si Pr(Z = 1/X = x) > Pr(Z = 2/X = x)

C2 ← x sinon

I Ceci se généralise aisément pour K > 2 clusters

Gilles Gasso - Philippe LERAY Clustering 59 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Du modèle de mélange au clustering

Comparaison avec K-means

K-means Approche modélisationModèle - Modèle de mélanges

f (X ) =∑K

k=1 πk f (X/Z = k)

Paramètres Centres des clusters Proba a priori πkà estimer µk , k = 1, · · · ,K Paramètres des lois

f (X/Z = k)

Critère Variance intra-classe Log-VraisemblanceoptimiséIndice d(x , µk) Proba a posteriorid’affectation Pr(Z = k/X = x)

Règle Cluster dont le centre Cluster de plus granded’affectation est le plus proche proba a posterioride x

Gilles Gasso - Philippe LERAY Clustering 60 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Estimation des paramètres du modèle

Retour à l’exemple

I Modèle de mélange gaussienf (X ) = π1N (X ;µ1,Σ1) + π2N (X ;µ2,Σ2)

I Paramètres à estimer : π1, π2, µ1, Σ1, µ2 et Σ2

I On regroupe tous les paramètres du modèle de mélange dansle vecteur θ :

θ =[π1, π2, µ

>1 , Σ1(:)>, µ2, Σ2(:)>

]>I Comment estimer les paramètres à partir des données ?

Maximiser la vraisemblance (ou le log de la vraisemblance)

Gilles Gasso - Philippe LERAY Clustering 61 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Notion de vraisemblance

I Supposons des données {xi}i=1,··· ,N i.i.d. (identiquement etindépendamment distribuées). Ces données suivent une loif (X ; θ) de paramètres θ

I Vraisemblance

Λ(θ; x1, · · · , xN) =N∏

i=1

f (X = xi ; θ)

I En général on utilise la Log-vraisemblance

L(θ; x1, · · · , xN) = log (Λ(θ; x1, · · · , xN))

=N∑

i=1

log(f (X = xi ; θ))

Gilles Gasso - Philippe LERAY Clustering 62 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Maximisation de la vraisemblance

I On considère de façon générale le problème suivant

maxθL(θ; x1, · · · , xN) = max

θ

N∑i=1

log(f (X = xi ; θ))

Approche directe

I La solution θ̂ du problème précédent vérifie∇L(θ̂; x1, · · · , xN) = 0

I Pas de solution analytique en général

I Problème d’optimisation difficile en général

I Il existe des cas simples où la solution analytique existe commepar exemple l’estimation des paramètres d’une loi normale

Gilles Gasso - Philippe LERAY Clustering 63 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Maximisation de la vraisemblance

Approche directe : exemple de solution analytique

I Soit des données {xi ∈ Rd}Ni=1 i.i.d. Elles sont tirées selon uneloi de distribution gaussienne

N (X/µ,Σ) =1√

(2π)d |Σ|exp{−12

(X − µ)>Σ−1(X − µ)

}I La Log-vraisemblance est

L(µ,Σ; x1, · · · , xN) = −12N log((2π)d |Σ|)−1

2

N∑i=1

(xi−µ)>Σ−1(xi−µ)

I Estimation de la moyenne µ et de la matrice de covariance Σ

maxµ,ΣL(µ,Σ; x1, · · · , xN)

Gilles Gasso - Philippe LERAY Clustering 64 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Maximisation de la vraisemblance

Approche directe : exemple de solution analytique

I Par dérivation de L, on trouve l’estimation des paramètres µet Σ au sens du maximum de vraisemblance

I Conditions d’optimalité

∇µL = 0 ⇒ −N∑

i=1

Σ−1(xi − µ) = 0

∇ΣL = 0 ⇒ −N2

Σ−1 +12

N∑i=1

Σ−1(xi − µ)>(xi − µ)Σ−1 = 0

I Solutions analytiques

µ̂ =1N

N∑i=1

xi , Σ̂ =1N

N∑i=1

(xi − µ̂)(xi − µ̂)>

Gilles Gasso - Philippe LERAY Clustering 65 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Maximisation de la vraisemblance

Exemple où la solution analytique n’existe pas

I Log-Vraisemblance du modèle de mélange de deux gaussiennes

L(θ/x1, · · · , xN) =N∑

i=1

log(π1N (xi ;µ1,Σ1) + π2N (xi ;µ2,Σ2))

I Solution non analytique à cause du log de la somme destermes πjN (x/µj ,Σj)

I Quel est le problème ? On ne connait pas a priori le clusterauquel appartient le point xi

I Que se passe-t-il si on a cette information ? On peut construireune démarche itérative : c’est l’algorithme EM

Gilles Gasso - Philippe LERAY Clustering 66 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

EM par l’exemple

Existe-t-il une parade dans l’exemple du mélange degaussiennes ?

I Que se passe-t-il si on se donne arbitrairement l’appartenancede xi à un cluster ?

On définit la log-vraisemblance complétée

Lc(θ; {xi , zi}i=1,··· ,N) =N∑

i=1

zi log(π1N (xi ;µ1,Σ1))+(1−zi ) log(π2N (xi ;µ2,Σ2))

avec zi = 1 si xi ∈ C1 et zi = 0 si xi ∈ C2

Il est alors possible de déterminer π̂j , µ̂j et Σ̂j analytiquement

I Problème : nous avons pris arbitrairement les inconnus zi !

Gilles Gasso - Philippe LERAY Clustering 67 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

EM par l’exemple

Comment on s’en sort ?

I On prend l’espérance conditionnelle de Lc

Esp(Lc/{xi}i=1,··· ,N) =N∑

i=1

Esp(zi/xi ) log(π1N (xi ;µ1,Σ1))

+(1− Esp(zi/xi )) log(π2N (xi ;µ2,Σ2))

I Esp(zi/xi ) = Pr(zi = 1/xi ) est la probabilité a posteriori quexi ∈ C1

I Intuition : si on tirait aléatoirement la classe du point xi untrès grand nombre de fois, combien de fois le point xitomberait dans la classe C1 ? Ceci est traduit par Esp(zi/xi ).

Gilles Gasso - Philippe LERAY Clustering 68 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

EM par l’exemple

Comment on s’en sort ?

I D’après la loi de Bayes

Pr(zi = 1/xi ) =Pr(zi = 1)f (xi/zi = 1)

f (xi )

Pr(zi = 1/xi ) =π1N (xi ;µ1,Σ1)

π1N (xi ;µ1,Σ1) + π2N (xi ;µ2,Σ2)

I Si on connait les paramètres, on peut calculer les probabilités aposteriori. Connaissant Pr(zi = 1/xi ), on peut calculer lesparamètres. EM : approche itérative alternant calcul desPr(zi = 1/xi ) et calcul des paramètres

Gilles Gasso - Philippe LERAY Clustering 69 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

EM appliqué au mélange de 2 gaussiennes : AlgorithmeI Répeter

I Etape E (Expectation) : calcul des probabilités a posterioriPr(zi = 1/xi ) et Pr(zi = 0/xi )

γ(1)i =

π1N (xi ;µ1,Σ1)

π1N (xi ;µ1,Σ1) + π2N (xi ;µ2,Σ2), i = 1, · · · ,N

Rmq : γ(2)i = Pr(zi = 0/xi ) = 1− γ(1)

i : probabilité a posteriorique xi ∈ C2

I Etape M (Maximisation) : calcul des paramètres

µj =

∑Ni=1 γ

(j)i xi∑N

i=1 γ(j)i

, πj =

∑Ni=1 γ

(j)i

N, j ∈ {1, 2}

Σj =

∑Ni=1 γ

(j)i (xi − µj)(xi − µj)

>∑Ni=1 γ

(j)i

, j ∈ {1, 2}

I Jusqu’à convergenceGilles Gasso - Philippe LERAY Clustering 70 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

EM appliqué au mélange de 2 gaussiennes : Algorithme

Initialisation de l’algorithme

I Fixer les paramètres π1 et π2 tels que π1 + π2 = 1

I Fixer les paramètres µ1,Σ1 et µ2,Σ2

I On peut utiliser l’algo K-means pour initialiser les clusters

Du modèle de mélange au clusteringI Après convergence, on dispose des paramètres. On affecte le

point xi au cluster Cj tel que γ(j)i soit maximal

C1 ← xi si γ(1)i > γ

(1)i

C2 ← xi autrement

Gilles Gasso - Philippe LERAY Clustering 71 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

EM appliqué au mélange de 2 gaussiennes

Illustration [S. Sankararam]Initialisation Init : Etape E Iteration 1

Itération 2 Itération 5 Itération 20

Gilles Gasso - Philippe LERAY Clustering 72 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Extensions au cas général

Modèle de mélange

f (x) =K∑

k=1

πk f (x ; θk) avecK∑

k=1

πk = 1

Algorithme EM

I A l’étape E, on calcule les proba a posteriori de xi ∈ Ck

γ(k)i =

πk f (xi ; θk)∑Kk=1 πk f (x ; θk)

, i = 1, · · · ,N, et k = 1, · · · ,K

Rmq :∑K

k=1 γ(k)i = 1

I Etape M : on calcule les paramètres θk et πk par maximisationde Esp(Lc/{xi}i=1,··· ,N). Si on a un modèle de mélange deK > 2 gaussiennes, on calcule les paramètres analytiquement

Gilles Gasso - Philippe LERAY Clustering 73 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Remarques sur EM

I Convergence vers un extremum local (convergence globale nongarantie)

I Critère de convergence : variation de la log-vraisemblance

I On montre qu’à chaque étape, on améliore lalog-vraisemblance (la log-vraisemblance est monotonecroissante)

I Initialisation : aléatoire ou utilisation de résultats a priori(comme par l’exemple faire K-means sur les données et utiliserces résultats pour initialiser l’algorithme)

I Des initialisations différentes peuvent donner des paramètresdifférents

Gilles Gasso - Philippe LERAY Clustering 74 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Variante de EM : CEM

I Initialiser les paramètres θk et πk , k = 1, · · · ,K

I RépéterI Etape E : calculer les probabilités a posteriori γ(k)

i ,∀ i = 1, · · · ,N et ∀ k = 1, · · · ,K

I Etape C : classification des points

Ck ← xi si k = arg` max γ(`)i

Modification des proba a posteriori

γ(k)i = 1 et γ

(`)i = 0, ∀ ` 6= k

I Etape M : calcul des paramètres par la procédure usuelle enutilisant les proba a posteriori modifiées

I Jusqu’à convergence

Remarque : A la fin de l’algo, on obtient directement les clustersGilles Gasso - Philippe LERAY Clustering 75 / 76

Introduction Problématiques Méthodes de clustering CHA K-means Mélange de gaussiennes

Conclusion

I Clustering : apprentissage non-supervisé

I Regroupement des données en classes (clusters) homogènes

I Propriétés d’un bon clustering : identifier des classes trèshomogènes (faible variance intra-classe) et bien séparées (fortevariance inter-classe)

I Il existe des critères composites permettant d’évaluer la qualitéd’un clustering

I Le nombre de clusters est un hyper-paramètre qui dépend del’application mais peut être déterminé sur la base de cescritères composites

I Algorithmes : CHA, K-means, mélange de distributions et biend’autres

Gilles Gasso - Philippe LERAY Clustering 76 / 76