PIRLS 2011 - Étude internationale sur la lecture des...

Transcript of PIRLS 2011 - Étude internationale sur la lecture des...

12.21DÉCEMBRE

i n f o r m a t i o nnote d’

PIRLS 2011 - Étudeinternationale sur la lecturedes élèves au CM1Évolution des performances à dix ans

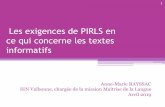

L’étude internationale PIRLS 2011vise à mesurer les performancesen lecture des élèves à la fin deleur quatrième année de scolaritéobligatoire (CM1 pour la France).La France, avec un score de520 points, se situe au delàde la moyenne internationale(500 points) mais en deçà de lamoyenne européenne (534 points)et ce, quel que soit la compétenceou le type de texte considéré.Comparées aux résultats obtenuslors de PIRLS 2001 et PIRLS 2006,bien qu’en légère baisse,les performances globales dela France sont statistiquementstables.Sur la période de dix ans (2001-2011),on observe toutefois une baissesignificative des performancessur la compréhension des textesinformatifs (- 13 points), de mêmeque sur les compétences les pluscomplexes (- 11 points).Par ailleurs, les élèves françaissont toujours les plus nombreuxà s’abstenir de répondre lorsqueles réponses doivent être rédigées.Ils sont aussi les plus nombreuxà ne pas terminer les épreuves.

En mai 2011, cinquante-quatre pays ouprovinces1 ont participé à l’enquête inter-nationale PIRLS (Progress in InternationalReading Literacy Study) organisée par l’IEA2

(Association internationale pour l’évalua-tion des compétences scolaires) en vued’évaluer les performances en lecture desélèves à la fin de leur quatrième année descolarité obligatoire. À cette étape de leurscolarité, les élèves approfondissent leurscompétences en lecture et lisent dès lorspour apprendre. Quelle que soit la matièreenseignée, la lecture est essentielle à laréussite à l’école, mais elle joue un rôleimportant dans la réalisation de soi desélèves et permet d’augmenter leurs capa-cités de réflexion et de créativité. Cetteétude a déjà été menée en 2001 et en 2006 ;23 pays de 2001 et 31 pays de 2006 sonttoujours présents en 2011. Ainsi, cette troi-sième prise d’informationde la série, en plusd’apporter un constat sur les compétencesen lecture des élèves français en 2011 parrapport à celles de leurs camarades desautres pays, donne lieu également à unecomparaison dans le temps.

Une évaluation des élèvesde CM1

Dans PIRLS, la population étudiée necorrespond pas à une génération d’élèvesd’un âge défini, comme c’est le cas dans le

programme PISA (Programme internationalpour le suivi des acquis des élèves) del’OCDE. Le but de l’étude est de mesurerles performances de l’ensemble des élèvesprésents à un niveau déterminé de lascolarité, quels que soient leur âge, leurparcours et l’organisation du système éducatif(proportion d’élèves en retard, etc.).La classe cible de l’enquête est précisémentdéfinie comme « la classe qui représentequatre années d’enseignement. Le pointde départ de ces quatre années, la premièreannée du premier niveau de la ClassificationInternationale Type de l’Éducation (CITE)validée par l’UNESCO, c’est la classe oùse fait le début des apprentissages systéma-tiques de la lecture, de l’écriture et desmathématiques. » Dans la plupart des pays,PIRLS évalue donc les élèves de quatrièmeannée d’école obligatoire, en France lesélèves de CM1. Toutefois, la moyenned’âge des élèves ne doit pas être inférieure

1. Trois provinces canadiennes (Alberta, Ontario etQuébec) ; l’État de Floride aux USA ; la Communautéautonomed’AndalousieenEspagne; laprovincechinoisede Hong Kong ; l’Angleterre et l’Irlande du Nord pour leRoyaume-Uni, participent à l’étude pour elles-mêmes.Ceci se justifie par le fait que les systèmes éducatifsde ces entités sont distincts.2. L’IEA (International Association for the Evaluationof Educational Achievement) est une associationscientifique indépendante à but non lucratif, dont lamission principale est de mettre en œuvre des étudescomparatives à échelle internationale sur l’évaluationet la réussite scolaire des élèves. Depuis sa création en1958, cette association pionnière a conduit plus d’unevingtaine d’études de portée internationale dont PIRLS.

note d’information 12-21 � Page 2

à 9,5 ans au moment de la passationdes épreuves. C’est la raison pour laquellel’Angleterre, Malte, la Nouvelle-Zélande, etTrinité-et-Tobago ont évalué les élèves dansleur cinquième année de scolarité.Au moment de la passation, la moyenned’âge internationale est de 10,2 ans ; lesélèves français sont légèrement plusjeunes,1 0,0 ans, commeen 2006. Les élèvesfrançais sont parmi les plus jeunes del’étude, les plus jeunes étant les Italienset les Norvégiens (9,7 ans) et les plusâgés les Danois et les Roumains (10,9 ans).Les politiques de chaque pays en matièred’âge de scolarisation, de promotion etde rétention de classe, conformément auxcontexteséconomiques, sociaux et culturelsne permettent pas d’établir un lien directentre résultats et âge moyen des élèves.Certains pays, par exemple, adoptent unepolitique stricte d’admission à l’écoleprimaire sur la seule base de l’âge et utili-sent ensuite le principe de la promotionautomatique ; d’autres permettent auxparents une certaine latitude dans le choixdu moment où leur enfant commencel’école, et peuvent autoriser, voire obligerles élèves à redoubler ou, à l’inverse, àavancer d'une classe.

Une évaluation qui viseles compétences en lectureet les objectifs donnésà la lecture

PIRLS est conçu pour évaluer la « compé-tence en lecture ». Celle-ci est définiecomme : « L’aptitude à comprendre et àutiliser les formes du langage écrit querequiert la société ou qui sont importantspour l’individu. Les jeunes lecteurs peuventconstruire du sens à partir de textes trèsvariés. Ils lisent pour apprendre, pour s’inté-grer dans une société où la lecture joueun rôle essentiel et pour leur plaisir. »Le lecteur mobilise toute une gamme decapacités, de stratégies cognitives etmétacognitivesainsi que ses connaissancespréalables des objets abordés.L’étude pose comme hypothèse que lacompétence en lecture est directementliée aux raisons qui incitent le lecteur àlire. C’est pourquoi l’épreuve dans sonensemble a été bâtie sur le croisement de

deux aspects : les compétences en lectureet les objectifs du lecteur.

Les compétences en lectureQuatre compétences sont définies :– prélever des informations explicites(Prélever) (22 % du barème) : repérer lesinformations directement liées à l’objectifde la lecture ; chercher des idées précises ;chercher la définition de mots ou d’expres-sions ; repérer le contexte de l’histoire(époque, lieu) ; trouver l’idée principale(si elle est exprimée explicitement) ;– faire des inférences directes (Inférer)(28 % du barème) : déduire que tel événe-ment a entraîné tel autre ; déduire l’élémentprincipal d’une série d’arguments ; déter-miner le référent d’un pronom ; repérer lesgénéralisations présentées dans le texte ;décrire la relationentredeuxpersonnages ;– interpréter et assimiler idées et informa-tions (Interpréter) (37 % du barème) :déduire le message global ou le thème d’untexte ; envisager une alternative aux actionsdes personnages ; comparer des informa-tions du texte ; saisir l’atmosphère ou le tondu récit ; trouver une application concrèteaux informationscontenuesdans le texte ;– examiner et évaluer le contenu, la langueet les éléments textuels (Apprécier) (13 %du barème) : évaluer la probabilité que lesévénements décrits se passent réellement ;décrire la manière dont l’auteur a amené lachute ; juger de l’intégralité ou de la clartédes informations fournies dans le texte ;décrire comment le choix des adjectifsmodifie le sens.Il est à noter que ces quatre compétencessont hiérarchisées dans leur degré decomplexité et que chacun des dix textesproposés aux élèves est couvert par unecombinaison de questions qui visent àévaluer l’atteintedechacuned’entreelles.

Les objectifs donnés à la lectureLa longueur des textes utilisés dans PIRLSest en moyenne de 850 mots, elle varie de600 à 1 000 mots selon les cas. Les textessont présentés en général sur trois ouquatre pages contenant également desillustrations ou des documents. Pourchaque texte, entre 13 et 16 questions sontposées aux élèves. En 2011, PIRLS contient135 questions.

Deux des objectifs les plus fréquentsdonnésaux élèves pour leur lecture à l’école etailleurs structurent également l’enquêtePIRLS :– lire pour accéder aux textes littéraires(cinq textes, 52 % du barème), la formedes textes utilisés principalement dans cecontexte est la fiction narrative. Le lecteuraborde le texte pour s’investir dans desévénements, des situations, des actions,des conséquences, des personnages, uneatmosphère, des sentiments, des idéesimagées et pour apprécier la langue en soi.Les textes narratifs proposés dans PIRLSsont des histoires ou des épisodes completsappuyés par des illustrations. Ces cinqtextes proposent des histoires contempo-raines ou traditionnelles et couvrent unevariété de contextes, on y rencontre le plussouvent deux personnages principaux etune intrigue avec un ou deux évènementscentraux. Les styles utilisés sont variéset on y trouve des éléments narratifs telsque l’utilisation de la première personne,l’humour, les dialogues, voire du langagefiguratif. Les thèmes des textes sont euxaussi divers ;– lire pour acquérir et utiliser des informa-tions (cinq textes, 48 % du barème), lestextes informatifs prennent de nombreusesformes ; ils peuvent présenter l’informationsuivant ou non une logique chronologique.Au moyen de ces textes, le lecteur s’informesur des aspects de l’univers réel pourcomprendre le monde tel qu’il est, mais ilpeut également aller plus loin et appliquerles informations obtenues à un raisonne-ment ou à une action. Les cinq textes sontstructurés par séquence ou par sujet, ilssont présentés avec, ou organisés autourde schémas, de cartes, d’illustrations, dephotos, d’encadrés, de listes, de tableaux.Les textes sont proposés par les paysparticipants puis retenus après un longprocessus de sélection ; ils ont une syntaxeet un lexique bien adaptés à l’âge desélèves et correspondent aux prescriptionsdes programmes du cycle 3 de l’écoleélémentaire.

Résultats généraux

Sur l’ensemble de l’évaluation, la France sesitue de manière statistiquement significative

note d’information 12-21 � Page 3

au-dessus du point central de l’échellePIRLS : les élèves français obtiennent unscore moyen de 520, soit un cinquièmed’écart-type au dessus de la moyenne inter-nationale fixée à 500. Le score moyen de laFrance est différent de manière statistique-ment significative de celui de chacun despays de l’étude, excepté la Pologne (525).Quatre pays se partagent les meilleursrésultats : Hong Kong, avec un score de 571,la Fédération de Russie (568), la Finlande(568) et Singapour (567). Leurs scoresmoyens ne sont pas différents d’un pointde vue statistique. Le score moyen le plusfaible est obtenu par le Maroc (310).32 pays participants obtiennent des scoresmoyens globaux significativement supé-rieurs au point central de l’échelle ; 11 paysont même des scores moyens supérieursà 550 (plus d’un demi-écart-type au-dessusde la moyenne). Néanmoins, dans cettepartie de l’échelle, les différences de perfor-mances entre les pays sont souvent relative-ment faibles. À l’autre extrémité, 10 paysont des performances globales significative-ment inférieures au point central de l’échelle(entre 425 et 488). Les deux derniers pays(Oman et Maroc) ont de forts pourcentagesd’élèves dont les performances sont tropbasses pour permettre une mesure et descomparaisons fiables (respectivement 16 et33 %).À chaque évaluation successive, PIRLS amontré que les filles ont des performancessupérieures aux garçons dans la trèsgrande majorité des pays. Ces résultats sont

corroborés dans de nombreuses étudesnationales, voire dans PISA pour les élèvesde 15 ans. Les résultats de 2011 ne fontpas exception, les filles obtiennent desrésultats significativement supérieurs àceux des garçons dans tous les pays,sauf en Colombie, en Israël, en Espagne,en Italie et en France où cette différencen’est plus significative. Les différencesde performances filles/garçons peuventêtre très importantes dans certains pays(Finlande : 21 points ; Angleterre : 23 points ;Arabie saoudite : 54 points).En France, en 2001 et en 2006, l’écartfilles/garçons (11 points) était significatifmais faible ; en 2011, il est plus réduit(5 points) et ne distingue plus les deuxsexes (graphique 1). Cette réduction del’écart est due en partie à une moindreperformance des filles, dont le score de2011 est significativement inférieur à celuide 2001. Les jeunes Françaises avec unscore moyen de 522 ne sont qu’à 2 pointsau-dessus de la moyenne internationaledes filles (520) ; en revanche les jeunesFrançais (518) s’écartent sensiblement dela moyenne internationale des garçons(504).Le tableau 1 présente la moyenne obtenueà PIRLS 2011 par différents groupes depays dont la France est proche d’un pointde vue géographique ou économique. Lesrésultats français (520) se retrouvent endeçà de la moyenne des pays voisins, despays de l’Union européenne ou des paysde l’OCDE.

L’écart-type de la distribution est un indica-teur de la dispersion. Plus il est faible, moinsle système éducatif creuse d’écarts entreélèves faibles et forts ; à l’inverse, unécart-type élevé est l’indice que le systèmeéducatif ne réussit pas à combler les inéga-lités des performances entre les élèves.Pour la France, l’écart-type est de 68 (71 auniveau européen) : les résultats des élèvesfrançais sont donc un peu moins dispersésque dans l’ensemble des pays européensde l’étude. Pour ce qui concerne les payseuropéens, on peut relever les écarts-typesles plus bas aux Pays-Bas (54), en Républiquetchèque (61) et en Autriche (63). En revanche,les plus élevés se trouvent à Malte (97), enRoumanie (91) et en Angleterre (82).Le graphique 2 présente les scores despays européens.

Une surreprésentation des élèvesfrançais dans le plus faible niveaueuropéen

Si l’on ordonne tous les élèves des payseuropéens ayant participé à PIRLS en fonc-tion de leur score et que l’on découpe cetensemble en quatre groupes de même taille,on note que les élèves français se trouventsurreprésentésdans le groupe le plus faible :32 % contre 25 % et, à l’inverse, qu’ils sontsous-représentés dans le groupe de plushaut niveau : 17 % contre25 %. Ces donnéesn’ont pas évolué depuis 2006. Les scoresmoyens de ces différents groupes de niveaumontrent une moindre réussite des élèvesfrançais du groupe le plus fort par rapportà leurs camarades européens (616 pointscontre 622) alors que dans le groupe le plusfaible ils obtiennent un meilleur scoremoyen, 441 points contre 436.

Les points de référenceinternationaux PIRLS

Pour mieux rendre compte des résultats desélèves, PIRLS utilise son échelle internatio-nale des performances pour caractériser ce

522

518

531

527

520

516

514

516

518

520

522

524

526

528

530

532

2001 2006 2011 (1)

Filles

Garçons

Lecture : en France, les filles avaient un score moyen de 531 en 2001. Elles obtiennent un score de 522 en 2011.(1) La différence filles/garçons n'est pas significative en 2011.

GRAPHIQUE 1 – Évolution des scores des filles et des garçons français

Source : MEN-MESR-DEPP

TABLEAU 1 – Regroupements des paysproches de la France

PIRLS 2011Score moyen global

(Écart-type)Pays de l’OCDE (25 pays) 538 (70)Union européenne (23 pays) 534 (71)France 520 (68)

Lecture : le score moyen des 25 pays (dont la France)appartenantà l’OCDEetprésentsdansl’étudeest de538.Source : MEN-MESR-DEPP

note d’information 12-21 � Page 4

que les élèves sont capables de faire à diffé-rents points de référence.Quatre points sontainsimisenavantsur l’échelle (tableau2) :– au niveau avancé de l’indice de référence(625 points de score), les élèves sont capa-bles de prendre en compte la totalité deséléments du texte pour soutenir leurs inter-prétations et leurs explications ;– au niveau élevé de l’indice de référence(550 points), les élèves sont en mesure dedistinguer les actions et les informationsimportantes, de faire des inférences etdes interprétations à partir d’éléments dutexte, d’évaluer le contenu et les élémentstextuels, et de reconnaître certaines fonc-tionnalités de langage ;– au niveau intermédiaire de l’indice deréférence (475 points), les élèves peuventprélever des informations, faire des infé-rences directes, utiliser certains élémentsde présentation, et commencer à recon-naître des caractéristiques du langage ;– enfin, au niveau bas de l’indice de réfé-rence (400 points), les élèves sont capablesde prélever des informations à partir d’untexte quand celles-ci sont clairement etexplicitement énoncées ou faciles àlocaliser.

Les élèves français faiblesrelativement mieux classés

Pour chaque pays européen, lorsque l’oncompare les élèves les plus faibles, d’unepart, et les élèves les plus performants,d’autre part, il apparaît que les 5 % d’élèvesfrançais les plus faibles se classent mieux,de manière relative (16e rang européen) queles 20 % d’élèves français les plus perfor-mants qui occupent le 20e rang européen.

Stabilité des résultatspar rapport à 2001

En juin 2008, de nouveaux programmespour l’école primaire sont venus remplacerceux de février 2002. Ces nouveauxprogrammes sont entrés en vigueur à larentrée scolaire 2008-2009. Ainsi, un élève« à l’heure » dans sa scolarité, évaluédans le cadre de PIRLS, aura effectué sonCP avec les programmes de 2002 et sesCE1, CE2 et CM1 régis par les nouveauxprogrammes de 2008.L’évaluation 2011 reprend à l’identiquequatre textes et leurs questions utilisés

en 2006 ainsi que deux textes et leursquestions utilisés en 2001 et en 2006.Ainsi, 60 % des items de 2011 sontcommuns aux deux périodes 2006/2011, etce fort ancrage permet une comparaisonstatistiquement fiable entre les prises d’in-formations. Ces items ont servi à élaborerl’échelle de 2011 de telle manière que lesperformancessoientparfaitementcompara-blesàcellesobservées il yacinqetdixans.En 2001, le score global de la France étaitde 525, en 2006 de 522, et il est de 520 en2011 (tableau 3). Du point de vue statistique,ces différences, à cinq ou dix ans, ne sont

pas significatives, c’est-à-dire qu’il n’estpas possible d’affirmer qu’elles seraientdues à une légère érosion des résultats.Sur les 23 pays ayant participé à PIRLSà dix ans d’intervalle, 14 obtiennent desscores en 2011 significativement diffé-rents de ceux obtenus en 2001. Parmi eux,notons la Bulgarie (- 19 points), la Suède(- 19 points), la Lituanie (- 15 points) et lesPays-Bas (- 8 points), qui voient leursrésultats baisser, tandis que la Slovénie(+ 29 points), la République slovaque(+ 17 points) et la République tchèque(+ 9 points) augmentent leurs performances.

Moyenne européenne 534

France

Finlande

Irlande du Nord

DanemarkAngleterre, Irlande

Pays-BasRépublique tchèque

SuèdeAllemagne, Italie, PortugalHongrie

Slovaquie

BulgarieSlovénieAutricheLituaniePologne

Espagne

Belgique (Com. fr.)

Roumanie

Malte475

480

485

490

495

500

505

510

515

520

525

530

535

540

545

550

555

560

565

Lecture : ce graphique ne prend en compte que les pays de l'Union européenne qui ont participé à PIRLS 2011.La moyenne de ce groupe de pays est de 534. Avec 520, la France se situe sous la moyenne de ce groupe.

GRAPHIQUE 2 – Classement des pays européens participant à PIRLS 2011

Source : MEN-MESR-DEPP

TABLEAU 2 – Évolution des pourcentages d’élèves atteignant les points de référenceinternationaux de performances en lecture

Point de référenceAvancé (625) Élevé (550) Intermédiaire (475) Bas (400)

France2001 7 % � 37 % 77 % 95 %2006 5 % 35 % 76 % 96 %2011 5 % 35 % 75 % 95 %

Europe 2011 9 % 44 % 80 % 95 %Lecture : en 2011, 35 % des élèves français atteignent le point de référence élevé contre 44 % des élèves européens.� : le pourcentage de 2011 est significativement inférieur à celui de 2001.Source : MEN-MESR-DEPP

note d’information 12-21 � Page 5

Mais les plus fortes hausses ne se font pasen Europe : Iran (+ 44 points), Hong Kong(+ 43 points), Fédération de Russie(+ 40 points) et Singapour (+ 39 points).En France, entre 2001 et 2011, on note unelégère baisse des résultats (- 10 points)dans le public hors éducation prioritaire,tandis que dans le privé et dans l’éducationprioritaire les élèves obtiennent des scoresstables (respectivement + 4 et + 3 points).En 2011, tout comme c’était le cas dix ansplus tôt, les seules différencessignificativesconcernent l’éducation prioritaire, dont lesperformances sont moindres (tableau 3).

Résultats détaillés de 2011

Des résultats variablesselon les items

Le score moyen global de la France masquebien sûr des performances variables selonles activités proposées. L’analyse des résul-tats par item permet de mettre en évidencecette variabilité : en effet, sur l’ensembledes 135 items de l’épreuve, les élèves fran-çais réussissent moins bien à 69 items(soit un peu plus de 1 item sur 2) et ce,de manière significative par rapport à lamoyenne européenne. À l’inverse, leursperformances sont significativement supé-rieures pour 17 items (soit 1 item sur 8).Au total, on note donc un comportementqui s’écarte de la moyenne près de deuxfois sur trois (64 % des cas).Parmi les 17 items pour lesquels lesélèves français ont des performances signi-ficativement supérieures aux autres élèveseuropéens, les items relevant des compé-tences « Prélever » et « Inférer » sont surre-présentés (88 % contre 59 % dans l’en-semble de l’épreuve), tout comme ceux quisont en format de QCM (questions à choixmultiple de réponses) (65 % contre 55 %).Parmi les 69 items pour lesquels lesélèves français ont des performances signi-ficativement inférieures aux autres élèveseuropéens, ceux relevant des compétences

« Interpréter » et « Apprécier » sont surrepré-sentés (57 % contre 41 %), tout comme lesitems qui imposent un format de réponseconstruite (51 % contre 45 %), de mêmeque les items issus des textes à caractèreinformatif (51 % contre 47 % dans l’en-semble de l’épreuve).

Une baisse significativesur les textes informatifs

Pour chacun des deux types de textes(narratifs et informatifs), une échelle descores a été construite avec une moyenne

toujours fixée à 500. Le graphique 3 rendcompte de la distribution des seuls pays del’Union européenne sur ces deux échellesindépendantes3 et permet d’apprécier laperformance de la France relativement auxautrespaysetauxmoyenneseuropéennes.Les élèves français se positionnent demanière significative en dessous de lamoyenne européenne dans chacun desdeux cas, avec un score de 519 pour lestextes informatifs (Europe : 533) et 521pour les textes narratifs (Europe : 535).Ces deux sous-scores ne s’écartent pas

TABLEAU 3 – Scores moyens globaux selon le type de scolarisation

Type de scolarisation Score moyen (Écart-type)2001 2006 2011

Public hors EP 533 525 523 (66)Privé 527 536 531 (66)Public EP 477 478 480 (70)France 525 (70) 522 (67) 520 (68)

Lecture : les élèves scolarisés dans le public en éducation prioritaire (EP) obtenaient un score de 477 en 2001 etde 478 en 2006. Ils obtiennent 480 en 2011.Source : MEN-MESR-DEPP

3. Il faut comprendre que ces deux échelles, narrativeet informative, ne sont pas directement comparables.Elles représentent des concepts différents et les itemsconstitutifs de chaque échelle ont des niveaux dedifficulté quelque peu différents. Toutefois, une mise àl’échelle MRI, en calant ces deux échelles sur cellesdes résultats globaux, prend en compte ces niveaux dedifficultés et il devient alors possible de comparer lessous-scores par rapport au score global.

Angleterre, Irlande

Angleterre

Autriche

Autriche

Belgique (Com. fr.)

Belgique (Com. fr.)

Bulgarie

DanemarkDanemark

Espagne

Espagne

Finlande Finlande

FranceFrance

Hongrie

Hongrie

IrlandeIrlande du nord

Irlande du nord

Italie, République tchèque

Italie

LituanieLituanie

Malte

Malte

Pays-BasAllemagne, Pays-Bas

Pologne

Pologne

Portugal

Portugal

Slovaquie

Slovaquie

Roumanie

Roumanie

Allemagne, Suède

Slovénie

Bulgarie, Slovénie

Suède

470

475

480

485

490

495

500

505

510

515

520

525

530

535

540

545

550

555

560

565

570 Lecture de textes informatifs Lecture de textes narratifs

Moyenne européenne533

Moyenne européenne535

Lecture : parmi les 23 pays européens présents dans l'étude, la France occupe le 19e rang pour les textes narratifset le 18e rang ex aequo (avec la Pologne) pour les textes informatifs.

GRAPHIQUE 3 – Classement des pays européens selon les types de textes

Source : MEN-MESR-DEPP

note d’information 12-21 � Page 6

significativement du score global français(520). C’est le cas dans un peu plus de lamoitié des pays européens.Quelques pays, en revanche, ont des profilsplus tranchés. L’Irlande, l’Irlande du Nord,la Pologne, la Hongrie, la Républiqueslovaque, l’Allemagne, l’Autriche, et parti-culièrement la Suède, montrent des écartssignificatifs en faveur des textes narratifs.À l’inverse, les élèves du Portugal, deMalte et d’Italie obtiennent des scoressignificativement supérieurs aux textesinformatifs.En général, les augmentations ou les dimi-nutions des scores globaux depuis 2001 et2006 se sont traduites, pour les différentspays, par des augmentations ou des diminu-tions à la fois pour les textes narratifs

et pour les textes informatifs. La Francecependant, suit un schéma notablementdifférent. Alors que les performances surla lecture des textes narratifs sont restéesrelativement stables, les performancesqui concernent la lecture des textes detype informatif ont diminué depuis 2001(13 points), effaçant ainsi les différences deperformances observées entre les deuxtypesde textesen2001et2006 (tableau4).Pour conclure sur ce point, il est intéressantde noter que les filles françaises réussissentsignificativement mieux que les garçonsles textes narratifs (526 points contre 517),alors qu’aucune différence n’est observéeentre les deux sexes pour les textes informa-tifs (519 points dans les deux cas).

Une baisse significative sur lescompétences les plus complexes

Les quatre compétences « Prélever »,« Inférer », « Interpréter » et « Apprécier » ontété regroupées deux à deux : « Prélever etInférer », « Interpréter et Apprécier », afinde créer deux échelles de scores indépen-dantes. Le graphique 4 rend compte deces deux échelles indépendantes4 pour lesseuls pays européens. Si par constructionla moyenne internationale de ces deux

échelles est de 500, la moyenne européenneest de 535 pour ce qui concerne « Préleveret Inférer », et de 533 pour « Interpréter etApprécier ».En général, les pays qui obtiennent lesperformances globales les plus élevéesobtiennent aussi les performances les plusélevées sur les deux échelles des compé-tences. On observe cependant une tendancepour les pays les mieux classés à obtenir desperformances relativement plus élevéespour « Interpréter et Apprécier » que pour« Prélever et Inférer ».

Les élèves français se positionnent demanière significative en dessous de lamoyenne européenne dans chacun desdeux cas avec un score de 528 pour« Prélever et Inférer » (Europe : 535) et512 pour « Interpréter et Apprécier »(Europe : 533). Ces deux sous-scores fran-çais s’écartent significativement du scoreglobal français (520).Cinq autres pays européens se comportentcomme la France sur ce point : La Belgique(Communauté francophone), l’Espagne,l’Allemagne, l’Autriche et les Pays-Bas.

4. Cf. note précédente. Ici, c’est par construction queles items constitutifs de chaque échelle ont des niveauxde difficultés différents puisque les compétences sonthiérarchisées dans leur degré de complexité. Au niveauinternational, le taux de réussite des items est de 64 %pour « Prélever et Inférer » et de 45 % pour « Interpréteret Apprécier ».

TABLEAU 4 – Évolution du score moyen de la France en fonction des types de textes

PIRLSFrance

Textes informatifs Textes narratifsScoremoyen

Différence entre années Scoremoyen

Différence entre années2006 2001 2006 2001

2011 519 - 7 � - 13 � 521 4 22006 526 - 6 517 - 22001 532 519

Lecture :en2011, lescoremoyendelaFrancesur les textes informatifsest de519. C’est 13 pointsdemoinsqu’en2001.� : la baisse est significative.Source : MEN-MESR-DEPP

Angleterre

Angleterre

Autriche, Portugal

Autriche

Belgique (Com. fr.)

Belgique (Com. fr.)

Bulgarie Bulgarie

Danemark

Espagne

Espagne

FinlandeFinlande

France

France

Hongrie

Portugal, Hongrie

IrlandeIrlande, Danemark

Irlande du nord

Irlande du nord

Italie

LituanieLituanie

Malte

Malte

Pays-Bas

Pays-Bas

PolognePologne

République tchèque, Italie

Roumanie

Roumanie

Allemagne, République tchèque

Allemagne, Slovaquie

Slovénie

Slovénie

SuèdeSuède

470

475

480

485

490

495

500

505

510

515

520

525

530

535

540

545

550

555

560

565

570Prélever et Inférer Interpréter et Apprécier

Moyenne européenne535 Moyenne européenne

533Slovaquie

Lecture : au sein des 23 pays européens de l'étude, La France occupe le 18e rang pour les compétences « Préleveret Inférer » et le 19e rang pour les compétences « Interpréter et Apprécier ». Sur ce graphique, les compétencessont présentées dans un ordre croissant de complexité.

GRAPHIQUE 4 – Classement des pays européens selon les compétences

Source : MEN-MESR-DEPP

note d’information 12-21 � Page 7

À l’inverse, les élèves de Hongrie, d’Irlandedu Nord et d’Angleterre obtiennent desscores significativement supérieurs pour« Interpréter et Apprécier ». Il est vraisem-blable que ces différences de profil s’expli-quent par l’accent plus ou moins marquéque met chaque système éducatif surl’enseignement de ces compétences à ceniveau de scolarité.Pour la France, on observe une asymétriede l’évolution des performances sur dix ans(tableau 5). Le score moyen des compé-tences « Prélever et Inférer », les moinsexigeantes, restent relativement stablessur la décennie, alors que les compétences« Interpréter et Apprécier », plus complexes,voient leur score moyen diminuer sur lamême période (11 points).Pour la France, la différenciation par genremontre que si les filles réussissent significa-tivement mieux que les garçons pour« Prélever et Inférer » (531 points contre525), en revanche aucune différence n’estobservée entre eux pour les compétencesplus complexes « Interpréter et Apprécier »(513 points contre 510).Une synthèse récente du nombre d’élèvesen difficulté face à l’écrit5 montre que,depuis une dizaine d’années, ce nombre aaugmenté : près d’un élève sur cinq estaujourd’hui concerné en début de sixième.À partir des deux enquêtes de la DEPP,« Lire, écrire, compter » et « Difficultésde lecture en début de sixième », cettesynthèse fait ressortir que la dégradation duniveau de performance face à l’écritconcerne plus particulièrement les élèvesles plus en difficulté. Le niveau des élèvessitués autour de la médiane n’a, quant à lui,pas évolué. C’est ce que confirment lesrésultats PIRLS 2011, dont le dispositif estparticulièrement précis pour mesurer leniveau des élèves situés autour de lamédiane.

Les formats de questionsL’évaluation PIRLS a recours à deux formatsde questions : d’une part des questions àchoix multiples (QCM) et d’autre part desquestions dites à réponses construites, qui

imposent à l’élève une production écriteplus ou moins longue. Les élèves françaisréussissent significativement mieux lors-qu’il s’agit de répondre à des QCM que lors-qu’il s’agit de rédiger des écrits, avecrespectivement 67 % et 40 % de réussite.Parmi les questions dont les réponsesdoivent être rédigées, on note des diffé-rences selon que la réponse requise doitêtre longue ou brève. Plus la réponseattendue doit être élaborée, plus le scoredes élèves français diminue : 53 % de réus-site aux questions à réponses construitesbrèves (un mot, un groupe de mots) ; 31 %de réussite aux questions où la réponseattendue est de l’ordre d’une phrase ; 20 %de réussite aux questions où on attend unpetit paragraphe. Ce phénomène s’observepour l’ensemble des pays et, à ce titre, laFrance ne se distingue pas de la moyenneeuropéenne. C’est en Angleterre et enIrlande du Nord que l’on trouve les écartsde réussite les plus faibles d’un type dequestion à l’autre, c’est en revanche enAutriche que cet écart est le plus marqué.Le format de question est lié à la compé-tence évaluée. Ainsi, « Prélever et Inférer »fait plus souvent appel aux questions àchoix multiples (68 % des cas), alors que« Interpréter et Apprécier » demande plussouvent de développer un raisonnement etexige généralement une réponse construiteet plus longue (64 % des cas). Dans ce cas,pour obtenir un bon score, des capacitésen production d’écrits s’ajoutent donc àcelles de la compréhension. Pour autant,un outil d’analyse statistique, la régressionlinéaire, rend possible la neutralisation dece lien. Lorsqu’on neutralise par ce moyenl’effet des formats de questions, lahiérarchie des scores de réussite des élèvesfrançais au niveau des compétencesdemeure inchangée.Symétriquement, toutescompétences étudiées égales par ailleurs,les élèves obtiennent de meilleurs résultats

quand le mode de réponse requis n’impliquepas le recours à l’écrit construit.

Absences de réponse au filde l’épreuve...

Les taux d’absence de réponse semblentliés aux formats de questions. Plus la réponserequise doit être élaborée et demande undéveloppement écrit, plus les élèves onttendance à s’abstenir. Comme en 2001 et en2006, la France se distingue néanmoins desautres pays par l’amplitude du phénomène.Le taux d’absence de réponse des élèvesfrançais est de 1,9 % pour les QCM alorsqu’il est six fois plus élevé lorsqu’il s’agitde productions écrites. Ce taux est mêmemultiplié par huit lorsque l’exigence delongueur de la réponse attendue est la plusforte ; il s’agit du plus fort taux d’absencede réponse parmi les pays européens.C’est un problème récurrent, pointé dansPIRLS depuis dix ans, c’est aussi unproblème dont l’ampleur est importante :6,4 % des réponses attendues ne sont pasfournies par les élèves.

… et abandons avant la finde l’épreuve

Si les élèves français sont les plus nombreuxau sein des pays européens à s’abstenir derépondre, ils sont aussi les plus nombreux(avec les élèves belges) à ne pas terminerles épreuves qui leur sont proposées.En moyenne, pour chacun des textes, 6,7 %des élèves français ne vont pas jusqu’aubout de la quinzaine de questions posées.C’est sept foisplusque les élèves finlandais,néerlandais ou irlandais du Nord. Ce pour-centage d’élèves qui ne terminent pas lesépreuves varie en fonction du type detextes ; 4,7 % en moyenne lorsque l’épreuveporte sur un texte informatif, c’est presquedeux fois plus que la moyenne européenne ;8,7 % dans le cas d’un texte narratif, c’estlà près de trois fois plus que la moyenne

TABLEAU 5 – Évolution du score moyen de la France en fonction des compétences

PIRLSFrance

« Prélever et Inférer » « Interpréter et Apprécier »Scoremoyen

Différence entre années Scoremoyen

Différence entre années2006 2001 2006 2001

2011 528 1 - 1 512 - 4 - 11 �

2006 527 - 2 515 - 7 �

2001 529 523Lecture : en 2011, le score moyen de la France sur les compétences « Interpréter et Apprécier » est de 512.C’est 11 points de moins qu’en 2001.� : la baisse est significative.Source : MEN-MESR-DEPP

5. Daussin, J.-M., Keskpaik, S. et Rocher, T. (2011),« L’évolution du nombre d’élèves en difficulté face àl’écrit depuis une dizaine d’années », France PortraitSocial, pp. 137-152.

note d’information 12-21 � Page 8

DIRECTION DE L’ÉVALUATION,DE LA PROSPECTIVE ET DE LA PERFORMANCEDirecteur de la publication : Michel Quéré

Secrétaire de rédaction : Marc SaillardMaquettiste : Frédéric VoiretImpression : DEPP/DVE

DEPP, Département de la valorisation et de l’édition61-65 rue Dutot – 75732 Paris Cedex [email protected]

ISSN 1286-9392Reproduction autorisée à la condition expresse de mentionner la source

européenne et plus de dix fois plus que lesélèves néerlandais qui sont ceux qui vontle plus souvent jusqu’au bout de ces ques-tions. Il est possible d’estimer à 1,3 % lesréponses attendues dans PIRLS qui ne sontpas fournies par les élèves français pourcette raison. Ce pourcentage s’ajoute àcelui des absences de réponses au filde l’épreuve ; c’est donc au total 7,7 %(6,4 + 1,3) des réponses attendues que lesélèves français laissent vierges. Ceci a unimpact mécanique sur le niveau de leursperformances.

Marc Colmant etMarion Le Cam, DEPP B2

- « Les élèves de CM1 - Premiers résultats d’une évaluation internationale en lecture (PIRLS 2001) »,Note d’Information 03.22, MEN-DEPP, avril 2003.

- « Évolution des performances en lecture des élèves de CM1. Résultats de l’étude internationalePIRLS 2006 », Note d’Information 08.14, mars 2008.

- Site Internet de l’étude : http://timss.bc.edu/

Il est possible d’y télécharger notamment les documents suivants :

PIRLS 2011 Assessment Framework, août 2009 (présentation du cadre de l’étude) ;

PIRLS 2011 International Report, décembre 2012 (rapport international) ;

PIRLS 2011 Encyclopedia, septembre 2012 (guide de référence des systèmes éducatifs des paysparticipants).

Tous les documents des PIRLS 2001 et 2006 sont également disponibles à la même adresse.

www.education.gouv.fr/[email protected]

Pour en savoir plus

CadrePIRLS (Progress in International Reading Literacy Study) est pilotée parl’IEA (Association internationale pour l’évaluation du rendement scolaire)et mise en œuvre par l’International Study Center du Boston College.Les 45 pays sont les suivants : Allemagne, Angleterre, Arabie saoudite,Australie, Autriche, Azerbaïdjan, Belgique (Communauté francophone),Bulgarie, Canada, Colombie, Croatie, Danemark, Émirats arabes unis,Espagne, États-Unis, Fédération de Russie, Finlande, France, Géorgie,Hongrie, Indonésie, Iran, Irlande, Irlande du Nord, Israël, Italie, Lituanie,Malte, Maroc, Norvège, Nouvelle-Zélande, Oman, Pays-Bas, Pologne,Portugal, Qatar, Roumanie, Singapour, République slovaque, Républiquetchèque, Slovénie, Suède, Taïwan, Trinité-et- Tobago. En outre, certainesprovinces ont participé pour elles-mêmes : Alberta, Ontario, Québec(Canada) ; Floride (USA) ; Andalousie (Espagne), Hong Kong, Dubaï,Abu Dhabi (EAU).

L’échantillonEn France, l’enquête porte sur un échantillon de 174 écoles primaireset élémentaires. Le tirage de l’échantillon tient compte de la taille desécoles et de quelques caractéristiques (public/privé ; ZEP/hors ZEP).Au sein de chaque école, et suivant sa taille, une ou deux classes entièresont été retenues. L’échantillon français regroupe 4 438 élèves effective-ment évalués, répartis au sein de 277 classes.Au niveau international, l’échantillon porte sur 10 539 écoles et291 709 élèves.

Comparaison 2001-2006-2011Pour assurer la comparabilité dans le temps, l’évaluation PIRLS a réutiliséune partie des textes et leurs questions afférentes des évaluationsde 2001 et de 2006 pour celle de 2011. Ainsi, en 2011, l’ensemble duprotocole est composé de dix blocs (textes et questions) dont quatre(deux informatifs et deux narratifs) sont issus de l’épreuve de 2006 etdeux (un informatif et un narratif) de l’épreuve de 2001. Ces six blocs,qui avaient été gardés sous embargo, ont ainsi servi d’ancrage pour leséchelles de comparaison dans le temps. Ainsi, quatre blocs nouveauxont été introduits en 2011.

Les procédures de passationLa mise en œuvre de l’enquête est basée sur des procédures standar-disées afin de garantir la comparabilité des résultats : désignationde responsables de l’enquête dans chaque établissement, respect des

consignes de passation, procédures de contrôle, etc. L’évaluation, detype « papier-crayon », est fondée sur la technique dite des « cahierstournants ». Les textes et leurs questions ont été répartis dans treizecahiers d’évaluation différents, à raison de deux textes par cahier, enménageant des parties communes. Ces treize cahiers ont été distribuésaléatoirement aux élèves (à raison d’un seul cahier par élève), qui avaientdeux fois 40 minutes pour y répondre. Ce procédé a ainsi permis de testerl’équivalent de près de 7 heures d’évaluation sans allonger le tempsde passation individuel.En ce qui concerne les questionnaires de contexte, ils sont au nombre dequatre et ont dû être renseignés par les élèves eux-mêmes ; leurs parents ;leurs enseignants ; ainsi que les directeurs des écoles concernées.Ces questionnaires de contexte permettront de cerner l’environnementdes élèves et d’apporter des informations supplémentaires sur leurrapport à la lecture, éclairant ainsi certains résultats.

La construction des scoresUne échelle de score a été élaborée en utilisant des modèles statistiquesparticuliers (modèles de réponse à l’item : MRI). Cette approche permetde distribuer les performances des élèves sur une même échelle même si,individuellement, ils ont répondu à des tests différents (cf. PIRLS 2011Technical Report). En 2001, la moyenne internationale a été fixée à 500et l’écart-type à 100. Pour permettre les comparaisons temporelles,les résultats de 2006 et 2011 ont été distribués sur cette échelle.Le choix d’une telle échelle est arbitraire, mais son intérêt est de permettrede classer les pays sur une dimension commune. On comprend que cetteméthodologie met l’accent sur une évaluation « relative » des performan-ces (comparaison de pays à pays), même si l’aspect évaluation « absolue »du niveau des performances n’est pas totalement absent.

Les correctionsLes questions à réponses construites ont été corrigées par un grouped’enseignants formés à cette tâche suivant des consignes internationalesstrictes par le biais d’une interface informatique. Dans chaque pays,un lot de cahiers a subi une double correction permettant de vérifierle degré d’accord des correcteurs. D’autre part, pour vérifier la fiabilitédes corrections entre chacun des pays participants, un lot de copiesa été corrigé par les correcteurs de tous les pays. Enfin, pour maîtriserune éventuelle évolution dans la sévérité des correcteurs d’un cycle àl’autre de l’étude, une étude de fiabilité a été réalisée en proposant auxcorrecteurs de 2011 un lot de copies de 2001 et 2006.

Méthodologie