Tadti crs3-n

Click here to load reader

-

Upload

mohamedchaouche -

Category

Data & Analytics

-

view

64 -

download

0

Transcript of Tadti crs3-n

Régression Linéaire Multiple

Massih-Réza Amini

Techniques d’Analyse de Données et Théorie de l’InformationMaster M2 IAD – Parcours Recherche

http://www-connex.lip6.fr/~amini Laboratoire d’Informatique de Paris 6 [email protected]

Plan

Définition,

Historique,

Interprétation géométrique de la solution,

Lien avec l’analyse de Corrélation Canonique,

Récapitulatif – solutions de VPG

Laboratoire d’Informatique de Paris 6 [email protected]

Régression Linéaire Multiple

Les modèles de régression tentent de trouver une relation entre deux variables aléatoires x∈ℜp et y∈ℜ

On cherche à trouver une dépendance fonctionnelle entre les sorties réelles comme fonction des entrées

De prévoir la valeur de y connaissant celle de x

En régression linéaire la forme de la dépendance fonctionnelle est une droite: y=xtw+w0

Il s’agit ici d’estimer une variable réelle par une combinaison linéaire des caractéristiques d’entrée

Cas particulier de la corrélation canonique avec q =1.

( )pw,...,w1

Laboratoire d’Informatique de Paris 6 [email protected]

Historique

Le premier travail sur la régression linéaire à été publié par Legendre en 1805.

La méthode des moindres carrés.

Gauss prétendait la connaissance de cette méthode depuis 1795.

Legendre et Gauss ont appliqué cette méthode pour prédire l’orbites des planètes à partir des observations astronomiques

Gauss a publié en 1821 une théorie sur la méthode des moindres carrésIncluant une version du théorème Gauss-Markov

D’autres études ont été menées tout le 19ème et le début de 20ème siècle pour décrire des phénomènes biologiques et étendues à un contexte statistique général par Pearson, Yule (1877,1885) et Fisher (1922).

Laboratoire d’Informatique de Paris 6 [email protected]

Régression au sens des moindres carrées

On cherche une fonction f :ℜp →ℜ qui prédit la valeur de y connaissant x

On suppose qu’il existe une relation entre x et y à travers une distribution de probabilité jointe p(x,y)

Pour trouver les paramètres de la fonction f on définit une fonction de risque L(y,f(x)) qui pénalise les erreurs de prédictions.

Laboratoire d’Informatique de Paris 6 [email protected]

Régression au sens des moindres carrées (2)

Au sens des moindres carrées la fonction de risque est

Pour trouver la fonction qui minimise cette expression il suffit de minimiser ECM pour tout x

La solution est

( ) ( )( )( )( ) ( )

( )( )[ ][ ]XXfYEE

dxdyy,xpxfy

XfYEfECM

X

X Y2

2

2

−=

−=

−=

∫ ∫

( ) ( )[ ]xXcYEminargxf XYc

=−= 2

( ) ( )XYExf =

Laboratoire d’Informatique de Paris 6 [email protected]

Interprétation géométrique

L’espace de toutes les variables aléatoires sur le même expérimental forme un espace de Hilbert si on le munit du produit scalaire

Dans ce cas pour des variables centréesLa norme des variables centrées est leur écart-type,La covariance entre X et Y est le produit scalaire des variables.

Pour des variables centrées, l’espérance de X est la projection orthogonale de X sur la droite des constantes.

( )XYEY,X =

Laboratoire d’Informatique de Paris 6 [email protected]

Interprétation géométrique (2)

Soit LX le sous-espace de Hilbert constitué des variables aléatoires fonctions seulement de X.

On peut montrer que LX est fermé et contient la droite des constante DC

L’opérateur qui associe à chaque variable aléatoire son espérance conditionnelle à X est un opérateur linéaire idempotent E(Y |X) est donc le projecteur orthogonal de Y sur LX

Laboratoire d’Informatique de Paris 6 [email protected]

Interprétation géométrique (3)

E(Y |X) est une projection orthogonale sur LX, le minimum de

est atteint pour f(X)=E(Y|X).

( )( )[ ] ( ) 22 XfYXfYE −=−

0

Y

DC

LX

f(X)=E(Y|X)

||Y -

f(X)||

2

Laboratoire d’Informatique de Paris 6 [email protected]

Poids de la combinaison linéaire - Résolution analytique

Pour chaque entrée x ∈ℜp on cherche à prédire une sortie réelle suivant un modèle linéaire.

f(x)=xtwEn supposant qu’on cherche à déterminer les paramètres w sur un ensemble d’apprentissage (x1, y1) … (xn, yn).

Le critère d’optimisation est l’erreur carrée moyenne (ECM)

( )( ) ( )XwYXwY

wxy)w(ECM

t

n

i

tii

−−=

−= ∑=1

2

Laboratoire d’Informatique de Paris 6 [email protected]

Poids de la combinaison linéaire - Résolution analytique (2)

Les dérivées partielles d’ordre 1 et 2 de ECM en fonction de Β sont :

Si X t.X est non singulière (i.e. det(X t.X )≠0), il existe alors une solution unique qui minimise ECM :

Pour une entrée X le modèle prédit la sortie :

( )

XXww

ECM

XwY.X.w

ECM

tt

t

2

2

2=

∂∂∂

−−=∂

∂

( ) YXXXw tt 1−=

( ) YXXXXwXY tt 1−==

Laboratoire d’Informatique de Paris 6 [email protected]

Poids de la combinaison linéaire - Résolution analytique (3)

La solution de la régression vérifie

La réponse du modèle, est la projection orthogonale de Y sur l’espace des données.

( ) ( ) 0=−=− YYXwXYX ttw

x1

x2

Y

Y

Y

( ) YXXXXwXY tt 1−==

Matrice de projection

Laboratoire d’Informatique de Paris 6 [email protected]

Poids de la combinaison linéaire - Résolution VPG

Pour des variables X et Y centrées la solution de la régression est

D’après la relation de Pythagore

xyxx CCw 1−=

Y

Y

LX

Y

||Y||YY −

222 YYYY +−=

Minimiser ⇔ Maximiser 2

YY −2

Y

⇔ Maximiser ( )Y

YY,Ycos =

Pour des variables centrées, cos(Y,f(X))=cor(Y,f(X)) ⇒ Lien avec l’ACCLaboratoire d’Informatique de Paris 6 [email protected]

Poids de la combinaison linéaire - Résolution VPG (2)

Le but de la régression est donc de trouver w qui maximise

La dérivée partielle de c par rapport à w

Et

( )wCwY

Cw

XwXwY

YXwXw,Ycoscxx

t

xyt

tt

tt===

( )wCCwCwYw

cxxwxy

xxt λ−=

∂∂ 1

wCwCw

xxt

xyt

w =λ

xyxx CCw 1−∝

Laboratoire d’Informatique de Paris 6 [email protected]

Le cas où Y réel régression

xi

yi

ii yy −ˆ

iy

Laboratoire d’Informatique de Paris 6 [email protected]

Le cas où Y∈{-1,1} classification

x t.β2 +γ

O = 0

x1

x2

y

x1

Laboratoire d’Informatique de Paris 6 [email protected]

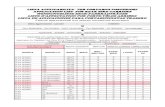

RécapitulatifRésolution de B-1Aw=λw

AFD

B = SwA = SB

Trouver la direction w qui discrimine au mieux les classes en projection

ACP

B = IA = Cxx

Trouver les directions w qui déforment le moins possible les distances en projection

ACC

⎟⎟⎠

⎞⎜⎜⎝

⎛=

00

yx

xy

CC

A

⎟⎟⎠

⎞⎜⎜⎝

⎛=

yy

xx

CC

B0

0

Trouver les directions wx et wy qui maximisent le carré de corrélation entre X et Y

RLMTrouver la combinaison linéaire Xw la plus proche de

Y au sens ERM

Laboratoire d’Informatique de Paris 6 [email protected]

Clustering contrainte avec des variétés géométriques

Laboratoire d’Informatique de Paris 6 [email protected]

Algorithmes de Clustering

But : Regrouper (ou segmenter) une collection de données en différents ensembles, tel que les individus d’un groupe donné soient plus liés les uns des autres (au sens d’une similarité) qu’avec ceux d’autres groupes.

Un objet peut-être décrit par un ensemble de mesures ou par sa relation à d’autres objets.

Deux étapes itératives : Définition de la relation entre individus avec une mesure de similarité (distance euclidienne, score, …)Décision pour le partitionnement (entropie, …)

Laboratoire d’Informatique de Paris 6 [email protected]

Algorithme de Kmeans

Laboratoire d’Informatique de Paris 6 [email protected]

Clustering - Kmeans

20ème itération-4 -2 0 2 4 6

-20

24

6Initialisation centroïdes

2ème itération-4 -2 0 2 4 6

-20

24

6-4 -2 0 2 4 6

-20

24

6

Laboratoire d’Informatique de Paris 6 [email protected]

Algorithme CEM

∑ ∑∈

=ui Xx k

iikiu

kyxptX

),(log1

Laboratoire d’Informatique de Paris 6 [email protected]

Nouveaux types d’algorithmes de clustering

Clustering par contraintesOn utilise l’a priori sur les classes des exemples

Clustering dans l’espace impliciteOn utilise l’a priori sur l’espace avec les noyaux

Clustering structuréOn utilise l’a priori sur l’hiérarchie

Laboratoire d’Informatique de Paris 6 [email protected]

Clustering utilisant l’a priori de classes et la structure des données

Idée nouvelle (2004)On cherche un graphe sans boucle connectant les exemples,On fait propager les étiquettes des exemples étiquetés sur ce graphe jusqu’à convergence.

Solution partielleSi on a plusieurs classes, il faut appliquer l’algorithme plusieurs fois à la suite sur chacune des classes.

Laboratoire d’Informatique de Paris 6 [email protected]

Problème jouet en 2D: clowns

Laboratoire d’Informatique de Paris 6 [email protected]

Méthode de clustering avec les variétés géométriques (Zhou et al. ICML 2004)

Laboratoire d’Informatique de Paris 6 [email protected]

Méthode de clustering avec les variétés géométriques (Zhou et al. ICML 2004)

Laboratoire d’Informatique de Paris 6 [email protected]

α=0.3

Laboratoire d’Informatique de Paris 6 [email protected]

α=0.6

Laboratoire d’Informatique de Paris 6 [email protected]

α=0.6, classe 2