IV. Provision Best Estimate, marge de risque, approche ... · Présentation du modèle ... Modèle...

Transcript of IV. Provision Best Estimate, marge de risque, approche ... · Présentation du modèle ... Modèle...

1

Sommaire:

I. Introduction........................................................................................................................... 4

II. Solvency 2, présentation et contexte actuel....................................................................... 4

III. Approche standard, approche par les modèles internes ................................................ 6

III.1. Présentation ................................................................................................................... 6

III.2. Utilités d’un modèle de risque globale ......................................................................... 6

III.3. Etapes de calcul d’un modèle interne............................................................................ 7

IV. Provision Best Estimate, marge de risque, approche "coût du capital" ...................... 9

IV.1. Présentation................................................................................................................... 9

IV.2. Best estimate ................................................................................................................. 9

IV.3. Marge de risque (MVM), approche de calcul par le coût du capital (Cost of Capital)

.................................................................................................................................................. 10

V. Capital de solvabilité requis (SCR).................................................................................. 13

V.1. Mesures de risque VaR ou TVaR................................................................................. 13

V.2. Horizon temporel.......................................................................................................... 14

V.3. Capital porteur de risque .............................................................................................. 14

V.4. Minimum du capital requis (MCR) .............................................................................. 15

V.5. Capital de solvabilité requis (SCR) .............................................................................. 15

VI. Actif et risques de marché............................................................................................... 19

VI.1. Présentation................................................................................................................. 19

VI.2. Modélisation des actions et des actifs immobiliers..................................................... 19

VI.2.1. Introduction...................................................................................................... 20

VI.2.2. Présentation du modèle .................................................................................... 21

VI.3. Modélisation des obligations, modèle de taux ............................................................ 21

VI.3.1. Présentation...................................................................................................... 22

VI.3.2.Le modèle de COX, INGERSOLL et ROSS .................................................... 23

VI.3.3.Limites de ce modèle ........................................................................................ 23

VI.4. Corrélation et dépendance........................................................................................... 24

VII.4.1. Présentation..................................................................................................... 24

VI.4.2. Les limites de la covariance ............................................................................. 24

VI.4.3. Théorie des copules.......................................................................................... 25

VI.4.3.1. Quelques définitions ............................................................................ 25

VI.4.3.2.Copule archimédienne, copule elliptique.............................................. 27

2

VII. Passif et risque d’assurance non-vie ............................................................................. 30

VII.1. Présentation................................................................................................................ 30

VII.2. Modélisation dynamique des cash-flows futurs ........................................................ 30

VII.3. Calcul de la provision Best Estimate à la date t = 0 (BE (0)) .................................... 32

VII.4. Calcul de la distribution du montant total de sinistres payés de 0 à 1 ....................... 33

VII.5. Calcul du Best Estimate à la date t = 1 (BE(1))......................................................... 33

VIII. Outils mathématiques et statistiques .......................................................................... 34

VIII.1. Processus stochastiques usuelles .............................................................................. 34

VIII.2. Méthodes statistiques pour l’estimation des paramètres .......................................... 35

VIII.2.1. Modèle de régression linéaire, moindres carrées ordinaires (MCO)............. 35

VIII.2.2. Modèle de régression non linéaire, moindres carrées non ordinaire ............. 36

VIII.2.3. Méthode des moments, méthode mu maximum de vraisemblance............... 37

VIII.3. Méthode de simulation Monte-Carlo ....................................................................... 37

VIII.3.1. Présentation ................................................................................................... 38

VIII.3.2. Simulation de distributions discrètes............................................................. 38

VIII.3.2. Simulation de distributions continues ........................................................... 40

IX. Estimation des paramètres et application numérique.................................................. 44

IX.1. Modèles des actifs ....................................................................................................... 44

IX.1.1. Modèle de Merton............................................................................................ 44

IX.1.2. Modèle de taux (CIR) ...................................................................................... 48

IX.1.3. Copule Student ,vt∑ .......................................................................................... 49

IX.2. Modèles des passifs..................................................................................................... 51

IX.2.1. Application du modèle ..................................................................................... 51

IX.2.2. Estimation des paramètres ............................................................................... 52

IX.3. Application numérique................................................................................................ 54

IX.3.1 Modèle de Merton............................................................................................. 54

IX.3.2. Modèle de taux (CIR): ..................................................................................... 55

IX.3.3. Copule Student ,vt∑ .......................................................................................... 55

IX.3.4. Valeur du portefeuille ...................................................................................... 57

IX.3.5. Provision Best Estimate………………..……………………………….…….64

IX.3.6. Résultat du calcul du SCR ............................................................................... 72

X. Provision technique « fair value » (juste valeur ou valeur de marché) ........................ 75

3

X.1. Présentation .................................................................................................................. 75

X.2. Transformation de WANG........................................................................................... 76

XI. Conclusion ........................................................................................................................ 78

XII. Annexes ........................................................................................................................... 79

Bibliographies…...………..……………………………………………………………….…82

4

I. Introduction:

Un des sujets les plus sensibles actuellement dans le monde de l’assurance européen

porte le nom de « Solvency II ». Ce mémoire va se consacrer pleinement à cette

problématique. D’abord, un bref rappel de Solvency II sera présenté avec ses approches de

calculs. Ensuite, je développerai une approche de calcul du capital de solvabilité requis par un

modèle interne appliqué à un assureur non-vie fictif. Pour cela, je considérerai un portefeuille

d’actifs composé d’actions, de titres immobiliers et d’obligations d’état, le passif de l’assureur

sera constitué uniquement des provisions pour les sinistres connus ou non déclarés, mais

survenus, toutes les autres provisions ne seront pas prises en compte. Les modèles

stochastiques seront développés judicieusement, à savoir Merton pour les actions et les titres

immobiliers, Cox-Ingersoll-Ross pour les obligations d’état et le mouvement brownien

géométrique pour les sinistres. Par la suite, je calculerai le capital de solvabilité requis en

projetant le bilan de l’assureur dans 1 an avec l’aide de méthodes de simulation Monte-Carlo.

La marge de risque (MVM) et le minimum du capital requis (MCR) seront évoqués mais ne

seront pas calculés explicitement. Les risques pris en compte sont : risque de taux d’intérêt,

risque d’actions, risque de titre immobilier et le risque d’assurance, tous les autres risques

sont négligés.

II. Solvency 2, présentation et contexte actuel :

La réforme de la réglementation européenne sur les nouvelles normes de solvabilité

est très nettement engagée, dans un cadre global Solvency II, sur les traces de la réforme

bancaire Bâle II. Les réflexions en cours et travaux d’analyses relatifs à cette réforme sont

assurés au sein du Ceiops, comité européen réunissant les autorités de contrôles des vingt-cinq

pays associés.

Dans ce contexte, les assureurs européens ont été interrogés en 2005 sur leurs

provisions techniques et les méthodes d’évaluation harmonisées, comme le Best Estimate ou

l’évaluation par Quantiles qui est présentée notamment dans l’étude d’impacts QIS1

(Quantitative Impact Study). Les études suivantes, le QIS2, lancée en 2006 et le QIS3 en 2007

ont eu pour objectif de mieux cerner les contours d’une formule standard d’évaluation du

capital de solvabilité requis, le SCR (Solvency Capital Requirement), et la méthode de

détermination des besoins en capital minimum, le MCR (Minimum Capital Requirement).

5

Selon l’idée que la marge de solvabilité correspond aux fonds propres, c’est-à-dire la

différence entre les actifs et les engagements de passifs, le principe directeur dans la recherche

des besoins de couverture de la solvabilité des assureurs est la mise en œuvre d’une

probabilité de ruine à moins de 0,05 %.

Un des principes le plus important de Solvency II est basé sur le fait que les actifs (les

placements) et les passifs (les engagements) doivent tous être évalués à leur valeur de marché.

La différence entre la valeur de marché actuelle des passifs, d’une part, et l’estimation non

biaisée de la valeur actualisée (discounted best estimate) de l’espérance mathématique des

flux de paiements afférents, d’autre part, est appelée marge sur la valeur de marché ou

« market value margin » (MVM).

Les risques considérés dans le Solvency II sont les risques de marché, de crédit, de

souscription vie et non vie et le risque opérationnel.

6

III. Approche standard, approche par les modèles internes :

III.1. Présentation:

Le projet de Solvabilité II a pour but d’établir un référentiel harmonisé et cohérent à

l’ensemble des sociétés d’assurance européennes. Deux modes de calcul du besoin en capital

d’une compagnie d’assurance, à priori opposés, sont à l’étude : la formule standard et les

modèles internes.

Dans le premier cas, un ensemble de calculs simplifiés reposant sur des données

comptables et des indicateurs connus, permettent d’établir un besoin minimum de capital,

admis comme relativement arbitraire. Cependant, cette approche s’avère très coûteuse pour

les assureurs, car ses formules sont calibrées pour tous les assureurs et du coup, le capital

requis est généralement supérieur à celui qu’il doit réellement disposer.

Dans le deuxième cas, le CEIOPS prévoit notamment d’inciter les sociétés à mieux

modéliser leurs risques en les autorisant à construire des modèles internes. Cette voie est bien

plus complexe à mettre en œuvre. L’idée de départ est néanmoins simple et pragmatique : la

réalisation de modélisations personnalisées et globales des portefeuilles d’assurance à travers

la prise en compte des passifs, des actifs, et surtout de leurs interactions respectives. Le besoin

en capital pour la solvabilité peut alors s’apprécier directement à la lecture des résultats

générés par le modèle. Ces modèles peuvent être envisagés complètement libres ou structurés

par branche de risques.

Dans quelques années, gageons que les modèles internes mis en place par les

compagnies serviront principalement à leur gestion quotidienne des risques, et accessoirement

aux obligations réglementaires de solvabilité ; ceci est d’ailleurs un des souhaits du projet de

la directive Solvency II.

III.2. Utilités d’un modèle de risque globale :

Cette partie est extraite du livre de FITOUCHI [2005]

a) Les raisons internes à la compagnie :

Le premier objectif est l’identification et la mesure des risques liés à l’activité. En

particulier, l’assureur essaie de quantifier le niveau de capital minimum qui correspond au

7

risque de ruine qu’il estime acceptable. L’optique de l’assureur est de gérer ses risques à un

niveau qu’il juge correct compte tenu de sa structure.

Le deuxième objectif d’un modèle interne est de fournir au groupe d’assurances un

cadre de référence où la rentabilité exigée d’une activité dépend du risque qu’elle fait

supporter à la compagnie. Le modèle permet de déterminer quelles branches sont les plus

risquées et pour quelles rentabilités afin de pouvoir réaliser des arbitrages en ce qui concerne

les stratégies de développement de certaines d’entre elles.

Le modèle permet aussi de disposer d’un outil pour la gestion opérationnelle (politique

de prise ou cession de risque, mesure de performance, allocation d’actif, politique

d’intéressement, de participation aux bénéfices).

b) Les raisons externes à la compagnie

L’objectif principal est la nécessité de pouvoir répondre aux attentes ou aux exigences

d’acteurs externes à l’entreprise (les banques, les agences de notation, les marchés financiers).

Certains groupes anticipent également une évolution des exigences réglementaires.

D’une façon très générale, les modèles de risques globaux essaient :

- de modéliser la distribution de probabilité des fonds propres réels, ou « capital

économique », à un horizon de temps donné ;

- de calculer « un besoin de capital économique », indicateur qui correspond à un

niveau de risque global accepté par l’entreprise ;

- de définir, enfin, sur la base du cadre formulé précédemment, une règle

d’allocation du capital économique aux différentes activités.

III.3. Etapes de calcul d’un modèle interne:

D’après PLANCHET, THEROND, JACQUEMIN [2005], un modèle interne consiste

à simuler les flux futurs de l’entreprise de manière à déterminer une fonction reliant le niveau

des fonds propres au « risque » de l’entreprise. Sa mise en place nécessite donc la

détermination de ce qui caractérise le risque de l’entreprise (la faillite), le choix d’une mesure

de risque (VaR, TVaR) et enfin la modélisation de l’entreprise (actif, passif, actif-passif).

La simulation des flux futurs de l’entreprise va donc nécessiter de modéliser les

éléments qui sont à la source de ces flux : les sinistres et les placements. Généralement, le

8

choix d’un modèle se fonde sur l’hypothèse implicite que la variable modélisée aura dans le

futur le même comportement que par le passé. Ceci se traduit notamment dans le choix des

paramètres qui sont estimés sur des données historiques.

N.B. Pour certaines variables pour lesquelles les données historiques sont trop peu

nombreuses, les modèles devront être déterminés de manière ad hoc (avis d’experts par ex.).

Le modèle doit notamment intégrer, à l’actif :

- évolution des cours et des dividendes/loyers des actifs financiers (actions,

OMPCVM, immobilier, etc.),

- évolution des taux d’intérêt,

- évolution de l’inflation,

- dépendance entre ces différents éléments,

- défaut des émetteurs d’obligations

et au passif :

- survenance et montants de sinistres,

- sinistres catastrophiques,

- défaut des réassureurs,

- dépendance entre les branches.

Dans ce mémoire, par souci de simplicité, certaines des éléments cités ci-dessus ne

seront pas pris en compte.

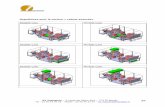

Voici le schéma de la structure d’un modèle interne :

Figure 1 : Structure d’un modèle interne

Générateur de nombres aléatoires

Estimation des paramètres &

Tests d’adéquation

Modèles

Actif Discrétisation

9

V. Provision Best Estimate, marge de risque, approche par le coût du

capital:

IV.1. Présentation:

Un des principes essentiels de Solvency II est que les actifs (placements) et les passifs

(engagements) doivent être évalués à leur valeur de marché actuelle. Pour de nombreuses

positions financières telles que les actions ou les obligations, la valeur de marché est connue

puisque ces actifs font l’objet d’un négoce. Les passifs techniques ont quant à eux une valeur

de marché que l’on ne peut pas relever et des flux de trésorerie dont l’espérance

mathématique peut seulement être estimée. C’est pourquoi, lorsqu’on veut calculer la valeur

de marché d’une position actuarielle, il faut d’abord modéliser la marge sur la valeur de

marché. Lorsqu’un portefeuille est en liquidation (run-off), l’assuré ne subit aucun dommage si

un tiers prend en charge le risque inhérent au portefeuille en liquidation. Tel est le cas lorsque

l’assureur dispose d’un capital porteur de risque suffisant pour supporter le risque, ou

lorsqu’une instance extérieure (un autre assureur, un investisseur, un bailleur de fonds)

reprend le portefeuille ou injecte du capital dans l’entreprise – ce qui revient au même. Dans

le deuxième cas, l’instance extérieure doit mettre du capital-risque à disposition pour la

liquidation. Elle sera prête à le faire en contrepartie d’une indemnisation.

Le prix d’un passif technique se compose donc d’un montant correspondant à sa

liquidation attendue et d’une indemnisation pour le risque encouru, indemnisation dont la

définition recoupe parfaitement celle de la marge sur la valeur de marché donnée ci-dessus.

Le projet de directive actuel indique que la valeur des provisions techniques sera égale

à la somme du best estimate et d’une marge de risque.

IV.2. Best estimate:

La notion de best estimate est définie par l’extrait suivant : « La meilleure estimation

est égale à la moyenne pondérée par leur probabilité des flux de trésorerie futurs, compte tenu

de la valeur temporelle de l’argent (valeur actuelle probable des flux de trésorerie futurs),

déterminée à partir de la courbe des taux sans risque pertinente. Le calcul de la meilleure

10

estimation est fondé sur des informations actuelles crédibles et des hypothèses réalistes et il

fait appel à des méthodes actuarielles et des techniques statistiques adéquates »

IV.3. Marge de risque (MVM), approche de calcul par le coût du capital (Cost of

Capital):

Comme un passif n'arriverait pas à trouver preneur au prix du 'Best Estimate', une

quantité complémentaire doit être ajoutée au 'Best Estimate' pour pouvoir qualifier l'ensemble

de "valeur de marché" des provisions. Cette quantité supplémentaire qui permettrait alors de

vendre ces passifs, c'est la marge de risque ou 'Market Risk Margin' (MVM).

Il existe encore deux écoles qui s'affrontent en IARD pour pouvoir déterminer cette

'Market Risk Margin', soit le 'Cost of Capital', soit l'approche par les quantiles.

Le 'Cost of Capital' est défini comme le coût du capital qu'un tiers, un réassureur par

exemple, reprenant le stock de provisions', devrait immobiliser pour supporter le risque

jusqu'à extinction complète de ces provisions.

La notion de la marge sur la valeur de marché est valable en tout temps. En règle

générale, on veut connaître la valeur de marché actuelle, soit en t=0. Dans le Swiss Solvency

Test (SST), c’est surtout à la valeur en fin d’année soit t=1 qu’on s’intéresse, je traiterai donc

la marge sur la valeur de marché sous cet angle.

D’après la méthode « coût du capital », sur la base de l’écart de taux d’intérêt (spread)

et du capital risque nécessaire chaque année après t = 1, on peut définir la marge sur la valeur

de marché comme

_31 2(0) (0) (0) 2 (0) 3 (0) _

1 1 2 3 _

(1)(0) ...1 (1 ) (1 ) (1 ) (1 )

run offspread run off

run off

SCRSCRSCR SCRMVMMVM ir r r r r

⎛ ⎞= = + + +⎜ ⎟⎜ ⎟+ + + + +⎝ ⎠

1SCR : inclure les risques de marchés et de crédit.

iSCR (i > 1) : limités aux risques de souscription et risques opérationnels, risques de

crédit/concentration du réassureur.

6%spreadi CoC= = : Coût du capital pour un assureur qui est noté BBB.

11

Remarque : La marge sur la valeur de marché n’appartient pas au bailleur de capital risque

mais à l’assuré.

Il est important de comprendre aussi que la marge sur la valeur de marché doit

indemniser le repreneur pour les risques techniques, mais pas pour tous les risques encourus.

Imaginons un portefeuille qui se compose d’une part de passifs techniques et d’autre part

d’instruments existants (actifs) qui répliquent au mieux les passifs. Pour un portefeuille non-

vie, ce pourraient par exemple être des emprunts souverains générant le flux de trésorerie

attendu par les passifs. La marge sur la valeur de marché ne doit indemniser que les risques de

ce portefeuille. En revanche, elle ne doit pas couvrir les risques de marché du portefeuille

d’actifs existant, dont la composition est généralement différente de ce qu’elle serait dans un

portefeuille de réplication optimale.

Simplification :

Le futur SCR de l’année 1 (SCR1) inclura les risques de marché et de crédit, et les

futurs SCR à partir de l'année 2, seront limités au risque de souscription et au risque

opérationnel et aux risques de crédit/concentration du réassureur. Pour calculer les substituts

des futurs SCR, on estime que l’assureur a calculé le futur SCR à l’année 1(SCR’1) en

incluant uniquement les risques de souscription, opérationnel et de réassurance.

12

Voici le schéma pour calculer la marge de risque :

1

2

3

1 2

Discount the cost of holding future SCR's at the risk-free rate to get the CoC Risk Margin (RM)

3 4 5 ...

Steps to calculate the Risk Margin under a Cost-of-Capital approach

1 2 3 4 5 ...

Project the SCR for future years until run-off of the current liability portfolio

Determine the cost of holding future SCRs, by multiplying the projected SCR by the CoC factor

in

ii vSCRfactorCoCRM ××= ∑

=1_

Figure 2 : Etapes de calcul de la marge de risque.

13

V. Capital de solvabilité requis (SCR):

Notons SCR (Solvency Capital Requirement) le capital de solvabilité requis pour

l’assureur.

Avant de définir le capital requis, il convient d’introduire deux notions de mesure de

risque : la Value at Risk (VaR) et Tail Value At Risk (TVaR).

V.1. Mesures de risque VaR ou TVaR:

Le but de la mesure de risque est généralement de pouvoir représenter par un chiffre

réel une incertitude ou une grandeur dont la valeur est inconnue, à l’aide d’un étalon de

mesure adéquat, de manière à pouvoir exprimer l’exposition au risque de cette grandeur. Dans

ce mémoire, on va utiliser la mesure Value At Risk ou VaR.

a) Définition de la VaR :

La Value-at-Risk (VaR) de la variable aléatoire X au niveau de sécurité 1-α est

définie par

( , ) inf{ | Pr( ) }VaR X x X xα α= ≤ ≥

b) Définition de la TVaR :

La Tail Value at Risk (TVaR) de la variable aléatoire X au niveau de sécurité 1-α est

définie comme l’espérance mathématique conditionnelle E de X, pour X plus petit ou égal à la

VaR au niveau de sécurité 1-α :

[ ]( ) | ( )TVaR X E X X VaR Xα α= ≤

Au même niveau de sécurité, la TVaR est un étalon de mesure de risque plus prudent

que la VaR. Dans la réalité, une distribution des dommages présentera certainement quelques

pertes extrêmement élevées mais dont la probabilité est très faible. Pour ces cas, la TVaR est

plus appropriée que la VaR car elle intègre aussi l’ampleur de ces pertes extrêmes.

14

Contrairement à la VaR, la TVaR quantifie le coût moyen de l’un des 100. %α pires

événements. En pratique, on constate que la TVaR est plus stable que la VaR De plus, elle

présente aussi d’autres propriétés mathématiques intéressantes comme la cohérence.

Malgré tous les avantages de la TVaR par rapport à la VaR, la mesure de risque

utilisée pour déterminer le capital de solvabilité requis dans ce mémoire est la VaR afin de

permettre la comparaison des résultats du calcul de la formule standard.

Un autre objet qui intervient dans le calcul du capital de solvabilité requis est le capital

porteur de risque.

V.2. Horizon temporel:

L’horizon temporel retenu dans ce modèle interne est d’un an. Les calculs doivent

inclure tous les risques provenant de la poursuite du business pendant cet horizon. Toute

l’information reçue durant cet horizon et affectant la position financière de l’assureur doit être

prise en compte pour l’estimation du SCR.

V.3. Capital porteur de risque:

Le capital porteur de risque (CR) est le capital qui peut être utilisé pour compenser les

fluctuations des affaires. Il est défini comme la différence entre la valeur de marché actuelle

des actifs et l’estimation non biaisée de la valeur actualisée de l’espérance mathématique des

passifs.

à la date t = 0 : CR(0) = A(0) – BE(0)

à la date t = 1 : CR(1) = A(1) – BE(1)

Le capital porteur de risque en t = 0 (CR(0)) se détermine à partir des actifs et des

passifs, à l’aide du bilan établi à la valeur de marché actuelle. Il est donc connu. En revanche,

le capital porteur de risque futur (CR(1)) est une inconnue, car l’environnement de

l’entreprise est elle-même inconnue : il s’agit donc d’une valeur aléatoire.

Le montant du capital porteur de risque en fin d’année est indicatif de la valeur de

marché des actifs par rapport à celle des passifs :

15

CR < 0 Actifs < Passifs Best Estimate

0 < CR < MVM Passifs Best Estimate < Actifs < Valeur de marché des passifs

MVM < CR Valeur de marché des passifs < Actifs

Si le capital porteur de risque en fin d’année est supérieur à la marge sur la valeur de

marché, la valeur des actifs est supérieure à la valeur de marché des passifs.

Si CR(1) < MVM(1), le portefeuille en liquidation n’est pas suffisamment capitalisé.

Le risque inhérent à ce portefeuille ne peut donc pas être couvert par le capital porteur de

risque et aucun bailleur de fonds externe ne serait intéressé à l’assumer. Ce risque est donc

supporté entièrement et exclusivement par les assurés.

Tant que le capital porteur de risque reste positif, l’espérance mathématique des

passifs est certes inférieure à la valeur des actifs, mais le risque que les règlements de sinistre

excèdent cette valeur peut cependant être très élevé. Si le capital porteur de risque est négatif,

les actifs ne couvrent même pas l’espérance mathématique des passifs.

V.4. Minimum du capital requis (MCR):

MCR : Niveau de fonds propres en deçà duquel l’entreprise d’assurance présente un

risque inacceptable de ne pas pouvoir faire face à ses engagements.

Le calcul de ce montant ne sera pas abordé dans le cadre de ce mémoire. On peut

prendre simplement MCR = 1/3 SCR.

V.5. Capital de solvabilité requis (SCR):

SCR : niveau de capital qui permet à l’assureur d’absorber des pertes significatives. Il

doit être calibré de telle sorte à jouer un rôle d’alarme. Autrement dit, il est le capital

nécessaire pour couvrir le risque pendant 1 an. Le SCR est donc formulé de façon à ce que la

probabilité de réalisation de l’événement CR(1) < MVM(1) soit la plus faible possible.

Mathématiquement :

[ ](1) | (0) (0) (1)VaR CR CR SCR MVM MVMα = + =

16

Soit (0)1

(1) (0)1CRSCR VaR CR

rα

⎛ ⎞= − −⎜ ⎟+⎝ ⎠

Où CR(t) = A(t) – BE(t) : capital porteur de risque à la date t.

A(t) : valeur du portefeuille d’actif à la date t.

BE(t) : valeur de la provision best estimate à la date t.

t = 0 : date de calcul

t = 1 : l’horizon du calcul

Remarque : Bien que le capital porteur de risque dépend de la marge (MVM), la

variation de ce capital ne l’est pas.

Preuve :

On a :

(0) (0)1 1

(1) (1) (1)(0) (0) (0)1 1CR FP MVMCR FP MVM

r r+

− = − −+ +

Or

(0)1

(1) (0)1

MVM MVMr

=+

Par construction

Donc

(0) (0)1 1

(1) (1)(0) (0)1 1CR FPCR FP

r r− = −

+ + qui est indépendant de la marge.

Avec FP(t) =Actif(t) –Provision technique(t) représentant le niveau du fond propre à la date t.

On peut comprendre ainsi : MVM(1) est l’indemnisation que l’assureur doit payer à

l’acquéreur en plus des montants de sinistres attendus à la date t=1 s’il devait céder ses passifs

à la fin de l’exercice. Pour cela il doit construire une provision pour cette marge à la date t=0

qui est noté MVM(0).

Preuve de la formule de calcul du SCR :

α =0,05%, on cherche le niveau de SCR qu’il faut disposer aujourd’hui pour que l’actif dans

1 an soit inférieur au passif dans 1 an à moins de 0,05%.

17

( )( )( )

(0) (0)1 1

(0)1

(1) (1) | (0) (0)

(1) (1) (1) (1) | (0) (0)

(1) (1) | (0) (0)

(1) (1) | (0) (0)1 1

(1) ((0)1

P Actif Passif CR SCR MVM

P Actif BE Passif BE CR SCR MVM

P CR MVM CR SCR MVM

CR MVMP CR SCR MVMr r

CR MVMP CRr

α

α

α

α

≤ = + ≤

⇔ − ≤ − = + ≤

⇔ ≤ = + ≤

⎛ ⎞⇔ ≤ = + ≤⎜ ⎟+ +⎝ ⎠

⇔ − ≤+ (0)

1

(0) (0)1 1

(0)1

(0)1

1) (0) | (0) (0)1

(1) (1)(0) (0)1 1

(1) (0)1

(1) (0)1

CR CR SCR MVMr

CR MVMP CR MVM SCRr r

CRP CR SCRr

CRSCR VaR CRrα

α

α

α

⎛ ⎞− = + ≤⎜ ⎟+⎝ ⎠

⎛ ⎞⇔ − ≤ − − ≤⎜ ⎟+ +⎝ ⎠

⎛ ⎞⇔ − ≤ − ≤⎜ ⎟+⎝ ⎠

⎛ ⎞⇔ = − −⎜ ⎟+⎝ ⎠

La valeur des actifs dans 1 an est égale à la valeur de marché de nos actions,

immobiliers et obligations dans 1 an plus la valeur des coupons tombés et diminuées des flux

payés pour les sinistres pendant l’année. Toutes ces valeurs sont inconnues à la date t = 0 sauf

les coupons des obligations d’état.

La valeur des passifs Best Estimate dans 1 an est également inconnue en t = 0, elle est

calculée comme l’espérance des montants de sinistres payés en t>1 actualisés

conditionnellement aux aléas de la période 0 à 1.

Ici, j’ai considéré que la composition du portefeuille est inchangée pendant l’année, les

sinistres sont payés en fin d’année et si les coupons ne sont pas suffisants pour payer les

sinistres, il y aura la liquidation de certaines actions ou obligations…

18

Je termine ce chapitre par un schéma simplifié du bilan économique d’une compagnie

d’assurance.

Figure3 : Bilan économique simplifié

Actifs

Placements: Actions, obligations…

Fair Value

Capital Libre

MCRMMVVMM

Best Estimate

FFoonnddss PPrroopprreess SSCCRR

PPrroovviissiioonnss TTeecchhnniiqquueess

19

VI. Actifs et risques de marché :

VI.1. Présentation:

Le risque de marché est le risque de fluctuation du capital porteur de risque sous l’effet

de modifications de la situation conjoncturelle ou de facteurs économiques, désignés ici par

facteurs de risque.

Dans le modèle présenté ici, une allocation d’actifs est fixée initialement (en t=0). Elle

est censée représenter l’allocation optimale reflétant l’équilibre que la compagnie souhaite

maintenir à long terme dans son portefeuille. Cette allocation cible s’exprime en pourcentages

représentant les différentes lignes d’actifs.

Mon portefeuille simplifié se compose de 2 actions, 1 obligation d’état et 1 actif

immobilier.

Les cours des actions et des immobiliers sont modélisés par le processus de Merton

tandis que l’obligation d’état est déduite de la courbe de taux d’intérêt sans risque dont

l’évolution suit le modèle de Cox-Ingersoll-Ross (CIR).

Ensuite, ces actifs n’évoluent pas indépendamment, ils sont corrélés entre eux et avec

les indices des marchés sur lesquels ils sont côtés. Les deux indices choisis sont le CAC 40

pour les actions et l’Euronext CAC Real Estate IX pour les actifs immobiliers. Les structures

de dépendance seront modélisées par la copule de Student qui est choisie pour prendre en

compte la dépendance des valeurs extrêmes.

Enfin, pour connaître la valeur de marché de l’actif en t > 0, les scénarios

économiques doivent projeter des primes de risque d’où la nécessité d’être en « monde réel ».

Exemple : Les actions ne doivent pas évoluer simplement au taux sans risque car il est

primordial de connaître leur vrai rendement pour évaluer correctement les occurrences de

ruine.

Donc, l’espace de travail utilisé dans la modélisation des actifs est celui de probabilité

historique.

VI.2. Modélisation des actions et des actifs immobiliers :

Cette partie s’inspire de l’article « L’impact de la prise en compte des sauts boursiers

dans les problématiques d’assurance », PLANCHET, THEROND [2005].

20

VI.2.1. Introduction:

Pour modéliser l’évolution du prix d’un actif risqué, le modèle de Black & Scholes est

actuellement la référence pour les praticiens de l’assurance. Cependant, confronté à la réalité,

ce modèle n’est pas suffisamment robuste : en effet, il ne tient pas compte de toutes les

données économiques observées sur les marchés financiers. Notamment, ce modèle n’intègre

pas les variations brutales du cours du sous jacent dues à l’arrivée d’information, bonnes ou

mauvaises.

Dans le contexte actuel d’utilisation du modèle de Black et Scholes en assurance,

essentiellement dans le cadre de la détermination d’allocations stratégiques et de l’évaluation

d’options (pour des garanties « plancher » sur des contrats en unités de compte par exemple),

cette relative inadéquation du modèle à la réalité s’avère assez peu pénalisante. En pratique

elle est largement compensée par la facilité de mise en œuvre du modèle.

Toutefois, le projet Solvabilité 2 en cours d’élaboration modifie profondément les

règles de fixation du niveau des fonds propres en assurance en introduisant comme critère

explicite le contrôle du risque global supporté par la société. Ce risque devra notamment être

quantifié au travers de la probabilité de ruine.

Dans ce nouveau contexte, les inconvénients principaux de modélisations de type «

brownien géométrique » et notamment l’insuffisance de l’épaisseur des queues de distribution

(qui conduit à une trop faible représentation des évènements rares) et la non prise en compte

des chocs, à la hausse ou à la baisse, sur les cours (qui conduit à ne pas intégrer au modèle

d’évènements exceptionnels et brutaux) peuvent avoir des conséquences importantes sur

l’appréciation du niveau de capital nécessaire pour contrôler la ruine au niveau fixé. Ce point

est par exemple abordé dans BALLOTTA [2004] pour le cas des options cachées d’un contrat

d’épargne, et dans PLANCHET et THEROND [2005] dans le cadre d’un modèle mono

périodique simplifié en assurance non-vie pour la détermination d’un capital cible et

l’allocation d’actifs.

Compte tenu de la place privilégiée du mouvement brownien géométrique, je

m’intéresse ici aux modèles généralisant cette approche et incluant le mouvement brownien

géométrique comme cas particulier. Le modèle proposé par MERTON [1976] est de ce point

de vue assez naturel; c’est donc le modèle que je retiendrai. Je reprends le modèle proposé par

MERTON [1976] et je m’inspire pour cela de la démarche proposée par RAMEZANI et

ZENG [1998] pour l’estimation des paramètres par la méthode du maximum de

vraisemblance.

21

Pour conclure, les hypothèses de mes modèles me permettront, dans le cadre de

l’approche Solvabilité II, de mieux évaluer l’impact de variations du cours d’une action que

par le modèle classique de Black&Scholes. Si l’adéquation du modèle à nos échantillons n’est

pas acceptée, il est possible que cela provienne de la simplicité des hypothèses. Toutefois, il

est ardu de rajouter des paramètres sans que le modèle proposé devienne trop compliqué à

manipuler.

VI.2.2. Présentation du modèle:

Les actions, les titres immobiliers ainsi que les indices CAC40 et Euronext CAC Real

Estate IX sont modélisés par le modèle de Merton, l’évolution des prix est donnée par

l’équation suivante :

1

²( ) (0)exp ( )2

tN

t kk

S t S t B Uσμ σ=

⎧ ⎫= − + +⎨ ⎬

⎩ ⎭∑

Où :

S(t) : prix de l’actif à l’instant t.

0( )t tB B ≥= : Mouvement brownien.

0( )t tN N ≥= : Processus de Poisson homogène d’intensitéλ .

1( )k kU U ≥= : Suite de variables aléatoires indépendantes identiquement distribuées de

loi Normale (0, )uN σ .

Les processus B, N, U sont mutuellement indépendants.

Les sauts sont ici, dans un souci de simplicité, supposés symétriques et en moyenne nuls.

VI.3. Modélisation des obligations, modèle de taux :

Cette partie est tirée du livre de PLANCHET F., THEROND P et JACQUEMIN J.

[2005], « Modèles financiers en assurance », Editions Economica.

22

VI.3.1. Présentation:

Le prix d’une obligation quelconque de nominal N, de maturité T et de taux facial

ρ s’écrit :

( ) ( )1

1 11 ( , ) ( , ) 1 ( , ) ( , )

T

t i t T ti t

O Nr t i spread t i r t T spread t T

ρ − −= +

⎛ ⎞= × +⎜ ⎟

⎜ ⎟+ + + +⎝ ⎠∑

Où ( , )r t i est le taux sans risque à la date t et de maturité i.

Le spread de taux dépend de la probabilité de défaut de l’émetteur, cette probabilité

pouvant être modélisée à l’aide des copules gaussiennes.

Si l’obligation est sans risque, son prix se déduit des prix des zéros-coupons P(t, T) via

la formule :

1

( , ) ( , )T

ti t

O N P t i P t Tρ= +

⎛ ⎞= × +⎜ ⎟⎝ ⎠∑

Il faut donc pour valoriser ces titres obligataires déterminer le prix des zéros-coupons

ou bien construire une courbe de taux. Il existe 3 approches concernant les modèles de taux :

- Les modèles d’équilibre partiel reposant sur un raisonnement d’arbitrage.

Citons, par exemple, celui de VASICEK [1997] qui comporte une variable d’état et celui

de BRENNAN et SCHWARTZ [1979] qui en comporte deux.

- Les modèles d’équilibre général, tel que le modèle de COX, INGERSOLL et

ROSS [1985] basés sur une description globale de l’économie.

- Les modèles de déformation qui partent de la structure des taux d’intérêt

observés et lui font subir des chocs. Le modèle de HO et LEE [1986] ainsi que sa

généralisation proposée par HEATH, JARROW et MORTON [1987] sont sans aucun

doute les plus connus dans cette catégorie.

Le modèle de VASICEK donne parfois des valeurs négatives, donc on va utiliser le

modèle de COX, INGERSOLL et ROSS (CIR) dans ce mémoire.

23

VI.3.2.Le modèle de COX, INGERSOLL et ROSS [1985] :

Ce modèle, présenté en 1985, introduit un processus en racine carrée qui interdit à un

taux initialement positif de prendre des valeurs négatives, tout en conservant la simplicité du

processus de d’ORNSTEIN-UHLENBECK. Le processus de taux d’écrit sous la forme :

( )t t t tdr a b r dt r dBσ= − +

Où tr est le taux sans risque instantané, tB est un mouvement Brownien en « proba

historique ».

a, b, σ sont des paramètres à estimer

La valeur du zéro-coupon à l’instant t qui paie 1 en T est déterminée, par la formule

suivante :

[ ]( , ) ( , ) exp ( , ) tP t T A t T B t T r= − Où tr est le taux sans risque à la date t

et t < T,

{ }{ }

{ }{ }

22 /

2 2

2 exp ( )( ) / 2( , )

( )(exp ( ) 1) 2

2exp ( ) 1( , )

( )(exp ( ) 1 ) 2

2

aba T t

A t Ta T t

T tB t T

a T t

a

σγ γ

γ γ γ

γγ γ γ

γ σ

⎧ ⎫+ −⎪ ⎪= ⎨ ⎬+ − − +⎪ ⎪⎩ ⎭− −

=+ − − +

= +

VI.3.3.Limites de ce modèle:

Ce modèle présente l’inconvénient de stabiliser la queue de la structure des taux, le

taux à long terme est réduit à une constante indépendante de la forme de la structure. Or, d’un

point de vue purement économique, il n’est pas toujours approprié d’expliquer le marché des

titres obligataires par une seule variable explicative, le taux sans risque instantané. Ces

processus mono-factoriels, ne dépendant que d’une variable d’état, supposent une parfaite

corrélation entre les taux r(t, T), non satisfaite dans la pratique.

Toutes ces limites ont poussé les chercheurs à construire des modèles prenant en

considération plusieurs facteurs (notamment par BRENNAN et SCHWART [1979], [1980] et

LONGSTAFF [1989]).

24

VI.4. Corrélation et dépendance:

VII.4.1. Présentation:

Les actifs n’évoluent pas indépendamment, ils sont corrélés entre eux et avec les

indices des marchés sur lesquels ils sont côtés. Les deux indices choisis ici sont le CAC 40

pour les actions et l’Euronext CAC Real Estate IX pour les actifs immobiliers.

Pour connaître la distribution des valeurs d’un portefeuille, il est nécessaire de pouvoir

anticiper l’évolution conjointe des facteurs de risque. Les facteurs de risque d’un portefeuille

sont les rendements de ses sous-jacents qui sont modélisés à l’aide des Browniens et des

sauts. Ils constituent les composantes aléatoires des prix futurs.

Dans le modèle de Merton, la composante à sauts représente l’information propre au

titre, le brownien associé au marché. Donc négliger la dépendance entre les composantes à

sauts c’est dire que les informations spécifiques à l’entreprise sont indépendantes des

informations d’autres entreprises, ce qui peut se concevoir.

Il s’agit donc d’estimer la distribution conjointe d’une série des browniens. Mais

comme on dispose déjà de la loi marginale de chacun de ces browniens, il reste à déterminer

la manière dont ils évoluent ensemble, c’est-à-dire la structure de dépendance entre ces

browniens.

VI.4.2. Les limites de la covariance:

Une première solution serait d’utiliser la matrice de covariance (décomposition de

Cholesky) pour approximer la dépendance entre les Browniens. Toutefois, la covariance ne

permet pas de décrire correctement la dépendance entre ces derniers et ce pour 2 raisons.

La première est d’ordre théorique. La covariance ne permet de caractériser qu’une

dépendance linéaire entre 2 variables aléatoires. On peut rencontrer des situations où il n’y a

pas de dépendance linéaire entre 2 variables (leur covariance est donc nulle) sans pour autant

qu’elles soient indépendantes. Pratiquement, supposons que, suite à une modélisation

particulière, on obtient une covariance entre 2 taux de rendements de 2 actions appartenant à

un même secteur industriel. Il est évident qu’on ne peut pas conclure l’absence de dépendance

entre ces rendements.

La deuxième raison est d’ordre empirique. Les taux de rendements représentent un

comportement de dépendance extrême qui ne peut être modélisé par la covariance. Tant qu’ils

25

ne prennent pas des valeurs trop grandes, ils varient indépendamment. Mais lorsqu’ils

prennent des valeurs extrêmes, ils les prennent tous en même temps. On parle dans ce cas de

dépendance extrême. C’est typiquement le phénomène que l’on observe lors d’un crash

boursier. Tous les prix chutent très fortement ensemble.

Par conséquent, on ne peut donc se contenter de modéliser la dépendance entre les

rendements ou bien les Browniens par leur matrice de covariance. Il faut chercher à

approximer plus précisément la distribution conjointe des Browniens. La théorie des copules

présente des résultats qui permettent de modéliser une distribution conjointe. Et de parvenir à

une description plus complète de la dépendance entre les variables aléatoires.

VI.4.3. Théorie des copules :

VI.4.3.1. Quelques définitions :

Définition de la copule :

Soit [0,1]1 : ii n u U∀ ≤ ≤ , une copule C est définie comme une fonction de répartition

multivariée :

1 2 1 2:[0,1] [0,1] : ( , ,..., ) ( , ,..., )nn nC u u u C u u u→ →

Dont les marginales sont uniformes sur [0,1].

Théorème de Sklar :

Le théorème suivant fournit un lien entre les distributions multivariée, leurs

marginales, et une copule.

On a 1( ,..., )nX X un vecteur de variable aléatoire dimension n, avec la fonction de

distribution jointe 1,..., nX XF et les distributions marginales

1,...,

nX XF F , i.e. :

1 ,..., 1 1 1( ,..., ) ( ,..., )

nX X n n nF x x P X x X x= ≤ ≤ et ( ) ( )iX i i iF x P X x= ≤ { }1 1,..., n∀ ∈

Alors, il existe une unique copule telle que :

1 1,..., 1 1( ,..., ) ( ( ),..., ( ))

n nX X n X X nF x x C F x F x= [ ]1( ,..., ) , nnx x∀ ∈ −∞ +∞

26

Le théorème de Sklar est central dans la théorie des copules. En gros, il dit qu’on peut

généralement associer une copule à une distribution multivariée. Par conséquent une fonction

de distribution peut être divisée en 2 parties :

+ D’une part, les n fonctions de distributions marginales.

+ D’autre part, une copule reliant ces fonctions.

La copule caractérise entièrement la structure de dépendance stochastique de n

variables aléatoires.

Le théorème dit également que si les lois marginales d’un vecteur aléatoire sont

connues, chaque copule définit une et une seule distribution jointe. Autrement dit, il existe

une et une seule copule qui permet de reconstruire la distribution jointe à partir des

distributions marginales.

Mesure de dépendance de queue :

Une des propriétés des copules qui nous intéresse le plus dans le cadre de Solvency 2

est la dépendance de queue. Soit (X, Y) un couple aléatoire. On définit les coefficients de

queue inférieure et supérieure, respectivement par,

1 1

0lim Pr[ ( ) | ( )]L X Yu

X F u Y F uλ − −

→= ≤ ≤ et 1 1

1lim Pr[ ( ) | ( )]U X Yu

X F u Y F uλ − −

→= > >

Quand les limites existent.

Notons que ces coefficients dépendent uniquement de la copule du couple (X, Y) et

nullement des lois marginales : si (X, Y) admet la copule C, les coefficients de dépendance de

queue sont définis, dès lors que la limite existe, par

0

( , )limL u

C u uu

λ→

= et __

0

( , )lim1U u

C u uu

λ→

=−

où __

C désigne la copule de survie associé à C (c’est-à-dire la fonction de répartition du couple

(1-U, 1-V) si (U, V) admet pour la fonction de répartition C).

Les cas intéressants sont ceux où ces coefficients sont strictement supérieurs à 0

comme ils indiquent la propension des copules pour générer conjointement les évènements

27

extrêmes. Si Lλ > 0 par exemple, il y a une dépendance de queue dans la queue inférieure et si

Lλ = 0, il y a une dépendance asymptotique dans la queue inférieure.

VI.4.3.2.Copule archimédienne, copule elliptique :

En générale il existe 2 familles de copules, les copules archimédiennes et les copules

elliptiques.

a) Les copules archimédiennes :

Définition :

La copule archimédienne de générateur ϕ est définie par

l’égalité ( )11 1( ,..., ) ( ) ... ( )n nC u u u uϕ ϕ ϕ−= + + , dès lors que

1( ) (0)

n

ii

uϕ ϕ=

≤∑

et 1( ,..., ) 0nC u u = , sinon. Le générateur choisi doit être de classe 2C de sorte que (1) 0ϕ = ,

' ( ) 0uϕ ≤ et '' ( ) 0uϕ > .

La notion de la copule archimédienne regroupe un certain nombre de copules comme

CLAYTON, GUMBEL, FRANCK.

Nom Copule

Clayton ( ) 1/( , , ) 1C u v u v

θθ θθ−− −= + −

Franck 1 (exp( ) 1)(exp( ) 1)( , , ) ln 1exp( ) 1u vC u v θ θθ

θ θ⎛ ⎞− − − − −

= +⎜ ⎟− −⎝ ⎠

Gumbel

( ) ( )1/

( , , ) exp ln( ) ln( )C u v u vθθ θθ ⎛ ⎞⎡ ⎤= − − + −⎜ ⎟⎣ ⎦⎝ ⎠

b) Les Copules elliptiques :

Les copules elliptiques sont des copules de distributions elliptiques. Un vecteur

aléatoire X de dimension n suit une distribution elliptique si leurs fonctions caractéristiques

peuvent s’exprimer comme suivant :

1( ) exp( . . ). ( . . . )2

T TX t i t t tϕ μ ϕ= ∑

28

Où

μ est le vecteur colonne des moyennes, et ∑ est la matrice de covariance.

ϕ est la fonction caractéristique.

Parmi les copules elliptiques, les copules Normale et Student ont des propriétés

intéressantes :

-Elles sont symétriques, i.e. si un vecteur 1( ,..., )nU U est distribué selon une de

ces 2 copules, on a 1 1( ,..., ) (1 ,...,1 )n nU U U U− − . Il en résulte que 2 mesures de

dépendance de queues Lλ et Uλ sont égales et sont dénotéesλ .

-Il existe un lien simple entre les composantes de la matrice ∑ et le Tau de

Kendall d’une paire de variables aléatoires. Nelsen(1999) et Embrechts(2001) ont

montré que le Tau de Kendall dépend de la copule et non des distributions marginales.

Il existe 2 copules phares dans la famille des copules elliptiques :

b.1) Copule Normale :

Une copule Normale est une copule de la distribution normale multivariée. Cette

copule a une matrice R comme paramètre. La densité de la copule Normale est de la forme :

11 1/ 2

1 1( ,..., ) .exp '( ).| | 2

NormaleR nc u u S R I S

R−⎛ ⎞= − −⎜ ⎟

⎝ ⎠

où 1( )j jS u−= Φ , 1−Φ est l’inverse de la fonction de répartition de la loi N(0,1) et I est

la matrice d’identité de dimension n.

Cependant la copule Normale ne présente pas la dépendance de queue, i.e. 0Normaleλ = .

b.2) Copule Student :

La copule Student a comme paramètres un nombre réel v et une matrice R de

dimension ( n n× ). La densité de la copule Student s’écrit :

21

1/ 2, 1 2 1

2

1

11 '. .( ) ( )2 2( ,..., ) | | . . .1( ) ( ) (1 )2 2

v nn

StudentR v n vn

j

j

v n v S R Svc u u R v v S

v

+−

−

−+

−

=

⎛ ⎞+ ⎛ ⎞ +Γ Γ ⎜ ⎟⎜ ⎟ ⎝ ⎠= ⎜ ⎟+⎜ ⎟Γ Γ +⎝ ⎠ ∏

29

Où 1( )j v jS T u−= , 1vT − est l’inverse de la fonction de répartition de la loi Student univariée de v

degré de liberté.

b.3) Copule Normale et Copule Student :

Contrairement à la copule Normale, la copule Student montre une dépendance de

queue positive. Cela veut dire qu’il y a moins de valeurs extrêmes générées par la copule

Normale que par la copule Student.

c) Distinction entre les copules elliptiques et les copules archimédienne :

Les copules archimédiennes sont souvent utilisées mais elles ont un

désavantage majeur : elles représentent la structure de dépendance avec peu de paramètres (un

ou deux dans la plupart des cas), qui ne sont pas très cohérents en pratique avec la complexité

des structures observées. Ces copules sont donc irréalistes pour modéliser la dépendance dans

des dimensions supérieures à deux.

Par contre, les copules elliptiques sont particulièrement adaptées à la modélisation des

structures de dépendance en dimension n≥ 2. En effet, l’introduction de la matrice de

corrélation ∑ comme un paramètre multidimensionnel donne une grande flexibilité pour ce

qui est de la forme de la structure et est plus facile à interpréter que les paramètres des copules

archimédiennes.

Donc pour des raisons de facilité de calibration et pour ses qualités dans la prise en

compte des mouvements extrêmes, je vais utiliser la copule Student pour modéliser la

structure de dépendance entre mes titres d’actifs.

30

VII. Passif et risque d’assurance non-vie:

VII.1. Présentation:

Le risque d’assurance, ou risque technique, est le risque de fluctuation du capital

porteur de risque sous l’effet de la réalisation aléatoire des risques assurés d’une part et des

incertitudes propres à l’estimation des paramètres actuariels d’autre part. Il peut être aussi

défini comme le risque que la réserve doit être réévaluée suite à des nouvelles informations.

Ce risque est divisé en risque stochastique et risque de paramètre. Le premier est le risque que

la fluctuation aléatoire des paiements de sinistres rend insuffisants les réserves établies par

l’assureur et le deuxième est le risque concernant l’estimation des paramètres du modèle.

Dans ce mémoire, le passif de l’assureur sera constitué uniquement des provisions

pour les sinistres connus ou non déclarés, mais survenus.

Provisions = IBNR + PSAP

Avec IBNR : provisions pour les sinistres survenus mais pas encore déclarés

PSAP : provisions pour les sinistres survenus dont les coûts n’ont pas été

entièrement réglés.

Ces deux provisions seront estimées à partir d’un triangle de paiement, avec les années

de survenance et les années de développement.

Pour commencer, je vais exposer la méthode de modélisation des paiements de

sinistres.

VII.2. Modélisation dynamique des cash-flows futurs :

Les assureurs doivent de plus en plus raisonner sur la base d’une gestion actif-passif

de leurs risques en donnant toute l’intensité de leurs efforts sur le passif, et non plus se

contenter des modèles historiques ALM, dont l’objectif est principalement lié à une correcte

allocation des actifs. Ce renversement de tendance en direction d’une gestion des risques de

passif constitue une opportunité rare dans l’histoire de l’assurance.

Normalement, les cash-flows futurs (coûts des sinistres…) sont modélisés de manière

statique, i.e. pour quelques dates dans l’avenir, à 1 an, à 2 ans par exemple. On en déduit la

provision technique en actualisant ces cash-flows à la date d’évaluation au taux

correspondant.

31

Dans ce mémoire, j’utilise un modèle dynamique pour représenter les cash-flows

futurs. Cela permet d’être cohérent avec la modélisation des actifs financiers d’où une gestion

actif-passif plus efficace cependant cette idée ne sera pas développé par la suite du mémoire.

En effet, l’actualisation sera effectuée avec les cash-flows aux dates spécifiques (en fin

d’année).

Ce qui suit dans cette partie s’inspire de l’article de HAYER [2001]. Le modèle

développé est une généralisation du modèle « Lognormal age-to-age », HAYNE [1985]. Le

modèle de HAYNE suppose que le facteur de développement suit une loi log-normale.

L’évolution du montant cumulé des sinistres tP se décrit par un processus

stochastique :

( ) ( )t t t tdP t Pdt t PdBμ σ= +

Où tB est un mouvement Brownien, ( )tμ , ( )tσ sont respectivement le taux

d’augmentation marginal et le coefficient proportionnel des montants cumulés.

On en déduit que le facteur de développement suit la loi log-normale :

2 2

2

1 1 1

2 21( ) ( ) , ( )2

t tt

t t t

PLN t t dt t dt

Pμ σ σ

⎛ ⎞⎛ ⎞→ −⎜ ⎟⎜ ⎟⎜ ⎟⎝ ⎠⎝ ⎠∫ ∫ (*)

Ce modèle est appelé le mouvement Brownien géométrique et est fréquemment utilisé

dans le monde financier, l’exemple le plus connu est la formule d’évaluation du prix d’option

de Black-Scholes.

Les éléments que l’on souhaite connaître concernant les passifs sont la provision Best

Estimate à la date 0, la distribution de la provision Best Estimate à la date 1 et la distribution

du montant total de sinistres payés de 0 à 1.

Supposons qu’on a un triangle de paiement suivant avec n années de développements

et la dernière année de survenance est 2006 (rappelons que la date de calcul est 29/12/2006).

32

Année de développement

1 2 n

2006-n+1

Ann

ée d

e su

rven

ance

2006

Les données dans les cases blanches sont disponibles.

VII.3. Calcul de la provision Best Estimate à la date t = 0 (BE (0)):

Pour calculer le BE(0), je dois remplir les cases jaunes du tableau par les montants

moyennes des paiements futurs actualisés aux taux sans risque. Ensuite, la provision Best

Estimate à la date 0 est la somme de ces cases jaunes.

De 1 1

, 1 2 2

,

1( ) ( ) , ( )2

j ji j

i j j j

PLN t t dt t dt

Pμ σ σ

+ ++

⎛ ⎞⎛ ⎞→ −⎜ ⎟⎜ ⎟⎜ ⎟⎝ ⎠⎝ ⎠∫ ∫

En appliquant la formule de calcul de la fonction génératrice de moment d’une

variable aléatoire suivant la loi normale, je trouve :

1 1 12 21 1( ) ( ) ( ) ( )

2 2, 1

,

j j j

j j j

t t dt t dt t dtdti j

i j

PE e e

P

μ σ σ μ+ + +⎛ ⎞− +⎜ ⎟⎝ ⎠+∫ ∫ ∫⎡ ⎤

= =⎢ ⎥⎢ ⎥⎣ ⎦

Où i : année de survenance du sinistre et j : année de développement.

Les taux d’actualisation sont obtenus à partir de la courbe de taux sans risque actuelle.

De manière générale, la 2ème diagonale est actualisée avec le taux 1 an, la 3e avec le

taux 2 ans, et ainsi de suite jusqu’à la dernière valeur en bas à droite du triangle.

33

VII.4. Calcul de la distribution du montant total de sinistres payés de 0 à 1 :

En utilisant la technique de Monte Carlo, je simule un nombre important de fois la

deuxième diagonale en se basant sur la distribution log-normale des facteurs de

développement. Le montant total de sinistres payés de 0 à 1 est la somme des éléments de

cette diagonale.

VII.5. Calcul du Best Estimate à la date 1 (BE(1)) :

Dans cette partie, je vais utiliser une méthode dite « simulations dans les

simulations ». Pour cela, je simule tous les aléas qui peuvent survenir dans la période 0 à 1

(ici les paiements de sinistres et le taux d’intérêt sans risque), la provision Best Estimate à la

date 1 doit être construite conditionnellement à ces aléas.

En fait, pour chaque 2ème diagonale simulée, en supprimant la première ligne et la

première colonne, j’obtiendrai un nouveau triangle de taille diminuée de 1. Ensuite, je

procède de la même manière que pour le calcul du BE(0) avec les nouvelles données tout en

gardant les mêmes hypothèses sur la distribution des facteurs de développements ainsi que la

forme des fonctions ( )tμ et 2 ( )tσ . Par contre suite aux aléas en 2007, les paramètres de ces

dernières fonctions vont changer.

Un autre paramètre qui va changer aussi est le taux d’actualisation. Avec le modèle

CIR, j’obtiens un échantillon de taux sans risque instantané dans 1 an noté 1r ; les taux

d’actualisations en t = 1 sont obtenus par :

[ ]1(1, ) (1, ) exp (1, )P T A T B T r= −

34

VIII. Outils mathématiques et statistiques:

Avant d’aborder le calibrage des modèles, je voulais présenter brièvement quelques

objets mathématiques importants, et des méthodes d’estimations usuelles qui seront utilisés

dans le cadre de ce mémoire.

VIII.1. Processus stochastiques usuelles :

a) Mouvement brownien :

On rappelle ici les propriétés essentielles de cet objet.

Le mouvement brownien est le plus célèbre des processus de Lévy. C’est un processus

stable, continu (il ne fait aucun saut), ce qui ne l’empêche pas d’être complexe (il est à

variation infinie).

Le mouvement brownien est un processus qui satisfait par construction les trois

propriétés suivantes :

- Accroissements indépendants : les bouts de trajectoires sont indépendants les uns des

autres.

- Accroissements stationnaires.

- Continuité : la continuité est l’absence de saut.

Un processus de Lévy est simplement un processus qui vérifie les deux premières mais

pas forcément la troisième.

b) Processus de Poisson :

Le processus de Poisson est un outil extrêmement utilisé tant pour la modélisation des

sinistres (dans les modèles de type Poisson-composé) que dans les modèles d’actifs dans

lesquels on souhaite introduire des sauts.

On considère des évènements qui se produisent à des dates aléatoires, et on s’intéresse,

pour tout t > 0 au nombre d’évènements qui se sont produits au cours de l’intervalle ]0, ]t , que

l’on note N(t).

Définition et quelques propriétés intéressantes :

35

On définit alors le processus de Poisson d’intensité 0λ > comme le processus N(t)

satisfaisant les conditions suivantes :

- P1 : le processus est à accroissements indépendants, i.e. 1 20 ... nt t t∀ ≤ < < , les

variables aléatoires 1( ) ( ), 1,...,i iN t N t i n−− = sont globalement indépendantes.

- P2 : Le processus est à accroissements stationnaires, i.e. , 0t h∀ > , la loi de

( ) ( )N t h N t+ − ne dépend que de h.

- P3 : ( ( ) ( ) 1) ( )P N t h N t h o hλ+ − ≥ = + et ( ( ) ( ) 2) ( )P N t h N t o h+ − ≥ =

La condition P3 signifie que sur un petit intervalle de temps, on observe 0 ou 1

événement, et que la probabilité d’observer un événement est proportionnelle au temps

écoulé. On peut remarquer que N(0) = 0.

Les trajectoires sont par définition croissantes, continues à droite avec une limite à

gauche. Elles croissent par sauts d’une unité.

On vérifie par ailleurs sans difficulté que si ( )1tN et ( )2

tN sont deux processus de

Poisson indépendants d’intensité respectives 1λ et 2λ , alors 1 2t t tN N N= + est un processus de

Poisson d’intensité 1 2λ λ+ . Pour le vérifier on remarque que tN est un processus à

accroissements indépendants et stationnaire, et qu’il vérifie également P3.

Ce résultat admet la réciproque suivante : si tN est un processus de Poisson et que nT

désigne l’instant du ièmen saut, et si on se donne des variables aléatoires de Bernoulli nX

indépendantes des instants de saut et de paramètre p, on peut construire deux processus en

affectant les sauts de tN à l’un si 1nX = , à l’autre sinon, les 2 processus ainsi obtenus sont

des processus de Poisson indépendants, de paramètre respectifs pλ et (1 )p λ− .

VIII.2. Méthodes statistiques pour l’estimation des paramètres:

VIII.2.1. Modèle de régression linéaire, moindres carrées ordinaires (MCO) :

Soit le modèle suivant Y XB σε= + où 2(0, )Nσε σ→ . Les paramètres à estimer sont

B et σ .

36

On considère une variable d’intérêt y appelée variable dépendante et un ensemble de K

variables dites explicatives auquel on adjoint une constante. On dispose de N observations

notés ( )_

1 2, ,..., Ny y y y= de la variable dépendante. On définit de même les vecteurs _ _

1,..., Kx x

et _

x la matrice des variables explicatives à laquelle on adjoint le vecteur constant

'(1,...,1)e = : _ _ _

1, ,..., Kx e x x⎛ ⎞= ⎜ ⎟⎝ ⎠

est donc une matrice de dimension N x (K+1).

Définition :

L’estimateur des moindres carrés ordinaires est défini comme le vecteur b de

dimension K + 1, ( )_ '

0 ,..., Kb b b= , des coefficients de la combinaison linéaire de _ _

1, ,..., Ke x x

réalisant le minimum de la distance de _

y à l’espace vectoriel de NR engendré par

_ _

1, ,..., Ke x x , pour la norme euclidien : 2_ _^

arg minmcob y xb= −

Proposition 1 :

Sous l’hypothèse H1 : les vecteurs _ _

1, ,..., Ke x x sont indépendants,

L’estimateur des moindres carrés existe, est unique et a pour expression

1_ _ _ _^

' 'mcob x x x y−

⎛ ⎞= ⎜ ⎟⎝ ⎠

Et pour les résidus, on a : :

2^

1

( 1)

n

mcoi ii

y b x

n Kσ∧

=

⎛ ⎞−⎜ ⎟⎝ ⎠=− +

∑

VIII.2.2. Modèle de régression non linéaire, moindres carrées non ordinaire:

De même que la régression linéaire, on a le modèle suivant ( )Y X B σε= + où

2(0, )Nσε σ→ . Les paramètres à estimer sont B et σ .

Sauf qu’ici X(B) est une fonction non linéaire, mais le principe d’estimation des

paramètres reste le même.

37

A savoir 2_ _^

arg min ( )mcob y x b= −

VIII.2.3. Méthode des moments, méthode mu maximum de vraisemblance:

Définissons une population par :

( ; ),

( ) ( ; )

m

k kk k

X f x R

E X x f x dx

θ θ

μ μ θ θ

∈

⎡ ⎤ = = =⎣ ⎦

→

∫

Et 1

1

,...,1n

nk

k ii

x x

M xn =

= ∑ statistique observable

a) Méthode des moments :

L’estimateur de moment est obtenu en égalant les moments théoriques et les moments

empiriques.

θ∧

est solution de ( ) 1,...,k kM k mμ θ= = .

En effet, on doit résoudre m équations à m inconnus 1,..., mθ θ

b) Méthode du maximum de vraisemblance :

C’est la plus populaire des méthodes d’estimations.

L’estimateur du maximum de vraisemblance (MLE) de θ est obtenu comme

1 1( ,..., ) arg max ( , ,..., )n nx x l x xθ

θ θ∧

=

Où l est la fonction de vraisemblance qui est définie par : 11

( , ,..., ) ( ; )n

n ii

l x x f xθ θ=

=∏

VIII.3. Méthode de simulation Monte-Carlo :

Le projet Solvency II implique le passage des méthodes déterministes aux méthodes

stochastiques. Le terme « stochastique » amène à l’utilisation de tirages aléatoires respectant

38

des lois de probabilité et permettant d’obtenir une distribution des résultats et ainsi de

représenter le plus fidèlement possible la réalité des risques portés par une compagnie

d’assurance.

Le développement nécessaire de modèles internes en particulier fait donc appel aux

méthodes et outils stochastiques présentés ci-après

VIII.3.1. Présentation:

L’idée sous-jacente est d’approcher le résultat théorique (qui peut être une statistique

associée à une distribution, comme son espérance, sa fonction de répartition, ou, plus

généralement, toute fonctionnelle associée à la distribution étudiée) en effectuant des tirages

dans la loi du phénomène observé.

Pour pouvoir utiliser les modèles de simulations, que ce soit en Assurance Vie, avec

les méthodes de tirages aléatoires, en Assurance Non-Vie, avec les modèles « fréquence-coûts

», ou en finance avec les processus stochastiques il est donc nécessaire de savoir simuler des

réalisations des différentes lois de probabilité.

L’ensemble de ces techniques est généralement regroupé sous le vocable de «

méthodes de Monte-Carlo ». Il en existe de différents types, adaptés à la loi que l’on souhaite

simuler et au contexte. Mais, dans tous les cas, la génération de nombres aléatoires de loi

uniforme est essentielle à toute technique de simulation, du fait de l’utilisation de méthodes

type « inversion de la fonction de répartition ».

VIII.3.2. Simulation de distributions discrètes:

a) Méthode d’inversion :

Le principe est ici de découper l’intervalle [0;1] en sous intervalles dont les bornes

sont les Σ pi croissantes. Ce découpage est dû au fait qu’il n’existe pas obligatoirement de

bijection entre les différentes modalités de la distribution entière et l’intervalle [0;1], puisque

la fonction de répartition d’une distribution entière est en escaliers. L’indice de la borne

supérieure de l’intervalle ainsi créé dans lequel se trouvera le nombre aléatoire de loi

uniforme simulé donnera la valeur simulée de notre distribution.

39

Algorithme :

Si Y a pour loi ( ) ,k kP Y y p k N= = ∈ et si [ ]0,1U Uniforme→

alors, 10

0 0

01

1 1 i n

j jj j

U p ip U pi

y y−

= =

≤ ⎧ ⎫⎪ ⎪< ≤≥ ⎨ ⎬⎪ ⎪⎩ ⎭

+∑ ∑

∑ a même loi que Y.

Exemple : Simuler une réalisation de la loi Poisson(3)

P (X = k) = pk = !

k

ek

λ λ− , k ∈ N, F(k) fonction de répartition/ F(k) = P(X ≤ k)

p0 = 0,049

Simuler une réalisation u de la loi uniforme U(0,1)

+ Si u ≥ p0, on a une réalisation de 0 de la loi simulé

+ Si u < p0, on prend k tel que u > F(k)

Remarque : Il est à noter que cette méthode, très générale, peut être coûteuse en temps de

calcul suivant les cas. Pour chacune des lois entières connues, il existe des méthodes de

simulations particulières, qui s’avèrent beaucoup plus performantes.

b) Méthode de la composition :

Seconde méthode “classique” de simulation pour les distributions entières, ou même

absolument continues, la méthode de la composition a pour objectif de décomposer la densité

de probabilité de la variable aléatoire en mélange de fonctions de densité. Cette

décomposition peut se faire à partir des probabilités conditionnelles.

Méthodologie :

Soit X la variable aléatoire réelle dont nous cherchons une réalisation x.

La méthode de la composition propose de chercher g et Y telles que

( ) ( ) ( )i ii

P X x P Y y g x Y Y= = = =∑

Pour simuler une réalisation de X, il faut simuler un premier nombre aléatoire 1u pour

trouver y réalisations de Y tell que 1( )P Y y u= = puis générer un autre nombre aléatoire 2u

afin d’en déduire 2( )x g u Y y= =

40

Exemple : Une distribution Binomiale Négative BN(r, p) est une distribution Poisson-

Gamma (r, p/q)

Ainsi, il est possible d’utiliser cette propriété pour simuler une distribution Binomiale

Négative, à partir de la méthode de la composition, en deux étapes :

+ Simulation d’une réalisation λ de la loi Gamma (r, p/q),

+ Simulation d’une réalisation de la loi de Poisson de paramètre λ.

On obtient ainsi une réalisation de la loi BN(r, p).

Remarque : Dans cet exemple, et contrairement à la présentation de la méthode, c’est la loi

discrète (loi de Poisson) à laquelle nous appliquons le conditionnement, et non pas la loi

absolument continue, mais il est bien évident que le principe reste le même.

VIII.3.2. Simulation de distributions continues:

a) Méthode de l’inversion de la fonction de répartition :

Classiquement, c’est l’une des méthodes les plus utilisées en simulation, au moins

lorsque la puissance de l’outil informatique permet les calculs, et que l’inversion de la

fonction de répartition est possible, ce qui nécessite le plus souvent une expression analytique

simple de cette fonction.

Proposition : Soit Y une variable aléatoire réelle à valeurs dans R de fonction de répartition

YF . On pose :

1( ) inf{ : ( ) }Y YF u y F y u− = ∈ ≥ , [0,1]u∈

Si 1( )Ydom FU U −→ alors 1( )YF U− et Y ont la même loi.

Ainsi, pour simuler un n-échantillon i.i.d. d’une loi ayant pour fonction de répartition

F, il suffit de simuler n réalisations indépendantes d’une v.a.r. de loi uniforme sur l’intervalle

[0;1], puis d’appliquer l’inverse de la fonction de répartition à chacune de ces valeurs. Ceci

montre tout l’enjeu d’une simulation “optimale” des réalisations d’une loi uniforme, puisque

les seules approximations résident dans cette opération quand l’inversion de la fonction de

répartition est possible de manière analytique.

41

Exemple : Loi Exponentielle ε (q)

Cette loi dépend d’un unique paramètre θ > 0.

La fonction de répartition F de la loi exponentielle est donnée par :

( ) 1 xF x e θ−= −

Grâce à l’expression analytique de cette fonction de répartition, nous pouvons

facilement extraire :

1 1( ) ln(1 )F u uθ

− = − − .

Ainsi, on simule une réalisation u de la loi normale U(0,1), et on obtient une

simulation de X par x = 1( )F u−

Avantage:

+ Facile à comprendre et à implémenter.

+ Cette méthode permet de simuler, notamment, les lois suivantes :

- La loi exponentielle ( )E θ

- La loi de Pareto ( , )P a α

- La loi de Weibull ( , )W τ α

- La loi Normale 2( , )N μ σ

Inconvénient :

+ L’inverse de la fonction de répartition est rarement disponible.

+ Lemme d’inversion ne s’applique qu’en dimension 1.

+ Algorithme résident sur machine seulement pour lois usuelles.

b) Méthode du rejet :

Dans le cas où l’on ne connaît pas la forme exacte de la fonction de répartition, une

solution est de simuler une loi de proposition « plus simple » et d’utiliser un algorithme

d’acceptation-rejet.

Algorithme d’acceptation-rejet :

Soit une loi d’intérêt de densité f et une loi de proposition g telle que ( ) ( )f x Mg x≤

sur le support de f. Alors, on peut simuler suivant f avec l’algorithme suivant

42

Générer x g→ et ([0,1])u U→

Accepter y = x si

( )( )

f xuMg x

≤

Retourner en 1) si rejet

Remarque : Le choix de g et de M doit être fait comme suit :

+ g est une fonction de densité “simple”, que nous savons simuler,

+ M est une constante le plus proche de 1 que possible (ce qui améliore la

qualité du générateur),

+ La probabilité d’acceptation est égale à 1/M, donc la valeur de M règle

l’efficacité (vitesse) de l’algorithme.

Exemple :

On cherche à simuler une loi X qui admet comme densité la fonction

( ) exp( ² / 2)f x x= −

On sait que 2( 1) 1xe− − ≤ soit

2 2 1 1x xe− + − ≤ soit 2

12

x

x

e ee

−

− ≤

Donc, on va prendre 2( ) 2 xg x e−= qui est la densité de la loi d’exponentielle de

paramètre 2 et le constant M = e/2.

Probabilité d’acceptation = 1/M = 2/e = 0,74

Appliquons maintenant l’algorithme de simulation :

Nous simulons un couple (u1, x1) de v.a.r. indépendantes de lois respectives U ([0;1])

et Exponentielle(2).

Si u1 ≤ ( 1)( 1)

f xMg x

, alors nous gardons X = x1

Si u1 > ( 1)( 1)

f xMg x

, alors nous rejetons X = x1, simulons un autre couple (u2, v2)

c) Méthode de la composition :

Utilisée pour les simulations de distributions entières, la méthode de la composition se

généralise aux distributions absolument continues.

43

Méthodologie : Soit X la v.a.r. dont nous cherchons une réalisation x.

Soit Xf la densité de probabilité de X.

La méthode de la composition se propose de chercher g et YF telles que :

( ) ( ) ( ( ))X Yf x g x y d F y= ∫

Pour simuler une réalisation de X, il faut alors simuler un premier nombre aléatoire u1

pour trouver y réalisation de Y telle que F = u1 puis de générer un autre nombre

Aléatoire u2 afin d’en déduire x = g (u2 | Y = y).

Exemple :

Nous voulons simuler une loi qui est un mélange de 2 autres lois continues connues

( )X Exponentielle λ→ et ( , )gamma a bλ →

+ Simulation d’une réalisation λ de la loi Gamma (a, b),

+ Simulation d’une réalisation de la loi d’Exponentielle de paramètre λ.

Nous obtenons ainsi une réalisation de la loi de X.

Avantage :

+ Cette méthode donne une meilleure précision que la méthode de rejet.

Inconvénient :

+ Normalement, il est difficile de décomposer une loi quelconque en 2 lois connues.

d) Conclusion :

Il faut remarquer que certaines lois ne sont pas simulées à partir des trois méthodes

précédentes.

La meilleur méthode (et la plus simple) reste la méthode d’inversion de la fonction de

répartition, viens ensuite la méthode de décomposition, mais il faut savoir décomposer la

densité qui est une tâche difficile. Si ces 2 méthodes ne tiennent pas, on applique la méthode

de rejet.

44

IX. Estimation des paramètres et application numérique:

Normalement, la modélisation d’une variable passe par trois étapes de choix de

modèle, d’estimation des paramètres du modèle sur la base des données historiques et d’étude

de la robustesse du modèle en vue d’accepter ou de rejeter le modèle choisi. Dans ce

mémoire, comme je travaille sur un portefeuille fictif, et par souci de simplicité, je vais passer