Ch6 Régression Gauss-Newton

-

Upload

api-3737025 -

Category

Documents

-

view

71 -

download

1

Transcript of Ch6 Régression Gauss-Newton

Chapitre 6

La Regression de Gauss-Newton

6.1 Introduction

On associe au modele de regression non lineaire une regression artificielleque l’on nomme regression de Gauss-Newton, ou GNR. Nous avons dejarencontre une version de la regression de Gauss-Newton; nous l’avons em-ployee dans la Section 3.6 pour calculer les tests du multiplicateur de Lagrangepour les modeles de regression non lineaire. Les regressions artificielles sonttout simplement des regressions lineaires qui sont employees comme systemed’evaluation. Comme nous le constaterons, de nombreux types de modelesnon lineaires en econometrie possedent des regressions artificielles associees.La regressande et les regresseurs sont construits deliberement de maniere a ceque lorsque l’on execute la regression artificielle, certaines valeurs qu’affichele programme de regression sont des quantites que l’on desire calculer. Denombreux resultats donnes par les regressions artificielles peuvent pourtantn’etre d’aucun interet. Par exemple, il nous arrive d’executer des regressionsartificielles pour lesquelles toutes les estimations des coefficients seront nulles!

On emploie les regressions artificielles pour au moins cinq raisons diffe-rentes:

(i) pour verifier que les conditions du premier ordre d’un minimum ou d’unmaximum sont satisfaites avec assez de precision;

(ii) pour calculer les matrices de covariance estimees;

(iii) pour calculer les statistiques de test apres qu’un modele ait ete estimesous contraintes, sans avoir besoin d’estimer le modele non contraint;

(iv) pour calculer des estimations efficaces en une etape;

(v) c’est un element essentiel pour les procedures d’optimisation numeriquesdont on fait usage pour chercher les estimations par moindres carres nonlineaires et d’autres types d’estimations.

Dans le present chapitre nous discuterons de la maniere de faire usage dela regression de Gauss-Newton pour ces differentes raisons. Puis, lorsque nousrencontrerons d’autres regressions artificielles, nous verrons qu’elles peuventsouvent etre utilisees exactement de la meme maniere que la GNR. De fait,de nombreux resultats que nous obtiendrons dans ce chapitre reapparaıtront

176

6.1 Introduction 177

a plusieurs reprises dans les chapitres qui suivront, mais des vecteurs et desmatrices differentes remplaceront ceux que nous utiliserons ici. L’ecriturealgebrique (et son interpretation geometrique) sera identique dans tous les cas;seul le modele statistique sous-jacent, et par la les definitions de la regressandeet des regresseurs, seront modifies.

Ainsi que nous l’avons fait dans les chapitres qui precedent, nous traite-rons le modele de regression non lineaire univariee

y = x(β) + u, u ∼ IID(0, σ2I), (6.01)

ou X(β) ≡ Dx(β) est une matrice de dimension n× k dont le t ieme elementest la derivee partielle de xt(β) par rapport a βi. Le vecteur des fonctions,x(β), et sa matrice de derivees, X(β), sont supposes satisfaire les conditionsde convergence et de normalite asymptotique que nous avons detaillees dansles Theoremes 5.1 et 5.2.

La facon la plus evidente d’obtenir la regression de Gauss-Newton consistea calculer le developpement en serie de Taylor a l’ordre un de (6.01) autourd’un quelconque vecteur de parametres β∗. Cela donne

y = x(β∗) + X(β∗)(β − β∗) + termes de plus haut degre + u.

En replacant x(β∗) dans le membre de gauche, en combinant les termes deplus haut degre avec les aleas u et en nommant tout ceci “residus”, et enremplacant β−β∗ par un vecteur (b) a k composantes que nous ne specifionspas, nous obtenons

y − x(β∗) = X(β∗)b + residus. (6.02)

C’est la version la plus simple de la regression de Gauss-Newton dans sa formegenerique. La regressande est comparable a un vecteur de residus, car c’estla difference entre le vecteur des valeurs de la veritable variable dependanteet le vecteur de valeurs “prevues” par le modele x(β∗). Il y a k regresseurs,chacun etant un vecteur de derivees de x(β) par rapport a un element de β.Par consequent cela a un sens d’associer le i ieme regresseur a βi. Ainsi quenous l’avons vu, lorsque x(β) est un modele de regression lineaire ou X est lamatrice des variables independantes, X(β) est tout simplement egal a X, desorte que pour les modeles lineaires, la GNR possedera justement les memesregresseurs que le modele d’origine.

Les proprietes de la regression (6.02) dependront de la maniere dont levecteur de parametres β∗ est choisi. Observons tout d’abord ce qu’il ad-vient lorsque β∗ = β, l’estimation non contrainte NLS de β. La regression deGauss-Newton devient

y − x = Xb + residus, (6.03)

178 La Regression de Gauss-Newton

ou x ≡ x(β) et X ≡ X(β). Maintenant rappelons-nous que les conditions dupremier ordre pour un minimum de la fonction somme-des-carres sont

(y − x)>X = 0. (6.04)

L’estimation OLS de b a partir de (6.03) est

b =(X>X

)−1X>(y − x),

qui doit etre un vecteur nul si l’on tient compte de (6.04). Ainsi dans ce cas,la GNR n’aura strictement aucun pouvoir explicatif! Cela pourrait passerpour un resultat denue d’interet. Apres tout, pourquoi voudrait-on executerune regression artificielle dont on sait deja par avance que tous les coefficientssont nuls? Il y a en realite deux bonnes raisons de le faire.

La premiere est que la GNR (6.03) offre un moyen tres simple de verifierque les conditions du premier ordre (6.04) sont satisfaites avec suffisammentde precision. Etant donnees les limites de l’arithmetique a virgule flottante surles calculateurs numeriques, la valeur approchee de β qu’affiche un programmede moindres carres non lineaires ne satisfera jamais reellement les conditionsdu premier ordre. Si le programme est performant et si les donnees procurentsuffisamment d’informations pour nous permettre d’estimer β avec precision,alors l’approximation β sera tres proche du vrai β et (6.04) sera presque vraie.En consequence, l’estimation b de la GNR devrait etre proche de zero, et lepouvoir explicatif de la GNR sera presque nul. Dans de telles circonstances,on s’attend a ce que les Students de b affiches soient tous inferieurs a environ10−3 ou 10−4, et a ce que le R2 soit compose de plusieurs decimales nulles. Ilest preferable d’observer les Students plutot que b car les premiers sont desquantites sans unite de mesure; quelques elements de b pourraient etre assezimportants, si les colonnes correspondantes de X etaient tres petites, memesi l’estimation de β etait tres fine.

S’il fallait executer la GNR (6.03) et si l’on s’apercevait que quelquesStudents associes a b etaient superieurs a, disons 10−2, alors il faudrait mettreen doute la validite du β qui a ete calcule. Peut-etre le calcul devrait-iletre execute a nouveau a l’aide d’un critere de convergence plus severe oud’un algorithme different (consulter la Section 6.8). Ou alors les donnees etle modele sont tels qu’une estimation plus fine de β est impossible ou tresdifficile a obtenir, auquel cas il serait souhaitable d’estimer un autre modele,plus simple, ou de disposer de davantage de donnees.

La GNR (6.03) est particulierement utile lorsqu’une evaluation de β a etecalculee avec un programme de moindres carres non lineaires auquel on ne peutpas se fier (de tels programmes existent!), ou grace a une procedure ad hoc.Les procedures ad hoc sont parfois utilisees lorsque le modele est seulementlegerement non lineaire. En particulier, il y a de tres nombreux modeles nonlineaires qui sont lineaires conditionnellement a un de leurs parametres. Unexemple est le modele

yt = β1 + β2zt1 + β3zβ4t2 + ut, (6.05)

6.2 Calcul des Matrices de Covariance 179

ou les variables zt1 et zt2 sont des regresseurs exogenes, qui est lineaire condi-tionnellement a β4. Il est parfois pratique d’estimer de tels modeles en faisantabstraction de l’unique parametre qui engendre la non linearite, dans ce cas,β4, et de calculer les autres parametres avec une procedure de moindres carresordinaires conditionnellement a chaque valeur de β4. On execute ensuite laGNR pour savoir si, oui ou non, l’approximation de β qui en resulte est assezprecise, ce qui, dans le cas de (6.05) donne

yt − β1 − β2zt1 − β3zβ4t2

= b1 + b2zt1 + b3zβ4t2 + b4β3(log zt2)z

β4t2 + residu.

(6.06)

Si les Students de b1, b2, b3 et b4 sont tous suffisamment faibles, on peutaccepter le β calcule comme etant suffisamment proche des estimations NLS.

Dans la Section 1.6 nous avons discute des techniques de detection despoints de levier et des observations influentes dans le contexte des OLS. Dansle cas d’un modele de regression non lineaire, il est possible d’appliquer cestechniques a la GNR (6.03). Le t ieme element diagonal de la matrice chapeaupour la GNR est

ht ≡ Xt

(X>X

)−1Xt>,

que de nombreux progiciels de regression savent calculer assez facilementcomme un sous-produit du calcul des estimations OLS. Avec ht, il est possiblede calculer (

ht

1− ht

)ut

pour tout t. Cette expression est l’analogue de l’expression (1.42), et endessiner la courbe representative en fonction de t est un bon moyen dedetecter les observations influentes. Evidemment, dans le cas non lineaire,cela ne sera pas exactement egal a la modification enregistree par le residus del’observation t apportee par l’omission de cette observation dans la regression,contrairement a ce qui se passerait si x(β) etait lineaire en β, mais cela offriraneanmoins une bonne approximation dans la plupart des situations. Ainsi, enappliquant les techniques habituelles de detection des observations influentesdans les modeles de regression lineaire a la GNR (6.03), il est possible dedetecter les problemes relatifs aux donnees dans les modeles de regression nonlineaire aussi simplement que pour les modeles lineaires.

6.2 Calcul des Matrices de Covariance

La seconde raison majeure pour laquelle on utilise la GNR (6.03) est qu’ellepermet le calcul de la matrice de covariance estimee de β. Souvenons-nous

180 La Regression de Gauss-Newton

du resultat asymptotique, le Theoreme 5.2, selon lequel pour un modele deregression non lineaire correctement specifie,

n1/2(β − β0)a∼ N

(0, σ2

0(n−1X0>X0)−1

), (6.07)

ou X0 ≡ X(β0). Dans la pratique nous sommes interesses par la distributionde β−β0 plutot que par celle de n1/2(β−β0), et pour obtenir une matrice decovariance estimee il nous faut d’abord remplacer σ2

0 et (n−1X0>X0)−1 dans

(6.07) par des quantites qui les estiment de maniere convergente, et les diviserpar n.

Considerons a present la GNR (6.03) une nouvelle fois. L’estimation dela matrice de covariance que le programme de regression affichera est

s2(X>X

)−1, (6.08)

ou

s2 ≡ (y − x)>(y − x)n− k

est l’estimation OLS de la variance de la regression, a la fois de la regressionartificielle et de la regression non lineaire originelle (6.01). Parce que la GNRn’a aucun pouvoir explicatif, ces deux regressions possedent exactement lesmemes residus.

Il est evident que s2 est une estimation convergente de σ20 , et puisque β

est une estimation convergente de β0, n−1X>X doit etre une estimation con-vergente de n−1X0

>X0; voir Section 5.7. Ainsi, a l’evidence, il est raisonnablede faire usage de (6.08) pour estimer la matrice de covariance de β − β0. Lamatrice de covariance de b qu’affiche d’habitude le programme de moindrescarres offrira une estimation tout a fait correcte, et facilement calculable, de lamatrice de covariance des estimations NLS. Particulierement lorsque β a eteestime par une tout autre methode que celle des moindres carres non lineaires(souvenons-nous du modele (6.05) et de la GNR associee a (6.05)), la GNR(6.03) presente un moyen extremement simple de calculer une estimation dela matrice de covariance de β.

Dans le cas non lineaire, il n’est pas evident qu’il faille utiliser s2 plutotqu’un autre estimateur convergent de σ2. L’estimateur le plus simple est

σ2 = 1−n(y − x)>(y − x),

et, comme nous le verrons au cours du Chapitre 8, c’est l’estimateur que lamethode du maximum de vraisemblance conseille d’utiliser. Toutefois, commenous l’avons montre a la Section 3.2, σ2 tendra a sous-estimer σ2 en moyenne,de sorte qu’utiliser l’estimation OLS de (6.03) se revele preferable. De plus,lorsque le DGP est un cas particulier du modele que l’on estime, nous dis-posons du resultat asymptotique (5.57) selon lequel

y − xa= M0u, (6.09)

6.3 Colinearite dans les Regressions non Lineaires 181

ou M0 ≡ I −X0(X0>X0)−1X0

> est la matrice qui projette orthogonalementsur S⊥(X0). Le resultat (6.09) est l’analogue du resultat valable en echantillonfini, pour les modeles des regression lineaire, qui est

y −Xβ = MXu.

Alors le fait que s2 soit un estimateur non biaise de σ2 pour les modeles deregression lineaire suggere que, pour les echantillons de grande taille, s2 soitegalement non biaise pour les modeles non lineaires et surement plus approprieque σ2.

Malheureusement, tous les programmes de moindres carres non lineairesn’utilisent pas s2. Une raison d’executer la GNR (6.03) est de voir si la ma-trice de covariance estimee pour β calculee par le programme est reellementla meme que celle obtenue par la GNR. Les deux approches different du fac-teur de proportionnalite (n − k)/n, auquel cas il serait judicieux d’utiliserla plus grande des deux estimations (c’est-a-dire celle donnee par la GNR).Si elles different d’une autre facon, il serait souhaitable de se mefier du pro-gramme de moindres carres non lineaires, et de conserver la matrice de cova-riance estimee par la GNR plutot que celle affichee par le programme. Il y acependant une exception possible a ce conseil. Certains progiciels modernessont capables d’afficher une estimation de la matrice de covariance robustea l’heteroscedasticite, ou HCCME, au lieu de l’estimation usuelle (qui sup-pose l’homoscedasticite) dont nous venons de parler; voir Section 16.3. Dansdes cas semblables, il serait sans doute revelateur d’executer la GNR et decomparer les deux estimations des matrices de covariance.

6.3 Colinearite dans les Regressions non Lineaires

Nous avons remarque dans la Section 2.3 que les modeles de regression lineairequi sont insuffisamment identifies sont souvent consideres comme manifestantun phenomene de colinearite ou de multicolinearite. Les deux termes expri-ment la meme chose, aussi prefererons-nous le plus court, meme si le terme“multicolinearite” est probablement le plus usite dans la litterature consacreea l’econometrie. La relation entre la colinearite et l’identification apparaıtclairement si l’on etudie la regression de Gauss-Newton. Comme nous allonsle montrer, si un modele de regression non lineaire est faiblement identifie auvoisinage d’un quelconque vecteur de parametres β∗ qui n’est pas trop eloignede β0 (souvenons-nous que pour les modeles non lineaires, l’identificationdependra generalement des valeurs des parametres), alors la GNR evaluee enβ∗ manifestera la colinearite. Nous presenterons egalement une explicationintuitive de ce qu’implique la colinearite dans les modeles de regression lineaireet non lineaire.

Dans la Section 2.3, nous avons defini sans trop de precision un modeleinsuffisamment identifie comme un modele pour lequel la matrice Hessienne

182 La Regression de Gauss-Newton

H(β) de la fonction somme-des-carres est presque singuliere pour des valeursinteressantes de β. Nous avons deliberement evite toute tentative d’appro-fondissement, car le fait qu’un modele soit ou non insuffisamment identifiedepend de la raison pour laquelle nous nous soucions du fait qu’il est identi-fiable. Par exemple un modele peut etre tellement mal identifie que certainsprogrammes de moindres carres non lineaires soient incapables de l’estimer,mais pas suffisamment pour empecher les meilleurs programmes de le mani-puler et de le traiter. Ou bien un modele peut etre suffisamment bien identifiepour qu’il n’y ait pas de difficulte a l’estimer, mais pas assez pour permettred’obtenir des estimations des parametres aussi precises que nous le desirons.

Normalement, la quasi singularite d’une matrice est determinee parl’observation de son nombre condition qui est le rapport de sa plus grandevaleur propre par sa plus petite valeur propre. Cependant, le nombre conditionde H(β) peut etre modifie grandement par une reparametrisation du modele,meme si la reparametrisation consiste simplement a choisir une autre echellepour certains regresseurs. Par exemple, dans un cas de regression lineairepour lequel x(β) = Xβ, la matrice Hessienne H(β) est egale a 2X>X. Sil’on multiplie une colonne de X par, disons, 106, cela modifierait serieusementle nombre condition de X>X, le rendant presque a coup sur plus important, amoins que les elements de cette colonne de X ne fussent tres petits a l’origine.Puisque ce genre de modification ne nous apprendra pas grand chose de plusa partir des donnees (bien qu’il puisse tout a fait affecter les performancesdes algorithmes de moindres carres non lineaires), il ne nous est pas possiblede classer raisonnablement les modeles selon leur degre d’identification sur labase d’un indice aussi simple que le nombre condition.1 En realite, il semblequ’il n’existe aucun procede mecanique qui permette de decider si, oui ounon, un modele est “mal” identifie. Toutefois, comme nous allons le voir apresent, la regression de Gauss-Newton peut etre utilisee pour nous indiquersi l’identification peut etre un obstacle.

Dans la Section 5.4 nous avons vu que

n−1H(β0)a= 2n−1X>(β0)X(β0). (6.10)

Ainsi, si la matrice Hessienne est quasi singuliere, nous pouvons nous at-tendre a ce qu’il en soit de meme pour la matrice X>(β)X(β), pourvu queces deux matrices soient evaluees en un point suffisamment proche de β0.Nous avons besoin de cette condition parce que (6.10) n’est verifiee qu’en β0,puisque ce resultat (6.10) depend du fait que y − x(β0) = u0; consulter ladiscussion qui a precede (5.38). La continuite de x(β) suggere toutefois que(6.10) doit etre approximativement vraie pour des valeurs de β proches de β0.

1 Si la matrice X etait normalisee de maniere a ce que toutes ses colonnes aientla meme longueur— par exemple une longueur unitaire— l’usage du nombrecondition serait pertinent pour deceler la colinearite de X>X. Voir Belsley,Kuh, et Welsch (1980, Chapitre 3).

6.3 Colinearite dans les Regressions non Lineaires 183

Par consequent, il serait extremement surprenant que la regression de Gauss-Newton ne reussisse pas a prevoir la colinearite lorsque la matrice Hessienneest en realite quasi singuliere.

A titre d’exemple, considerons le modele de regression non lineaire

yt = β1 + β2zβ3t + ut. (6.11)

Pour ce modele, la t ieme ligne de X(β) est

[1 zβ3

t β2zβ3t log(zt)

]. (6.12)

A partir de la on voit immediatement que la matrice X>(β)X(β) sera sin-guliere si jamais β2, ou β3, est nul. Dans le premier cas, la troisieme colonnede X(β) sera composee de zeros, alors que dans le second, la deuxieme colonnesera equivalente a la colonne correspondant a la constante. Ainsi ce modeleest asymptotiquement non identifie en des points tels que β2 = 0 ou β3 = 0,bien qu’il soit identifie par presque tous les ensembles de donnees.

Si un modele n’est pas identifie asymptotiquement meme s’il est iden-tifie par un ensemble de donnees precis, il est probable qu’il soit d’un interetrestreint, puisque sans l’identification asymptotique, operer des inferences cor-rectes est impossible. De plus, si un modele n’est pas identifie asymptotique-ment en β0, les moindres carres non lineaires ne produisent pas des estimationsconvergentes. D’un autre cote, un modele qui est identifie asymptotiquementpeut ne pas etre identifie par un ensemble de donnees particulier. Il sera utiled’acquerir davantage de donnees en vue d’estimer un tel modele.

Meme pour des valeurs des parametres pour lesquelles il est identifie,c’est-a-dire des valeurs differentes de β2 = 0 et β3 = 0, le modele (6.11)sera surement mal identifie. Il est clair d’apres (6.12) que ce sera le cas leplus probable, en fonction des donnees et des valeurs des parametres. Ladeuxieme colonne de X(β) est tres similaire a la troisieme colonne, chaqueelement de la deuxieme colonne multiplie par une constante et par log(zt)etant egal a l’element correspondant de la troisieme colonne. A moins quel’etendue de zt ne soit tres importante, ou qu’il y ait quelques valeurs de zt

tres proches de zero, zβ3t et β2 log(zt)z

β3t tendront a etre fortement correlees.

Par exemple, si z>est compose des cinq observations [1 2 3 4 5], qui couvrentune etendue plus large que ne le feraient la plupart des regresseurs dans lesapplications econometriques, et si β3 est egal a l’unite, la correlation entreles deux vecteurs s’etablit a 0.9942; si z> est compose des cinq observations[5 6 7 8 9], la correlation atteint l’importante valeur de 0.9996. Remarquonsque l’insuffisance d’identification du modele depend autant des donnees quedes valeurs des parametres et de la structure du modele.

Nous avons deja note que la regression de Gauss-Newton

y − x = Xb + residus,

184 La Regression de Gauss-Newton

ou x(β) et X(β) sont evalues aux avec les estimations NLS β, produit uneestimation valide de la matrice de covariance de β lorsque le DGP est un casparticulier du modele qui a ete estime. Il est clair que la GNR

y − x0 = X0b + residus, (6.13)

ou x(β) et X(β) sont evaluees en β0, devrait egalement entraıner une estima-tion valide de V (β), bien qu’en pratique cette regression ne soit pas envisa-geable parce qu’elle requiert la connaissance du DGP. Quoi qu’il en soit, il estutile de considerer V (β) comme ayant ete generee par cette equation. Si l’onfait abstraction des finesses de l’analyse asymptotique, de facon a eviter lamanipulation des divers facteurs de n, on peut utiliser simplement l’equation(6.13) pour mettre en lumiere le probleme de colinearite dans les modeles deregression lineaire et dans les modeles de regression non lineaire.

Supposons que l’on porte quelque interet a la mesure de l’estimation NLSd’un element unique de β, que nous pouvons appeler β1 sans reduire la porteede l’analyse. Il est toujours possible de partitionner X(β) en [x1(β) X2(β)],ou x1(β) designe la colonne unique de X(β) correspondant a β1, et X2(β)designe les k − 1 colonnes restantes. Si l’on ne rapporte pas l’indice “0” parsouci de clarte, la GNR (6.13) devient alors

u = x1b1 + X2b2 + residus.

D’apres le Theoreme FWL, l’estimation de b1 pour cette regression artificiellesera numeriquement identique a celle de la regression

M2u = M2x1b1 + residus, (6.14)

ou M2 ≡ I − X2(X2>X2)−1X2

> est la matrice qui projette orthogonalementsur S⊥(X2), le complementaire orthogonal de l’espace engendre par X2.

La regression (6.14) ne possede qu’un seul regresseur, M2x1. Il est facilede voir que

V (b1) = σ20

(x1>M2x1

)−1 =σ2

0

x1>M2x1

.

C’est asymptotiquement la meme que la variance de β1. Notons que x1>M2x1

est tout simplement la somme des residus au carre de la regression

x1 = X2c2 + residus. (6.15)

Ainsi, on en conclut que la variance de β1 est proportionnelle a l’inverse dela somme des carres des residus de la regression (6.15). Lorsque x1 est bienexplique par les autres colonnes de X, cette SSR sera faible et la variance de β1

sera par consequent importante. Lorsque ce n’est pas le cas et que x1 est assezmal explique par les autres colonnes de X, cette SSR sera forte, et la variance

6.3 Colinearite dans les Regressions non Lineaires 185

....................................................................................................................................................................................................................................................................................................................... ......................................................................................

......................................................................

......................................................................

......................................................................

..................... ................

............

............

............

............

............

............

............

............

..................

................

...............

...................................................................................

O S(x2)

x1

M2x1φ

(a)

....................................................................................................................................................................................................................................................................................................................... .............................................................................................................................................................................................................................................................................................................................................

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

....................

................

...............

........................................................................................................................

..........

O S(x2)

x1

M2x1

φ

(b)

.................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................

...............................

................................

................................

..................................

..................................

....................................

....................................

......................................

.........................................

............................................................

............................................................................................................................................................................................................................................................................................................................................................ ................

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

....................

................

...............

...............

...............

............

...............

...............

...............

............

β1

β2

(c)

A B

O

............................................................................................................................................................................................................................................................................................

................................................

...............................................

............................................................................................................................................................................................................................................................................................................. ................

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

............

....................

................

...............

...............

...............

............

...............

...............

...............

............

β1

β2

(d)

A B

O

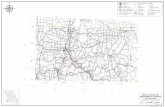

Figure 6.1 Colinearite et precision de l’estimation

de β1 deviendra faible. Ces deux cas ont ete illustres dans la Figure 6.1, pourle cas ou il n’y a que deux regresseurs. Il faudrait comparer cette figure a laFigure 3.3, car pour l’essentiel les memes resultats apparaissent dans les deuxfigures, puisque la longueur de l’intervalle de confiance d’un parametre donneest proportionnel a la racine carree de la variance estimee de ce parametre.

Le regresseur x2, qui represente sur la figure tous les regresseurs autresque le regresseur x1 qui nous interesse, est le meme de chaque cote de lafigure. D’autre part, le regresseur x1 est oriente differemment par rapport ax2 sur les deux parties. Pour simplifier les deux regresseurs sont de memelongueur et la seule variable est l’angle φ, qu’ils forment ensemble. Dans leschema (a) en haut a gauche, x2 explique x1 relativement bien, alors l’angleφ et la somme des residus au carre de (6.15) sont relativement faibles. Cettederniere est le carre de la longueur du vecteur de residus M2x1. Dans leschema (b), x2 explique beaucoup moins bien x1, de sorte que l’angle φ et laSSR de (6.15) sont assez importants. Clairement le degre de colinearite entrex1 et x2 est plus fort lorsque φ est faible, ou de facon equivalente, lorsque x2

explique bien x1.

Dans les schemas (c) et (d), nous avons represente les ellipses et intervallesde confiance pour β1 correspondant aux regresseurs illustres dans les schemas(a) et (b). Pour simplifier, nous les avons representes dans le cas β = 0:

186 La Regression de Gauss-Newton

dans tout exemple reel le seul aspect different des figures serait l’origine quise deplacerait n’importe ou, laissant inchangees les tailles et les positionsrelatives des autres elements. Remarquons que les deux schemas du bas ontete dessines a la meme echelle. Les intervalles de confiance, qui sont lessegments AB dans la figure, sont donc de longueurs tres differentes. Commenous l’avons explique a la Section 3.3, un plus haut degre de colinearite faitapparaıtre une region de confiance elliptique de plus grande excentricite, etcela se voit aisement sur la figure. Pour la situation depeinte, dans laquelleseul l’angle φ varie, il peut etre montre que l’aire de l’ellipse de confiance et lalongueur de l’intervalle de confiance de β1 sont inversement proportionnellesa sin φ. Par consequent, si φ tend vers zero, et si les deux regresseurs serapprochent en devenant colineaires, la longueur de l’intervalle de confiancetend vers l’infini. Cela, bien evidemment, ne fait que refleter le fait que lavariance de β1 tend vers l’infini lorsque φ tend vers zero.

Le phenomene de colinearite se manifeste lorsqu’une ou plusieurs colonnesde X sont extremement bien expliquees par les colonnes restantes, et lorsqueles estimations des parametres associes a ces colonnes sont tres imprecises.Un moyen tres simple de caracteriser la presence ou l’absence de colinearite,etant donne qu’elle affecte l’estimation du parametre unique β1, est de con-siderer le rapport de x1

>M2x1 par x1>Mιx1, ou Mι ≡ I − ι(ι>ι)−1ι> est la

matrice qui opere la deviation par rapport a la moyenne (comme d’habitude,ι designe un vecteur compose de n uns). Le numerateur de ce rapport mesurela variation de x1 qui n’est pas expliquee par la variation de X2, tandis que ledenominateur mesure la variation de x1 autour de sa moyenne. Si ce rapportest tres faible, la colinearite peut se reveler etre un probleme.

Lorsqu’un modele est insuffisamment identifie pour une quelconque valeurde β, disons β∗, la regression de Gauss-Newton manifestera de facon syste-matique un niveau important de colinearite lorsqu’elle est evaluee en β∗. Sil’on eprouve quelques difficultes a obtenir des estimations NLS, ou si l’onn’a pas encore debute l’estimation d’un modele et que l’on s’attend a ren-contrer quelques obstacles, il peut devenir tres utile de savoir si, oui ou non,la regression de Gauss-Newton est en proie a un phenomene consequent decolinearite pour des valeurs plausibles des parametres. Si c’est effectivementle cas, alors le modele est surement insuffisamment identifie par les donnees,et il peut donc s’averer impossible d’obtenir des estimations d’une precisionsatisfaisante de ce modele avec cet ensemble de donnees, ou meme de localiserle minimum de SSR(β) (voir Section 6.8).

Que faire lorsque l’on est confronte a un modele de regression non lineairequi est insuffisamment identifie? Il y a fondamentalement deux options qui sepresentent: recueillir davantage de donnees, ou estimer un modele plus simple,peut-etre le modele originel apres lui avoir impose quelques contraintes. S’ils’avere irrealisable de recueillir davantage de donnees, alors il faut accepterl’idee selon laquelle les donnees dont on dispose contiennent une quantitelimitee d’informations, et adapter le modele a la situation. L’estimation de

6.4 Tests de Contraintes 187

modeles qui se revelent trop complexes est une des erreurs les plus frequenteschez les econometres inexperimentes. Un modele tel que (6.11), par exemple,requiert un nombre important de donnees, et sera sans doute tres difficile aestimer avec de nombreux ensembles de donnees. Il ne sera possible d’obtenirdes estimations precises de β2 et β3 pour ce genre de modele que si le nombred’observations est tres important et/ou le champ de zt est tres etendu.

6.4 Tests de Contraintes

L’usage le plus connu de la regression de Gauss-Newton est celui qui consistea offrir un moyen simple de calcul de statistiques de test. Une fois obtenuesles estimations contraintes, une variante de la GNR peut etre utilisee pour lestests de tous types de contraintes d’egalite sur β sans avoir a estimer le modelenon contraint. Ces tests sont bases sur le principe du multiplicateur de La-grange dont nous avons discute a la Section 3.6. De nombreuses statistiquesde test, numeriquement differentes mais asymptotiquement equivalentes, peu-vent se calculer en se basant sur la GNR. Dans ce chapitre nous ne traitons queles statistiques de test qui sont basees sur des estimations NLS contraintes.Comme nous le constaterons a la Section 6.7, la GNR peut aussi etre employeedans le calcul de tests bases sur toute estimation convergente au taux n1/2.

Ecrivons l’hypothese nulle et l’hypothese alternative sous la forme

H0 : y = x(β1,0) + u

H1 : y = x(β1, β2) + u

u ∼ IID(0, σ2I),

ou β1 est de dimension (k − r) × 1, et β2 est de dimension r × 1. En neprenant en compte que des restrictions de nullite, nous ne limitons nullement lageneralite des resultats, car, comme nous en avons deja discute, tout ensemblede r contraintes d’egalite peut etre converti en un ensemble de r contraintesde nullite, grace a une reparametrisation adequate. Nous supposerons que lemodele non contraint est identifie asymptotiquement au voisinage du DGP,qui est suppose appartenir a la famille des DGP

y = x(β01,0) + u, u ∼ IID(0, σ20I)

de sorte que c’est H0 qui a genere reellement les donnees. La matrice X(β)peut etre partitionnee en deux, X1(β) et X2(β), correspondant a β1 et β2,et de dimensions respectives n× (k − r) et n× r.

Il n’est pas evident que toutes les contraintes d’egalite puissent etre con-verties en des contraintes de nullite a l’aide d’une reparametrisation adequate.Dans la Section 3.6 par exemple, nous considerons les contraintes lineaires dutype Rγ = r, ou R est une matrice de dimension r × k et r est un vecteura r composantes. Ici γ designe le vecteur a k composantes sur lequel portent

188 La Regression de Gauss-Newton

les contraintes; nous ferons usage de β pour designer une parametrisation al-ternative pour laquelle toutes les contraintes sont des contraintes de nullite.Pour cette parametrisation la matrice R prend la forme [0 Ir], et le vecteurr est compose de zeros. Ainsi il apparaıt que

Rγ − r = 0 = [0 Ir]β, (6.16)

ou γ et β designent les vecteurs de parametres dans deux parametrisationsdifferentes. Evidemment on peut associer βi a γi pour i = 1, . . . , k − r, alorsque dans l’equation (6.16) il apparaıt que

βi =k∑

j=1

Rijγj − ri

pour i = k − r + 1, . . . , k. Ainsi la conversion des contraintes lineaires Rγ =r parametrisees en γ en des contraintes de nullite parametrisees en β estdirecte. Il est aussi possible de convertir des contraintes non lineaires, tellesque celles dont nous avons parle a la Section 5.7, en des contraintes de nullite.Il faut simplement definir les nouveaux parametres en fonction des anciensparametres. Par exemple, si une des contraintes etait γγ2

1 −5 = 0, on pourraitdefinir un nouveau parametre β1 de facon a le rendre egal a γγ2

1 − 5. Biensur, ce type de reparametrisation non lineaire n’est pas toujours aise dans lapratique s’il y a plusieurs contraintes non lineaires compliquees. Par chance,il n’est pas necessaire de reparametriser le modele de facon a n’obtenir quedes contraintes de nullite en vue d’utiliser les resultats theoriques bases surl’hypothese que ces contraintes sont de ce genre.

L’identification asymptotique implique que la matrice n−1X0>X0 doit ten-

dre vers une matrice definie positive. Cette hypothese elimine un certain nom-bre de modeles et de contraintes. Par exemple, il ne nous serait pas possiblede traiter un modele tel que

yt = β1 + β2 exp(β3zt) + ut

soumis aux contraintes β2 = 0 ou β3 = 0, puisqu’alors le modele ne seraitpas identifiable asymptotiquement. Nous noterons l’estimation de β sous H0

par β, pour la distinguer du vecteur d’estimations non contraintes β; toutesles quantites reperees par un ∼ sont evaluees par les estimations contraintes.Dans ce cas, β ≡ [β1

.... 0].A present nous allons examiner la distribution de quelques statistiques

de test etroitement liees, qui s’obtiendraient en executant une regression deGauss-Newton avec β evalue en β. Toutes ces statistiques de test sont asymp-totiquement equivalentes a la statistique de test LM (3.47), ou sa variante, laforme du score (3.48), qui a ete devoilee a la Section 5.7 comme etant asymp-totiquement distribuee suivant la χ2(r) sous l’hypothese nulle. La regressionde Gauss-Newton evaluee en β = β est

y − x = X1b1 + X2b2 + residus. (6.17)

6.4 Tests de Contraintes 189

Ce qui ressemble enormement a la regression (3.49), que nous avons introduitea la Section 3.6 en tant que moyen de calcul de la statistique du multiplicateurde Lagrange. La seule difference entre les deux est que la regressande n’a pasete divisee par une estimation de σ; comme nous allons le voir bientot, ladivision de la regressande par une estimation de σ est facultative.

Par l’intermediaire du Theoreme FWL, nous voyons que la regression(6.17) entraıne exactement les memes estimations de b2, c’est-a-dire b2, etexactement la meme somme des residus au carre que la regression

y − x = M1X2b2 + residus, (6.18)

ou M1 est la matrice qui projette sur S⊥(X1). La regressande n’est pas icimultipliee par M1 parce que les conditions du premier ordre impliquent quey − x se situe deja dans S⊥(X1), de sorte que M1(y − x) = (y − x). Lasomme des residus au carre de la regression (6.18) est

(y − x)>(y − x)− (y − x)>X2

(X2>M1X2

)−1X2>(y − x).

Puisque y − x se trouve dans S⊥(X1), il doit etre orthogonal a X1. Ainsi sinous n’avions pas compris X2 dans la regression, la SSR aurait ete egale a(y − x)>(y − x). Par consequent la reduction dans la SSR de la regression(6.17) consecutive a l’addition de X2 est

(y − x)>X2

(X2>M1X2

)−1X2>(y − x). (6.19)

Cette quantite correspond egalement a la somme des carres expliques (autourde zero) de la regression (6.17), une fois de plus a cause du pouvoir expli-catif de X1. Comme nous le montrons maintenant, cette quantite divisee parn’importe quelle estimation convergente de σ2, est distribuee asymptotique-ment selon une χ2(r) sous l’hypothese nulle.

Pour s’en rendre compte, observons que

n−1/2(y − x)>X2a= n−1/2u>M1X2 ≡ ν>,

ou M1 ≡ M1(β0) et X2 ≡ X2(β0). L’egalite asymptotique provient ici dufait que u

a= M1u, qui est le resultat (6.09) dans le cas ou le modele est estimesous la contrainte β2 = 0. La matrice de covariance du vecteur aleatoire ν dedimension r est

E(νν>) = E(n−1X2

>M1uu>M1X2

)= n−1X2

>M1(σ20 I)M1X2

= n−1σ20(X2

>M1X2) ≡ σ20V .

La convergence de β et les conditions de regularite pour le Theoreme 5.1impliquent que

n−1X2>M1X2

a= n−1X2>M1X2 = V .

190 La Regression de Gauss-Newton

Sous les conditions de regularite du Theoreme 5.2, il nous est possibled’appliquer un theoreme de la limite centrale et de conclure que ν est dis-tribue asymptotiquement selon une normale centree et de matrice de cova-riance σ2

0V . Ainsi toute statistique de test construite en divisant (6.19) parune estimation consistante de σ2 est asymptotiquement egale a

1σ2

0

ν>V −1ν.

Nous voyons immediatement que cette quantite est distribuee asymptotique-ment suivant une χ2(r), puisque c’est une forme quadratique en un vecteuraleatoire a r composantes qui est asymptotiquement d’esperance nulle et d’unematrice de covariance σ2

0V ; voir Annexe B.Parce que nous voulons utiliser n’importe quelle estimation convergente

de σ2, ce resultat justifie l’usage de plusieurs statistiques de test differentes.Une possibilite est d’utiliser la somme des carres expliques de la regression(3.49) dans laquelle la regressande de (6.17) a ete divisee par une estimationconvergente de σ. Cependant les deux statistiques de test les plus courantessont n fois le R2 non centre de la regression (6.17) et le Fisher habituel pourb2 = 0 de la meme regression. Pour constater que la forme nR2 du test estcorrecte, observons que puisque R2

u, le R2 non centre, est egal a la somme descarres expliques divisee par la somme des carres totaux,

nR2u =

n(y − x)>X2

(X2>M1X2

)−1X2>(y − x)

(y − x)>(y − x)

=‖PM1X2

(y − x)‖2‖y − x‖2/n

.

Cette variante du test emploie implicitement σ2, l’estimation contrainte dumaximum de vraisemblance pour estimer σ2. Comme nous l’avons remarque,cette estimation tendra a etre trop faible, du moins lorsque l’hypothese nulleest exacte. Il serait surement plus prudent d’utiliser (n − k + r)R2

u commestatistique de test, puisqu’elle utiliserait implicitement s2, l’estimation OLSde σ2 dans le modele contraint, au lieu de σ2; la statistique de test qui enresulterait serait egale a la ESS de (3.49).

Un probleme d’ordre pratique qui se pose avec des tests bases sur leR2

u de la regression artificielle est que de nombreux progiciels de regressionn’affichent pas le R2 non centre. Dans la plupart des cas, cela ne poserapas de difficulte parce que le R2

u sera identique au R2 centre ordinaire. Celasera verifie chaque fois que le modele contraint x(β1,0) comprend l’equivalentd’un terme constant de sorte que y − x sera de moyenne nulle. Dans le casou y − x n’a pas une moyenne nulle, le R2 non centre differera cependant duR2 centre, et ce dernier ne produit pas une statistique de test correcte. Il estcrucial que les utilisateurs de statistiques de test nR2 et (n− k + r)R2 soient

6.4 Tests de Contraintes 191

avertis de cette eventualite, et verifient que la regressande pour la regressionde test (6.17) est bien de moyenne nulle.

Il est egalement envisageable, et surement preferable, d’utiliser le Fisherhabituel pour b2 = 0 dans la regression de Gauss-Newton. Si RSSR et USSRdesignent les sommes des residus au carre contraints et non contraints de laregression (6.17), ce Fisher est

(RSSR−USSR)/r

USSR/(n− k)(6.20)

=(y − x)>X2

(X2>M1X2

)−1X2>(y − x)/r

((y − x)>(y − x)− (y − x)>X2

(X2>M1X2

)−1X2>(y − x)

)/(n− k)

.

Le denominateur est ici l’estimation OLS de σ2 de (6.17), qui tend vers σ20

lorsque n →∞ sous H0. Le numerateur est 1/r fois l’expression (6.19). Ainsi,il est clair que r fois (6.20) sera distribuee asymptotiquement selon une χ2(r).

Avec des echantillons finis, la comparaison entre (6.20) et la distributionde F (r, n − k) est aussi correcte que la comparaison entre r fois (6.20) et ladistribution du χ2(r). En fait, il est evident que le Fisher (6.20) possede demeilleures proprietes en echantillons finis que la statistique nR2 basee sur lameme regression de Gauss-Newton; consulter Kiviet (1986). Cette evidenceva dans le meme sens que la theorie, parce que, comme nous l’avons vu,u

a= M0u. Aussi l’usage de la distribution F , qui considere l’estimations2 basee sur les residus NLS comme si elle etait basee sur les residus OLS,est plus pertinent que l’usage de la distribution χ2, qui traite σ2 commeetant basee sur les aleas au lieu des residus. Sur la base de la theorie etde l’evidence d’une part, et de la commodite de l’usage d’un test qui auraitla meme forme pour les regressions de Gauss-Newton comme pour d’autresregressions plus authentiques d’autre part, nous conseillons donc l’usage d’untest en F plutot qu’un test en nR2 ou qu’un test numeriquement comparablebase sur la regression (3.49).

L’expression (6.20) peut se simplifier en notant que c’est tout simplement(n− k)/r fois le ratio des longueurs au carre de deux vecteurs

n− k

r× ‖PM1X2

(y − x)‖2‖MX(y − x)‖2 . (6.21)

Le numerateur est la longueur au carre du vecteur PM1X2(y − x), qui est

le vecteur de residus y − x projete sur S(M1X2). Le denominateur est lalongueur au carre du vecteur MX(y − x) = MM1X2

(y − x), qui est le vecteurde residus projete en dehors de S(X) = S(X1, X2). La geometrie du test en Fdans ce cas est identique a la geometrie du test en F dans un cas de regressionlineaire, dont nous avons deja discute a la Section 3.5. La seule difference estque X1 et X2 sont des fonctions de l’estimation contrainte β.

192 La Regression de Gauss-Newton

Nous avons demontre a la Section 3.5 que, pour les modeles de regressionlineaire, le Student portant sur l’hypothese que la valeur d’un unique para-metre est nulle est numeriquement egal a la racine carree d’un Fisher por-tant sur la meme hypothese nulle. Puisqu’il s’agit d’un resultat numerique,il est valable pour les regressions artificielles autant que pour les veritablesregressions. Alors lorsque b2 est un scalaire, le Student portant sur b2 a partirde la GNR (6.17) est aussi valable que toutes les autres statistiques de testdont nous avons deja parle.

Pourquoi la regression des residus du modele contraint sur les derivees dex(β) nous permet-elle de calculer des statistiques de test valides? Pourquoiavons-nous besoin de comprendre toutes les derivees, et pas seulement cellescorrespondant aux parametres qui sont contraints? La discussion que nousavons tenue plus haut fournit des reponses formelles a ces questions, maispeut-etre pas celles qui sont intuitivement plaisantes. Considerons doncl’importance d’un point de vue legerement different. A la Section 5.7, nousmontrions que les statistiques de Wald, LR et LM pour tester le meme ensem-ble de contraintes sont asymptotiquement egales a la meme variable aleatoiresous l’hypothese nulle, et que cette variable aleatoire est asymptotiquementdistribuee selon une χ2(r). Pour les modeles de regression non lineaire quenous avons traites, la statistique LR est simplement la difference entre SSR(β)et SSR(β), divisee par n’importe quelle estimation convergent de σ2. Pourvoir pourquoi la statistique LM est valide et pourquoi la GNR doit inclure lesderivees par rapport a tous les parametres, nous allons envisager la statistiqueLM basee sur la GNR comme une approximation quadratique de cette statis-tique LR. Et cela a un sens parce que la GNR est elle-meme une approximationlineaire du modele de regression non lineaire.

Une facon de considerer la regression de Gauss-Newton est d’imaginer quec’est un moyen d’approximer la fonction SSR(β) par une fonction quadratiquequi possede les memes derivees premieres et secondes au point β. Cettefonction quadratique approximee, que nous nommerons SSR∗(β, b), est toutsimplement la fonction somme des carres de la regression artificielle. Elle sedefinit comme

SSR∗(β, b) = (y − x− Xb)>(y − x− Xb).

La somme des carres expliques de la GNR correspond precisement a la diffe-rence entre SSR(β) et SSR∗(β, b). Si β est relativement proche de β, SSR∗(·)doit fournir une bonne approximation de SSR(·) au voisinage de β. En fait,pourvu que les contraintes soient exactes et la taille de l’echantillon suffisam-ment importante, β et β seront proches l’un de l’autre parce qu’ils sont tousles deux convergents pour β0, de sorte que SSR∗(·) doit fournir une bonne ap-proximation de SSR(·). Ainsi SSR∗(β, b) sera proche de SSR(β) et la sommedes carres expliques de la GNR sera par consequent une bonne approximationde SSR(β) − SSR(β). Lorsque nous divisons la somme des carres expliquespar une estimation convergente de σ2, la statistique de test LM qui en decouledoit donc etre similaire a la statistique de LR.

6.4 Tests de Contraintes 193

.............................................................................................................................................................................................................................................................................................................................................................................................................................................

.................................................

................................................................................................................................................................................

...........................

..................................

..............................................

......................................................................................

................................................................................................................................................................................................................................................................................................................................................................. ............................................................................................................................................................................................................................................................................................................

......................................

..................................................................................................

...............................

.....................................................

.......................................................................................................................................................................................................................................................................... ...............................................................................................................................................................................................

...................................................................

...............................................

......................................................................................................................................................

(β1, 0)

(β1, β2)•

•β1

β2

A

B

Figure 6.2 Cas ou la minimisation de SSR∗∗ est satisfaisante

Il doit etre clair desormais que la GNR doit inclure autant X1 que X2.Si ce n’etait pas le cas, la GNR ne minimiserait pas SSR∗(β, b), mais plutotune autre approximation de SSR(β),

SSR∗∗(β, b2) = (y − x− X2b2)>(y − x− X2b2).

Bien que SSR∗(·) offre normalement une approximation raisonnablement satis-faisante de SSR(·), SSR∗∗(·) n’en fera pas de meme, puisqu’elle ne dispose pasd’un nombre suffisant de parametres libres. Lorsque l’on minimise SSR∗∗(·),cela n’est possible que dans les directions qui correspondent a β2 mais pasdans les directions qui correspondent a β1. SSR∗∗(·) ne sera satisfaisante quedans le cas ou les contours de SSR(·) forment approximativement une ellipsedont les axes sont sensiblement paralleles aux axes de β1 et β2, de sorte que β1

et β1 soient tres proches. Dans les autres cas de figure, le minimum de SSR∗(·)peut etre tres different du minimum de SSR∗∗(·), et les valeurs correspondantau minimum de chaque fonction peuvent aussi etre differentes.

Ceci est illustre sur les Figures 6.2 et 6.3 dans le cas ou k = 2 et r = 1.Dans la premiere figure, les vecteurs x1 et x2 sont orthogonaux, et les axesde l’ellipse formee par les contours de SSR(·) sont precisement paralleles auxaxes des abscisses et des ordonnees. Dans cette situation le minimum deSSR∗∗(β1, b2), qui doit se situer sur la ligne AB, coıncide avec le minimumde SSR(β1, β2) au point (β1, β2). Dans la Figure 6.3 x1 et x2 sont correlesnegativement de sorte que les axes de l’ellipse formee par les contours deSSR(·) sont inclines vers le haut a droite. Dans cette situation le minimumde SSR∗∗(β1, b2), qui une fois de plus doit se situer sur la ligne AB, est al’evidence tres different du minimum de SSR(β1, β2).

A l’evidence, le minimum de SSR∗∗(·) ne peut etre inferieur, et sera nor-malement superieur au minimum de SSR∗(·). Ainsi, si l’on omettait par inad-vertance X1 dans la GNR et si l’on calculait nR2

u ou une des autres valeursde la statistique de test equivalente, nous obtiendrions une statistique de

194 La Regression de Gauss-Newton

................................................................................................................................

......................................

...............................................................................................................................................................................................................................................................................................................................................................

.....................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................

..................................................................

.................................................................................................................................................................................................................................................................................................

..............................................................................................................................................................................................................................................................................................................................................................................................................................................

.......................................................................................................

................................................................................................................................................................................................................................................................................................................................................................................

...............................................................................................................................................................................................

.............................................................................................................................. ...............

......................

...............................................

(β1, 0)

(β1, β2)

(β1, b2)

••

•β1

β2 A

B

Figure 6.3 Cas ou la minimisation de SSR∗∗ est peu satisfaisante

test inferieure a la valeur correcte. C’est un phenomene utile dont il faut sesouvenir. Dans certains cas, il peut s’averer aise de construire X2 mais aucontraire difficile de construire X1. Dans de telles situations il serait utile, enpremier lieu, de regresser u sur X2 isolement. Si cette regression artificielle ap-porte une evidence definitivement defavorable envers l’hypothese nulle, alorsnous pourrions sans aucun doute decider de rejeter H0 sans avoir a executer laGNR correcte. Cependant, si une regression de u sur X2 isolement ne permetpas de rejeter l’hypothese nulle, il n’est pas possible de tirer des conclusionssures a partir de cette regression et il est necessaire d’executer la vraie GNRpour pouvoir aboutir a des conclusions sures.

La GNR (6.17) resterait correcte si l’on remplacait X2 par n’importequelle matrice de dimension n × r, disons Z(β), evaluee en β, qui seraitasymptotiquement non correlee a u sous l’hypothese nulle, qui satisferait lesmemes conditions que X(β), et qui pourrait dependre effectivement ou pasde β. Ainsi, si le modele qui doit etre teste etait

y = x(β) + u, u ∼ IID(0, σ2I), (6.22)

et si Z(β) etait une matrice construite de sorte que, si le modele etait ex-act, n−1Z0

>u tendrait vers un vecteur nul, il nous serait toujours possibled’effectuer la GNR

u = Xb + Zc + residus (6.23)

et de calculer un test en F pour c = 0 ou une des statistiques de testequivalente. De maniere implicite bien sur, Z doit correspondre a la matriceX2 pour un modele non contraint quelconque qui comprend (6.22) comme uncas particulier. Mais il y a des situations pour lesquelles il est naturel dederiver la GNR (6.23) sans preciser explicitement un tel modele, pour evaluerun test diagnostique. De tels tests sont abondamment utilises lorsque l’on doit

6.5 Tests Diagnostiques pour les Regressions Lineaires 195

estimer un modele et que l’on desire savoir s’il y a une quelconque evidencesur le fait qu’il soit mal specifie. Nous allons rencontrer de tels tests dans lasection qui suit et tout au long du livre.

6.5 Tests Diagnostiques pour les Regressions Lineaires

Les resultats precedents sur l’usage de la GNR pour tester des contraintesportant sur les parametres des modeles de regression non lineaire sont biensur transposables aux modeles de regression lineaire. Il est utile de considereren peu de mots le cas de ces derniers, d’une part parce qu’une grande partde la litterature y est consacree, d’autre part parce que cela nous donneral’opportunite de discuter des tests diagnostiques (qui sont souvent, a tort,consideres comme differents des autres tests portant sur des contraintes), etenfin parce qu’il y a toujours du merite a envisager les cas les plus simplespossibles.

Supposons que l’on ait estime le modele de regression lineaire

y = Xβ + u, u ∼ N(0, σ2I), (6.24)

ou X est une matrice de dimension n×k et β est un vecteur a k composantes,et que l’on veuille le tester sur de mauvaises descriptions eventuelles de lafonction de regression. Nous supposons la normalite pour l’instant afin depouvoir discuter sur la base de tests exacts. Souvenons-nous que la fonctionde regression est supposee determiner E(y |Ω), l’esperance de y conditionneepar un ensemble d’informations donne Ω. Soit Z une matrice de dimensionn × l contenant les observations de n’importe quel ensemble de regresseursqui appartiennent a Ω mais qui ne se trouvent pas dans S(X). Alors, sil’hypothese nulle E(y |Ω) = Xβ est exacte, l’estimation du vecteur γ dans laregression

y = Xβ + Zγ + u (6.25)

devrait etre tres peu differente de zero. Bien sur, il serait possible de testercette hypothese en calculant un Fisher ordinaire pour γ = 0:

(RSSR−USSR)/l

USSR/(n− k − l), (6.26)

ou RSSR et USSR sont respectivement les sommes des residus au carre de(6.24) et (6.25). Si la valeur de la statistique de test est forte (et donc leP associe est faible), nous voudrons rejeter l’hypothese nulle, et conclureainsi que le modele (6.24) est mal specifie. Ceci est un exemple de ce quecertains auteurs (dont Pagan (1984a) et Pagan et Hall (1983)) appellent lestests a variable additionnelle. En francais, on parle aussi d’une regressionaugmentee.

196 La Regression de Gauss-Newton

Que se passerait-il si l’on utilisait une regression de Gauss-Newton aulieu de la regression plus naturelle (6.25)? La GNR (6.17) devient

MXy = Xb + Zc + residus, (6.27)

qui grace au Theoreme FWL entraıne la meme SSR que la regression

MXy = MXZc + residus. (6.28)

Mais si l’on applique le Theoreme FWL a la regression (6.25), nous constatonsque la SSR de cette regression est identique a la SSR de la regression (6.28).Ainsi, dans cette situation le Fisher base sur la regression de Gauss-Newton(6.27) sera identique a (6.29), le Fisher base sur la regression ordinaire (6.25).Nous voyons que les tests fondes sur la GNR sont equivalents aux tests avariable additionnelle lorsque ceux-ci sont applicables.

Il semble souvent interessant de fonder des tests portant sur une mauvaisespecification d’un modele sur les residus u, car ils fournissent des estimationsdes aleas u (Pagan et Hall (1983) montrent la facon de construire un grandnombre de tests qui vont dans ce sens). Ainsi, il semble naturel de tester laqualite de la specification en regressant simplement les residus u = MXy surles regresseurs de tests Z.

L’hypothese que E(y |Ω) = Xβ peut etre testee contre toute autrespecification alternative de l’esperance conditionnelle en testant l’importanced’une quelconque matrice de test Z dans les regressions (6.25) et (6.27). Laseule chose necessaire est que Z soit asymptotiquement non correlee a u etne depende de rien d’autre que ce qui fait partie de l’ensemble d’informationsΩ. Un grand nombre de tests de specification de ce genre a ete proposeet nous en rencontrerons beaucoup au cours de cet ouvrage. Un exemplebien connu est le test d’erreur de specification de la regression (en anglaisRESET, l’abreviation que nous emploierons) qui a ete presente la premierefois par Ramsey (1969) (voir egalement Anscombe (1961)), et remanie sousla forme d’un test en F pour les variables omises, par Ramsey et Schmidt(1976). Pour ce test chaque colonne de Z est composee d’une puissance desvaleurs ajustees Xβ, telle que le carre des valeurs ajustees, le cube des valeursajustees, et ainsi de suite. Dans le cas le plus simple, il n’y a qu’un regresseurde test, qui est le regresseur des valeurs ajustees au carre, et cette versionepuree du test RESET est souvent la plus utile. Il est interessant de constaterqu’il peut se deriver comme une application de la regression de Gauss-Newton.

Supposons que le modele soumis au test soit une fois encore (6.24) quel’on desire tester contre l’hypothese alternative explicite

yt = Xtβ (1 + θXtβ) + ut, (6.29)

ou θ est un parametre inconnu qu’il faut evaluer. Lorsque θ = 0, ce modelese resume a (6.24), mais lorsque θ est non nul il tient compte d’une relation

6.6 Estimation Efficace en une Etape 197

non lineaire entre Xt et yt. Beaucoup d’autres modeles non lineaires seraientapproximes avec satisfaction par (6.29) au voisinage de θ = 0, de sorte quecela semble etre une alternative raisonnable. Il est aise de voir que la GNRcorrespondante de (6.29) est

yt −Xtβ (1 + θXtβ) =(2θ(Xtβ)Xt + Xt

)b + (Xtβ)2c + residu.

Lorsque cette expression est evaluee en β, l’estimation OLS sous l’hypothesenulle θ = 0, elle se resume a

yt −Xtβ = Xtb + (Xtβ)2c + residu, (6.30)

et ainsi que nous l’avons vu le Student de c dans cette GNR sera identique auStudent de l’estimation de c dans la regression

yt = Xtβ + (Xtβ)2c + residu,

qui est la regression necessaire a l’execution de la version la plus simple dutest RESET. Ainsi le test RESET fournit un moyen simple de tester la nonlinearite dans la relation entre X et y; pour davantage de details a ce sujet,consulter MacKinnon et Magee (1990). Ce test est evidemment transposableaux modeles de regression non lineaire. Si le modele soumis au test etaityt = xt(β) + ut, il suffirait de remplacer Xtβ par xt deux fois, lorsqu’elleapparaıt dans la regression (6.30), afin d’obtenir une GNR adequate.

6.6 Estimation Efficace en une Etape

Il est quelquefois facile d’obtenir des estimations convergentes mais inefficaces,mais il est relativement delicat d’obtenir des estimations NLS. Cela peut etre lecas, lorsque par exemple, le modele non lineaire qu’il faut estimer est en realiteun modele lineaire soumis a des contraintes non lineaires, comme c’est le casavec de nombreux modeles d’anticipations rationnelles. Dans de telles circon-stances, un resultat utile est que si l’on franchit une seule etape a partir de cesestimations convergentes initiales, en utilisant la regression de Gauss-Newton,les estimations que l’on obtiendra seront equivalentes asymptotiquement auxestimations NLS.

Si β designe les estimations initiales qui sont supposees etre convergentesa un taux n1/2. La GNR est alors

y − x = Xb + residus,

et l’estimation de b de cette regression est

b =(X>X

)−1X>(y − x). (6.31)

198 La Regression de Gauss-Newton

Alors l’estimateur en une etape est

β = β + b.

Un developpement de Taylor de x(β) autour de β = β0 entraıne

x ∼= x0 + X0(β − β0),

ou x0 ≡ x(β0) et X0 ≡ X(β0). En mettant ce resultat dans (6.31), en rem-placant y par sa valeur sous le DGP, x0 +u, et en introduisant des puissancesadequates de n de sorte que toutes les quantites soient O(1), il vient le resultatsuivant

n1/2b ∼= n−1/2(n−1X>X

)−1X>(x0 + u− x0 −X0(β − β0)

)

=(n−1X>X

)−1(n−1/2X>u− (n−1X>X0)n1/2(β − β0)

).

Mais notons que

n−1X>X a= n−1X0>X0

a= n−1X>X0,

qui decoule de la convergence de β. Ainsi,

n1/2ba=

(n−1X0

>X0

)−1(n−1/2X0

>u)− n1/2(β − β0).

En ajoutant cette expression a n1/2β afin d’obtenir n1/2 fois l’estimateur enune etape β, nous constatons que

n1/2(β − β0) ∼=(n−1X0

>X0

)−1(n−1/2X0

>u).

En prenant la limite en probabilite de n−1X0>X0, cela devient

n1/2(β − β0)a= plim

n→∞

(n−1X0

>X0

)−1(n−1/2X0

>u). (6.32)

Le membre de droite de cette expression nous semble familier. En realite,le resultat (5.39) qui provient du Chapitre 5 nous montre que n1/2(β − β0)est asymptotiquement egal au membre de droite de (6.32). Nous avons ainsidemontre que l’estimateur en une etape β est asymptotiquement equivalenta l’estimateur NLS β. Par consequent, il doit avoir la meme distributionasymptotique que β, et nous pouvons donc conclure que

n1/2(β − β0)a∼ N

(0, σ2(n−1X0

>X0)−1).

Une estimation en une etape peut se reveler particulierement utile pourimposer des contraintes non lineaires a un modele qu’il est aise d’estimersans contraintes mais qui devient plus delicat a evaluer lorsqu’il est soumis a

6.6 Estimation Efficace en une Etape 199

des restrictions. En particulier, supposons que la fonction de regression noncontrainte soit Xβ et que la fonction de regression contrainte puisse s’ecriresous la forme Xβ(γ), ou β(γ) est un vecteur dont les k composantes sontdes fonctions du vecteur γ a l composantes, l etant inferieur a k, de facona ce que le modele contraint soit non lineaire en ses parametres uniquement.Quelques elements de β(γ) peuvent evidemment etre nuls. Dans ce cas lemodele contraint est

y = Xβ(γ) + u, (6.33)

et le modele non contraint est

y = Xβ + u. (6.34)

Le vecteur des estimations OLS de (6.34), β, fournit un vecteur d’estimationsinitiales convergentes γ. Celui-ci peut etre facile ou non a calculer, et seracertainement non unique, puisqu’il y a moins d’elements dans γ que dans β.La regression qui doit servir a l’obtention des estimations en une etape est laGNR correspondant a (6.33) avec le vecteur de parametres γ evalue en γ:

y −Xβ(γ) = X∗c + residus,

ou la matrice X∗ de dimension n× l est definie par

X∗ ≡ X∂β(γ)

∂γ

∣∣∣∣γ=γ

.

Comme d’habitude les estimations en une etape sont γ = γ + c, et elles serontasymptotiquement equivalentes aux estimations contraintes γ, qui seraient deloin plus couteuses a obtenir.

Intuitivement, les estimateurs efficaces en une etape bases sur la GNRsont asymptotiquement equivalents aux estimateurs NLS pour une raison tressemblable a celle que nous avons exposee a la section precedente pour la va-lidite des tests fondes sur la regression de Gauss-Newton. La GNR realisela minimisation de SSR∗(β + b), qui est une approximation quadratique deSSR(β) autour de β. Asymptotiquement, la fonction SSR(β) est quadra-tique au voisinage de β0. Lorsque la taille d’echantillon est suffisammentimportante, la convergence de β implique que nous prenions l’approximationquadratique en un point proche de β0, et ainsi l’approximation coıncideraasymptotiquement avec SSR(β) elle-meme.

Nous pouvons constater ce qu’il advient en considerant la Figure 6.4.Comme dans les figures de ce genre que nous avons deja vues (par exemple laFigure 2.2), k = 1 et nous supposons que x(β) se situe, du moins localement,dans un sous-espace bi-dimensionnel de Rn, ce qui nous permet de la tracersur le papier. C’est deliberement que nous l’avons dessinee avec un fort degrede non linearite dans cet espace, en vue de rendre les resultats plus faciles a

200 La Regression de Gauss-Newton

........................................

........................................

........................................

........................................

........................................

........................................

........................................

........................................

........................................

........................................

........................................

........................................

........................................

........................................

........................................

........................................

........................................

........................................

........................................

........................................

........................................

..................................................................................................................................................................................................................

....................................

....................................

....................................

....................................

....................................

....................................

...............................................................................................................................................................................................................................................................................................................................................................................

...............................................................

...............................................................................................................................................................................................................................................................................................................................................................................................................................................................................

X

y

x

←− S∗(X)

x←− x+ Xb

Figure 6.4 Estimation efficace en une etape

assimiler. La variete X dessine ainsi une ligne fortement incurvee dans Rn. Aupoint x ≡ x(β) nous prenons une approximation lineaire, x + Xb. Le sous-espace engendre par les colonnes de X, translate de maniere a ce qu’il soittangent a la variete X en x, est designe par S∗(X). L’estimation en une etapeimplique la projection orthogonale de y sur ce sous-espace, afin d’obtenir uneestimation du coefficient, b. Nous obtenons a present l’estimation en uneetape β = β + b. Au contraire, les moindres carres non lineaires impliquentla projection orthogonale de y sur X, au point x. A l’evidence β et β sontgeneralement differents a moins que S∗(X) ne coıncide avec X au voisinagede β. Mais les estimations NLS et les estimations en une etape n’en sontpas moins asymptotiquement equivalentes parce que la convergence de x im-plique que, asymptotiquement, il est si proche de x que X ne peut pas etresuffisamment courbee entre les deux points.

Malheureusement le fait que les estimateurs en une etape fondes sur laGNR soient asymptotiquement equivalents aux estimateurs NLS n’impliquepas que ceux-ci possedent les memes proprietes que ces derniers en echantillonsfinis. Souvenons-nous que l’equivalence implique que le DGP soit y =x(β0) + u. Si le DGP n’est pas un cas particulier du modele, l’equivalenceest caduque. Meme dans le cas contraire, un grand nombre de choses dependde la qualite de l’estimateur convergent initial β. Lorsque β est proche deβ0 et que l’echantillon a une taille importante, SSR∗(β + b) devrait se reveleretre une tres bonne approximation de SSR(β), et donc β devrait etre trespres de l’estimation NLS β. D’un autre cote lorsque l’estimation convergenteest eloignee de β0 (et le fait qu’un estimateur soit convergent n’empeche pasqu’il soit extremement peu efficace), les estimations en une etape peuventdifferer fortement des estimations NLS. Lorsque la difference entre les deuxest significative, nous recommanderions l’usage des estimations NLS, bienqu’en l’absence d’une etude detaillee du modele en cause, il ne soit pas possi-

6.7 Tests Bases sur une Estimation Convergente 201

ble d’etre categorique sur le choix de l’usage d’un estimateur plutot que d’unautre lorsque les deux sont asymptotiquement equivalents. Les estimationsen une etape prennent davantage de sens lorsque la taille de l’echantillon estimportante, ce qui implique que l’estimateur convergent initial est vraisem-blablement satisfaisant, et aussi que les moindres carres non lineaires puissentetre couteux a employer.

6.7 Tests Bases sur une Estimation Convergente

Les procedures de test dont nous avons discute dans les Sections 6.4 et 6.5impliquent toutes l’evaluation d’une regression artificielle aux estimations NLScontraintes, et entraınent par consequent des statistiques de test basees sur leprincipe LM. Mais lorsque la fonction de regression contrainte est non lineaire,il n’est pas toujours pratique d’obtenir des estimations NLS. Par chance, il esttoujours possible d’executer des tests au moyen d’une GNR lorsque n’importequelle estimation convergente a un taux n1/2 qui satisfait l’hypothese nulleest disponible. Dans cette section nous discutons brievement de la facon deproceder.

Supposons que l’on traite la situation dont nous avons discute a la Section6.4, dans laquelle le vecteur de parametres β est partitionne en [β1

.... β2],et l’hypothese nulle est β2 = 0. Supposons que l’on dispose d’un vecteurd’estimations convergentes a un taux n1/2 β ≡ [β1

.... 0]. Alors la GNR,exprimee dans la notation appropriee, est

y − x = X1b1 + X2b2 + residus. (6.35)

La somme des carres expliques de cette regression est

(y − x)>P1(y − x) + (y − x)>M1X2

(X2>M1X2

)−1X2>M1(y − x). (6.36)

Le premier terme est ici la somme des carres expliques de la regression dey − x sur X1 uniquement, et le second terme represente l’accroissement de lasomme des carres expliques cause par la prise en compte de X2. Remarquonsque le premier terme est en general non nul, parce que β1 ne satisfera pas engeneral les conditions du premier ordre pour les estimations NLS du modelecontraint.

La difference entre la somme des carres expliques de (6.35) et la sommedes carres expliques de la regression de y − x sur X1 uniquement est

(y − x)>M1X2

(X2>M1X2

)−1X2>M1(y − x) =

∥∥PM1X2(y − x)

∥∥2.

Cela ressemble justement au numerateur du Fisher (6.24). En realite, l’uniquedifference est que tout est evalue avec les estimations convergentes au tauxn1/2 β, au lieu des estimations NLS contraintes β. Il ne devrait donc pas

202 La Regression de Gauss-Newton

etre surprenant d’apprendre que le Fisher pour b2 = 0 est asymptotiquementequivalent (sous l’hypothese nulle) a celui pour b2 = 0 dans le test LM plusconventionnel de la GNR (6.17).