2005 - Nanosciences Et Nanotechnologies

Transcript of 2005 - Nanosciences Et Nanotechnologies

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 1/92

MISSION SCIENTIFIQUE TECHNIQUE ET PEDAGOGIQUE

Nanosciences et Nanotechnologies

Une réflexion prospective

Mai 2005

MSTP-mai 2005 1

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 2/92

SOMMAIRE

INTRODUCTION…………………………………………………………………………p 3

I - NANOPHYSIQUE…………………………………………………………………...p 7

II - NANOCHIMIE & NANOMATÉRIAUX……………………………………………p 16

III - NANOBIOTECHNOLOGIES……………………………………………………….p 20

IV - NANOSCIENCES & NANOTECHNOLOGIES :…………………………………...p 29Dimension sociétale et problèmes de santé publique

V - APPENDICES

A- TECHNOLOGIES à l’ÉCHELLE ATOMIQUE………………………………p 34

B- MODÉLISATION des MATÉRIAUX et NANOSTRUCTURES :…………...p 38Enjeux et perspectives

C- MÉTHODES de CARACTÉRISATION en NANOSCIENCES……………...p 46

D- PASSAGE MICRO-NANO…………………………………………………...p 50

E- FIABILITÉ et NANOTECHNOLOGIES……………………………………..p 52

F- CAO de SYSTÈMES et CIRCUITS INTÉGRÉS :……………………………p 58Du transistor à la complexité des systèmes

G- NANO-MICROFLUIDIQUE………………………………………………….p 66

H1- APPORT des NANOTECHNOLOGIES aux SOURCES D’ÉNERGIEMINIATURES…………………………………………………………………p 69

H2- NANOTHERMIQUE………………………………………………………….p 70

I- CAPTEURS et NANOTECHNOLOGIES……………………………………...p 73

J- NANOTECHNOLOGIES et NOUVEAUX MÉDICAMENTS……………….p 74

K- DISPOSITIFS MIS en PLACE pour COORDONNER et SOUTENIR lesACTIONS FRANÇAISES dans le DOMAINE des NANOSCIENCES………p 79

VI – CONCLUSION………………………………………………………………………p 83

SYNTHÈSE des RECOMMANDATIONS……………………………………………….p 86

ANNEXES :Liste des auteurs…………………………………………………………………………...p 89Références…………………………………………………………………………………p 90

MSTP-mai 2005 2

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 3/92

INTRODUCTION

Dès l’antiquité, des philosophes ou des poètes, tels Démocrite au Ve siècle ou Lucrèce au Ier siècle avant notre ère, ont eu l’intuition géniale d’imaginer l’existence de particules ultimes,insécables, constituant la matière aussi bien inerte que vivante. Pourtant il a fallu attendredeux millénaires pour que, comme une lointaine descendance, des chimistes, au début duXIXe siècle, établissent scientifiquement les fondements de la théorie atomistique. Ainsi ledéveloppement de la physique et de la chimie modernes repose largement sur ce modèle dereprésentation de la matière.Suivant cette logique d’approche historique, le terme de nanoscience s’inscrit depuis unevingtaine d’années dans la continuité d’une démarche d’investigation qui tend à ouvrir lechamp des connaissances vers une "nouvelle frontière". Qu’il s’agisse des sciences

physiques, chimiques, mais aussi biologiques, l’objectif est désormais la compréhension des phénomènes au niveau du grain élémentaire, de l’atome ou de la molécule, sur desdistances de l’ordre du nanomètre (10¯9m : milliardième de mètre).En parallèle s’est développée progressivement une capacité à observer et à façonner deséchantillons de matière toujours plus petits et mieux contrôlés dans leurs propriétés, ce quiapparaît comme partie prenante d’un nouveau savoir-faire nanotechnologique.

Plutôt que de parler d’une nouvelle science, on est, de fait, en présence d’une nouvelle grillede lecture des avancées scientifiques et technologiques qui concernent désormais la référencede la nano-échelle. A ce titre on propose de reprendre la définition d’Heinrich Rohrer s’appliquant aux objets étudiés :

« La nanoscience s’intéresse aux nano-objets individualisés dont il convient de mesurer, decomprendre mais aussi de modifier sélectivement les propriétés ; ces nano-objets on souhaite

par ailleurs pouvoir les manipuler, les positionner et les usiner. Il s’agit donc dudéveloppement de nouveaux concepts permettant de traiter ces nano-objets et toutspécialement une grande collection d’entre eux ».A ce stade se définit le passage à partir duquel les dimensions de l’objet deviennent

primordiales pour expliquer ses propriétés, chacune d’elles ayant une longueur caractéristique vis-à-vis des phénomènes observés.Un autre précurseur, Richard P. Feynman, déclarait, devant la société américaine de

physique : "il y a beaucoup de place en bas " ; et pour fixer les idées, il montrait que les

30 000 pages de l’ Encyclopædia Britannica, couvrant 1 500 m², pourraient occuper la surfaced’une grosse tête d’épingle (2,5mm²), à condition de savoir réduire de 25 000 fois chaquedirection; un trait de 0,25 mm d’épaisseur se trouverait alors ramené à 10 nm (équivalent à lalargeur d’un film de carbone constitué de 30 atomes disposés côte à côte).

Cette activité de recherche s’inscrit-elle dans une mode de circonstance ou nous entraîne-t-elle dans une dynamique qui va profondément transformer notre monde scientifique ettechnologique ? La réponse à cette question dans le domaine des semi-conducteurs estcontenue dans le constat de la loi de Moore (co-fondateur d’Intel) ; cette loi empirique etvolontariste prévoit une intégration toujours plus poussée du nombre de transistorsincorporés dans une "puce" électronique, avec un doublement tous les 18 mois depuis près

de 40 ans. La programmation de la feuille de route (international technology roadmap for semi-conductors) prolonge et accentue cette tendance vers l’écriture nanométrique pour lesquinze prochaines années avec pour objectifs de produire des objets opérationnels encore

plus petits, plus rapides , moins coûteux et consommant moins d’énergie.

MSTP-mai 2005 3

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 4/92

Plus généralement, malgré les investissements considérables qu’elles exigent, on doitconstater que les nanosciences et les nanotechnologies sont au premier plan de l’actualitéscientifique internationale et que tous les pays techniquement avancés ont affiché ces thèmesen priorité de leur effort de recherche dans un cadre national ou multinational.Ainsi on retient l’effort prioritaire des États-Unis sur les nanobiotechnologies, les objectifs

du Japon en matière de nanosystèmes, la mobilisation des anglais après le constat d’unengagement trop faible et trop tardif dans ce domaine (Too little- too late : Rapport à laChambre des Communes, avril 2004), et la définition d’une stratégie européenne en faveur des nanotechnologies par la Commission des Communautés Européennes (mai 2004).Enfinl’expression d’une politique scientifique et technique de la part des autorités françaises(Ministre Délégué à la Recherche - Décembre 2004) confirme l’intérêt essentiel pour notre

pays de contribuer dans ce domaine à l’avancée du front des connaissances et de partager lamaîtrise de techniques en pleine évolution.

La recherche en nanosciences est, par nature, une activité génératrice de connaissancesinterdisciplinaires animée par l’ambition de comprendre les lois qui gouvernent le

comportement des objets définis à l’échelle nanométrique, que l’on s’intéresse à leurs propriétés physiques, chimiques ou biologiques ; ceci à travers la découverte et l’étude denouveaux phénomènes et l’élaboration de nouveaux concepts pour les décrire.Ainsi les disciplines conventionnelles, en convergence d’approche, ont pu donner naissance àdes nanodisciplines qui tirent leur développement de ce creuset commun.

S’agissant désormais de manipuler les atomes à l’unité et de comptabiliser les électrons et les photons un à un, les technologies utilisées à ce stade sont tributaires des progrès réalisés par les différentes approches du nanomonde :A l’approche descendante, par le haut (top-down), conditionnée par la capacité d’uneminiaturisation toujours plus poussée, peut-on substituer une approche montante, par le

bas (bottom-up), capable d’assembler des nano-éléments (briques élémentaires) fabriqués àla chaîne ?On se trouve alors limité par les performances des moyens d’investigation et des outilsd’opération. Ainsi donc la science et la technologie apparaissent avoir parties totalement liéeset dépendantes dans cette problématique.

Le rapport qui suit a été éclairé par cette perspective ; il vient en complément decontributions majeures, récentes ou en cours, qu’il cite en références principales. :

- le rapport de l’Académie des Sciences et de l’Académie des Technologies ( rst n°18 - Nanosciences – Nanotechnologies ; avril 2004) : un état des lieux, une vue

prospective et des recommandations adressées aux pouvoirs publics.- l’ouvrage à vocation pédagogique, sous la responsabilité collective de MarcelLahmani, Claire Dupas et Philippe Houdy : Nanophysique et Nanotechnologies(collection Echelles – Edition Belin ; Mai 2004).

- CNRS- Focus Nanosciences (en cours) dont la présentation s’inscrit délibérémentdans une perspective opérationnelle pour l’organisme et la communauté scientifique.

La première partie relève les fondamentaux scientifiques des nanosciences dans la logiquemultidisciplinaire de leurs applications présentes et à venir.

La nanophysique succède à la révolution de la microélectronique qui avait déjà rapproché la physique et la mécanique et bientôt la biologie. On décrit les phénomènes de base liés aux

MSTP-mai 2005 4

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 5/92

dimensions nanométriques : l’électronique moléculaire et l’émergence du nanomagnétisme etde l’électronique de spin.Quels sont alors les moyens de fabrication et d’études à cette échelle et les applicationsenvisageables par le passage du composant élémentaire au système combiné ?

La nanochimie va pouvoir toujours mieux contrôler l’organisation de la matière en termesde propriétés physiques, chimiques ou biologiques, mais aussi sur un plan morphologique pour une vision prédictive des synthèses; ainsi en est-il des nano-objets et de leur assemblageen nanomatériaux (multifonctionnels ou adaptatifs). Des exemples de réalisations récentesou à brève échéance sont évoqués.

Les nanobiotechnologies représentent un champ d’expériences et de développementconsidérable depuis les composants jusqu’aux systèmes multiformes et complexes :

- nanoparticules destinées au marquage et/ou à la délivrance de médicaments- nanotubes et nanofils à usage de détection intégrés sur des biopuces.- surfaces nanostructurées par une fonctionnalisation chimique à ciblage spécifique.

Le rapprochement des microtechnologies et de la biologie permet la réalisation de systèmesintégrés in vivo (laboratoire sur puce) avec la mise en oeuvre d’un protocole completd’analyse au sein d’un dispositif miniaturisé aux performances potentiellement considérables.

Ces avancées de la science vers l’infiniment petit, dont on pressent qu’elles peuvent ànouveau apporter des bouleversements dans la vie de chacun, ont une dimension sociétale qu’il convient absolument d’accompagner d’une démarche pédagogique et progressive, en

particulier dans ses dimensions de santé publique. L’exemple des Etats-Unis, en pointe dansce domaine, pourrait inspirer notre propre action à ce sujet.

La seconde partie du rapport est constituée d’un ensemble complémentaired’ "Appendices" dédiés aux technologies en cours de développement, aux voies de progrèsqu’elles dessinent et aux moyens à mettre en œuvre pour s’y engager :

- Les technologies à l’échelle atomique représentent un nouveau champ scientifiquequi laisse espérer la conception de molécule-calculateur ou de molécule-machine.

- La modélisation des matériaux et nanostructures représente un fort enjeu et ouvredes perspectives qu’il convient de rappeler. Si les moyens de calcul nécessairessont disponibles, l’infrastructure logicielle reste insuffisante. Des initiatives ont été

prises à l’échelon européen et des atouts existent au plan national, il revient

aujourd’hui à rapprocher et à organiser les compétences par trop dispersées.-

- Les méthodes de caractérisation utilisées en nanosciences sont décrites etanalysées. Elles s’inscrivent dans une évolution constante d’amélioration de leurs

performances.

- Le passage de la micro à la nano-échelle présente un intérêt particulier,marquant dans ce cas l’importance prise, au sein de la matière, par les propriétés desurface par rapport aux propriétés de volume. Les micro-nanosystèmes, à plusieurséchelles, constituent un pont incontournable entre les nanotechnologies et lesapplications macroscopiques.

MSTP-mai 2005 5

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 6/92

- La fiabilité des nanotechnologies est essentielle pour leur assurer la large diffusionque requièrent les très gros investissements liés à leur mise en œuvre (maîtrise des

paramètres de fabrication et d’évolution des matériaux et systèmes).

- A l’instar des méthodes de CAO appliquées à une microélectronique de plus en plus

intégrée, il convient de développer, à l’échelle nanométrique, des outils deconception allant de la modélisation physique des briques élémentaires àl’élaboration de systèmes de complexité croissante, associant des éléments matérielset logiciels.

- Au-delà de l’électronique, les nanotechnologies s’ouvrent dès maintenant à la nano-microfluidique, la nanothermique, les nanosources d’énergie, aux nanocapteurs et à la nanométrologie. L’ensemble des disciplines est touché par ce changementd’échelle dont la connaissance et la maîtrise conditionnent les développementsfuturs.

- Enfin un domaine probablement immense s’ouvre pour les nanobiotechnologies etles nouveaux médicaments ; la première génération correspondait au ciblage auprèsde certaines cellules, la deuxième génération se fondait sur le concept de résidencevasculaire prolongée, la troisième génération étant dédiée à l’usage de ligands àreconnaissance moléculaire.

- En complément on décrit le dispositif mis en place pour coordonner et soutenir lesactions françaises dans le domaine des nanosciences et nanotechnologies àl’éclairage des déclarations du Ministre délégué à la Recherche (16 Décembre 2004)

La conclusion revient sur l’importance des enjeux tant sur le plan scientifique et technologiquequ’économique, annonçant une nouvelle révolution dans l’environnement de l’Homme et de laSociété.Des recommandations expriment les conditions à réunir dans notre pays pour y participer aumeilleur niveau

Gérard Cognet

Kangi (caractère japonais) signifiant atome

écrit avec des atomes de fer sur du cuivre ©IBM

MSTP-mai 2005 6

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 7/92

NANOPHYSIQUE

Patrice Hesto

L’histoire : la révolution de la microélectronique

Le vingtième siècle a vécu l’avènement de la microélectronique. Jusqu’aux années 1950,les moyens de calcul, de traitement et de stockage des données faisaient appel à des systèmesde grandes tailles, utilisant des puissances électriques très importantes qui devaient être

pilotés par des personnels très qualifiés. Pour le calcul, le développement ultime a été en1945 l’ENIAC qui comportait 19.000 tubes 1 , 1.500 relais et 100.000 capacités etinductances ; il occupait entièrement une salle climatisée et requérait une puissance installéede 200 kW. La machine avait de faibles performances. Pour comparer celles-ci, on peut seramener à la puissance de calcul à prix donné. A l’époque de l’ENIAC, en investissant 100$on ne pouvait effectuer qu’une opération toutes les 10 secondes. Avec les microprocesseursactuels, pour un investissement du même ordre de grandeur on peut effectuer une dizaine demilliards d’opérations par seconde. Pour l’enregistrement, les disques magnétiques avaientatteint leur maximum avec le système RAMAC d’IBM qui, en 1956, permettait d’enregistrer 5 millions de bits de données sur 50 disques de 25". Ici encore, une pièce climatisée étaitnécessaire. Cette capacité est à comparer à celle des disques durs actuels qui, pour undiamètre de 1" permettent d’enregistrer 1.000 milliards de bits. Le passage à la

microélectronique constitue une véritable révolution. Nous en dressons ci-après un rapidehistorique.

On peut considérer que tout a commencé dans les années 1930 avec les bases théoriquesde la mécanique quantique développées par Louis de Broglie et Erwin Schrödinger. Au coursde la décennie suivante, les concepts de la mécanique quantique ont été utilisés avec succès

par Eugène Wigner et son élève Frederik Seitz pour expliquer la conduction dans les semi-conducteurs, matériaux encore mystérieux à l’époque car ils pouvaient conduire l’électricitéou pas suivant les cas. En parallèle, des travaux importants ont été développés concernant lacroissance de semi-conducteurs de qualité, très purs et monocristallins. C’est ainsi que RusselOhl a fabriqué en 1939 du silicium pur à 99,8%2 et que le hasard a permis qu’une craquelure

dans le matériau induise une contrainte avec apparition d’une zone très riche en électrons etune zone très riche en trous. La première diode à jonction PN était née. Une suite logique àces travaux a été l’invention du transistor en 1947 par John Bardeen, Walter Brattain etWilliam Shockley (prix Nobel en 1956). De gros efforts technologiques ont alors étéentrepris et les technologies planaires ont permis à Jack Kilby de développer les premierscircuits intégrés en 1960 (prix Nobel en 2000). La microélectronique était née. Son évolutiona été fulgurante avec, pour les technologies du silicium, un doublement du nombre detransistors par circuit tous les 2 ans entre 1970 et 2004. Cela a été rendu possible par unediminution de la taille des transistors dont les longueurs de grille, les détails les plus fins,

1 Un tube électronique, c'est la "lampe" des postes de radio de l'époque.2 Les puretés requises actuellement sont de l'ordre de 99,9999999999 %, soit moins de 1ppt d'impuretés (partie par trillion

ou mille milliards).

MSTP-mai 2005 7

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 8/92

atteignent actuellement 90nm3 . Les bases du fonctionnement des dispositifs avaient été posées avant les années 1950 ; durant le vingtième siècle le développement relève plus particulièrement du domaine des technologies de fabrication (évolution des procédés mis enoeuvre dans les salles blanches, lithographie, dépôts, gravures, ..) et de l’architecture descircuits ( outils de CAO).

Si le silicium représente plus de 90% du marché des semi-conducteurs, ses propriétés physiques ne permettent pas de l’utiliser pour des applications dans les domaines del’optoélectronique et des circuits hyperfréquences. Par contre les semi-conducteurs composés"III-V" sont tout à fait adaptés pour couvrir ces besoins. Ce sont des matériaux telsl’arséniure de gallium ou le phosphure d’indium qui sont composés à parts égales d’atomesdes 3ème et 5ème colonnes du tableau de Mendeleïev. Ils ont des propriétés de transport dixfois supérieures à celles du silicium (très important pour traiter des signaux hyperfréquences)et permettent d’émettre et de détecter facilement des photons dont les caractéristiques sont,

par exemple, compatibles avec l’utilisation des fibres optiques pour les réseaux detransmission. Ils permettent également de réaliser des lasers à semi-conducteurs, éléments de

base des lecteurs DVD. Pour réaliser de tels dispositifs, il faut confiner les électrons dans des puits de potentiel, ce qui peut être réalisé avec des hétérostructures épitaxiées, contraintes ourelaxées. Ces recherches ont nécessité des équipes multidisciplinaires avec des technologues,des physiciens et des chimistes. Les premières idées sur les hétérojonctions sont apparues dèsles années 1960 ; des méthodes d’épitaxies performantes et une bonne compréhension des

phénomènes physiques mis en jeu ont permis de les réaliser dans les années 1970 (travauxde Zhores Alférov et Herbert Kroemer, prix Nobel en 2000). Actuellement, les équipes quidéveloppent les composants du silicium de taille inférieure à 90nm doivent non seulementfaire progresser les technologies mais également prendre en compte les phénomènesquantiques liés à la taille des dispositifs ; les communautés scientifiques des III-V et dusilicium ont des problématiques communes.

Pour ce qui est des disques durs, l’évolution a été encore plus rapide avec actuellement undoublement de la capacité d’enregistrement par unité de surface tous les 15 mois. Celarésulte bien évidemment de l’amélioration des matériaux magnétiques supports. Toutefois ladécouverte du phénomène de magnétorésistance géante (GMR) en 19884 et une applicationrapide au niveau des têtes de lecture ont permis l’accélération que l’on connaît depuis unedizaine d’années.

On peut ainsi décrire l’évolution de la micro-opto-électronique en trois phases : une première période, avant les années 1950 où les physiciens du solide, grâce à leurs travaux,ont développé la physique des semi-conducteurs et la fabrication de matériaux

monocristallins très purs, une seconde phase jusqu’aux années 1990 où les technologues etles concepteurs de circuits ont su faire progresser les circuits pour atteindre des composantssubmicroniques et enfin la période actuelle où des équipes multidisciplinaires constituées de

physiciens, chimistes, électroniciens et concepteurs de circuits travaillent aussi bien dans leslaboratoires académiques que dans les laboratoires de R&D industriels.

Un autre domaine a eu une évolution très parallèle à celle de la microélectronique : lamicromécanique. Depuis deux décennies, les sauts technologiques qui ont été réalisés et misen œuvre dans les domaines de la mécanique et de la métallurgie, dans la thermique et dans

3 Un transistor à effet de champ est un condensateur. Le courant est véhiculé par les charges induites sur l'une des armatures

du condensateur par une tension appliquée entre celle-ci et l'autre armature appelée grille.4 La magnétorésistance géante a été découverte en 1988 par Albert Fert à Orsay et Peter Grünberg de Jülich. Elle permet

d'améliorer d'un facteur 10 à 100 la détection des champs magnétiques associés aux bits sur les disques durs. On produit

actuellement plus de 600 millions de têtes de lecture à GMR par an dans le monde.

MSTP-mai 2005 8

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 9/92

l’énergétique depuis plus d’un siècle, ont permis de converger vers des approches similaires.Les deux "métiers", mécanique et électronique se sont ignorés jusqu’à la découverte de la

piézo-électricité par Pierre Curie en 1886, propriété qui associe étroitement dans le mêmematériau monocristallin (ou son équivalent) l’électricité et la mécanique des solides. Cettedécouverte a sans aucun doute été l’une des plus importantes avec celle des semi-conducteurs

car elle est la base incontournable de toutes les grandes avancées technologiques en capteurs,actionneurs, systèmes de communication, systèmes de détection et de guidage et dans ledomaine des microordinateurs.

La miniaturisation des composants et des systèmes a intéressé les mécaniciens, en particulier les chercheurs et les ingénieurs, comme exemple d’association des matériaux piézoélectriques et des matériaux semi-conducteurs. Ils ont alors été d’un apport fondamentaldans d’autres microstructures telles que les micromoteurs, les micro- actionneurs, lesmicropompes, les microsystèmes appelés MEMS (micro-electro-mechanical system).

L’intérêt qu’on leur a porté, a été stimulé par les conditions nouvelles d’études des propriétés des matériaux solides du fait de la prépondérance des effets de surface par rapport

aux effets de volume mais aussi du fait des microstructures nouvelles obtenues par lestechnologies de dépôts de couches minces. Il faut alors de nouveaux modèles et de nouveauxinstruments d’investigation locale pour optimiser un matériau ayant des propriétésfonctionnelles, adaptées aux besoins.

De plus l’apport des techniques de fabrication proches ou identiques à celles de lamicroélectronique a ouvert la voie à des approches de fabrication collective de pièces et demécanismes de très petites dimensions tous identiques. La réduction de taille desmicrostructures mécaniques a aussi induit des recherches originales en mécanique des fluidescar par suite de la réduction de la taille des canaux, cuvettes et éjecteurs, les nombres deReynolds deviennent très petits et les effets de parois prépondérants. Les notions de mélange,

de flux laminaire, de turbulence sont alors à reconsidérer. Cette nouvelle microfluidiqueouvre un vaste champ d’études et d’applications pour la chimie, la biotechnologie etl’aérodynamique. La micro-fabrication collective laisse espérer des systèmes identiques, àcommande répartie et distribuée pour provoquer par un effet de nombre des actionsfluidiques impossibles à réaliser par des approches macroscopiques.

Aujourd’hui, une consolidation des études est engagée pour étendre les champsd’application vers la réaction chimique, les synthèses de produits, les laboratoires sur puce, lecontrôle d’écoulement en aérodynamique…Dorénavant, si les chercheurs s’intéressenttoujours aux propriétés électroniques, optiques et magnétiques des nanostructures, ils sontégalement concernés par leurs propriétés mécaniques, thermiques et énergétiques.

Le XXe siècle : la révolution des nanosciences

Si on peut qualifier le vingtième siècle de siècle de la microélectronique, le vingt etunième sera certainement celui des nanosciences. Pour préciser le périmètre couvert, on peutdire simplement que les nanosciences sont concernées par tout ce qui est de taillenanométrique. Au delà de cette définition quelque peu restrictive, on considére dans le cadrede ce rapport, toutes les structures dans lesquelles on a une notion de confinement, tel leconfinement quantique, conduisant à un comportement qui ne peut s’expliquer par des loisd’échelle extrapolées depuis le niveau macroscopique. Dans ce domaine, les phénomènes desurface prennent le pas sur les propriétés de volume. Le développement ne peut se faire que

grâce à une approche globale, par des équipes multidisciplinaires regroupant des physiciens(étude des phénomènes quantiques, du nanomagnétisme,...), des chimistes (création de

MSTP-mai 2005 9

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 10/92

structures artificielles,...), des technologues (architectures, fabrication et caractérisation desstructures de base, fabrication des circuits,...) et des concepteurs (architectures des systèmes).

Les lois de base de la thermodynamique et de la thermique qui concernent l’énergétique,sont également remises en cause par l’extrême miniaturisation. Il est important d’étudier lesruptures de propriétés induites qui auront alors des conséquences positives ou négatives sur les applications aux sources d’énergie, au stockage, au refroidissement, à la mesure et aucontrôle de la chaleur et de l’énergie.

Pour illustrer les différents aspects de la nanophysique, nous évoquons ci-après quelques phénomènes de base ou nouvelles orientations qui apparaissent aujourd’hui, ainsi que lesmoyens de fabrication, en faisant le point sur les outils d’études expérimentales et desimulation des phénomènes de base et des structures élémentaires. Les applications dans ledomaine des nanostructures semi-conductrices et les technologies de l’information et de lacommunication seront abordées en évoquant les aspects fiabilité et criticité et en menant uneréflexion sur l’utilisation des structures élémentaires pour réaliser les systèmes du futur. Lefoisonnement exceptionnel des travaux autour des nanosciences est très sensible dans les

différents articles cités en référence ou joints à ce dossier. Les références traitant de la physique des nanostructures parlent également de technologies de réalisation ; lestechnologies ne peuvent progresser que grâce à la compréhension des phénomènes physiquesmis en jeu et la chimie est incontournable dans les domaines des matériaux et des procédésde fabrication et d’élaboration. Les concepteurs se sentent de plus en plus concernés, demême les acteurs des domaines applicatifs ont compris que les approches devaient êtremultidisciplinaires. Ces intrications des différents domaines des sciences dures 5 ennanophysique sont bien mises en évidence dans le FOCUS-CNRS qui traite desnanosciences.

Nous terminerons en dressant un panorama rapide du contexte français.

Les phénomènes de base liés aux dimensions nanométriques

La mécanique quantique a prédit le caractère ondulatoire des électrons et des interférencesentre faisceaux d’électrons ont été réalisées dans le vide. Une telle expérience est trèsdélicate dans les matériaux et actuellement seules deux équipes, dont une française, l’ontréussie. En effet les interactions inélastiques que subissent les électrons dans les solidesdétruisent la cohérence de phase et limitent ainsi la "longueur de cohérence de phase".Lorsque les dimensions deviennent plus faibles que cette longueur, le comportement desélectrons est quantique et les lois classiques, la loi d’Ohm par exemple, ou encore la notionde masse effective, ne sont plus valables. Une des signatures remarquables de la cohérence

de phase est la possibilité d’avoir un courant permanent en l’absence de tout générateur dansun système annulaire mésoscopique composé de matériaux dont la résistance n’est pas

nulle /1/.

Une alternative aux composants actuels est l’utilisation de molécules fonctionnaliséescomme composants élémentaires. C’est le domaine de l’électronique moléculaire avec en

particulier les fullerènes et les nanotubes de carbone, un domaine à la frontière entre la physique et la chimie en pleine évolution, qui pourrait déboucher sur les systèmes performants assurant des fonctions de calcul, de traitement, de stockage d’informations etd’actionnement fabriqués à moindre coût /2,3/.

5 Les aspects sociétaux font l'objet d'un chapitre spécial.

MSTP-mai 2005 10

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 11/92

La découverte de la magnétorésistance géante (GMR) a ouvert la voie à l’émergence dunanomagnétisme et de l’électronique de spin. Ces approches utilisent le fait que l’électron aun spin et que les niveaux d’énergies possibles pour les électrons à spin majoritaire peuventêtre différents de ceux pour les électrons à spin minoritaire. Il s’ensuit des possibilitésnouvelles, notamment dans le domaine des structures dites à vanne de spin qui, compte tenu

de leur polarisation magnétique, ne laissent passer que les électrons qui ont le bon spin. On aainsi des performances de détection de champ magnétiques multipliées par 10 ou 100 par rapport à la magnétorésistance géante /4/.

Les machines actuelles utilisent en général des variables classiques qui ont des niveaux bien définis avec un comportement déterministe. En fait le principe d’incertitude inhérent à lamécanique quantique n’empêche pas un calculateur de fonctionner mais le schéma classiquedes machines de type Von Neumann est à reconsidérer 6. L’amorce des réflexions théoriquesdate des années 1980 et les premières réalisations ont été obtenues en 2000/5/.

La fabrication

Pour fabriquer des nanostructures, on a classiquement deux grandes approches. D’un côtéon diminue la taille des objets existants en améliorant les procédés technologiques ; c’est ladémarche descendante (top-down) bien connue dans les domaines de la microélectronique etdes microsystèmes. On peut également utiliser la démarche inverse en partant de moléculesque l’on fonctionnalise dans des systèmes de plus en plus complexes ; c’est l’approchemontante (bottom-up) /6/. Pour la démarche montante, on peut partir d’agrégats constitués dequelques atomes contrôlés à échelle nanométrique /7/. Enfin une troisième voie, certainement

plus lointaine, consiste à rester à échelle nanométrique et à concevoir des systèmes completsen rendant fonctionnelle une molécule unique /8/.

Les moyens d’étude

Pour accompagner le développement des nanostructures, deux ensembles d’outils sontnécessaires : (i) des modèles permettant de comprendre les phénomènes physiques mis en jeuaussi bien lors de l’élaboration des structures que lors de l’analyse de leur fonctionnement /9/,(ii) des moyens de caractérisation adaptés aux dimensions nanométriques /10,11/.

Les domaines applicatifs

Toutes les structures de base étudiées sont utilisées pour les domaines applicatifs. Le

premier d’entre eux concerne les technologies de l’information et de la communication avecen particulier les moyens en traitement et stockage des informations /12/. C’est dans cedomaine que les retombées sont les plus prévisibles avec les composants actuels qui ont destailles submicroniques (<<1µm), certains pouvant utiliser quelques électrons, voire un seul.Des travaux importants concernent les nanostructures semi-conductrices, souvent sous formede boîtes quantiques qui permettent de confiner les électrons, avec des applicationsimportantes notamment dans le domaine de l’opto-électronique /13/.

6 John Von Neumann est à l'origine (1946) d'un modèle de machine universelle qui possède les éléments suivants : une

mémoire contenant programme et données, une unité arithmétique et logique (UAL ou ALU), une unité d'entrée/sortie

(E/S ou I/O) et une unité de commande (UC)

MSTP-mai 2005 11

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 12/92

Du composant au système

Un problème important, qui concerne aussi bien les technologies que les architectures se pose : c’est la communication entre des dispositifs de tailles nanométriques (les composantsélémentaires) et des connexions ou des commandes de taille macroscopique pour réaliser un

système complexe /14/. Notre société supporte de plus en plus mal les dysfonctionnements et demande des

systèmes robustes avec des niveaux de fiabilité élevés. Il est certain que ces aspects doiventêtre pris en compte dès la conception des structures de base et que le vieillissement dessystèmes doit être étudié soigneusement /15/.

Quand on regarde l’évolution de la microélectronique au cours du vingtième siècle, lesdifférents aspects de conception et de réalisation, ont progressé en parallèle. Les premierstransistors à effet de champ ont conduit aux premiers circuits intégrés qui en comportaientquelques dizaines, voire un millier. Les systèmes ont progressivement évolué vers les circuitsintégrés actuels qui peuvent comporter jusqu’à un milliard de transistors de taille inférieure à0,1µm. La démarche générale était de définir les fonctions visées, de concevoir les circuits

pour les réaliser et de les fabriquer avec des technologies de plus en plus sophistiquées. Lesoutils informatiques des concepteurs de circuits ont suivi cette évolution. Cela est illustré sur la figure par une droite qui suit la fameuse loi de Moore. Cette loi permet des extrapolations

pour les années futures et on prévoit des systèmes avec 1000 milliards de transistors vers lesannées 2030-2040 ayant chacun une dimension inférieure à 10 nm. Les nanotechnologies

permettent actuellement de fabriquer ces structures élémentaires de taille nanométriques(dispositifs à un électron, moléculaire) et on devrait rapidement savoir réaliser au laboratoiredes systèmes avec quelques milliers de composants tous fonctionnels. Il faudra toutefois, àéchéance d’une vingtaine d’années, réaliser, à partir de ces structures élémentaires, des

systèmes comportant ces milles milliards de composants avec un rendement suffisant pour que les circuits soient opérationnels. Il faudra certainement reconsidérer l’architecturegénérale et on risque d’inverser la démarche "micro-électronique" en réalisant des circuitstrès complexes, offrant la possibilité de multiples fonctions différentes, avec une notiond’apprentissage. On saura faire mais sans forcément comprendre l’aboutissement du résultat.Ce défi est certainement aussi difficile à relever que celui concernant les structures elles-mêmes, comme le montrent certains aspects développés en appendice /16/.

MSTP-mai 2005 12

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 13/92

La courbe en rouge correspond à la loi de Moore avec les années en abscisse et la taille des motifs élémentaires en

ordonnée. Les rectangles en bleu correspondent à des systèmes dont la taille est sur l’échelle horizontale supérieure. La loi

de Moore et l’approche "nanométrique" convergent vers les années 2040 dans le rectangle vert.

La nanomécanique, la nanothermique et la nano-énergétique

Ces domaines, qui représentent des défis complémentaires de la nano-électronique,supposent bien évidemment un choix et une maîtrise des matériaux de tailles nanométriques

pour leur mise en œuvre et leurs propriétés. Ceci est vrai et même essentiel pour lesmatériaux à propriétés spécifiques de la nanomécanique et des nanomécanismes. Ainsi, ennanomécanique des milieux continus solides ou semi-rigides (polymères et gels), lesmatériaux en fibres (carbure, acier, or) ou composites nanométriques ont des propriétésmécaniques très anisotropes complètement nouvelles. Les polymères et les gelsélectrodynamiques ou thermodéformables sont des candidats potentiels extrêmementattractifs pour des nanosystèmes défavorables (nanomoteurs, nano-actionneurs,nanogénérateurs). La nanofluidique est aussi un domaine d’avenir pour de nombreuses

applications aux nanosystèmes dédiés aux sciences chimiques, biologiques et aux futurssystèmes d’intérêt primordial pour les sciences de la vie /17/.

La nano (ou micro) stucturation en canaux, puits ou fonctions est essentielle mais les parois doivent être fonctionnalisées localement pour que les fluides rencontrent au cours deleur trajet des zones à propriétés spécialement définies. La fonctionnalisation peut être faite

par dépôts/croissance (nanotubes par exemple) ou par physicochimie auto-organisante.

Aux dires des experts du MIT, c’est l’une des clés de la complexité des nanosystèmescombinant fluides et solides, à l’horizon de plusieurs décennies.

Dans ce cadre, des éléments relatifs aux sources d’énergie miniatures sont rassemblés

dans les appendices H1, H2 /18/

Le dispositif français

Un certain nombre de moyens structurants ont été mis en place en France pour accompagner la révolution des nanosciences et des nanotechnologies. Un

programme "nanosciences", a été initié par le Ministère délégué à la Recherche, le CNRS, leCEA et la DGA, pour coordonner les actions incitatives, en appui des réseaux de centralesde technologie et des centres de compétences " nano" . Il est repris sous la forme du

programme "nanosciences- nanotechnologies" confié à l’Agence Nationale de la Recherche .En complément, de nombreuses formations sont proposées dans le cadre de la réforme du

système LMD (licence-maîtrise-doctorat) /19/.

Remarques

Ce texte se veut complémentaire de la publication FOCUS-CNRS consacrée aux Nanosciences. De plus, les réflexions s’appuient sur les aspects scientifiques développés dansle rapport sur la science et la technologie de l’Académie des Sciences et de l’Académie desTechnologies 7, largement cité dans les références.

7 Rapport sur la science et la technologie de l'Académie des Sciences et de l'Académie des Technologies, rst

n°18, Avril 2004, Editions Tec & Doc

MSTP-mai 2005 13

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 14/92

Références/1/ Bouchiat Hélène, Mailly Dominique

Transport quantique cohérent

Rapport sur la science et la technologie de l’Académie des Sciences et de l’Académie des

Technologies, rst n°18, Avril 2004, Editions Tec & Doc, p199

/2/ Launay Jean-Pierre

Electronique moléculaire

Rapport sur la science et la technologie de l’Académie des Sciences et de l’Académie des

Technologies, rst n°18, Avril 2004, Editions Tec & Doc, p113

/3/ Bourgoin Jean Philippe

Electronique moléculaire

Rapport sur la science et la technologie de l’Académie des Sciences et de l’Académie des

Technologies, rst n°18, Avril 2004, Editions Tec & Doc, p185

/4/ Chappert Claude

Nanomagnétisme et électronique de spin

Rapport sur la science et la technologie de l’Académie des Sciences et de l’Académie des

Technologies, rst n°18, Avril 2004, Editions Tec & Doc, p213

/5/ Estève Daniel

Vers des machines quantiques

Rapport sur la science et la technologie de l’Académie des Sciences et de l’Académie desTechnologies, rst n°18, Avril 2004, Editions Tec & Doc, p175

/6/ Mailly Dominique

Elaboration des nanostructures

Rapport sur la science et la technologie de l’Académie des Sciences et de l’Académie des

Technologies, rst n°18, Avril 2004, Editions Tec & Doc, p261

/7/ Bréchignac Catherine

Agrégats : précurseurs des nano-objets

Rapport sur la science et la technologie de l’Académie des Sciences et de l’Académie des

Technologies, rst n°18, Avril 2004, Editions Tec & Doc, p235

/8/ Joachim Christian

Technologies à l’échelle atomique

Appendice A

/9/ Jollet François, Leray Jean-Luc et Zérah Gilles

Modélisation des matériaux et des nanostructures : enjeux et perspectives

Appendice B

/10/ Roditchev Dimitri

Microscopies modernes : moyens expérimentaux pour la nanoscience

Rapport sur la science et la technologie de l’Académie des Sciences et de l’Académie des

Technologies, rst n°18, Avril 2004, Editions Tec & Doc, p245

MSTP-mai 2005 14

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 15/92

/11/ Menand Alain, Lecomte Claude, Hauden Daniel

Méthodes de caractérisations

Appendice C

/12/ Weisbuch Claude

Les nanotechnologies de l’information et de la communication

Rapport sur la science et la technologie de l’Académie des Sciences et de l’Académie des

Technologies, rst n°18, Avril 2004, Editions Tec & Doc, p325

/13/ Voos Michel

Les nanostructures de semiconducteurs

Rapport sur la science et la technologie de l’Académie des Sciences et l’Académie des

Technologies, rst n°18, Avril 2004, Editions Tec & Doc, p273

/14/ Hauden Daniel

Passage micro-nano

Appendice D

/15/ Danto Yves Haute fiabilité en nanotechnologies

Appendice E

/16/ Robert Michel

CAO de systèmes et circuits intégrés : du transistor à la complexité des systèmes

Appendice F

/17/ Hauden Daniel

Microfluidique

Appendice G

/18/ Gauthier-Manuel.B Apport des nanotechnologies aux sources d’énergie miniatures

Appendice H1

Volz.Sébastien

Nanothermique

Appendice H2

/19/ Hesto Patrice

Dispositifs mis en place pour coordonner et soutenir les actions françaises dans le domaine des

nanosciences.

Appendice K

&&&

MSTP-mai 2005 15

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 16/92

NANOCHIMIE & NANOMATERIAUX

Michel Ribes

A l’heure où les nanosciences connaissent un développement considérable, il paraît utile demettre en perspective l’apport indispensable de la chimie plus particulièrement dans le

domaine des nanomatériaux où l’approche dite « bottom-up » semble la plus prometteuse.

Grâce à la maîtrise des concepts qui gouvernent la réactivité chimique, la structuremoléculaire et l’organisation des solides, les chimistes ont pu mettre au point des méthodesde synthèse efficaces et sélectives qui leur ont permis d’isoler des architectures complexes.Aujourd’hui ils ont non seulement réussi à contrôler les tailles de nanoparticules mono ou

poly métalliques mais aussi à maîtriser de manière prévisionnelle un certain nombre desystèmes cristallisés mésoporeux. Ils ont pu également s’affranchir du contrôlethermodynamique dans la synthèse des solides (la chimie douce ou chimie « sol-gel » permetl’obtention de solides par des voies de polycondensation hydrolytique relevant uniquementd’un contrôle cinétique). Enfin le développement remarquable observé dans la chimie

supramoléculaire ouvre l’accès à des assemblages insoupçonnés (tectonochimie, moteursmoléculaires, …).

Les avancées de la chimie supramoléculaire d’une part, la meilleure compréhensionde la chimie « sol-gel » des hybrides organiques-inorganiques et des systèmes mésoporeuxd’autre part, ont permis de mieux appréhender les règles de l’auto-association. Par ailleurs,des amphiphiles possédant des unités pouvant être biologiques s’auto-organisent sous formede micelles. De même des associations de polymères poly cationiques et poly anioniques

permettent d’obtenir des coquilles nanométriques rigides. Tout ceci ouvre un champimmense pour accéder à l’organisation d’entités douées de propriétés physiques comme : lesnanoparticules métalliques ou semi-conductrices, le magnétisme moléculaire, les polymèresconducteurs, les systèmes électro et photo-luminescents, les entités pour l’optique nonlinéaire, les poudres d’oxydes photo-oxydables ou photo-réductrices, les films de matériauxhybrides organiques-inorganiques doués de propriétés mécaniques étonnantes.

Actuellement les données de base sont réunies pour permettre aux chimistes enassociation forte, en premier, avec les physiciens mais aussi avec les biologistes et lestechnologues de se lancer dans l’aventure de la maîtrise de l’organisation de la matière.

1. Définitions

Une définition assez large des nanomatériaux pourrait se décliner comme suit« Synthèse et étude de nano-objets (échelon élémentaire, briques de base) doués de

propriétés (physiques, chimiques ou biologiques) nouvelles ou exacerbées par effet de taille,

MSTP-mai 2005 16

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 17/92

méthodes d’assemblage et d’organisation permettant d’aboutir à des nanomatériaux et/ouà des matériaux adaptatifs (smart materials) ».

L’étape fondamentale est la création de nano-objets. A ce stade, même si ces "briques de

base" ont des propriétés remarquables, elles resteraient inexploitables si parallèlementn’étaient découvertes et développées des méthodes spécifiques d’assemblage (auto-assemblage) et de mise en forme (films, fibres, composites, solides à porosité contrôlée…)

permettant de passer du nano-objet, curiosité de laboratoire, au matériau doué de propriétés précises et utilisables. Dans le cas des matériaux adaptatifs il faudra de plus savoir organiser et coupler de façon interactive des propriétés différentes.

Ainsi définis les nanomatériaux se situent dans un vaste champ de recherche pluridisciplinaire impliquant des spécialistes d’horizons divers : physiciens, chimistes,mécaniciens…

2. Les nano-objets

Ils représentent les briques élémentaires des matériaux du futur. Ils peuvent êtreconstitués d’un assemblage d’atomes (« cluster » , nanoparticule métallique ou stadeélémentaire d’une combinaison minérale…). Il pourra souvent s’agir d’une moléculespécifiquement synthétisée dans le but d’obtenir une propriété particulière : optique,magnétique, électrique, chimique (catalyse, séparation) mécanique, etc… Dans tous les cas la

propriété doit être précise, mesurable et contrôlable : la synthèse du nano-objet doit êtrefocalisée sur la propriété dont on souhaite le doter. Le degré de précision atteint par lasynthèse chimique ouvre la possibilité de réaliser la préparation de n’importe quel objet

chimique conçu autour d’une propriété.La synthèse et l’étude des nano-objets n’est qu’un préalable. Le but à atteindre est la

synthèse de matériaux et, à terme, l’accès aux « matériaux adaptatifs ». Le nano-objet isolén’est pas un matériau : en l’absence d’assemblage et de mise en forme, il restera une curiositéde laboratoire.

3. Les nanomatériaux

Ils vont résulter de l’assemblage des nano-objets, leur préparation passe donc par lamise en œuvre des méthodes chimiques permettant l’assemblage et conduisant à un matériau

sous forme de film, fibre, matrice ou solide poreux. Pour arriver à ce résultat, il seranécessaire de choisir l’assemblage le mieux adapté à l’obtention du matériau visé (matriced’oxyde, matrice polymère, matrice hybride ou autre). Ceci va passer en particulier par lamaîtrise des systèmes présentant des liaisons stables covalentes, ioniques, hydrogène, maiségalement par celle de systèmes sièges d’interactions moins connues (forces de type Van der Waals, forces d’interaction à longues distances comme les forces d’hydratation, defluctuation et de déplétion). Un grand nombre de solutions existent pour accéder à cette étaped’assemblage. Il est probable que les chimistes devront en découvrir de nouvelles. Cet aspectconstitue un domaine de recherche essentiel pour l’avenir des nanosciences.

4. Les matériaux multifonctions - Les matériaux adaptatifs

Au-delà du concept un matériau/une fonction, il devient possible au sein d’un mêmeédifice de faire interagir plusieurs fonctions : une propriété peut en moduler une autre ou la

MSTP-mai 2005 17

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 18/92

coexistence de deux ou plusieurs propriétés peut en créer de nouvelles. Les nanomatériauxainsi obtenus le sont généralement par couplage de plusieurs nano-objets ayant chacun une

propriété différente d’ordre physique, chimique, mécanique ou autre. Le couplage interactif de ces nano-objets impliquera un contrôle parfait de leur organisation et de leurs fonctionsd’interaction mais aussi une bonne connaissance des effets des perturbations extérieures

pouvant moduler les propriétés physiques (température, pression, champ magnétique …). Ilest clair que beaucoup de choses restent à découvrir dans ce domaine.

Ce sera certainement le domaine de prédilection de la « nanochimie douce et biomimétique » qui offre une stratégie basée sur un codage de plus en plus précis etintelligent ouvrant les portes à une « chimie vectorielle ». Cette dernière permet desassemblages variés (nanoparticules, clusters, nano-composites hybrides) donc desarchitectures de plus en plus complexes. Des structures hiérarchisées se développant sur

plusieurs échelles de taille (nano-micro-mésométrique) ont été obtenues. Elles ouvrent lavoie à la conception de matériaux originaux, autoréparables ou autoréplicables.

5. Quelques exemples

Des exemples peuvent être cités. Loin de constituer une liste exhaustive, ils sontchoisis pour illustrer quelques voies de synthèse et quelques domaines d’application.

Synthèse

La « chimie douce » avec ses réactions à température ambiante et en solution,compatibles avec la présence de composantes minérales, organiques ou biologiques et sesfacilités de mise en forme, s’avère incontournable pour développer une approche

« biomimétique » des matériaux. Bien que la recherche dans ce domaine soit encoreexploratoire, plusieurs voies de synthèse sont actuellement testées :- par « transcription », en utilisant des gabarits (organiques, bio ou inorganiques)

moléculaires, supramoléculaires ou macromoléculaires afin de servir de moules structurants,- par « assemblage en synergie » ; dans ce cas les précurseurs et les agents texturants

(les gabarits) sont co-assemblés in situ dans des architectures organisées,- par « morphosynthèse » en utilisant des transformations chimiques dans des

domaines en géométries confinées (micro-émulsions, micelles, vésicules….) pour produiredes matériaux avec des formes complexes.

Une meilleure compréhension des mécanismes de formation devrait permettre deconcevoir des nanomatériaux originaux et sur mesure dans des domaines aussi variés que

l’optique linéaire et non linéaire, le magnétisme, la catalyse et photocatalyse ou encore lescosmétiques.

Applications

Le stockage et le traitement de l’information vont être profondément bouleversés par les possibilités offertes par les nanomatériaux : stockage magnétique ou optique ettraitement optique par exemple. La maîtrise des propriétés à l’échelle atomique (nano-objets)et leur organisation contrôlée permettront des progrès très nets dans la miniaturisation etdonc dans l’augmentation des capacités de stockage.

Des télécommunications ultrarapides basées sur les phénomènes optiques serontassez rapidement maîtrisées. Ce domaine est l’un des plus prometteurs pour le couplage entreles chimistes et les physiciens car la chimie de coordination a atteint une maturité suffisante :

MSTP-mai 2005 18

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 19/92

i) pour préparer des nano-objets doués des propriétés optiques souhaitables, ii) pour lesorganiser et iii) pour leur permettre de communiquer de manière contrôlée à l’aided’espaceurs modulables. Le photomagnétisme qui consiste à adresser, puis moduler les

propriétés magnétiques d’édifices par voie optique en est une bonne illustration.

Le stockage de l’énergie : défiant les lois bien établies sur le fonctionnement des batteries au lithium qui ont envahi aujourd’hui le marché des portables (processus classiquesd’insertion/désinsertion d’ions lithium, formation d’alliages avec le lithium), l’intérêt de lamise en œuvre de nanoparticules vis-à-vis du stockage de l’énergie vient d’être montré. Aucontraire des réactions d’insertion classique qui gouvernent les accumulateurs actuels à ionslithium et qui sont limités à 1 électron voire 0.5 électron par atome de métal (cas du LiCoO2),ces nouvelles réactions mettant en jeu des nanoparticules métalliques peuvent impliquer 2électrons voire plus par atome métallique. Il en résulte une amélioration des performances(au moins d’ un facteur 3) ouvrant de nouvelles opportunités. Le stockage de l’énergie seraégalement accessible par le développement de nouveaux systèmes. La maîtrise des ensembles

poreux par l’organisation des fonctions à l’intérieur des pores et des parois du matériau ouvre

d’intéressantes perspectives pour le stockage séparé d’anions et de cations à fort potentielélectrochimique.

L’avènement de capteurs sélectifs susceptibles de détecter sans ambiguïté etquantitativement des traces de matière est l’un des prolongements directs de l’introduction dela chimie dans les nanosciences. Les technologies modernes auront de plus en plus besoin desystèmes de détection ultra sélective et quantitativement précise, qu’il s’agisse de la détectionde matières organiques, de métaux lourds, de biomolécules, etc… On se retrouve face à un

besoin très large qui recouvre tous les secteurs de la vie sociale : industrie, environnement,santé, transport, etc… Notons que l’un des enjeux majeurs dans ce domaine est la maîtrisedes problèmes de pollution.

La catalyse préfigure elle aussi, un vaste champ d’applications pour les nanosciences.Les catalyseurs du futur tendront vers la sélectivité absolue de l’acte catalytique. Ceciimposera la maîtrise parfaite d’un centre catalytique qui sera souvent poly métallique et dontl’environnement solide permettra de contrôler la sélectivité de fonction et de formes. On saitque l’enjeu économique de la catalyse est considérable.

Les matériaux permettant des séparations ultra sélectives représentent un autreobjectif majeur. A côté des systèmes de détection, il sera nécessaire de posséder des outils

permettant des séparations sélectives d’ions, de produits chimiques ou biologiques. La

séparation des actinides fait également partie des potentialités à développer.

Références

Rapport de l’Académie des Sciences et de l’Académie des Technologies « Nanosciences et Nanotechnologies » (Avril 2004).Partie I – NanochimieEnsemble des contributions et plus particulièrement

• Introduction ; polymérisation minérale : R. Corriu• Vers une nanochimie douce et biomimétique : J. Livage et C. Sanchez• Nanotechnologie, auto-assemblage et chimie supramoléculaire : M.W. Hosseini

Nano-objets et nanostructures préparés par approche bottom-up : enjeux et perspectives. Projet de

réseau national : rapport au comité Nanosciences : M. Drillon J.M. Tarascon et al., Nature (407 (6803), 496-499 (2000)).

&&&

MSTP-mai 2005 19

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 20/92

NANOBIOTECHNOLOGIES

Pierre Puget

1. Définition et position du problème

Les Nanobiotechnologies constituent le domaine de convergence des nanotechnologies et dela biologie. Dans ce sens, elles regroupent :

• l’ensemble des nanotechnologies qui trouvent des applications dans divers domainesde la biologie (en particulier de nouveaux instruments pour comprendre lefonctionnement du vivant, de nouveaux moyens pour la médecine et la santé, que ce

soit au niveau du diagnostic, de la thérapie, de la délivrance de médicaments),• les biotechnologies, mettant en œuvre des biomolécules, biomatériaux ou procédés

pour des applications finales en dehors de la biologie. On peut citer par exemplel’élaboration de nouveaux matériaux biomimétiques, l’utilisation de procédés d’auto-assemblage empruntés à la biologie, l’utilisation de molécules biologiques pour l’électronique moléculaire.

Le domaine des nanobiotechnologies est relativement multiforme et complexe. Unesegmentation possible (inspirée des travaux menés actuellement au sein du réseaud’excellence européen Nano2life dans le cadre du "workpackage" prospective) estreprésentée ci-contre

.

Nanobiotechnologies

composants et technologies:structures fonctionnelles à l'échelle

nanométrique

composants et technologies:structures fonctionnelles à l'échelle

nanométrique

Nanotechnologies pour la biologie• nanoparticules• nanofils nanotubes• surfaces nanostructurées• nanostructures complexes

Biologie pour les nanotechnologies• matériaux bioinspirés• systèmes biomimétiques

systèmes intégrés

in vitro

• puces à ADN, protéines, etc• puces à cellules• laboratoires sur puce

in vivo

• délivrance de médicaments• implants

• diagnostic et suivi in vivo • pilules intelligentes

autres• électronique moléculaire• conversion d'énergie

technologies et outils communs

techniques analytiques(microscopies électronique, à sondes locales, biophotonique)

aspects théoriquessimulation et modélisationtraitement de l'information

composants et technologies:structures fonctionnelles à l'échelle

nanométrique

composants et technologies:structures fonctionnelles à l'échelle

nanométrique

Nanotechnologies pour la biologie• nanoparticules• nanofils nanotubes• surfaces nanostructurées• nanostructures complexes

Biologie pour les nanotechnologies• matériaux bioinspirés• systèmes biomimétiques

systèmes intégrés

in vitro

• puces à ADN, protéines, etc• puces à cellules• laboratoires sur puce

in vivo

• délivrance de médicaments• implants

• diagnostic et suivi in vivo • pilules intelligentes

autres• électronique moléculaire• conversion d'énergie

technologies et outils communs

techniques analytiques(microscopies électronique, à sondes locales, biophotonique)

aspects théoriquessimulation et modélisationtraitement de l'information

Nanobiotechnologies

composants et technologies:structures fonctionnelles à l'échelle

nanométrique

composants et technologies:structures fonctionnelles à l'échelle

nanométrique

Nanotechnologies pour la biologie• nanoparticules• nanofils nanotubes• surfaces nanostructurées• nanostructures complexes

Biologie pour les nanotechnologies• matériaux bioinspirés• systèmes biomimétiques

systèmes intégrés

in vitro

• puces à ADN, protéines, etc• puces à cellules• laboratoires sur puce

in vivo

• délivrance de médicaments• implants

• diagnostic et suivi in vivo • pilules intelligentes

autres• électronique moléculaire• conversion d'énergie

technologies et outils communs

techniques analytiques(microscopies électronique, à sondes locales, biophotonique)

aspects théoriquessimulation et modélisationtraitement de l'information

composants et technologies:structures fonctionnelles à l'échelle

nanométrique

composants et technologies:structures fonctionnelles à l'échelle

nanométrique

Nanotechnologies pour la biologie• nanoparticules• nanofils nanotubes• surfaces nanostructurées• nanostructures complexes

Biologie pour les nanotechnologies• matériaux bioinspirés• systèmes biomimétiques

systèmes intégrés

in vitro

• puces à ADN, protéines, etc• puces à cellules• laboratoires sur puce

in vivo

• délivrance de médicaments• implants

• diagnostic et suivi in vivo • pilules intelligentes

autres• électronique moléculaire• conversion d'énergie

technologies et outils communs

techniques analytiques(microscopies électronique, à sondes locales, biophotonique)

aspects théoriquessimulation et modélisationtraitement de l'information

Figure 1

MSTP-mai 2005 20

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 21/92

Nous nous concentrerons dans la suite du texte successivement sur les aspects:• composants et technologies (paragraphes II à V) ;• systèmes intégrés (paragraphe VI).

Les technologies communes ne seront pas développées ici.

2. NanoparticulesLes nanoparticules sont des composants très utilisés et très intéressants qui rassemblent des

propriétés à la fois de support solide (possibilité d’être fonctionnalisé chimiquement, desédimenter et d’être séparé d’une phase liquide) et de matière divisée (grande diffusion etgrande réactivité). Ces nanoparticules peuvent ainsi assurer de nombreuses fonctions :

• encapsulation de médicaments, principes actifs, etc… pour la délivrance demédicaments,

• marqueurs de molécules (en général optiques)• transducteurs et génération d’un effet physique (photonique, thermique, ultrason

magnétique, etc)• capture de molécules

Ces nanoparticules sont très diverses dans leur nature et leurs procédés d’élaboration :• les matériaux utilisés peuvent être organiques ou inorganiques,• elles peuvent être sous forme de liposomes, de nanocapsules solides (creuses),

nanosphères (pleines).

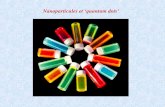

2-a. « Quantums-dots »

Les "quantum-dots" sont des cristaux semi-conducteurs de taille nanométrique, secomportant comme des fluorophores, ayant un certain nombre d’avantages sur leurshomologues organiques traditionnels:

• leur longueur d’onde d’émission est fonction de leur taille. On est ainsi capabled’émettre dans une raie d’émission très fine à condition d’avoir une population de

particules très monodisperse (par la synthèse ou le criblage). Cela permet de marquer simultanément tout en pouvant les détecter de façon indépendante un plus grandnombre de molécules en solution ;

• elles présentent un très bon rendement quantique,• elles présentent un "blanchiment" (dégradation sous l’effet d’une illumination)

beaucoup plus faible.En fonctionnalisant ces marqueurs de façon particulière, on peut les rendre "intelligents", par exemple en modifiant leur émission (activation, extinction, changement de longueur d’onde)en fonction d’un événement biologique ou chimique.

Les "quantum-dots" sont utilisés principalement aujourd’hui comme marqueurs optiquesdans des applications in vitro et in vivo.

Ils sont synthétisés dans une phase organique et sont naturellement hydrophobes. Leur stabilisation dans un tampon aqueux ainsi que leur fonctionnalisation biologique ont été des

problèmes non résolus jusqu’à une date récente (au cours de l’année 2002) mais qui sont

maintenant maîtrisés. On assiste à une explosion des travaux les mettant en œuvre. Il restecependant à établir clairement leur toxicité éventuelle pour pouvoir les utiliser dans ledomaine de la santé.

MSTP-mai 2005 21

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 22/92

2-b. Nanoparticules pour la délivrance de médicaments et la thérapie

Les nanoparticules peuvent servir de vecteurs de distribution de médicaments dans unorganisme. Leur utilisation, en modifiant la distribution des molécules permet à la foisd’augmenter l’efficacité du médicament et de diminuer leur toxicité, ce qui est

particulièrement important dans le traitement du cancer par exemple. La surface de cesnanoparticules est en général fonctionnalisée pour d’une part éviter leur piégeage non désirédans certains tissus, d’autre part pour se concentrer vers d’autres , voire être internalisées par les cellules ciblées.

Il est même possible dans certains cas de contrôler par une stimulation externe (optique, par ultra-sons, etc) les caractéristiques physico-chimiques des nanoparticules pour optimiser encore la libération des médicaments.

L’utilisation de nanoparticules pour les thérapies géniques où on introduit du matérielgénétique dans une cellule est un cas particulier également important.

D’autres propriétés des nanoparticules peuvent être utilisées pour la thérapie. On peutexploiter des propriétés physiques qui permettent d’agir sur leur environnement immédiat.Par exemple, on peut dans un premier temps fixer les nanoparticules sur certaines cellules oucertains tissus et les irradier pour qu’elles s’échauffent et détruisent par un effet thermiquetrès localisé les cellules dans leur voisinage immédiat. L’illumination de particules d’or,l’excitation par un champ magnétique alternatif de nanoparticules super-paramagnétiques, ou

bien encore l’excitation par des ultrasons de nanoparticules ont été ainsi utilisées.

3. Nanotubes et nanofils

Les nanotubes et nanofils de carbone et d’autres matériaux constituent des objets potentiellement extrêmement intéressants pour les nanobiotechnologies.

Ils ont des caractéristiques en particulier électriques qui peuvent être perturbées par desréactions chimiques à leur surface entre des molécules cibles à détecter et des sondesattachées à la surface du nanotube ou nanofil. La détection et la mesure de ces effets permetd’en faire des détecteurs à la fois sensibles, ne nécessitant pas de marquage, et entièrementintégrables (du dispositif sensible à l’électronique de traitement) sur une puce. Ceci en faitdes concurrents extrêmement sérieux vis à vis des méthodes utilisées courammentaujourd’hui.

Les premières preuves de principes ont été publiées en 2001. Aujourd’hui les principauxenjeux portent sur l’amélioration des performances en termes de sensibilité, l’intégration dedétecteurs complets et "multiplexés" (plusieurs détections en parallèle à l’instar des puces àADN ou à protéines), ainsi que la mise au point de procédés de fabrication compétitifs d’un

point de vue industriel.

4. Surfaces nanostructurées

La nanostructuration des surfaces, c’est-à-dire le contrôle à une échelle nanométrique deleurs propriétés chimiques ou physiques trouve de nombreuses applications pour lesnanobiotechnologies. On peut citer en particulier :

• la fonctionnalisation chimique de sondes qui, capables de réagir spécifiquementavec des molécules d’intérêt, permettent de réaliser des opérations dereconnaissance moléculaire. C’est le cas typique des puces à ADN, et à protéinesdiverses (peptides, protéines, glycoprotéines, haptènes, anticorps).

MSTP-mai 2005 22

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 23/92

• la fonctionnalisation chimique d’autres molécules comme des enzymes (par exemple la trypsine qui permet de digérer les protéines avant leur détection etanalyse par spectrométrie de masse) ou d’autres molécules particulières pour réaliser des colonnes miniaturisées de chromatographie ou d’électrophorèse.

• la fonctionnalisation chimique pour assurer une biocompatibilité des différentsdispositifs réalisés,

• la fonctionnalisation chimique pour libérer des médicaments avec une cinétique bien contrôlée,

• la réalisation de surface permettant d’avoir des propriétés de mouillabilitéextrêmement bien contrôlées, ce qui est important pour la microfluidique (voir

paragraphe 6-c ci-dessous). La structuration spatiale à l’échelle nanométrique dessurfaces permet d’amplifier les caractéristiques de mouillabilité des surfaces (casde l’effet lotus ou d’hyper-hydrophobicité).

La plupart de ces surfaces ont des propriétés statiques, mais le contrôle dynamique des

propriétés, tant chimiques que physiques par des moyens optiques, thermiques, ouélectriques, est extrêmement intéressant d’un point de vue fonctionnel. Des études sontmenées dans ce sens.

De nombreux travaux portent également sur les méthodes de fabrication qui doivent concilier performances et coût raisonnable.

5. Biologie pour les nanotechnologies

La biologie met à disposition des technologues un certain nombre de molécules et de procédés potentiellement extrêmement intéressants. Certains présentent des propriétés dereconnaissance moléculaire ou d’auto- assemblage que n’offre pas la chimie traditionnelle.

On met là en œuvre véritablement une approche "bottom-up" où des briques élémentaires telsque des molécules biologiques (acides nucléiques ou protéines principalement) ou même desmicroorganismes (virus par exemple), sont combinés pour construire des systèmes ou desmatériaux plus complexes.

Parmi les travaux les plus marquants, signalons l’utilisation de molécules biologiques commesupports mécaniques ou motifs pour la synthèse de structures nanométriques (par exemple denanofils métalliques), ou bien encore l’intérêt manifesté pour des matériaux biologiques telsles fils d’araignée, la nacre, la feuille de lotus déjà mentionnée. Ces matériaux ont des

propriétés que n’ont pas les matériaux artificiels. Par une approche de "reverse engineering",

on cherche ainsi à développer de nouveaux matériaux aux propriétés similaires.6. Systèmes intégrés in vitro

Les laboratoires sur puce, issus du rapprochement des microtechnologies et de la biologiereprésentent des nouveaux outils d’analyse caractérisés en ce qu’ils intègrent au sein d’undispositif miniaturisé unique les différentes étapes d’un protocole complet d’analyse. Ils

présentent sur leurs équivalents plus traditionnels les avantages suivants:• une facilité et une efficacité d’utilisation par un personnel non spécialisé, voire un

fonctionnement entièrement automatique,• des possibilités d’effectuer en parallèle un très grand nombre d’analyses,• une portabilité liée à leur taille réduite,• des performances accrues grâce à la miniaturisation (augmentation de la sensibilité et

diminution de la durée des tests par exemple).

MSTP-mai 2005 23

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 24/92

Ils trouvent leurs applications principales dans les domaines du diagnostic in vitro, ducontrôle agro-alimentaire (détection de contaminants et d’organismes génétiquementmodifiés, contrôle qualité), du contrôle de l’environnement (contrôle de la qualité de l’air etde l’eau). Les industries pharmaceutiques sont également des utilisatrices de ces systèmes

pour effectuer de façon efficace et bon marché les nombreuses et différentes analysesnécessaires pour le développement de nouveaux médicaments.

Les fonctions typiques implantées dans un laboratoire sur puce sont relativement diverses.On peut citer parmi les principales :

• des réactions spécifiques ("reconnaissance moléculaire") sur support solide ou ensolution, pour détecter la présence d’une ou plusieurs molécules dans unéchantillon. Principalement, pour la biologie, ces réactions mettent en œuvre desacides nucléiques, des protéines, des anticorps. Pour les réactions sur support solide,on est ici dans le domaine des puces à ADN ou puces à protéines;

• la détection de ces réactions spécifiques mettant en œuvre plusieurs principes

physiques;• des opérations de préparation d’échantillon incluant des séparations sur micro-

colonnes, des concentrations, l’amplification par PCR (Polymerase ChainReaction).

Toutes ces opérations sont implantées par la mise en œuvre de plusieurs technologies de basedont nous allons présenter les enjeux dans les paragraphes suivants.

6-a. Matériaux et procédés de fabrication

Le choix des matériaux utilisés et les procédés d’élaboration résultent de l’optimisation d’uncritère prenant en compte les fonctions et les performances attendues du dispositif, son coût

et le volume de production. Doivent être en particulier considérés :• les propriétés chimiques (pour la bio-compatibilité et la fonctionnalisation chimique

des surfaces), les propriétés thermiques, éventuellement optiques et électriques(essentiellement pour la détection) des matériaux,

• les procédés de mise en forme/usinage, d’assemblage, de fonctionnalisationchimique des surfaces, de conditionnement (packaging) utilisables,

• le coût des matériaux bruts mais aussi des procédés de fabrication.

Les matériaux les plus couramment utilisés sont les polymères, le verre et le silicium.

Les premiers ont pour avantage leur moindre coût et leur facilité de mise en œuvre, en

particulier au niveau de leur mise en forme ; celle-ci peut se faire par emboutissage, par moulage ou même par usinage direct (essentiellement pour du prototypage), pour desdimensions caractéristiques qui peuvent aller du centimètre jusqu’au micron, voire au-delàdans certains cas.

Le silicium présente plusieurs avantages, la capacité que l’on a d’y implanter des fonctionsélectriques ou électroniques (par exemple pour la détection), sa très bonne conductionthermique et la possibilité d’usiner des structures de taille de l’ordre du micron avec des

procédés très bien maîtrisés. Il a pour inconvénient principal un coût de fabricationrelativement élevé pour des objets de surface même modeste (au delà de quelques mm²) si les

objets fabriqués ne sont pas de très grande diffusion.Au niveau des matériaux, la tendance qui semble se dégager serait donc :

MSTP-mai 2005 24

5/16/2018 2005 - Nanosciences Et Nanotechnologies - slidepdf.com

http://slidepdf.com/reader/full/2005-nanosciences-et-nanotechnologies 25/92

• une combinaison polymères/verre/silicium pour des dispositifs complexes, intégrant plusieurs fonctions d’un protocole d’analyse, par exemple de la préparationd’échantillon à la détection. Ces dispositifs seraient destinés à des applications à fortevaleur ajoutée,

• l’utilisation exclusive de polymères pour des dispositifs plus simples, passifs (comme par exemple des puces à ADN ou protéines, ou des tests sans détection), en vued’applications à plus faible valeur ajoutée, beaucoup plus sensibles au coût defabrication.

6-b. Chimie de surface

La chimie de surface est un aspect très important pour les laboratoires sur puces. Laminiaturisation des échantillons, par la diminution de leur rapport volume sur surface, a pour conséquence une importance accrue des phénomènes de surface, parmi lesquels on peut citer:

• les réactions chimiques de surface, spécifiques (puces à ADN ou puces à protéines)ou non (cas des adsorptions non spécifiques qui peuvent créer des faux positifs dans

une détection ou occasionner la perte totale ou partielle d’analyses sur des parois decapillaires ou de chambres de réaction),

• les phénomènes physico-chimiques de surface comme la mouillabilité, trèsimportants pour la micro-fluidique (voir ci-dessous).

Ce sont les molécules et groupement chimiques présents à la surface des matériaux quiconditionnent ces phénomènes. Dans le cas particulier des laboratoires sur puce, les enjeux

principaux de la chimie de surface sont:• la fonctionnalisation chimique pour la reconnaissance moléculaire en surface. Il

s’agit de greffer des molécules (typiquement acides nucléiques, anticorps, protéines) tout en les gardant chimiquement actives et en contrôlant leur interaction avec la surface (interaction éventuellement néfaste);

• la compatibilité des chimies de greffage avec l’ensemble des procédés defabrication du microsystème;

• la fonctionnalisation de structures éventuellement complexes. S’il est(relativement) aisé de fonctionnaliser un support plan comme une puce à ADN oùl’on peut projeter les réactifs par une pipette miniaturisée ("spotting" en anglais),il l’est beaucoup moins dans le cas d’un capillaire, d’une chambre de réaction dequelques nanolitres, ou d’une microcolonne;

• le contrôle dynamique de l’activité chimique des molécules greffées en surface.

Cette fonction n’est pas aujourd’hui répandue mais serait d’une grande utilité pour plusieurs opérations telles que le relargage de molécules, le contrôledynamique localisé de propriétés chimiques (contrôle local du pH par exemple)ou physico-chimiques (mouillabilité par exemple).

6-c. Nano-microfluidique